Wetenschap

Het gebruik van geautomatiseerde besluitvormingssystemen door overheden weerspiegelt systemische problemen van onrechtvaardigheid en ongelijkheid

Software en technologie kunnen grote hoeveelheden data in een oogwenk verwerken, waardoor ze zeer aantrekkelijk zijn voor gebruik door de overheid. Tegoed:Shutterstock

In 2019 zei de voormalige speciale VN-rapporteur Philip Alston dat hij zich zorgen maakte dat we "zo zombie-achtig in een digitale welzijnsdystopie strompelden". Hij had onderzocht hoe overheidsinstanties over de hele wereld gebruik maakten van geautomatiseerde besluitvormingssystemen (ADS) om kosten te besparen, de efficiëntie te verhogen en middelen te benutten. ADS zijn technische systemen die zijn ontworpen om menselijke besluitvorming te helpen of te vervangen met behulp van algoritmen.

Alston was niet voor niets bezorgd. Onderzoek toont aan dat ADS kan worden gebruikt op manieren die discrimineren, ongelijkheid vergroten, rechten schenden, mensen in verschillende sociale groepen indelen, de toegang tot diensten ten onrechte beperken en het toezicht intensiveren.

Zo zijn gezinnen failliet gegaan en in crises terechtgekomen nadat ze valselijk werden beschuldigd van uitkeringsfraude.

Onderzoekers hebben vastgesteld dat gezichtsherkenningssystemen en risicobeoordelingstools eerder mensen met een donkere huidskleur en vrouwen ten onrechte identificeren. Deze systemen hebben al geleid tot onrechtmatige arrestaties en verkeerd geïnformeerde veroordelingen.

Vaak komen mensen er pas achter dat ze zijn getroffen door een ADS-toepassing als een van twee dingen gebeurt:nadat er iets misgaat, zoals het geval was met het A-levels-schandaal in het Verenigd Koninkrijk; of wanneer controverses openbaar worden gemaakt, zoals het geval was bij het gebruik van gezichtsherkenningstechnologie in Canada en de Verenigde Staten.

Geautomatiseerde problemen

Meer transparantie, verantwoordelijkheid, aansprakelijkheid en publieke betrokkenheid bij het ontwerp en het gebruik van ADS is belangrijk om de rechten en privacy van mensen te beschermen. Hier zijn drie hoofdredenen voor:

- deze systemen kunnen veel schade aanrichten;

- ze worden sneller geïntroduceerd dan de noodzakelijke beveiligingen kunnen worden geïmplementeerd, en;

- er is een gebrek aan mogelijkheden voor de getroffenen om democratische beslissingen te nemen over of ze moeten worden gebruikt en zo ja, hoe ze moeten worden gebruikt.

Ons nieuwste onderzoeksproject, Automating Public Services:Learning from Canceled Systems , levert bevindingen die gericht zijn op het helpen voorkomen van schade en bijdragen aan zinvolle discussies en actie. Het rapport biedt het eerste uitgebreide overzicht van systemen die in westerse democratieën worden opgeheven.

Het onderzoeken van de factoren en beweegredenen die leiden tot annulering van ADS-systemen helpt ons hun limieten beter te begrijpen. In ons rapport hebben we 61 advertenties geïdentificeerd die zijn geannuleerd in Australië, Canada, Europa, Nieuw-Zeeland en de VS. We presenteren een gedetailleerd overzicht van systemen die zijn geannuleerd op het gebied van fraudedetectie, kinderwelzijn en politie. Onze bevindingen tonen het belang aan van zorgvuldige afweging en zorg voor rechtvaardigheid.

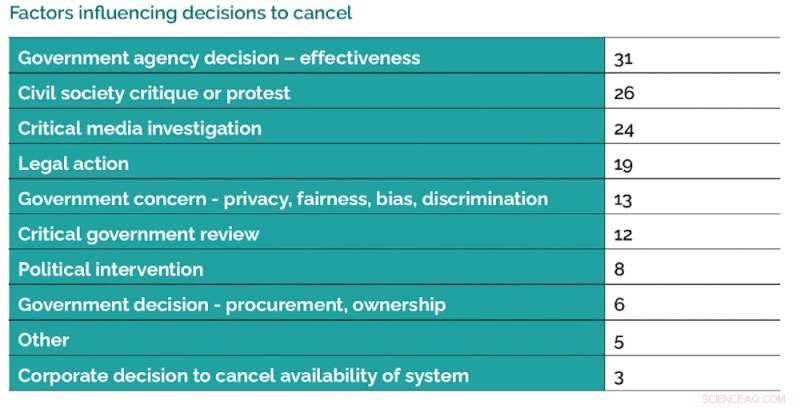

Er zijn een aantal factoren die van invloed zijn op beslissingen om het gebruik van ADS-systemen te annuleren. Credit:Data Justice Lab, auteur verstrekt

Redenen voor annulering

Er zijn een aantal factoren die van invloed zijn op beslissingen om het gebruik van ADS te annuleren. Een van onze belangrijkste bevindingen is hoe vaak systemen worden geannuleerd omdat ze niet zo effectief zijn als verwacht. Een andere belangrijke bevinding is de belangrijke rol die mobilisatie en onderzoek van de gemeenschap, onderzoeksrapportage en juridische stappen spelen.

Onze bevindingen tonen aan dat er concurrerende opvattingen, visies en politiek zijn rond het gebruik van ADS.

Hopelijk zullen onze aanbevelingen leiden tot meer burgerparticipatie en beter toezicht, verantwoording en schadepreventie.

In het rapport wijzen we op wijdverbreide oproepen aan regeringen om ADS-registers met middelen op te zetten als een eerste basisstap naar meer transparantie. Sommige landen, zoals het VK, hebben plannen aangekondigd om dit te doen, terwijl andere landen, zoals Canada, nog geen stap in deze richting hebben gezet.

Onze bevindingen tonen aan dat het gebruik van ADS kan leiden tot grotere ongelijkheid en systemische onrechtvaardigheid. Dit versterkt de noodzaak om alert te zijn op hoe het gebruik van ADS differentiële systemen van voor- en nadelen kan creëren.

Verantwoording en transparantie

ADS moet met zorg en verantwoordelijkheid worden ontwikkeld door op een zinvolle manier in contact te komen met getroffen gemeenschappen. Er kunnen schadelijke gevolgen zijn wanneer overheidsinstanties het publiek niet betrekken bij discussies over het juiste gebruik van ADS vóór implementatie.

Deze betrokkenheid moet de mogelijkheid omvatten voor leden van de gemeenschap om te beslissen over gebieden waar ze niet willen dat ADS wordt gebruikt. Voorbeelden van goede overheidspraktijken zijn onder meer de tijd nemen om ervoor te zorgen dat beoordelingen door onafhankelijke deskundigen en effectbeoordelingen worden uitgevoerd die gericht zijn op gelijkheid en mensenrechten.

Overheden kunnen verschillende benaderingen volgen om ADS-systemen op een meer verantwoorde manier te implementeren. Credit:Data Justice Lab, auteur verstrekt

We raden aan om de aansprakelijkheid van degenen die ADS willen implementeren te versterken door bewijs van nauwkeurigheid, effectiviteit en veiligheid te eisen, evenals beoordelingen van de wettigheid. Mensen moeten op zijn minst kunnen achterhalen of een ADS hun gegevens heeft gebruikt en, indien nodig, toegang hebben tot middelen om verkeerde beoordelingen aan te vechten en te herstellen.

In ons rapport worden een aantal gevallen genoemd waarin de samenwerking tussen overheidsinstanties en particuliere bedrijven voor het leveren van ADS-diensten tot problemen heeft geleid. In één geval besloot een overheidsinstantie om geen borgtochtbepalingssysteem te gebruiken omdat de eigendomsrechtelijke aard van het systeem betekende dat beklaagden en functionarissen niet zouden kunnen begrijpen waarom een beslissing was genomen, waardoor een effectieve betwisting onmogelijk werd.

Overheidsinstanties moeten over de middelen en vaardigheden beschikken om grondig te onderzoeken hoe ze ADS-systemen aanschaffen.

Een politiek van zorg

Al deze aanbevelingen wijzen op het belang van een zorgpolitiek. Dit vereist dat degenen die ADS willen implementeren, de complexiteit van mensen, gemeenschappen en hun rechten moeten waarderen.

Er moeten belangrijke vragen worden gesteld over hoe het gebruik van ADS tot blinde vlekken leidt vanwege de manier waarop ze de afstand vergroten tussen beheerders en de mensen die ze moeten dienen door middel van score- en sorteersystemen die mensen te simpel maken, schuld afleiden, zich ten onrechte richten op en stereotyperen door middel van categorisaties en kwantificaties.

Een goede praktijk, in termen van een zorgbeleid, houdt in dat je de tijd neemt om de mogelijke effecten van ADS zorgvuldig te overwegen vóór implementatie en te reageren op kritiek, te zorgen voor doorlopend toezicht en beoordeling, en om onafhankelijke en gemeenschapsbeoordeling te zoeken. + Verder verkennen

Gezichtsherkenning, camera's en andere hulpmiddelen die de politie gebruikt, roepen vragen op over aansprakelijkheid

Dit artikel is opnieuw gepubliceerd vanuit The Conversation onder een Creative Commons-licentie. Lees het originele artikel.

Wetenschappers verbeteren een fotosynthetisch enzym door fluoroforen toe te voegen

Wetenschappers verbeteren een fotosynthetisch enzym door fluoroforen toe te voegen Nieuw pathogeen mechanisme voor influenza NS1-eiwit gevonden

Nieuw pathogeen mechanisme voor influenza NS1-eiwit gevonden Lastige reactiereeks krijgt een grote boost van een stroomopstelling en statistieken

Lastige reactiereeks krijgt een grote boost van een stroomopstelling en statistieken Millimoles converteren naar PPM

Millimoles converteren naar PPM  Wetenschappers krijgen atomistisch beeld van afbraak van platinakatalysator

Wetenschappers krijgen atomistisch beeld van afbraak van platinakatalysator

40% van de EU-import van landbouwproducten zal tegen 2050 zeer kwetsbaar zijn voor droogte

40% van de EU-import van landbouwproducten zal tegen 2050 zeer kwetsbaar zijn voor droogte Verzuring van de oceaan treft krabvisserij West Coast Dungeness, nieuwe beoordeling toont

Verzuring van de oceaan treft krabvisserij West Coast Dungeness, nieuwe beoordeling toont Cheese Mold Experiments

Cheese Mold Experiments Klimaatslimme landbouw vereist radicale beleidswijzigingen

Klimaatslimme landbouw vereist radicale beleidswijzigingen Top 5 manieren om de planeet te redden met fietsen

Top 5 manieren om de planeet te redden met fietsen

Hoofdlijnen

- Hoe goede bacteriën je genen beheersen

- Waarom maken we verkeerde keuzes?

- Een bitter mysterie:wetenschappers sequencen 's werelds oudste plantengenoom van 6000 jaar oude watermeloenzaden

- Hoe worden bacteriën resistent tegen antibiotica?

- Kan een Vision Board uw toekomst echt beïnvloeden?

- Wat is een geest? Onderzoeker daagt percepties van gevoel uit met de kleinste wezens

- Viswetenschapper hielp de alien in Jordan Peeles Nee, het leek angstaanjagend echt

- Vogelneuronen gebruiken drie keer minder glucose dan zoogdierneuronen

- Wetenschappers vinden potentiële wapens voor de strijd tegen antibioticaresistentie

- Hoge omzet, lage lonen en ongelijkheden vergroot tijdens de pandemie voor directe ondersteuningsprofessionals

- Een menselijke niche creëren

- Genoom verwante dinosauriërs gekoppeld aan zoogdieren

- Machine learning gebruiken om de kijk op het oude verleden te verfijnen

- Om baan binnen te halen, studie suggereert meerdere netten uit te werpen

Facebook doodt trending topics, tests brekend nieuws label

Facebook doodt trending topics, tests brekend nieuws label Verwoestende gebeurtenissen kunnen mensenhandel stimuleren, papieren shows

Verwoestende gebeurtenissen kunnen mensenhandel stimuleren, papieren shows Theorie verklaart het gedrag van ferromagnetische supergeleiders

Theorie verklaart het gedrag van ferromagnetische supergeleiders Bedrijven profiteren van het geven van getuigenissen van het congres, studie vondsten

Bedrijven profiteren van het geven van getuigenissen van het congres, studie vondsten Onderzoekers ontdekken dat kristallen van indiumselenide een uitzonderlijke flexibiliteit hebben

Onderzoekers ontdekken dat kristallen van indiumselenide een uitzonderlijke flexibiliteit hebben Nieuwelingen in de verkoop, maak je geen zorgen - ga gewoon boven en buiten

Nieuwelingen in de verkoop, maak je geen zorgen - ga gewoon boven en buiten De 20 beste plaatsen om stikstofvervuiling op Amerikaanse boerderijen aan te pakken

De 20 beste plaatsen om stikstofvervuiling op Amerikaanse boerderijen aan te pakken Wetenschappers introduceren nieuw materiaal om waterstof op te slaan

Wetenschappers introduceren nieuw materiaal om waterstof op te slaan

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com