Wetenschap

Onderzoeker bespreekt de wetenschappelijke replicatiecrisis

Krediet:Caltech

Als er een centraal principe is dat alle wetenschappen verenigt, het is waarschijnlijk dat wetenschappers ontdekkingen moeten benaderen zonder vooringenomenheid en met een gezonde dosis scepsis. Het idee is dat de beste manier om de waarheid te bereiken is om de feiten te laten leiden waarheen ze willen, zelfs als het niet is waar je heen wilde.

Maar dat is misschien makkelijker gezegd dan gedaan. Mensen hebben onbewuste vooroordelen die moeilijk van zich af te schudden zijn, en de meeste mensen houden er niet van om ongelijk te hebben. In de afgelopen jaren, wetenschappers hebben verontrustend bewijs ontdekt dat deze vooroordelen de integriteit van het onderzoeksproces op veel gebieden kunnen aantasten.

Het bewijs suggereert ook dat zelfs wanneer wetenschappers met de beste bedoelingen werken, ernstige fouten komen vaker voor dan verwacht, omdat zelfs subtiele verschillen in de manier waarop een experimentele procedure wordt uitgevoerd, de bevindingen kunnen afwerpen.

Wanneer vooroordelen en fouten in het onderzoek lekken, andere wetenschappers die hetzelfde experiment proberen, kunnen ontdekken dat ze de bevindingen van de oorspronkelijke onderzoeker niet kunnen repliceren. Dit heeft het bredere probleem zijn naam gegeven:de replicatiecrisis.

Colin Camer, Caltech's Robert Kirby Professor of Behavioral Economics en de T&C Chen Centre for Social and Decision Neuroscience Leadership Chair, executive officer voor de sociale wetenschappen en directeur van het T&C Chen Center for Social and Decision Neuroscience, loopt voorop in het onderzoek naar de replicatiecrisis. Hij heeft een aantal studies over het onderwerp geschreven en is een fervent pleitbezorger voor hervormingen. We hebben met Camerer gesproken over hoe erg het probleem is en wat er kan worden gedaan om het te verhelpen; en de "open science"-beweging, die het delen van gegevens aanmoedigt, informatie, en materialen onder onderzoekers.

Wat is precies de replicatiecrisis?

De aanzet tot dit alles is de ontdekking dat veel bevindingen – oorspronkelijk in de geneeskunde, maar later op het gebied van psychologie, in economie, en waarschijnlijk op elk gebied - repliceer of reproduceer gewoon niet zo goed als we zouden hopen. Door te reproduceren, Ik bedoel het nemen van gegevens die iemand heeft verzameld voor een onderzoek en dezelfde analyse doen om te zien of je dezelfde resultaten krijgt. Mensen kunnen aanzienlijke verschillen krijgen, bijvoorbeeld, als ze nieuwere statistieken gebruiken dan beschikbaar waren voor de oorspronkelijke onderzoekers.

Uit de vroegste onderzoeken naar reproduceerbaarheid bleek ook dat het soms moeilijk is om mensen hun gegevens op een tijdige en duidelijke manier te laten delen. Er was een norm dat het delen van gegevens een soort bonus is, maar is niet absoluut een noodzakelijk onderdeel van het werk van een wetenschapper.

Hoe groot is dit probleem?

Ik zou zeggen dat het groot genoeg is om erg zorgwekkend te zijn. Ik geef een voorbeeld uit de sociale psychologie, wat een van de meest problematische gebieden is geweest. In de sociale psychologie, er is een idee genaamd priming, wat betekent dat als ik je onbewust aan één ding laat denken, die gedachten kunnen verwante associaties activeren en je gedrag op een verrassende manier veranderen.

Veel studies over priming zijn gedaan door John Bargh, die een bekende psycholoog is aan Yale. Bargh en zijn collega's lieten jongeren nadenken over oud zijn en lieten ze vervolgens aan een tafel zitten en een test doen. Maar de test was slechts een opvulling, omdat de onderzoekers niet geïnteresseerd waren in de resultaten van de test. Ze waren geïnteresseerd in hoe het denken over oud zijn het gedrag van de jongeren beïnvloedde. Toen de jongeren klaar waren met de vulstoftest, het onderzoeksteam heeft getimed hoe lang het duurde om van de tafel op te staan en naar een lift te lopen. Ze ontdekten dat de mensen die waren voorbereid om na te denken over oud zijn, langzamer liepen dan de controlegroep die die priming niet had gekregen.

Ze probeerden een dramatisch resultaat te krijgen dat aantoonde dat mentale associaties over oude mensen het fysieke gedrag beïnvloeden. Het probleem was dat wanneer anderen het onderzoek probeerden te repliceren, de oorspronkelijke bevindingen repliceerden niet erg goed. In een herhaling, er is nog iets ergers gebeurd. Sommige assistenten in dat experiment kregen te horen dat de priming de jonge proefpersonen langzamer zou laten lopen, en anderen kregen te horen dat ze door de priming sneller zouden lopen - dit is wat we een reactantie of boemerangeffect noemen. En wat de assistenten moesten verwachten, had invloed op hun metingen van hoe snel de proefpersonen liepen, ook al waren ze aan het timen met stopwatches. De stopwatch-metingen van de assistenten waren vertekend in vergelijking met een geautomatiseerde timer. Ik noem dit voorbeeld omdat het het soort onderzoek is waarvan we denken dat het te schattig is om waar te zijn. Toen het falen om te repliceren uitkwam, er was veel opschudding over hoeveel vaardigheid een experimentator nodig heeft om een goede replicatie uit te voeren.

U hebt onlangs deze kwestie in een paar kranten onderzocht. Wat heb je gevonden?

In onze eerste krant we keken naar experimentele economie, dat is iets dat hier bij Caltech is gepionierd. We namen 18 papers van meerdere instellingen die werden gepubliceerd in twee van de toonaangevende economische tijdschriften. Dit zijn de papieren waarvan je zou hopen dat ze het beste zouden repliceren. Wat we ontdekten was dat 14 van de 18 redelijk goed repliceerden, maar vier van hen deden dat niet.

Het is belangrijk op te merken dat in twee van die vier gevallen, we maakten kleine afwijkingen in de manier waarop het experiment werd uitgevoerd. Dat is een herinnering dat kleine veranderingen een groot verschil kunnen maken in de replicatie. Bijvoorbeeld, als je politieke psychologie en partijdigheid studeert en je repliceert een paper uit 2010, de resultaten van vandaag kunnen heel anders zijn omdat het politieke klimaat is veranderd. Het is niet zo dat de auteurs van het originele artikel een fout hebben gemaakt, het is dat het fenomeen in hun onderzoek is veranderd.

In ons tweede artikel we keken naar sociaalwetenschappelijke papers die tussen 2010 en 2015 werden gepubliceerd in Wetenschap en Natuur , die de vlaggenschip algemene wetenschappelijke tijdschriften zijn. We waren in hen geïnteresseerd omdat dit veel geciteerde artikelen waren en als zeer invloedrijk werden beschouwd.

We hebben degenen uitgekozen die niet al te moeizaam zouden zijn om te repliceren, en we eindigden met 21 papieren. Wat we ontdekten was dat slechts ongeveer 60 procent repliceerde, en degenen die niet repliceerden, hadden de neiging zich te concentreren op zaken als priming, die ik eerder noemde. Priming is het minst repliceerbare fenomeen gebleken. Het is jammer, want het onderliggende concept - dat denken aan één ding associaties met verwante dingen verheft - is ongetwijfeld waar.

Hoe gebeurt zoiets?

Een oorzaak van bevindingen die niet worden gerepliceerd, is wat we 'p-hacking' noemen. P-waarde is een maat voor de statistische waarschijnlijkheid dat uw hypothese waar is. Als de p-waarde laag is, een effect is hoogstwaarschijnlijk geen toevalstreffer. In de sociale wetenschappen en geneeskunde, bijvoorbeeld, je test meestal of het veranderen van de omstandigheden van het experiment het gedrag verandert. Je wilt echt een lage p-waarde krijgen, omdat het betekent dat de toestand die je hebt veranderd wel effect heeft gehad. P-hacking is wanneer u verschillende analyses met uw gegevens blijft proberen totdat u de p-waarde laag krijgt.

Een goed voorbeeld van p-hacking is het verwijderen van datapunten die niet passen bij je hypothese (uitbijters) uit je dataset. Er zijn statistische methoden om met uitbijters om te gaan, maar soms verwachten mensen een correlatie te zien en vinden ze er niet veel van, bijvoorbeeld. Dus dan bedenken ze een plausibele reden om een paar uitschieters weg te gooien, omdat ze door dat te doen de correlatie groter kunnen maken. Die praktijk kan worden misbruikt, maar op het zelfde moment, er zijn soms uitschieters die moeten worden weggegooid. Bijvoorbeeld, als proefpersonen te veel knipperen wanneer u visuele waarneming probeert te meten, het is redelijk om de knipperingen weg te werken of sommige onderwerpen niet te gebruiken.

Een andere verklaring is dat wetenschappers soms gewoon door geluk worden geholpen. Wanneer iemand anders dat originele experiment probeert te repliceren, maar niet hetzelfde geluk krijgt, ze zullen niet dezelfde resultaten krijgen.

In de wetenschappen, je wordt verondersteld onpartijdig te zijn en te zeggen, "Hier is mijn hypothese, en ik ga bewijzen dat het goed of fout is." Dus, waarom passen mensen de resultaten aan om een antwoord te krijgen dat ze willen?

Aan de top van de piramide staat regelrechte fraude en, gelukkig, dat is vrij zeldzaam. Typisch, als u een autopsie of een biecht doet bij fraude, je vindt een wetenschapper die een enorme druk voelt. Soms is het persoonlijk - "Ik wilde gewoon gerespecteerd worden" - en soms is het subsidie of te beschaamd zijn om het schoon te maken.

In de frauduleuze gevallen wetenschappers komen weg met een kleine hoeveelheid bedrog, en ze worden erg ingegraven omdat ze er echt hun carrière op verwedden. De bevinding die ze hebben vervalst, kan ervoor zorgen dat ze worden uitgenodigd voor conferenties en dat ze veel geld krijgen. Dan is het te gênant om te stoppen en te bekennen wat ze al die tijd hebben gedaan.

Er zijn ook gebrekkige wetenschappelijke praktijken die minder flagrant zijn dan regelrechte fraude, Rechtsaf?

Zeker wel. Het is de wetenschapper die denkt, "Ik weet dat ik gelijk heb, en hoewel deze gegevens het niet bewezen, Ik weet zeker dat ik nog veel meer experimenten zou kunnen doen en het zou kunnen bewijzen. Dus ik ga het proces gewoon helpen door de beste versie van de gegevens te maken." Het is als cosmetische chirurgie voor gegevens.

En opnieuw, er zijn prikkels die dit stimuleren. Vaak in Big Science en Big Medicine, je steunt veel mensen met je beurs. Als er echt iets mis gaat met je grote theorie of je baanbrekende methode, die mensen worden ontslagen en hun carrière wordt geschaad.

Een andere kracht die bijdraagt aan een zwakke repliceerbaarheid is dat, in de wetenschap, we vertrouwen in hoge mate op normen van eer en het idee dat mensen om het proces geven en de waarheid willen achterhalen. Er komt enorm veel vertrouwen bij kijken. Als ik een artikel krijg om te recenseren van een toonaangevend tijdschrift, Ik denk niet per se als een rechercheur over de vraag of het verzonnen is.

Veel van de fraudes werden alleen ontdekt omdat er een patroon was in veel verschillende kranten. Eén krant was te mooi om waar te zijn, en de volgende was te mooi om waar te zijn, enzovoort. Niemand is goed genoeg om 10 too-good-to-be-trues op een rij te krijgen.

Dus, vaak, het is een soort toevalstreffer. Iemand glijdt uit of een persoon merkt het en vraagt dan om de gegevens en graaft een stukje verder.

Welke best practices moeten wetenschappers volgen om te voorkomen dat ze in deze valkuilen trappen?

Er zijn veel dingen die we kunnen doen - ik noem het de reproduceerbaarheidsupgrade. Een daarvan is voorregistratie, wat betekent dat voordat u uw gegevens verzamelt, je publiekelijk uitlegt en online plaatst welke gegevens je precies gaat verzamelen, waarom je je steekproefomvang hebt gekozen, en welke analyse u precies gaat uitvoeren. Als je dan een heel andere analyse doet en een goed resultaat krijgt, mensen kunnen zich afvragen waarom je bent afgeweken van wat je vooraf hebt geregistreerd en of de ongeplande analyses p-gehackt zijn.

De meer algemene rubriek heet open wetenschap, waarin je doet alsof alles wat je doet beschikbaar moet zijn voor andere mensen, behalve voor bepaalde zaken zoals de privacy van patiënten. Dat omvat originele gegevens, code, instructies, en experimentele materialen zoals video-opnamen - alles.

Meta-analyse is een andere methode waarvan ik denk dat we die steeds vaker gaan zien. Daar combineer je de resultaten van onderzoeken die allemaal hetzelfde algemene effect proberen te meten. U kunt die informatie gebruiken om bewijs te vinden van zaken als publicatiebias, wat een soort groepsdenken is. Bijvoorbeeld, er is sterk experimenteel bewijs dat mensen kleinere borden geven waardoor ze minder eten. Dus misschien bestudeer je kleine en grote borden, en je vindt geen effect op de portiegrootte. Je zou bij jezelf kunnen denken, "Ik heb waarschijnlijk een fout gemaakt. Ik ga niet proberen dat te publiceren." Of je zou kunnen zeggen, "Wauw! Dat is echt interessant. Ik heb geen klein bordeffect gekregen. Ik ga het naar een tijdschrift sturen." En de redacteuren of scheidsrechters zeggen:'Je hebt waarschijnlijk een fout gemaakt. We gaan het niet publiceren.' Dat zijn publicatiebias. Ze kunnen worden veroorzaakt doordat wetenschappers resultaten achterhouden of doordat tijdschriften ze niet publiceren omdat ze een onconventioneel resultaat krijgen.

Als een groep wetenschappers gaat geloven dat iets waar is en het tegenovergestelde bewijs wordt genegeerd of onder het tapijt geveegd, dat betekent dat veel mensen tot een collectieve conclusie proberen te komen over iets dat niet waar is. De grote schade is dat het een kolossale tijdverspilling is, en het kan de publieke perceptie van hoe solide wetenschap in het algemeen is, schaden.

Staan mensen open voor de veranderingen die u voorstelt?

Ik zou zeggen dat 90 procent van de mensen me erg heeft gesteund. Een heel goed nieuws is dat het Open Science Framework is ondersteund door de Laura en John Arnold Foundation, wat een grote particuliere stichting is, en door andere donateurs. De particuliere stichtingen bevinden zich in een unieke positie om veel geld uit te geven aan dit soort zaken. Onze eerste beurs om replica's in experimentele economie te doen, kwam toen ik de programmamedewerker van de Alfred P. Sloan Foundation ontmoette. Ik vertelde hem dat we een groot project aan het uitvoeren waren om economische experimenten te repliceren. Hij raakte opgewonden, en het was figuurlijk alsof hij daar een zak geld uit zijn koffertje haalde. Mijn medewerkers in Zweden en Oostenrijk kregen later een bijzonder grote subsidie van $ 1,5 miljoen om aan replicatie te werken. Nu er wat vaart is, financiers zijn redelijk genereus geweest, wat geweldig is.

Een ander ding dat interessant was, is dat hoewel tijdschriften niet graag een kopie van één artikel publiceren, ze houden echt van wat we hebben gedaan, dat is een reeks replicaties. Een paar maanden na het werken aan het eerste replicatiedocument in experimentele economie, gefinancierd door Sloan, Ik kreeg een e-mail van een redacteur op Wetenschap wie zei, 'Ik heb gehoord dat je aan dit replicatieding werkt. Heb je al nagedacht over waar je het gaat publiceren?' Dat is een knipoog, terughoudende manier om te zeggen "Stuur het ons alstublieft" zonder enige belofte. Ze hebben het uiteindelijk wel gepubliceerd.

Welke uitdagingen zie je in de toekomst?

Ik denk dat de grootste uitdaging is om te bepalen waar de verantwoordelijkheid ligt. Tot ongeveer 2000, de conventionele wijsheid was, "Niemand zal betalen voor uw replicatie en niemand zal uw replicatie publiceren. En als het niet goed uitkomt, je maakt gewoon een vijand. Doe geen moeite om te repliceren." Studenten kregen vaak te horen dat ze niet moesten repliceren omdat het slecht zou zijn voor hun carrière. Ik denk dat dat onjuist is, maar het is waar dat niemand een grote prijs zal winnen voor het kopiëren van andermans werk. Het beste carrièrepad in de wetenschap komt door te laten zien dat je iets origineels kunt doen, belangrijk, en creatief. Replicatie is precies het tegenovergestelde. Het is belangrijk dat iemand het doet, maar het is niet creatief. Het is iets dat de meeste wetenschappers willen dat iemand anders doet.

Wat nodig is, zijn instellingen om stabiele, voortdurende herhalingen, in plaats van te vertrouwen op wetenschappers die proberen creatief te zijn en doorbraken te realiseren om het te doen. Het kunnen een paar centra zijn die zich alleen toeleggen op replicatie. Ze konden elke vijfde paper kiezen die in een bepaald tijdschrift werd gepubliceerd, repliceer het, en hun resultaten online plaatsen. Het zou zijn als een audit, of een soort consumentenrapporten voor de wetenschap. Ik denk dat dergelijke instellingen zullen ontstaan. Of misschien subsidieverstrekkers, zoals de National Institutes of Health of de National Science Foundation, verantwoordelijk zijn voor het inbouwen van waarborgen. Ze kunnen een auditproces hebben dat subsidiegeld opzij zet om een replicatie uit te voeren en uw werk te controleren.

Voor mij is dit als een hobby. Nu hoop ik dat een andere groep zorgvuldige mensen die erg gepassioneerd en slim zijn het stokje overneemt en heel routinematig replicaties gaat doen.

Nanokristallen worden beter als ze verdubbelen met MOF's

Nanokristallen worden beter als ze verdubbelen met MOF's Hoe theoretische percentages te berekenen

Hoe theoretische percentages te berekenen  Close-ups van korrelgrenzen onthullen hoe zwavelonzuiverheden nikkel broos maken

Close-ups van korrelgrenzen onthullen hoe zwavelonzuiverheden nikkel broos maken Zelfsteriliserend polymeer blijkt effectief tegen medicijnresistente pathogenen

Zelfsteriliserend polymeer blijkt effectief tegen medicijnresistente pathogenen Video:hoe zilveren nanodeeltjes geuren verminderen

Video:hoe zilveren nanodeeltjes geuren verminderen

Wat zijn de onderdelen van de microbiologie?

Wat zijn de onderdelen van de microbiologie?  Onderzoekers identificeren menselijke invloed als de belangrijkste factor voor oceaanopwarmingspatronen in de toekomst

Onderzoekers identificeren menselijke invloed als de belangrijkste factor voor oceaanopwarmingspatronen in de toekomst Overheidsrapport ziet drastische impact van klimaatverandering in VS:NYT

Overheidsrapport ziet drastische impact van klimaatverandering in VS:NYT Lood vergiftigt kinderen op Amerikaanse militaire bases, zegt verslag

Lood vergiftigt kinderen op Amerikaanse militaire bases, zegt verslag Nieuwe metingen tonen aan dat wijdverbreid bosverlies de rol van tropen als koolstofput heeft omgekeerd

Nieuwe metingen tonen aan dat wijdverbreid bosverlies de rol van tropen als koolstofput heeft omgekeerd

Hoofdlijnen

- Wat zijn Prions?

- Terugkeer van de inheemse wilde kalkoen - duurzame oogstdoelen stellen wanneer de informatie beperkt is

- Mottenvrouwtjes gebruiken geurnabijheid om partners aan te trekken

- Onderzoek suggereert dat vroege antibiotica de gezondheid en het gedrag van volwassenen kunnen beïnvloeden

- Onderzoekers breiden de kracht van genbewerking uit door een nieuwe klasse van DNA-basiseditors te ontwikkelen

- Wat is een bijtmiddel in de microbiologie?

- 10 wonderkinderen

- Nieuw mechanisme wijst de weg naar het doorbreken van de antibioticaresistentie van ribosoom

- Houden mannelijke vissen ze liever groot en kleurrijk?

- Enorme vondst van zilveren munten geeft nieuwe aanwijzingen voor turbulente tijden na Normandische verovering van Engeland

- Lamprei-tanden voor het eerst geïdentificeerd in archeologische vondsten in Londen

- Onderzoek toont aan dat locatie vele vormen van volkshuisvesting maakt of breekt

- Uit onderzoek blijkt dat hoge drukverwachtingen leiden tot onethisch gedrag

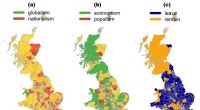

- Brexit-debat op Twitter gedreven door economische en nationalistische kwesties, geen populisme

Ademtests kunnen COVID-19 opsporen

Ademtests kunnen COVID-19 opsporen Nieuwe architectuur verhoogt de energie- en spectrumefficiëntie voor draadloze internet der dingen

Nieuwe architectuur verhoogt de energie- en spectrumefficiëntie voor draadloze internet der dingen 1.5C cap op opwarming bespaart wereldeconomie biljoenen:studie

1.5C cap op opwarming bespaart wereldeconomie biljoenen:studie Handleidingen voor het verhogen van de efficiëntie van organische zonnecellen

Handleidingen voor het verhogen van de efficiëntie van organische zonnecellen Rideshare-bedrijven hebben San Francisco opgepikt:studie

Rideshare-bedrijven hebben San Francisco opgepikt:studie Krantenketen McClatchy vraagt faillissementsbescherming aan (update)

Krantenketen McClatchy vraagt faillissementsbescherming aan (update) Hoe 30 KW te berekenen naar Amps

Hoe 30 KW te berekenen naar Amps Zonne-energie van de donkere kant ontgrendeld door een nieuwe formule

Zonne-energie van de donkere kant ontgrendeld door een nieuwe formule

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com