Wetenschap

Aleksander Madry over het bouwen van betrouwbare kunstmatige intelligentie

Aleksander Madry is een leider in het opkomende gebied van het bouwen van garanties in kunstmatige intelligentie, dat bijna een zelfstandige tak van machine learning is geworden. Krediet:CSAIL

Machine learning-algoritmen liggen nu ten grondslag aan veel van de software die we gebruiken, helpen onze nieuwsfeeds te personaliseren en onze gedachten af te ronden voordat we klaar zijn met typen. Maar naarmate kunstmatige intelligentie verder verankerd raakt in het dagelijks leven, verwachtingen zijn gestegen. Voordat autonome systemen ons vertrouwen volledig winnen, we moeten weten dat ze in de meeste situaties betrouwbaar zijn en bestand zijn tegen inmenging van buitenaf; in technische termen, dat ze robuust zijn. We moeten ook de redenering achter hun beslissingen begrijpen; dat ze interpreteerbaar zijn.

Alexander Madry, een universitair hoofddocent computerwetenschappen aan het MIT en een hoofdfaculteitslid van het Trustworthy AI-initiatief van het Computer Science and Artificial Intelligence Lab (CSAIL), vergelijkt AI met een scherp mes, een nuttig maar potentieel gevaarlijk hulpmiddel dat de samenleving moet leren correct te gebruiken. Madry sprak onlangs op MIT's Symposium over Robust, Interpreteerbare AI, een evenement mede gesponsord door de MIT Quest for Intelligence en CSAIL, en op 20 november gehouden in het Singleton Auditorium. Het symposium was bedoeld om nieuw MIT-werk te demonstreren op het gebied van het inbouwen van garanties in AI, dat bijna een zelfstandige tak van machine learning is geworden. Zes docenten spraken over hun onderzoek, 40 studenten presenteerden posters, en Madry opende het symposium met een lezing met de toepasselijke titel:"Robuustheid en interpreteerbaarheid." We spraken met Madry, een leider in dit opkomende gebied, over enkele van de belangrijkste ideeën die tijdens het evenement naar voren werden gebracht.

V:AI heeft veel van zijn recente vooruitgang te danken aan deep learning, een tak van machine learning die het vermogen van algoritmen om patronen in tekst te herkennen aanzienlijk heeft verbeterd, beelden en geluiden, ons geautomatiseerde assistenten zoals Siri en Alexa te geven, onder andere. Maar deep learning-systemen blijven op verrassende manieren kwetsbaar:ze struikelen wanneer ze enigszins onbekende voorbeelden in de echte wereld tegenkomen of wanneer een kwaadwillende aanvaller het subtiel gewijzigde afbeeldingen invoert. Hoe proberen jij en anderen AI robuuster te maken?

een:Tot voor kort, AI-onderzoekers richtten zich simpelweg op het verkrijgen van algoritmen voor machine learning om basistaken uit te voeren. Het was een grote uitdaging om zelfs gemiddelde prestaties te behalen. Nu de prestaties zijn verbeterd, de aandacht is verschoven naar de volgende hindernis:het verbeteren van de worst case performance. Het grootste deel van mijn onderzoek is gericht op het aangaan van deze uitdaging. specifiek, Ik werk aan de ontwikkeling van machine learning-systemen van de volgende generatie die betrouwbaar en veilig genoeg zijn voor missiekritieke toepassingen zoals zelfrijdende auto's en software die schadelijke inhoud filtert. We bouwen momenteel tools om objectherkenningssystemen te trainen om te identificeren wat er in een scène of afbeelding gebeurt, zelfs als de afbeeldingen die naar het model worden gestuurd, zijn gemanipuleerd. Ook onderzoeken we de grenzen van systemen die veiligheids- en betrouwbaarheidsgaranties bieden. Hoeveel betrouwbaarheid en veiligheid kunnen we inbouwen in modellen voor machine learning, en welke andere functies moeten we misschien opofferen om daar te komen?

Mijn collega Luca Daniel, die ook sprak, werkt aan een belangrijk aspect van dit probleem:het ontwikkelen van een manier om de veerkracht van een deep learning-systeem in sleutelsituaties te meten. Beslissingen die worden genomen door deep learning-systemen hebben grote gevolgen, en daarom is het essentieel dat eindgebruikers de betrouwbaarheid van elk van de outputs van het model kunnen meten. Een andere manier om een systeem robuuster te maken, is tijdens het trainingsproces. In haar toespraak "Robuustheid in GAN's en in Black-box Optimization, "Stefanie Jegelka liet zien hoe de leerling in een generatief vijandig netwerk, of GAN, kan worden gemaakt om manipulaties aan de invoer te weerstaan, leidt tot veel betere prestaties.

V:De neurale netwerken die diep leren mogelijk maken, lijken bijna moeiteloos te leren:geef ze voldoende gegevens en ze kunnen bij veel taken beter presteren dan mensen. En toch, we hebben ook gezien hoe gemakkelijk ze kunnen falen, met ten minste drie veel gepubliceerde gevallen van zelfrijdende auto's die crashten en iemand vermoorden. AI-toepassingen in de zorg staan nog niet onder dezelfde toets, maar de inzet is even groot. David Sontag concentreerde zich in zijn toespraak op de vaak gevolgen van leven of dood wanneer een AI-systeem niet robuust is. Wat zijn enkele van de rode vlaggen bij het trainen van een AI op medische patiëntendossiers en andere observatiegegevens?

A:Dit gaat terug op de aard van garanties en de onderliggende aannames die we in onze modellen inbouwen. We gaan er vaak van uit dat onze trainingsdatasets representatief zijn voor de real-world data waarop we onze modellen testen - een aanname die meestal te optimistisch is. Sontag gaf twee voorbeelden van gebrekkige aannames die in het trainingsproces zijn ingebakken en die ertoe kunnen leiden dat een AI de verkeerde diagnose geeft of een schadelijke behandeling aanbeveelt. De eerste was gericht op een enorme database van röntgenfoto's van patiënten die vorig jaar door de National Institutes of Health werden vrijgegeven. Verwacht werd dat de dataset grote verbeteringen zou brengen in de geautomatiseerde diagnose van longziekte, totdat een sceptische radioloog nader keek en wijdverbreide fouten ontdekte in de diagnostische labels van de scans. Een AI die is getraind op borstscans met veel onjuiste labels, zal het moeilijk krijgen om nauwkeurige diagnoses te stellen.

A second problem Sontag cited is the failure to correct for gaps and irregularities in the data due to system glitches or changes in how hospitals and health care providers report patient data. Bijvoorbeeld, a major disaster could limit the amount of data available for emergency room patients. If a machine-learning model failed to take that shift into account its predictions would not be very reliable.

Q:You've covered some of the techniques for making AI more reliable and secure. What about interpretability? What makes neural networks so hard to interpret, and how are engineers developing ways to peer beneath the hood?

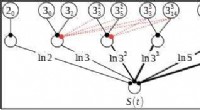

A:Understanding neural-network predictions is notoriously difficult. Each prediction arises from a web of decisions made by hundreds to thousands of individual nodes. We are trying to develop new methods to make this process more transparent. In the field of computer vision one of the pioneers is Antonio Torralba, director of The Quest. In zijn toespraak, he demonstrated a new tool developed in his lab that highlights the features that a neural network is focusing on as it interprets a scene. The tool lets you identify the nodes in the network responsible for recognizing, zeggen, a door, from a set of windows or a stand of trees. Visualizing the object-recognition process allows software developers to get a more fine-grained understanding of how the network learns.

Another way to achieve interpretability is to precisely define the properties that make the model understandable, and then train the model to find that type of solution. Tommi Jaakkola showed in his talk, "Interpretability and Functional Transparency, " that models can be trained to be linear or have other desired qualities locally while maintaining the network's overall flexibility. Explanations are needed at different levels of resolution much as they are in interpreting physical phenomena. Of course, there's a cost to building guarantees into machine-learning systems—this is a theme that carried through all the talks. But those guarantees are necessary and not insurmountable. The beauty of human intelligence is that while we can't perform most tasks perfectly, as a machine might, we have the ability and flexibility to learn in a remarkable range of environments.

Dit verhaal is opnieuw gepubliceerd met dank aan MIT News (web.mit.edu/newsoffice/), een populaire site met nieuws over MIT-onderzoek, innovatie en onderwijs.

Onderzoekers upgraden organische zonnecellen voor gebruik in dakpannen die stroom opwekken

Onderzoekers upgraden organische zonnecellen voor gebruik in dakpannen die stroom opwekken Gastro-intestinaal-bewoner, vormveranderende microdevices voor verlengde medicijnafgifte

Gastro-intestinaal-bewoner, vormveranderende microdevices voor verlengde medicijnafgifte Verloren metaalatomen hun valentie-elektronen bij het vormen van ionische verbindingen?

Verloren metaalatomen hun valentie-elektronen bij het vormen van ionische verbindingen?

Metaalatomen verliezen een deel van hun valentie-elektronen door een proces genaamd oxidatie, wat resulteert in een grote verscheidenheid aan ionische verbindin

Groene proteïne zonder smaak van stal

Groene proteïne zonder smaak van stal Nieuwe strategie ontworpen voor duurzame productie van benzylamines uit lignine

Nieuwe strategie ontworpen voor duurzame productie van benzylamines uit lignine

Verschillen tussen een kat, een hond en een menselijk skelet

Verschillen tussen een kat, een hond en een menselijk skelet Marcheren voor klimaatverandering kan de overtuigingen en acties van mensen beïnvloeden

Marcheren voor klimaatverandering kan de overtuigingen en acties van mensen beïnvloeden Factoren die van invloed zijn op de ademhaling in planten

Factoren die van invloed zijn op de ademhaling in planten NASA betrapt ontwikkeling van tropische cycloon 02A

NASA betrapt ontwikkeling van tropische cycloon 02A Kooldioxideniveaus bereikten 50% hoger dan pre-industriële tijd

Kooldioxideniveaus bereikten 50% hoger dan pre-industriële tijd

Hoofdlijnen

- Plantaanpassingen: woestijn, tropisch regenwoud, toendra

- Hoe antidepressiva werken

- Gletsjermuizen bewegen en dat heeft wetenschappers versteld doen staan

- Welke is eencellig: Prokaryoten of eukaryoten?

- Welke functies delen mitochondria en bacteriën?

- Bacteriën levenscyclus

- Burgerwetenschappers ontdekken zes nieuwe soorten kevers in Borneo

- Is er echt een kurkcrisis?

- Waar wordt zetmeel opgeslagen in plantencellen?

- Is Big Tech te groot? Een blik op het groeiende antitrustonderzoek

- Virtuele training voor cockpitbemanningen van vliegdekschepen

- Hersenachtige computers van legers komen dichter bij het kraken van codes

- Licht verbindt twee werelden op één chip

- EU keurt bod Comcast op Sky goed in overnamegevecht met Murdoch

Studie:Toegenomen combinaties van hitte en droogte kunnen gewassen wereldwijd beschadigen

Studie:Toegenomen combinaties van hitte en droogte kunnen gewassen wereldwijd beschadigen Auto's en vliegtuigen lichter en schoner maken met unidirectionele vezeltapes

Auto's en vliegtuigen lichter en schoner maken met unidirectionele vezeltapes Ultrakleine atoombewegingen vastgelegd met ultrakorte röntgenpulsen

Ultrakleine atoombewegingen vastgelegd met ultrakorte röntgenpulsen Wijken met een laag inkomen zouden het meest profiteren van groene daken in steden als Chicago

Wijken met een laag inkomen zouden het meest profiteren van groene daken in steden als Chicago Quantumsensoren zorgen voor magnetische resonantie met een ongekende gevoeligheid

Quantumsensoren zorgen voor magnetische resonantie met een ongekende gevoeligheid Google geeft $ 25 miljoen weg om humane AI-projecten te financieren

Google geeft $ 25 miljoen weg om humane AI-projecten te financieren Vulkaan Alaska zendt aswolk uit Aleoeten

Vulkaan Alaska zendt aswolk uit Aleoeten Captain Scotts Discovery-expeditie biedt 100 jaar later inzicht in klimaatverandering

Captain Scotts Discovery-expeditie biedt 100 jaar later inzicht in klimaatverandering

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com