Wetenschap

Seksistische online vertalers krijgen een training over gendergevoeligheid

Krediet:Aleutie/Shutterstock

Online vertaalhulpmiddelen hebben ons geholpen nieuwe talen te leren, communiceren over taalgrenzen heen, en bekijk buitenlandse websites in onze moedertaal. Maar de kunstmatige intelligentie (AI) erachter is verre van perfect, vaak repliceren in plaats van verwerpen de vooroordelen die bestaan binnen een taal of een samenleving.

Dergelijke instrumenten zijn bijzonder kwetsbaar voor genderstereotypering, omdat sommige talen (zoals Engels) niet de neiging hebben om zelfstandige naamwoorden te geslacht, terwijl anderen (zoals Duits) dat wel doen. Bij het vertalen van het Engels naar het Duits, vertaaltools moeten beslissen welk geslacht Engelse woorden zoals 'cleaner' toewijzen. overweldigend, de tools voldoen aan het stereotype, kiezen voor het vrouwelijke woord in het Duits.

Vooroordelen zijn menselijk:ze maken deel uit van wie we zijn. Maar als het niet wordt betwist, vooroordelen kunnen ontstaan in de vorm van een concrete negatieve houding ten opzichte van anderen. Nutsvoorzieningen, ons team heeft een manier gevonden om de AI achter vertaaltools om te scholen, door middel van gerichte training om genderstereotypering te voorkomen. Onze methode zou op andere gebieden van AI kunnen worden gebruikt om de technologie te helpen afwijzen, in plaats van te repliceren, vooroordelen binnen de samenleving.

Bevooroordeelde algoritmen

Tot ongenoegen van hun makers, AI-algoritmen ontwikkelen vaak racistische of seksistische trekken. Google Translate is beschuldigd van stereotypering op basis van geslacht, zoals de vertalingen die veronderstellen dat alle artsen mannelijk zijn en alle verpleegsters vrouwelijk. In de tussentijd, de AI-taalgenerator GPT-3 - die in 2020 een heel artikel voor The Guardian schreef - toonde onlangs aan dat het ook schokkend goed was in het produceren van schadelijke inhoud en verkeerde informatie.

Hongaars is een genderneutrale taal, het heeft geen geslachtsgebonden voornaamwoorden, dus Google Translate kiest automatisch het geslacht voor je. Dit is hoe alledaags seksisme consequent wordt gecodeerd in 2021. Fuck you, Googlen. pic.twitter.com/EPqkEw5yEQ

— Dora Vargha (@DoraVargha) 20 maart 2021

Deze AI-fouten zijn niet noodzakelijk de schuld van hun makers. Academici en activisten vestigden onlangs de aandacht op gendervooroordelen in de Oxford English Dictionary, waar seksistische synoniemen van "vrouw" - zoals "teef" of "meid" - laten zien hoe zelfs een voortdurend herziene, academisch bewerkte woordencatalogus kan vooroordelen bevatten die stereotypen versterken en het alledaagse seksisme in stand houden.

AI leert vooroordelen omdat het niet in een vacuüm is gebouwd:het leert denken en handelen door te lezen, het analyseren en categoriseren van bestaande gegevens, zoals die in de Oxford English Dictionary. In het geval van vertaling AI, we stellen het algoritme bloot aan miljarden woorden tekstuele gegevens en vragen het de patronen die het detecteert te herkennen en ervan te leren. We noemen dit proces machine learning, en gaandeweg worden patronen van vooringenomenheid geleerd, evenals die van grammatica en syntaxis.

Ideaal, de tekstuele gegevens die we AI laten zien, bevatten geen vooroordelen. Maar er is een voortdurende trend in het veld om grotere systemen te bouwen die zijn getraind op steeds groter wordende datasets. We hebben het over honderden miljarden woorden. Deze worden verkregen van internet met behulp van niet-onderscheidende tools voor het schrapen van tekst, zoals Common Crawl en WebText2, die over het web plunderen, elk woord dat ze tegenkomen opslokken.

De enorme omvang van de resulterende gegevens maakt het voor een mens onmogelijk om daadwerkelijk te weten wat er in zit. Maar we weten wel dat een deel ervan afkomstig is van platforms zoals Reddit, die de krantenkoppen heeft gehaald voor het kenmerken van aanstootgevende, valse of samenzweerderige informatie in berichten van gebruikers.

Nieuwe vertalingen

In ons onderzoek, we wilden zoeken naar een manier om de bias in tekstuele datasets die van internet zijn geschraapt, tegen te gaan. Onze experimenten gebruikten een willekeurig geselecteerd deel van een bestaand Engels-Duits corpus (een selectie van tekst) dat oorspronkelijk 17,2 miljoen paar zinnen bevatte - de helft in het Engels, de helft in het duits

Zoals we hebben benadrukt, Duits heeft geslachtsvormen voor zelfstandige naamwoorden (dokter kan "der Arzt" zijn voor mannelijk, "die Ärztin" voor vrouwelijk) waar we in het Engels deze zelfstandige naamwoorden niet geslacht (met enkele uitzonderingen, zelf controversieel, zoals "acteur" en "actrice").

Onze analyse van deze gegevens bracht duidelijke genderspecifieke onevenwichtigheden aan het licht. Bijvoorbeeld, we ontdekten dat de mannelijke vorm van ingenieur in het Duits (der Ingenieur) 75 keer vaker voorkwam dan zijn vrouwelijke tegenhanger (die Ingenieurin). Een vertaaltool die op deze gegevens is getraind, zal deze vooringenomenheid onvermijdelijk repliceren, het vertalen van "ingenieur" naar de mannelijke "der Ingenieur." Dus wat kan er worden gedaan om dit te voorkomen of te verminderen?

Vooroordelen overwinnen

Een schijnbaar eenvoudig antwoord is om het corpus te 'balanceren' voordat je computers vraagt om ervan te leren. Misschien, bijvoorbeeld, het toevoegen van meer vrouwelijke ingenieurs aan het corpus zou voorkomen dat een vertaalsysteem ervan uitgaat dat alle ingenieurs mannen zijn.

Helaas, er zijn problemen met deze aanpak. Vertaaltools worden dagenlang getraind op miljarden woorden. Ze omscholen door het geslacht van woorden te veranderen is mogelijk, maar het is inefficiënt, duur en ingewikkeld. Het aanpassen van het geslacht in talen als Duits is vooral een uitdaging omdat, om grammaticaal zinvol te zijn, meerdere woorden in een zin moeten mogelijk worden gewijzigd om de geslachtswisseling weer te geven.

In plaats van deze moeizame herbalancering van de geslachten, we besloten om bestaande vertaalsystemen om te scholen met gerichte lessen. Toen we een vooroordeel zagen in bestaande tools, we besloten om ze om te scholen op nieuwe, kleinere datasets - een beetje zoals een middag gender-sensitiviteitstraining op het werk.

Deze aanpak kost een fractie van de tijd en middelen die nodig zijn om modellen helemaal opnieuw te trainen. We konden slechts een paar honderd geselecteerde vertaalvoorbeelden gebruiken - in plaats van miljoenen - om het gedrag van vertaal-AI op gerichte manieren aan te passen. Bij het testen van gendergerelateerde beroepen in vertaling - zoals we hadden gedaan met 'ingenieurs' - waren de nauwkeurigheidsverbeteringen na aanpassing ongeveer negen keer hoger dan de 'gebalanceerde' omscholingsaanpak.

In ons onderzoek, we wilden laten zien dat het aanpakken van verborgen vooroordelen in enorme datasets niet hoeft te betekenen dat miljoenen trainingsvoorbeelden moeizaam moeten worden aangepast, een taak die het risico loopt als onmogelijk te worden afgedaan. In plaats daarvan, vooringenomenheid uit gegevens kan gericht en afgeleerd worden - een les die andere AI-onderzoekers kunnen toepassen op hun eigen werk.

Dit artikel is opnieuw gepubliceerd vanuit The Conversation onder een Creative Commons-licentie. Lees het originele artikel.

Ongekende 3D-beelden van de anatomie van het menselijk oor voor gehoorherstel

Ongekende 3D-beelden van de anatomie van het menselijk oor voor gehoorherstel Verschillen tussen homeostase en acclimatisatie

Verschillen tussen homeostase en acclimatisatie  Nieuw bewijsmateriaal ingediend bij Grenfell Tower Inquiry over bekledingsreactiviteit

Nieuw bewijsmateriaal ingediend bij Grenfell Tower Inquiry over bekledingsreactiviteit Onderzoekers maken doorbraak in lichtvangtechnologie voor industriële multikristallijne siliciumzonnecellen

Onderzoekers maken doorbraak in lichtvangtechnologie voor industriële multikristallijne siliciumzonnecellen Wetenschappers ontdekken bindend geheim achter eiwitsuperlijm

Wetenschappers ontdekken bindend geheim achter eiwitsuperlijm

Wat gebeurt er met de aardkorst na een aardbeving?

Wat gebeurt er met de aardkorst na een aardbeving?  Franse brandweerlieden vechten voor derde dag in Riviera inferno

Franse brandweerlieden vechten voor derde dag in Riviera inferno Milieuvriendelijke waterbehandeling werkt het beste met ervaren bacteriële flora

Milieuvriendelijke waterbehandeling werkt het beste met ervaren bacteriële flora Brandend probleem:branden in Indonesië zetten palmolie onder de loep

Brandend probleem:branden in Indonesië zetten palmolie onder de loep Voormalig VN-leider bezoekt klimaatadaptatieprojecten in Miami

Voormalig VN-leider bezoekt klimaatadaptatieprojecten in Miami

Hoofdlijnen

- Hoe nauwkeurig is ons mentale beeld van onszelf?

- Rangschikken met behulp van een vierkantswortelcurve

- De Term Synapsis is geassocieerd met welk proces?

- Landbouwgroepen dagen waarschuwing onkruidverdelger in Californië uit

- Kanker-kameleons: hoe sommige agressieve kankercellen chemotherapie “hacken”

- Pareidolie:waarom we in bijna alles gezichten zien

- Welke conclusies kunnen worden getrokken uit de overeenkomsten van de genetische code tussen levende organismen?

Als je door het park loopt en een straathond door het gras ziet rennen, is het niet zo moeilijk om delen van het erfgoed te identificer

- Onderzoekers vinden eiwit dat antibioticaresistentie kan helpen bestrijden

- Het verschil van de genomische DNA-extractie tussen dier en plant

- Hoe het is om de wereld rond te reizen in een vliegtuig op zonne-energie

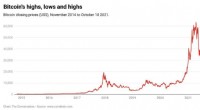

- Wat is een ETF? En waarom drijft het Bitcoin terug naar recordhoge prijzen?

- Algehele daling van 50% in aankopen:de uitgaven van huishoudens schommelen dramatisch als reactie op het coronavirus

- Mijnsites uit de bronstijd ontvingen leveringen van voorbewerkte voedingsmiddelen

- Gebruik van achternaam voor mannen meer dan voor vrouwen kan een teken zijn van onbedoelde vooringenomenheid

Hoe drijfzand werkt

Hoe drijfzand werkt  Natuurlijke spectraallijnen

Natuurlijke spectraallijnen General Motors zegt dat de staking heeft geleid tot een verlies van $ 194 miljoen in het vierde kwartaal

General Motors zegt dat de staking heeft geleid tot een verlies van $ 194 miljoen in het vierde kwartaal Video:De chemie achter zwart poeder

Video:De chemie achter zwart poeder COVID dwong Australische vaders om meer thuis te doen, maar tegen dezelfde prijs hebben moeders het lang volgehouden

COVID dwong Australische vaders om meer thuis te doen, maar tegen dezelfde prijs hebben moeders het lang volgehouden Wetenschappers waarschuwen dat de mensheid geen effectieve hulpmiddelen heeft om tsunami's te weerstaan

Wetenschappers waarschuwen dat de mensheid geen effectieve hulpmiddelen heeft om tsunami's te weerstaan Beschikbaarheid van waterstof regelt de chemische structuur van grafeenoxide

Beschikbaarheid van waterstof regelt de chemische structuur van grafeenoxide Toeleveringsketens van multinationals zijn verantwoordelijk voor een vijfde van de wereldwijde uitstoot

Toeleveringsketens van multinationals zijn verantwoordelijk voor een vijfde van de wereldwijde uitstoot

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com