Wetenschap

Simuleren 800, 000 jaar aardbevingsgeschiedenis in Californië om risico's te lokaliseren

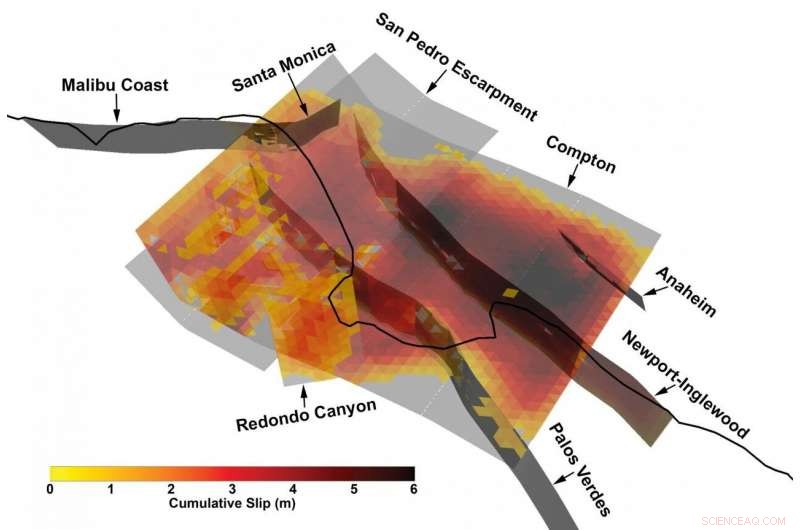

3D-weergave van een bijzonder complexe multi-fault breuk uit de synthetische aardbevingscatalogus ontwikkeld door het Southern California Earthquake Center met behulp van een nieuw raamwerk voor aardbevingsmodellering. Krediet:Kevin Milner, universiteit van zuid Californië

Enorme aardbevingen zijn, gelukkig, zeldzame gebeurtenissen. Maar die schaarste aan informatie verblindt ons in zekere zin voor hun risico's, zeker als het gaat om het bepalen van het risico voor een specifieke locatie of constructie.

"We hebben de meeste mogelijke gebeurtenissen die grote schade kunnen veroorzaken niet waargenomen, " legde Kevin Milner uit, een computerwetenschapper en seismologisch onderzoeker bij het Southern California Earthquake Center (SCEC) aan de University of Southern California. "Als we Zuid-Californië als voorbeeld nemen, we hebben sinds 1857 geen echt grote aardbeving meer gehad - dat was de laatste keer dat het zuidelijke San Andreas uitbrak in een enorme aardbeving met een kracht van 7,9. Een aardbeving in San Andreas kan een veel groter gebied treffen dan de aardbeving in Northridge in 1994, en andere grote aardbevingen kunnen ook voorkomen. Dat is waar we ons zorgen over maken."

De traditionele manier om dit gebrek aan gegevens te omzeilen, bestaat uit het graven van loopgraven om meer te weten te komen over breuken in het verleden, het verzamelen van informatie van veel aardbevingen over de hele wereld en het creëren van een statistisch model van gevaar, of het gebruik van supercomputers om een specifieke aardbeving op een specifieke plaats met een hoge mate van getrouwheid te simuleren.

Echter, een nieuw raamwerk voor het voorspellen van de waarschijnlijkheid en impact van aardbevingen over een hele regio, ontwikkeld door een team van onderzoekers verbonden aan SCEC in het afgelopen decennium, heeft een middenweg gevonden en misschien een betere manier om risico's vast te stellen.

Een nieuwe studie onder leiding van Milner en Bruce Shaw van Columbia University, gepubliceerd in de Bulletin van de Seismologische Vereniging van Amerika in januari 2021, presenteert resultaten van een prototype Rate-Stat aardbevingssimulator, of RSQSim, dat honderdduizenden jaren seismische geschiedenis in Californië simuleert. In combinatie met een andere code, CyberShake, het raamwerk kan de hoeveelheid schudden berekenen die voor elke aardbeving zou optreden. Hun resultaten zijn goed te vergelijken met historische aardbevingen en de resultaten van andere methoden, en een realistische verdeling van de kans op aardbevingen weer te geven.

Volgens de ontwikkelaars de nieuwe aanpak verbetert het vermogen om vast te stellen hoe groot een aardbeving kan plaatsvinden op een bepaalde locatie, waardoor ontwikkelaars van bouwcodes, architecten, en structurele ingenieurs om veerkrachtigere gebouwen te ontwerpen die aardbevingen op een specifieke locatie kunnen overleven.

"Voor de eerste keer, we hebben een hele pijplijn van begin tot eind waar het optreden van aardbevingen en grondbewegingssimulatie op fysica gebaseerd zijn, "Zei Milner. "Het kan tot 100 simuleren, duizenden jaren op een echt ingewikkeld foutsysteem."

Massale computerkracht toepassen op grote problemen

RSQSim transformeert wiskundige representaties van de geofysische krachten die een rol spelen bij aardbevingen - het standaardmodel van hoe breuken kiemen en zich voortplanten - in algoritmen, en lost ze vervolgens op op enkele van de krachtigste supercomputers ter wereld. Het rekenintensieve onderzoek werd gedurende meerdere jaren mogelijk gemaakt door door de overheid gesponsorde supercomputers in het Texas Advanced Computing Center, inclusief Frontera - het krachtigste systeem aan elke universiteit ter wereld - Blue Waters in het National Center for Supercomputing Applications, en top bij de Oak Ridge Leadership Computing Facility.

"Een manier waarop we het risico misschien beter kunnen voorspellen, is door op fysica gebaseerde modellering, door gebruik te maken van de kracht van systemen zoals Frontera om simulaties uit te voeren, "zei Milner. "In plaats van een empirische statistische verdeling, we simuleren het optreden van aardbevingen en de voortplanting van de golven."

"We hebben veel vooruitgang geboekt op Frontera bij het bepalen van wat voor soort aardbevingen we kunnen verwachten, op welke fout, en hoe vaak, " zei Christine Goulet, Directeur Toegepaste Wetenschappen bij SCEC, ook bij het werk betrokken. "We schrijven of vertellen de code niet wanneer de aardbevingen zullen plaatsvinden. We lanceren een simulatie van honderdduizenden jaren, en laat de code de stress van de ene fout naar de andere overbrengen."

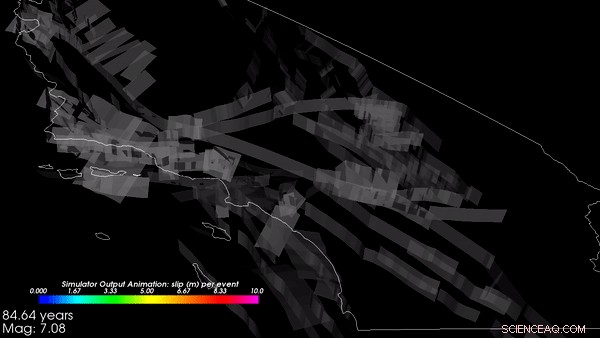

De simulaties begonnen met de geologische topografie van Californië en simuleerden meer dan 800, 000 virtuele jaren hoe spanningen zich vormen en verdwijnen als tektonische krachten op de aarde inwerken. Uit deze simulaties het raamwerk genereerde een catalogus - een record dat een aardbeving plaatsvond op een bepaalde plaats met een bepaalde omvang en kenmerken op een bepaald moment. De catalogus die het SCEC-team op Frontera en Blue Waters produceerde, was een van de grootste ooit gemaakt, zei Goulet. De outputs van RSQSim werden vervolgens ingevoerd in CyberShake, dat opnieuw computermodellen van geofysica gebruikte om te voorspellen hoeveel schudden (in termen van grondversnelling, of snelheid, en duur) zou optreden als gevolg van elke aardbeving.

"Het raamwerk geeft een volledige slip-time-geschiedenis weer:waar een breuk optreedt en hoe deze is gegroeid, " legde Milner uit. "We ontdekten dat het realistische grondbewegingen produceert, wat ons vertelt dat de fysica die in het model is geïmplementeerd, werkt zoals bedoeld." Ze hebben meer werk gepland voor validatie van de resultaten, wat van cruciaal belang is voor acceptatie voor ontwerptoepassingen.

De onderzoekers ontdekten dat het RSQSim-framework rijke, variabele aardbevingen in het algemeen - een teken dat het redelijke resultaten oplevert - terwijl het ook herhaalbare bron- en padeffecten genereert.

Een willekeurig gekozen 3, 000-jarig segment van de op fysica gebaseerde gesimuleerde catalogus van aardbevingen in Californië, gemaakt op Frontera. Krediet:Kevin Milner, universiteit van zuid Californië

"Voor veel sites het schudgevaar daalt, ten opzichte van de huidige schattingen", zei Milner. "Maar voor een aantal locaties met speciale configuraties van nabijgelegen breuken of lokale geologische kenmerken, zoals in de buurt van San Bernardino, het gevaar liep op. We werken eraan om deze resultaten beter te begrijpen en om benaderingen te definiëren om ze te verifiëren."

Het werk helpt bij het bepalen van de waarschijnlijkheid van een aardbeving langs een van de honderden aardbevingen veroorzakende fouten in Californië, de omvang van de aardbeving die kan worden verwacht, en hoe het andere aardbevingen kan veroorzaken.

Ondersteuning voor het project komt van de U.S. Geological Survey (USGS), Nationale Wetenschapsstichting (NSF), en de W. M. Stichting Keck. Frontera is NSF's nationale hulpbron van leiderschapsklasse. Rekentijd op Frontera werd verstrekt via een Large-Scale Community Partnership (LSCP)-prijs aan SCEC, waarmee honderden Amerikaanse wetenschappers toegang hebben tot de machine om vele aspecten van aardbevingswetenschap te bestuderen. LSCP-awards bieden verlengde toewijzingen van maximaal drie jaar ter ondersteuning van langdurige onderzoeksinspanningen. SCEC - dat in 1991 werd opgericht en al meer dan tien jaar op TACC-systemen rekent - is een uitstekend voorbeeld van een dergelijke inspanning.

De creatie van de catalogus vereiste acht dagen continu computergebruik op Frontera en gebruikte meer dan 3, 500 processors parallel. Het simuleren van het schudden van de grond op 10 locaties in Californië vereiste een vergelijkbare hoeveelheid computergebruik op Summit, de op één na snelste supercomputer ter wereld.

"Adoptie door de bredere gemeenschap zal begrijpelijkerwijs langzaam gaan, "zei Milner. "Omdat dergelijke resultaten de veiligheid zullen beïnvloeden, het maakt deel uit van onze due diligence om ervoor te zorgen dat deze resultaten technisch verdedigbaar zijn door de bredere gemeenschap, " voegde Goulet eraan toe. Maar onderzoeksresultaten zoals deze zijn belangrijk om verder te gaan dan algemene bouwvoorschriften die in sommige gevallen onvoldoende het risico vertegenwoordigen waarmee een regio wordt geconfronteerd, terwijl ze in andere gevallen te conservatief zijn.

"De hoop is dat dit soort modellen ons zal helpen seismisch gevaar beter te karakteriseren, dus we besteden onze middelen om sterke, veilig, veerkrachtige gebouwen waar ze het meest nodig zijn, ' zei Milner.

Droogijs versus Vloeibare stikstof

Droogijs versus Vloeibare stikstof  Op woestijnkever geïnspireerde magnetische demulgator ontwikkeld met uitstekende olie-in-water-emulsiescheidingsprestaties

Op woestijnkever geïnspireerde magnetische demulgator ontwikkeld met uitstekende olie-in-water-emulsiescheidingsprestaties Baanbrekende door rood licht geactiveerde anti-tumor prodrug vermindert bijwerkingen

Baanbrekende door rood licht geactiveerde anti-tumor prodrug vermindert bijwerkingen Chemicus suggereert een manier om de smaak van bier te meten

Chemicus suggereert een manier om de smaak van bier te meten Stokken en stenen kunnen je botten breken, maar deze reactie bewerkt skeletten

Stokken en stenen kunnen je botten breken, maar deze reactie bewerkt skeletten

Nieuwe studie onthult geheimen van Wolfe Creek Crater

Nieuwe studie onthult geheimen van Wolfe Creek Crater Het antropoceen begon in 1965, volgens tekens in 's werelds eenzaamste boom

Het antropoceen begon in 1965, volgens tekens in 's werelds eenzaamste boom Grand Challenge-review benadrukt de wereldwijde impact van microplastics

Grand Challenge-review benadrukt de wereldwijde impact van microplastics Sterren en wetenschappers roepen op dat de wereld niet terug naar normaal gaat

Sterren en wetenschappers roepen op dat de wereld niet terug naar normaal gaat Inleiding tot spaarlampen

Inleiding tot spaarlampen

Hoofdlijnen

- Ricine alleen dodelijk in combinatie met suiker

- Gezocht:vrijwillige schutters om kudde bizons in Grand Canyon uit te dunnen (update)

- Stamboom van Homo Sapiens blijft evolueren

- Wetenschappers zoeken naar overlevenden nadat de Thomas-brand een condorreservaat heeft verschroeid

- Trofisch niveau (voedselketen en web): definitie en voorbeelden (met diagram)

- Waar komt de kleur vandaan in paarse kool?

- Hoe groeit schimmel op brood?

- Nieuwe methode voor het planten van citrusvruchten stopt insecten, levert extra voordelen op

- Zit moraliteit in de hersenen?

- Hoe The Nature Conservancy werkt

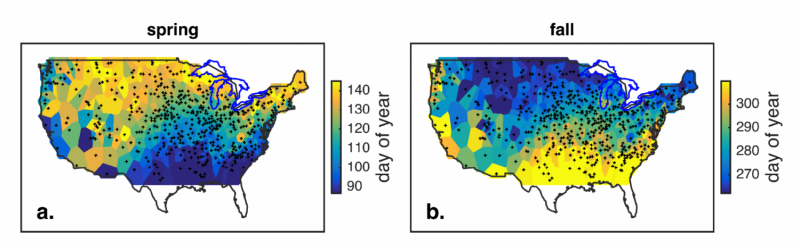

- De beste landbouwpraktijken voor bodemgezondheid verschillen per regio

- Bodemdegradatie kost Amerikaanse maïsboeren een half miljard dollar per jaar

- Arctische onderzoeksexpeditie wordt waarschijnlijk geconfronteerd met extreme omstandigheden in het snel veranderende Noordpoolgebied

- Luchtcirculatie beïnvloedt vorst meer dan opwarming van de aarde - voorlopig

Nieuwe ontdekking van walvisfossielen uit Peru werpt licht op walvisafstamming

Nieuwe ontdekking van walvisfossielen uit Peru werpt licht op walvisafstamming Transparante elektronica van op grafeen gebaseerde elektroden (met video)

Transparante elektronica van op grafeen gebaseerde elektroden (met video) NASA krijgt een infraroodbeeld van orkaan Oscar

NASA krijgt een infraroodbeeld van orkaan Oscar De elektrische eigenschappen van grafenen op atomair niveau begrijpen

De elektrische eigenschappen van grafenen op atomair niveau begrijpen Formeel bosbeheerbeleid van de gemeenschap leidt vaak tot verminderde toegang, bronrechten

Formeel bosbeheerbeleid van de gemeenschap leidt vaak tot verminderde toegang, bronrechten Een van de dichtste clusters van sterrenstelsels in het heelal wordt onthuld

Een van de dichtste clusters van sterrenstelsels in het heelal wordt onthuld Microben kunnen astronauten helpen om menselijk afval om te zetten in voedsel

Microben kunnen astronauten helpen om menselijk afval om te zetten in voedsel Amazon werkt naar verluidt aan een door Alexa aangedreven wearable die menselijke emoties leest

Amazon werkt naar verluidt aan een door Alexa aangedreven wearable die menselijke emoties leest

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | German | Dutch | Danish | Norway | Swedish |

-

Wetenschap © https://nl.scienceaq.com