Wetenschap

Onderzoek laat zien hoe AI-modellen potentieel gevaarlijke snelkoppelingen nemen bij het oplossen van complexe herkenningstaken

Krediet:Universiteit van York

Diepe convolutionele neurale netwerken (DCNN's) zien objecten niet zoals mensen dat doen - met behulp van configuratie-vormperceptie - en dat kan gevaarlijk zijn in real-world AI-toepassingen, zegt professor James Elder, co-auteur van een onderzoek van de Universiteit van York dat vandaag is gepubliceerd.

Gepubliceerd in het tijdschrift Cell Press iScience , Deep learning-modellen slagen er niet in om de configuratie van menselijke vormperceptie vast te leggen, is een gezamenlijke studie van Elder, die de York Research Chair in Human and Computer Vision bekleedt en mededirecteur is van York's Center for AI &Society, en assistent-professor psychologie Nicholas Baker aan het Loyola College in Chicago, een voormalig postdoctoraal onderzoeker van VISTA in York.

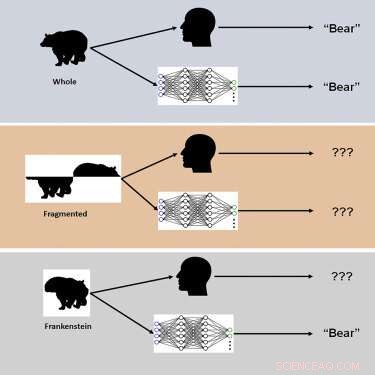

De studie maakte gebruik van nieuwe visuele stimuli genaamd "Frankensteins" om te onderzoeken hoe het menselijk brein en DCNN's holistische, configuratie-objecteigenschappen verwerken.

"Frankensteins zijn gewoon objecten die uit elkaar zijn gehaald en op de verkeerde manier weer in elkaar zijn gezet", zegt Elder. "Daardoor hebben ze alle juiste lokale kenmerken, maar op de verkeerde plaatsen."

De onderzoekers ontdekten dat hoewel het menselijke visuele systeem wordt verward door Frankensteins, DCNN's niet een ongevoeligheid voor configuratieobjecteigenschappen onthullen.

"Onze resultaten verklaren waarom diepe AI-modellen onder bepaalde omstandigheden falen en wijzen op de noodzaak om taken te overwegen die verder gaan dan objectherkenning om visuele verwerking in de hersenen te begrijpen", zegt Elder. "Deze diepe modellen hebben de neiging om 'snelkoppelingen' te gebruiken bij het oplossen van complexe herkenningstaken. Hoewel deze snelkoppelingen in veel gevallen kunnen werken, kunnen ze gevaarlijk zijn in sommige van de echte AI-toepassingen waaraan we momenteel werken met onze industrie- en overheidspartners, " Ouderling wijst erop.

Een voorbeeld van zo'n toepassing zijn verkeersvideo-veiligheidssystemen:"De objecten in een drukke verkeerssituatie - de voertuigen, fietsen en voetgangers - hinderen elkaar en komen in het oog van een bestuurder als een wirwar van losgekoppelde fragmenten", legt Elder uit. "Het brein moet die fragmenten correct groeperen om de juiste categorieën en locaties van de objecten te identificeren. Een AI-systeem voor verkeersveiligheidsmonitoring dat alleen de fragmenten afzonderlijk kan waarnemen, zal bij deze taak falen, waardoor risico's voor kwetsbare weggebruikers mogelijk verkeerd worden begrepen. "

Volgens de onderzoekers leidden aanpassingen aan training en architectuur om netwerken hersenachtiger te maken niet tot configuratieverwerking, en geen van de netwerken was in staat om de beoordeling van menselijke objecten nauwkeurig te voorspellen. "We speculeren dat om de menselijke configuratiegevoeligheid te evenaren, netwerken moeten worden getraind om een breder scala aan objecttaken op te lossen die verder gaan dan categorieherkenning", merkt Elder op. + Verder verkennen

Het bevorderen van menselijke waarneming in zelfrijdende voertuigen

In gloeiende kleuren:de verspreiding van medicijndeeltjes in een forensisch laboratorium zien

In gloeiende kleuren:de verspreiding van medicijndeeltjes in een forensisch laboratorium zien Nieuwe toepassingen vinden voor afvalbanden

Nieuwe toepassingen vinden voor afvalbanden Nieuwe 3D-röntgentechniek onthult geheimen van binnenuit botten

Nieuwe 3D-röntgentechniek onthult geheimen van binnenuit botten Kenmerken van zuren, basen en zouten

Kenmerken van zuren, basen en zouten  Gemeenschappelijke herbicideverbinding kan miljoenen levens redden

Gemeenschappelijke herbicideverbinding kan miljoenen levens redden

Aanjager van de grootste massa-extinctie in de geschiedenis van de aarde geïdentificeerd

Aanjager van de grootste massa-extinctie in de geschiedenis van de aarde geïdentificeerd Waarborgen van de veiligheid van offshore koolstofopslag

Waarborgen van de veiligheid van offshore koolstofopslag Rode en groene sneeuwalgen zorgen ervoor dat de sneeuw smelt op het Antarctisch Schiereiland

Rode en groene sneeuwalgen zorgen ervoor dat de sneeuw smelt op het Antarctisch Schiereiland IJswolken zaaien met uitstoot van natuurbranden

IJswolken zaaien met uitstoot van natuurbranden Nieuw systeem om aardbevingsgegevens Nepal te verwerken

Nieuw systeem om aardbevingsgegevens Nepal te verwerken

Hoofdlijnen

- Metafase: wat gebeurt er in dit stadium van mitose en meiose?

- Wat zijn de functies van co-enzymen?

- Onderzoekers ontdekken dat het nauwkeurig transcriberen van DNA het herstel van DNA opheft

- Afrikaanse pinguïns blijken samen te werken om vissen bijeen te jagen om te foerageren

- AI gebruiken om genomische afwegingen tussen soorten mutaties te identificeren

- Een nieuwe studie toont aan dat mieren voor de verstandigere optie kiezen, zelfs als dat betekent dat je wat harder moet werken

- Hoe u een mRNA-reeks kunt berekenen

- Wat maakt de mens menselijk?

- Denk je dat je een hersenschudding hebt? Een bloedtest kan het diagnosticeren

- Welkom bij de eerste pandemie van sociale media. Hier zijn 8 manieren waarop u de verspreiding van verkeerde informatie over het coronavirus kunt stoppen.

- Een platform om cruciale informatie uit satellietbeelden te halen

- Japan plant strengere regulering van techreuzen

- Een versterkend leerkader om de voetbalschietvaardigheden van viervoetige robots te verbeteren

- Sludge:hoe bedrijven ons ertoe aanzetten meer uit te geven

Geluid zien:wetenschappers observeren hoe akoestische interacties materialen op atomair niveau veranderen

Geluid zien:wetenschappers observeren hoe akoestische interacties materialen op atomair niveau veranderen Nieuwe oplossing om de strijd met hoogslapers te beëindigen

Nieuwe oplossing om de strijd met hoogslapers te beëindigen Gebruik van geradicaliseerde NOₓ-derivaten op metaaloxiden

Gebruik van geradicaliseerde NOₓ-derivaten op metaaloxiden Hoe driehoekshoekmetingen te vinden

Hoe driehoekshoekmetingen te vinden Kunnen residentiële warmtepompen deel uitmaken van de klimaatoplossing?

Kunnen residentiële warmtepompen deel uitmaken van de klimaatoplossing? Nieuw ondersteunend materiaal voor recyclebare toepassing van fotokatalysatorpoeders

Nieuw ondersteunend materiaal voor recyclebare toepassing van fotokatalysatorpoeders Winst Daimler loopt vooruit in derde kwartaal

Winst Daimler loopt vooruit in derde kwartaal Video:klimaatbericht van astronauten

Video:klimaatbericht van astronauten

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com