Wetenschap

Een raamwerk voor robotnavigatie binnenshuis bij mensen

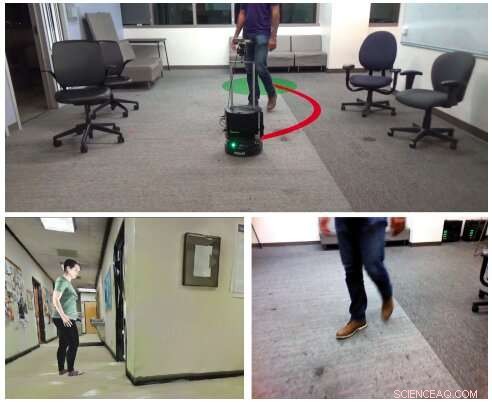

(Top) Een autonoom visueel navigatiescenario overwogen door de onderzoekers, in een voorheen onbekende, binnenmilieu met mensen, met monoculaire RGB-afbeeldingen (rechtsonder). Om machines te leren navigeren in binnenomgevingen met mensen, de onderzoekers creëerden HumANav, een dataset die fotorealistische weergave mogelijk maakt in gesimuleerde omgevingen (bijvoorbeeld linksonder). Krediet:Tolani et al.

Om de taken aan te pakken waarvoor ze zijn ontworpen, mobiele robots moeten in staat zijn om efficiënt door de echte wereld te navigeren, het vermijden van mensen of andere obstakels in hun omgeving. Hoewel statische objecten doorgaans vrij eenvoudig zijn voor robots om te detecteren en te omzeilen, het vermijden van mensen kan een grotere uitdaging zijn, omdat het inhoudt dat ze hun toekomstige bewegingen moeten voorspellen en dienovereenkomstig plannen.

Onderzoekers van de Universiteit van Californië, Berkeley, hebben onlangs een nieuw raamwerk ontwikkeld dat robotnavigatie bij mensen in binnenomgevingen zoals kantoren, huizen of musea. hun voorbeeld, gepresenteerd in een paper dat vooraf is gepubliceerd op arXiv, werd getraind op een nieuw samengestelde dataset van fotorealistische afbeeldingen genaamd HumANav.

"We stellen een nieuw raamwerk voor voor navigatie rond mensen dat op leren gebaseerde waarneming combineert met op modellen gebaseerde optimale controle, ’ schreven de onderzoekers in hun paper.

Het nieuwe raamwerk dat deze onderzoekers ontwikkelden, genaamd LB-WayPtNav-DH, heeft drie belangrijke componenten:een perceptie, een planning, en een regelmodule. De waarnemingsmodule is gebaseerd op een convolutioneel neuraal netwerk (CNN) dat is getraind om de visuele invoer van de robot in een waypoint (d.w.z. de volgende gewenste toestand) met behulp van begeleid leren.

Het door de CNN in kaart gebrachte waypoint wordt vervolgens naar de planning- en controlemodules van het framework gevoerd. gecombineerd, deze twee modules zorgen ervoor dat de robot veilig naar zijn doellocatie beweegt, obstakels en mensen in de omgeving te vermijden.

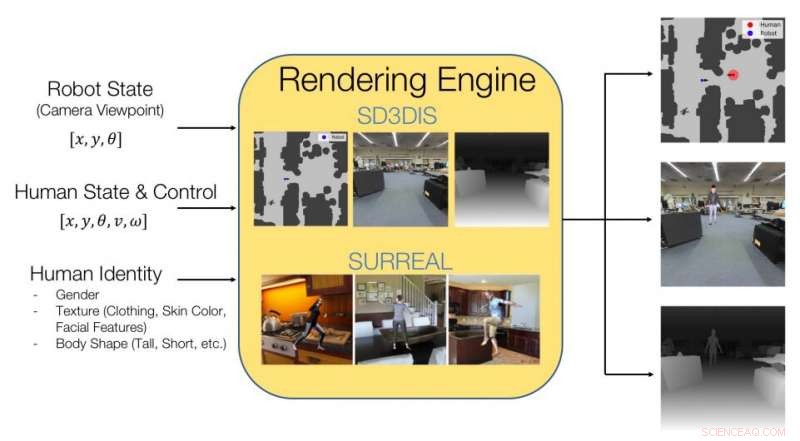

Afbeelding waarin wordt uitgelegd wat de HumANav-dataset bevat en hoe deze een fotorealistische weergave van binnenomgevingen met mensen bereikt. Krediet:Tolani et al.

De onderzoekers trainden hun CNN op afbeeldingen die zijn opgenomen in een dataset die ze hebben samengesteld, genaamd HumANav. HumANav bevat fotorealistische, gerenderde beelden van gesimuleerde bouwomgevingen waarin mensen zich verplaatsen, aangepast van een andere dataset genaamd SURREAL. Deze afbeeldingen beelden 6000 wandelende, getextureerde menselijke mazen, gerangschikt op lichaamsvorm, geslacht en snelheid.

"Het voorgestelde raamwerk leert te anticiperen op en te reageren op bewegingen van mensen, alleen gebaseerd op een monoculair RGB-beeld, zonder expliciet toekomstige menselijke bewegingen te voorspellen, ’ schreven de onderzoekers in hun paper.

De onderzoekers evalueerden LB-WayPtNav-DH in een reeks experimenten, zowel in simulaties als in de echte wereld. In praktijkexperimenten, ze pasten het toe op Turtlebot 2, een goedkope mobiele robot met open source software. De onderzoekers melden dat het robotnavigatieraamwerk goed generaliseert naar onzichtbare gebouwen, effectief mensen omzeilen, zowel in gesimuleerde als in de echte wereld.

"Onze experimenten tonen aan dat het combineren van op modellen gebaseerde controle en leren leidt tot beter en data-efficiënter navigatiegedrag in vergelijking met een puur op leren gebaseerde benadering, ’ schreven de onderzoekers in hun paper.

Het nieuwe raamwerk zou uiteindelijk kunnen worden toegepast op een verscheidenheid aan mobiele robots, hun navigatie in binnenomgevingen te verbeteren. Tot dusver, hun aanpak blijkt opmerkelijk goed te presteren, het overbrengen van beleid ontwikkeld in simulatie naar real-world omgevingen.

In hun toekomstige studies, de onderzoekers zijn van plan hun raamwerk te trainen op afbeeldingen van complexere of drukke omgevingen. In aanvulling, ze willen de trainingsdataset die ze hebben samengesteld uitbreiden, inclusief een meer diverse reeks afbeeldingen.

© 2020 Wetenschap X Netwerk

China wordt geconfronteerd met aanzienlijk warmere zomers en winters in 2050

China wordt geconfronteerd met aanzienlijk warmere zomers en winters in 2050 Onderzoek naar kustoverstromingen vindt vertrouwensopbouw, machtsdelingssleutel voor milieurechtvaardigheid

Onderzoek naar kustoverstromingen vindt vertrouwensopbouw, machtsdelingssleutel voor milieurechtvaardigheid Wereldwijd rapport over plastic bedreigingen voor de oceaan

Wereldwijd rapport over plastic bedreigingen voor de oceaan Breed draagvlak voor ambitieus klimaatbeleid als aan vier voorwaarden wordt voldaan

Breed draagvlak voor ambitieus klimaatbeleid als aan vier voorwaarden wordt voldaan De ijsbergproductie meten met aardbevingen

De ijsbergproductie meten met aardbevingen

Hoofdlijnen

- Hoe zijn fytoplankton reproductie?

- Energiebesparende LED's stimuleren wereldwijd lichtvervuiling

- Kenmerken van micro-organismen

- VN schotelt vijgcactus voor als antwoord op voedselzekerheid

- Onderzoekers vinden eerste wilde alligator brekende schildpad in Illinois sinds 1984

- Profase: wat gebeurt er in dit stadium van mitose en meiose?

- DNA-sequentiebepaling: definitie, methoden, voorbeelden

- Bevindingen sonde cel samenwerking, massale migratie

- Een vis, twee vissen - met behulp van een nieuw door MBARI ontworpen camerasysteem om roodbaars te tellen

- MoviePass-operaties in onderzoek door New York AG

- Energie sluipt stiekem mee in de wereldhandel

- Milieuvriendelijke en efficiënte propaanwarmtepomp

- Nieuwe technologie zal de energieopbrengst van PV-modules aanzienlijk verbeteren

- Netwerksoftware optimaliseren om wetenschappelijke ontdekkingen te bevorderen

VTT ontwikkelde een optische vezel van cellulose

VTT ontwikkelde een optische vezel van cellulose Simulatie van de krachten die door oceaanstromingen op cilinders worden geïnduceerd, zou kunnen helpen bij het ontwerp van offshore-platforms

Simulatie van de krachten die door oceaanstromingen op cilinders worden geïnduceerd, zou kunnen helpen bij het ontwerp van offshore-platforms Polluties Effecten op dieren

Polluties Effecten op dieren  Waar worden robijnen gemolken?

Waar worden robijnen gemolken?  Doden windturbines vogels?

Doden windturbines vogels?  Hoe kunnen counselors sociale rechtvaardigheid aanpakken tijdens klimaatverandering?

Hoe kunnen counselors sociale rechtvaardigheid aanpakken tijdens klimaatverandering? Onderzoek naar kankerverwekkende nanodeeltjes warmt op

Onderzoek naar kankerverwekkende nanodeeltjes warmt op Naarmate het extreme weer toeneemt, verkeerde informatie over het klimaat past zich aan

Naarmate het extreme weer toeneemt, verkeerde informatie over het klimaat past zich aan

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com