Wetenschap

Big data omzetten in realtime, bruikbare intelligentie

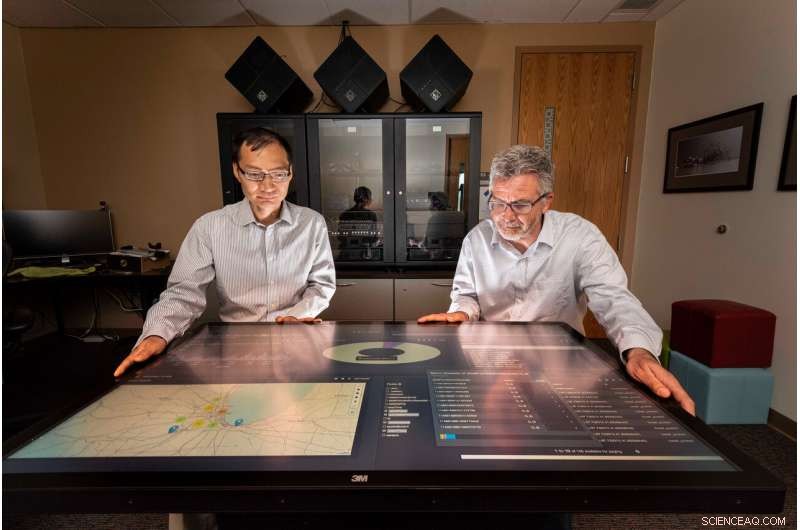

Sandia National Laboratories computerwetenschappers Tian Ma, links, en Rudy Garcia, leidde een project om bruikbare informatie uit streaminggegevens in bijna realtime te leveren. Krediet:Randy Montoya

Sociale media, camera's, sensoren en meer genereren enorme hoeveelheden gegevens die analisten kunnen overweldigen als ze alles doorzoeken op zinvolle, bruikbare informatie om besluitvormers, zoals politieke leiders en veldcommandanten, te voorzien in reactie op veiligheidsdreigingen.

Onderzoekers van Sandia National Laboratories werken eraan om die last te verminderen door de wetenschap te ontwikkelen om in bijna realtime inzichten uit gegevens te verzamelen.

"De hoeveelheid gegevens die door sensoren en sociale media wordt geproduceerd, groeit enorm - elke dag wordt er ongeveer 2,5 triljoen (of 2,5 miljard miljard) bytes aan gegevens gegenereerd, " zei Tian Ma, een Sandia-computerwetenschapper en co-leider van het project. "Ongeveer 90% van alle gegevens is de afgelopen twee jaar gegenereerd - er zijn meer gegevens dan we mensen hebben om te analyseren. Inlichtingengemeenschappen zijn in feite overweldigd, en het probleem is dat je uiteindelijk veel gegevens op schijven krijgt die over het hoofd kunnen worden gezien."

Sandia-onderzoekers werkten samen met studenten van de University of Illinois Urbana-Champaign, een Academic Alliance-partner, om analytische en besluitvormingsalgoritmen te ontwikkelen voor het streamen van gegevensbronnen en deze te integreren in een bijna realtime gedistribueerd gegevensverwerkingsraamwerk met behulp van big data-tools en computerbronnen bij Sandia. Het framework haalt verschillende gegevens uit meerdere bronnen en genereert bruikbare informatie waarop in bijna realtime kan worden gereageerd.

Om het raamwerk te testen, de onderzoekers en de studenten gebruikten verkeersgegevens uit Chicago, zoals afbeeldingen, geïntegreerde sensoren, tweets en streaming-tekst om verkeersopstoppingen met succes te meten en snellere rijroutes eromheen voor een forens uit Chicago voor te stellen. Het onderzoeksteam koos het Chicago-verkeersvoorbeeld omdat de ingevoerde gegevens vergelijkbare kenmerken hebben als gegevens die doorgaans worden waargenomen voor nationale veiligheidsdoeleinden, zei Rudy Garcia, een Sandia-computerwetenschapper en co-leider van het project.

Verdrinken in gegevens

"We creëren data zonder er zelfs maar over na te denken, " zei Laura Patrizi, een Sandia computerwetenschapper en onderzoeksteamlid, tijdens een lezing op het GEOINT Symposium van de United States Geospatial Intelligence Foundation in 2019. "Als we rondlopen met onze telefoon in onze zak of tweeten over vreselijk verkeer, onze telefoon volgt onze locatie en kan een geolocatie aan onze tweet koppelen."

Om deze datalawine te benutten, analisten gebruiken doorgaans big data-tools en machine learning-algoritmen om belangrijke informatie te vinden en te markeren, maar het proces draait op geregistreerde gegevens, zei mama.

"We wilden zien wat er kan worden geanalyseerd met realtime gegevens uit meerdere gegevensbronnen, niet wat kan worden geleerd van het ontginnen van historische gegevens, Ma zei. "Actiegerichte intelligentie is het volgende niveau van gegevensanalyse waarbij analyse wordt gebruikt voor bijna-realtime besluitvorming. Het succes van dit onderzoek zal een grote impact hebben op veel tijdkritische nationale veiligheidstoepassingen."

Een kader voor gegevensverwerking bouwen

Het team stapelde gedistribueerde technologieën in een reeks gegevensverwerkingspijplijnen die beheer en indexeer de gegevens. De wetenschappers die ruzie maakten over de gegevens, gaven aan hoe de pijpleidingen de gegevens moesten verzamelen en opschonen.

"Elk type gegevens dat we opnemen heeft zijn eigen gegevensschema en -formaat, " zei Garcia. "Om de gegevens bruikbaar te maken, het moet eerst worden samengesteld, zodat het gemakkelijk kan worden ontdekt voor een evenement."

Hortonworks-gegevensplatform, draait op Sandia's computers, werd gebruikt als de software-infrastructuur voor de dataverwerking en analytische pijplijnen. Binnen Hortonworks, het team ontwikkelde en integreerde Apache Storm-topologieën voor elke datapijplijn. De samengestelde gegevens werden vervolgens opgeslagen in Apache Solr, een enterprise-zoekmachine en -database. PyTorch en Lucidwork's Banana werden gebruikt voor detectie van voertuigobjecten en datavisualisatie.

De juiste gegevens vinden

"Grote hoeveelheden data binnenhalen is moeilijk, maar het is nog moeilijker om de informatie te vinden die u echt zoekt, " zei Garcia. "Bijvoorbeeld, tijdens het project zouden we tweets zien die iets zeggen als "De luchtverkeersleiding heeft ons het afgelopen uur op de grond gehouden op Midway." Verkeer zit in de tweet, maar het is niet relevant voor het snelwegverkeer."

Om de mate van verkeersopstoppingen op een snelweg in Chicago te bepalen, idealiter zou de tool een verscheidenheid aan gegevenstypen kunnen gebruiken, inclusief een verkeerscamera die de stroming in beide richtingen laat zien, geolokaliseerde tweets over ongevallen, wegsensoren die de gemiddelde snelheid meten, satellietbeelden van de gebieden en verkeersborden die de huidige reistijden tussen mijlpalen schatten, zei Forest Danford, een Sandia computerwetenschapper en onderzoeksteamlid.

"Echter, we krijgen ook veel slechte gegevens zoals een afbeelding van een webcamera die moeilijk te lezen is, en het komt zelden voor dat we eindigen met veel verschillende gegevenstypes die zeer nauw op elkaar zijn gelokaliseerd in tijd en ruimte, "Zei Danford. "We hadden een mechanisme nodig om te leren over de meer dan 90 miljoen gebeurtenissen (gerelateerd aan verkeer in Chicago) die we hebben waargenomen om beslissingen te kunnen nemen op basis van onvolledige of onvolmaakte informatie."

Het team heeft een classificatie voor verkeersopstoppingen toegevoegd door samengevoegde computersystemen te trainen die zijn gemodelleerd naar het menselijk brein op functies die zijn geëxtraheerd uit gelabelde afbeeldingen en tweets, en andere gebeurtenissen die in tijd en ruimte overeenkwamen met de gegevens. De getrainde classifier was in staat om voorspellingen te genereren over verkeersopstoppingen op basis van operationele gegevens op een bepaald tijdstip en locatie, zei Danford.

De professoren Minh Do en Ramavarapu Sreenivas en hun studenten aan de UIUC werkten aan real-time object- en beeldherkenning met beeldvorming via webcamera's en ontwikkelden robuuste routeplanningsprocessen op basis van de verschillende gegevensbronnen.

"Het ontwikkelen van overtuigende wetenschap voor bruikbare intelligentie vereist dat we worstelen met op informatie gebaseerde dynamiek, " Zei Sreenivas. "De heilige graal hier is om het specificatieprobleem op te lossen. We moeten weten wat we willen voordat we iets bouwen dat ons krijgt wat we willen. Dit is veel moeilijker dan het lijkt, en dit project is de eerste stap om precies te begrijpen wat we zouden willen hebben."

Vooruit gaan, het Sandia-team draagt de architectuur over, analyses en lessen die in Chicago zijn geleerd voor andere overheidsprojecten en zal analytische instrumenten blijven onderzoeken, verbeteringen aanbrengen in het objectherkenningsmodel van Labs en werken aan het genereren van zinvolle, bruikbare intelligentie.

"We proberen gegevens vindbaar te maken, toegankelijk en bruikbaar, "Zei Garcia. "En als we dat kunnen doen via deze big data-architecturen, dan denk ik dat we helpen."

Alarmerend lage regenniveaus zorgen ervoor dat Californië in de zomer brandgevaarlijk is, val

Alarmerend lage regenniveaus zorgen ervoor dat Californië in de zomer brandgevaarlijk is, val De verbranding van kolen moet aan banden worden gelegd als de opwarming van de aarde deze eeuw tot 1,5 C moet worden beperkt

De verbranding van kolen moet aan banden worden gelegd als de opwarming van de aarde deze eeuw tot 1,5 C moet worden beperkt Arctische smeltvijvers ontstaan wanneer smeltwater de ijsporiën verstopt

Arctische smeltvijvers ontstaan wanneer smeltwater de ijsporiën verstopt Geologen rapporteren eerder bewijs van dreigend massaal uitsterven in het Perm, en hedendaagse parallellen

Geologen rapporteren eerder bewijs van dreigend massaal uitsterven in het Perm, en hedendaagse parallellen Het tijdvenster voor het doel van 1,5 graad wordt gesloten

Het tijdvenster voor het doel van 1,5 graad wordt gesloten

Hoofdlijnen

- Wat is Tastile Stimulation?

- Biocomputer aangedreven door kwallen-DNA speelt Tetris en andere retro-videogames

- Naarmate het klimaat warmer wordt, meer vogelnesten worden vernietigd in Finse landbouwgronden

- Het belang van wetenschappelijke namen voor organismen

- Een rol van lipiden bij celdeling

- Glycosylering - onbekend terrein in kaart brengen

- 10 manieren om jezelf gelukkig te maken

- Type energie geproduceerd door fotosynthese

- Bio-ethicus bespreekt vier sleutels om te weten over mogelijkheden, valkuilen van genbewerking

- Facebook-bug deblokkeert een tijdje ongewenste verbindingen (update)

- Zachte tactiele logica-technologie verdeelt de besluitvorming over rekbaar materiaal

- SoftBank, Saoedi-Arabië kondigt grootschalig zonne-energieproject aan

- Hoe automatisering booreilanden veiliger maakt

- First lady roept technologiebedrijven bijeen om cyberpesten aan te pakken

Pandemie onderstreept grove ongelijkheden in Zuid-Afrika, en de noodzaak om ze te repareren

Pandemie onderstreept grove ongelijkheden in Zuid-Afrika, en de noodzaak om ze te repareren De chemische samenstelling van een ster verbinden met planeetvorming

De chemische samenstelling van een ster verbinden met planeetvorming Uitgerekte fotonen herstellen verloren interferentie

Uitgerekte fotonen herstellen verloren interferentie Manipulatie van licht door kleine technologie kan grote voordelen opleveren voor alles, van tv's tot microscopen

Manipulatie van licht door kleine technologie kan grote voordelen opleveren voor alles, van tv's tot microscopen UNESCO dringt er bij Polen op aan te stoppen met het kappen van oerbos

UNESCO dringt er bij Polen op aan te stoppen met het kappen van oerbos Onderzoekers bestuderen een neutrale waterstofsuperschil in de Melkweg

Onderzoekers bestuderen een neutrale waterstofsuperschil in de Melkweg WeWork verliest $ 1,25 miljard in derde kwartaal

WeWork verliest $ 1,25 miljard in derde kwartaal Waarom mochten toeristen op White Island?

Waarom mochten toeristen op White Island?

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com