Wetenschap

AI kan een kracht zijn voor positieve sociale verandering, maar stevent momenteel af op een donkere toekomst

Krediet:Markus Spiske/Unsplash, FAL

Kunstmatige intelligentie (AI) herconfigureert de wereld al op opvallende manieren. Gegevens zijn de drijvende kracht achter ons wereldwijde digitale ecosysteem, en AI-technologieën onthullen patronen in gegevens. Smartphones, slimme huizen, en slimme steden beïnvloeden hoe we leven en met elkaar omgaan, en AI-systemen worden steeds meer betrokken bij wervingsbeslissingen, medische diagnoses, en rechterlijke uitspraken. Of dit scenario utopisch of dystopisch is, hangt af van uw perspectief.

De potentiële risico's van AI worden herhaaldelijk opgesomd. Moordende robots en massale werkloosheid zijn veelvoorkomende zorgen, terwijl sommige mensen zelfs bang zijn voor het uitsterven van de mens. Meer optimistische voorspellingen beweren dat AI in 2030 15 biljoen dollar aan de wereldeconomie zal toevoegen, en ons uiteindelijk naar een soort sociaal nirvana leiden.

We moeten zeker rekening houden met de impact die dergelijke technologieën hebben op onze samenlevingen. Een belangrijk punt van zorg is dat AI-systemen bestaande sociale vooroordelen versterken, met schadelijke gevolgen. Verschillende beruchte voorbeelden van dit fenomeen hebben veel aandacht gekregen:geavanceerde geautomatiseerde automatische vertaalsystemen die seksistische output produceren, en beeldherkenningssystemen die zwarte mensen classificeren als gorilla's.

Deze problemen ontstaan omdat dergelijke systemen wiskundige modellen (zoals neurale netwerken) gebruiken om patronen in grote sets trainingsgegevens te identificeren. Als die gegevens op verschillende manieren erg scheef zijn, dan zullen de inherente vooroordelen onvermijdelijk worden geleerd en gereproduceerd door de getrainde systemen. Bevooroordeelde autonome technologieën zijn problematisch omdat ze groepen zoals vrouwen, etnische minderheden, of ouderen, waardoor bestaande sociale onevenwichtigheden worden verergerd.

Als AI-systemen worden getraind op gegevens van politie-arrestaties, bijvoorbeeld, dan zouden alle bewuste of onbewuste vooroordelen die zich manifesteren in de bestaande arrestatiepatronen worden gerepliceerd door een "predictive policing" AI-systeem dat op die gegevens is getraind. Zich bewust van de ernstige gevolgen hiervan, verschillende gezaghebbende organisaties hebben onlangs geadviseerd dat alle AI-systemen moeten worden getraind op onbevooroordeelde gegevens. Ethische richtlijnen die eerder in 2019 door de Europese Commissie werden gepubliceerd, boden de volgende aanbeveling:"Wanneer gegevens worden verzameld, het kan sociaal geconstrueerde vooroordelen bevatten, onnauwkeurigheden, fouten en fouten. Dit moet worden aangepakt voorafgaand aan de training met een bepaalde dataset."

Omgaan met vooringenomen gegevens

Dit klinkt allemaal verstandig genoeg. Maar helaas, het is soms gewoonweg onmogelijk om ervoor te zorgen dat bepaalde datasets onbevooroordeeld zijn voorafgaand aan de training. Een concreet voorbeeld zou dit moeten verduidelijken.

Alle geavanceerde machinevertaalsystemen (zoals Google Translate) zijn getraind op zinsparen. Een Engels-Frans systeem gebruikt gegevens die Engelse zinnen ("she is tall") associeert met equivalente Franse zinnen ("she is tall") elle est grande "). Er kunnen 500 m van dergelijke koppelingen zijn in een bepaalde set trainingsgegevens, en dus in totaal een miljard afzonderlijke zinnen. Alle gendergerelateerde vooroordelen zouden uit een dergelijke dataset moeten worden verwijderd als we willen voorkomen dat het resulterende systeem seksistische resultaten oplevert, zoals:

- Invoer :De vrouwen begonnen de vergadering. Ze werkten efficiënt.

- Uitgang: :Les femmes ont commencé la réunion. Ils ont travaillé efficacement.

De Franse vertaling is gegenereerd met Google Translate op 11 oktober 2019, en het is onjuist:" Ils " is het mannelijke meervoud onderwerp voornaamwoord in het Frans, en het verschijnt hier ondanks de context die duidelijk aangeeft dat er naar vrouwen wordt verwezen. Dit is een klassiek voorbeeld van het feit dat de mannelijke standaard de voorkeur heeft van het geautomatiseerde systeem vanwege vooroordelen in de trainingsgegevens.

In het algemeen, 70% van de geslachtsgebonden voornaamwoorden in vertaaldatasets zijn mannelijk, terwijl 30% vrouwelijk is. Dit komt omdat de teksten die voor dergelijke doeleinden worden gebruikt, meer naar mannen verwijzen dan naar vrouwen. Om te voorkomen dat vertaalsystemen deze bestaande vooroordelen kopiëren, specifieke zinparen zouden uit de gegevens moeten worden verwijderd, zodat de mannelijke en vrouwelijke voornaamwoorden 50%/50% voorkwamen aan zowel de Engelse als de Franse kant. Dit zou voorkomen dat het systeem hogere kansen toekent aan mannelijke voornaamwoorden.

Zelfstandige naamwoorden en bijvoeglijke naamwoorden zouden ook 50%/50% in evenwicht moeten zijn, natuurlijk, aangezien deze in beide talen het geslacht kunnen aangeven ("acteur", "actrice"; "neuf", "neuve") - enzovoort. Maar deze drastische down-sampling zou noodzakelijkerwijs de beschikbare trainingsgegevens aanzienlijk verminderen, waardoor de kwaliteit van de gemaakte vertalingen afneemt.

En zelfs als de resulterende gegevenssubset volledig genderevenwichtig zou zijn, het zou nog steeds op allerlei andere manieren vertekend zijn (zoals etniciteit of leeftijd). in waarheid, het zou moeilijk zijn om al deze vooroordelen te verwijderen volledig . Als één persoon slechts vijf seconden besteedt aan het lezen van elk van de miljard zinnen in de trainingsgegevens, het zou 159 jaar duren om ze allemaal te controleren - en dat veronderstelt de bereidheid om de hele dag en nacht te werken, zonder lunchpauzes.

Een alternatief?

Het is dus onrealistisch om te eisen dat alle trainingsdatasets onbevooroordeeld zijn voordat AI-systemen worden gebouwd. Dergelijke vereisten op hoog niveau gaan er gewoonlijk van uit dat "AI" een homogeen cluster van wiskundige modellen en algoritmische benaderingen aanduidt.

In werkelijkheid, verschillende AI-taken vereisen zeer verschillende soorten systemen. En het bagatelliseren van de volledige omvang van deze diversiteit verhult de echte problemen die worden veroorzaakt door (laten we zeggen) diep vertekende trainingsgegevens. Dit is jammer, omdat dit betekent dat andere oplossingen voor het probleem van gegevensbias worden verwaarloosd.

Bijvoorbeeld, de vooroordelen in een getraind machinevertaalsysteem kunnen aanzienlijk worden verminderd als het systeem wordt aangepast nadat het is getraind op het grotere, onvermijdelijk bevooroordeeld, gegevensverzameling. Dit kan met een veel kleinere, minder scheef, gegevensverzameling. Het merendeel van de gegevens kan sterk vertekend zijn, daarom, maar het systeem dat erop is getraind, hoeft dat niet te zijn. Helaas, deze technieken worden zelden besproken door degenen die belast zijn met het ontwikkelen van richtlijnen en wetgevende kaders voor AI-onderzoek.

Als AI-systemen de bestaande sociale onevenwichtigheden alleen maar versterken, dan belemmeren ze positieve sociale verandering in plaats van ze te vergemakkelijken. Als de AI-technologieën die we steeds vaker gebruiken, veel minder bevooroordeeld zouden zijn dan wij, dan kunnen ze ons helpen onze eigen loerende vooroordelen te herkennen en te confronteren.

Dit is natuurlijk waar we naartoe moeten werken. En dus moeten AI-ontwikkelaars veel zorgvuldiger nadenken over de sociale gevolgen van de systemen die ze bouwen, terwijl degenen die over AI schrijven meer in detail moeten begrijpen hoe AI-systemen eigenlijk worden ontworpen en gebouwd. Want als we inderdaad een technologische idylle of een apocalyps naderen, het eerste zou de voorkeur hebben.

Dit artikel is opnieuw gepubliceerd vanuit The Conversation onder een Creative Commons-licentie. Lees het originele artikel.

Chemici bevorderen het vermogen om chemische reacties te beheersen

Chemici bevorderen het vermogen om chemische reacties te beheersen Onderzoekers vinden nieuwe vorm voor hydrofobe moleculen in water

Onderzoekers vinden nieuwe vorm voor hydrofobe moleculen in water Het creëren van een snellere, on-site manier om bepaalde alkylstoffen te detecteren

Het creëren van een snellere, on-site manier om bepaalde alkylstoffen te detecteren Hoe warmteoverdracht te berekenen

Hoe warmteoverdracht te berekenen Wetenschappers ontwikkelen apparaat om namaak drank te detecteren

Wetenschappers ontwikkelen apparaat om namaak drank te detecteren

Geologen bepalen de breedte en diepte van erosie van een oude tsunami in Noord-Californië

Geologen bepalen de breedte en diepte van erosie van een oude tsunami in Noord-Californië Federale uitgaven voor vuursubsidies kunnen evenwichtiger zijn, nieuw model suggereert:

Federale uitgaven voor vuursubsidies kunnen evenwichtiger zijn, nieuw model suggereert: Oude meteorietinslag leidde tot langlevende vulkaanuitbarstingen op aarde

Oude meteorietinslag leidde tot langlevende vulkaanuitbarstingen op aarde Waarom zijn woestijnen belangrijk?

Waarom zijn woestijnen belangrijk?  Bij benaderingen voor bosbehoud moeten de rechten van de lokale bevolking worden erkend

Bij benaderingen voor bosbehoud moeten de rechten van de lokale bevolking worden erkend

Hoofdlijnen

- Evidence of Evolution: The Origin of Plants, Animals & Fungi

- Noord-Amerikaanse primeur:onderzoekers publiceren wetenschappelijke studie over cannabisproductie

- Wat is de regeling in de microbiologie?

- Flagella: soorten, functie en structuur

- Kleine bijen spelen een grote rol in het geheime seksleven van bomen

- orang-oetans, zoals mensen, geneeskrachtige planten gebruiken om gewrichts- en spierontsteking te behandelen

- Hoe lang kunnen virussen op oppervlakken leven?

- Nieuwe mechanismen ontdekt die bacteriën gebruiken om zichzelf te beschermen tegen antibiotica

- Je lichaam aan: een hittegolf

- Onderzoekers ontdekken ernstige schending van Bluetooth-communicatie

- Waarom hebben we geen elektrische vliegtuigen?

- Norwegian Air snijdt 4, 700 medewerkers in subsidiair faillissement

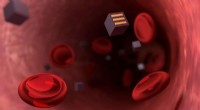

- Ontwikkeling van kankercellen volgen met drinkbare elektronische sensoren

- Iraniërs slagen erin om op internet te surfen ondanks de vloed van censuur

Insecten die leven Underground

Insecten die leven Underground Methaanmysterie van Mars:eerste resultaten van de ExoMars Trace Gas Orbiter

Methaanmysterie van Mars:eerste resultaten van de ExoMars Trace Gas Orbiter NRL ontwikkelt nieuwe low-defect methode om grafeen te dopen met stikstof, resulterend in afstembare bandstructuur

NRL ontwikkelt nieuwe low-defect methode om grafeen te dopen met stikstof, resulterend in afstembare bandstructuur Licht in het donker schijnen:nieuwe ontdekking maakt microscopische beeldvorming mogelijk in donkere omstandigheden

Licht in het donker schijnen:nieuwe ontdekking maakt microscopische beeldvorming mogelijk in donkere omstandigheden Vulkaan Hawaï kan rotsblokken ter grootte van koelkasten uitspuwen

Vulkaan Hawaï kan rotsblokken ter grootte van koelkasten uitspuwen Wetenschappers voeren eerste ruimtegebaseerde meting uit van de levensduur van neutronen

Wetenschappers voeren eerste ruimtegebaseerde meting uit van de levensduur van neutronen Groene ruimten in steden helpen bij het beheersen van overstromingen, koolstof opslaan

Groene ruimten in steden helpen bij het beheersen van overstromingen, koolstof opslaan Voors en tegens in methoden voor het oplossen van vergelijkingssystemen

Voors en tegens in methoden voor het oplossen van vergelijkingssystemen

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Swedish | German | Dutch | Danish | Norway | Portuguese |

-

Wetenschap © https://nl.scienceaq.com