Wetenschap

Decodering van hondencognitie:machine learning geeft een glimp van hoe het brein van een hond vertegenwoordigt wat het ziet

Naturalistische video's en presentatie in MRI-boring. (A) Voorbeeldframes van videoclips die aan de deelnemers worden getoond. (B) Bhubo, een 4-jarige Boxer-mix, kijkt naar video's terwijl hij wakker fMRI ondergaat. Credit:Journal of Visualized Experiments (2022). DOI:10.3791/64442

Wetenschappers hebben visuele beelden van de hersenen van een hond gedecodeerd en bieden een eerste blik op hoe de geest van de hond reconstrueert wat hij ziet. Het Journal of Visualized Experiments publiceerde het onderzoek gedaan aan Emory University.

De resultaten suggereren dat honden meer afgestemd zijn op acties in hun omgeving dan op wie of wat de actie uitvoert.

De onderzoekers registreerden de neurale fMRI-gegevens voor twee wakkere, ongeremde honden terwijl ze video's bekeken in drie sessies van 30 minuten, in totaal 90 minuten. Vervolgens gebruikten ze een machine learning-algoritme om de patronen in de neurale gegevens te analyseren.

"We hebben laten zien dat we de activiteit in de hersenen van een hond kunnen volgen terwijl hij naar een video kijkt en, op zijn minst in beperkte mate, reconstrueren waar hij naar kijkt", zegt Gregory Berns, Emory-hoogleraar psychologie en corresponderend auteur van het artikel. . "Dat we dat kunnen is opmerkelijk."

Het project is geïnspireerd op recente ontwikkelingen op het gebied van machine learning en fMRI om visuele stimuli uit het menselijk brein te decoderen, wat nieuwe inzichten oplevert in de aard van perceptie. Afgezien van mensen, is de techniek toegepast op slechts een handvol andere soorten, waaronder enkele primaten.

"Hoewel ons werk is gebaseerd op slechts twee honden, biedt het een bewijs dat deze methoden werken op hoektanden", zegt Erin Phillips, eerste auteur van het artikel, die het werk deed als onderzoeksspecialist in het Canine Cognitive Neuroscience Lab van Berns. "Ik hoop dat dit artikel de weg vrijmaakt voor andere onderzoekers om deze methoden toe te passen op honden, maar ook op andere soorten, zodat we meer gegevens en grotere inzichten kunnen krijgen in hoe de geest van verschillende dieren werkt."

Phillips, geboren in Schotland, kwam naar Emory als Bobby Jones Scholar, een uitwisselingsprogramma tussen Emory en de Universiteit van St. Andrews. Ze is momenteel een afgestudeerde student in ecologie en evolutionaire biologie aan de Princeton University.

Berns en collega's pionierden met trainingstechnieken om honden in een fMRI-scanner te laten lopen en volledig stil en ongeremd te houden terwijl hun neurale activiteit wordt gemeten. Tien jaar geleden publiceerde zijn team de eerste fMRI-hersenbeelden van een volledig wakkere, ongeremde hond. Dat opende de deur naar wat Berns The Dog Project noemt:een reeks experimenten die de geest van de oudste gedomesticeerde soort onderzoeken.

In de loop der jaren heeft zijn laboratorium onderzoek gepubliceerd naar hoe het hondenbrein visie, woorden, geuren en beloningen verwerkt, zoals het ontvangen van lof of voedsel.

Ondertussen bleef de technologie achter machine-learning computeralgoritmen verbeteren. De technologie heeft wetenschappers in staat gesteld enkele patronen van menselijke hersenactiviteit te decoderen. De technologie "leest gedachten" door binnen hersengegevenspatronen de verschillende objecten of acties te detecteren die een persoon ziet tijdens het bekijken van een video.

"Ik begon me af te vragen:'Kunnen we soortgelijke technieken toepassen op honden?'", herinnert Berns zich.

De eerste uitdaging was om video-inhoud te bedenken die een hond interessant genoeg zou kunnen vinden om voor een langere periode naar te kijken. Het Emory-onderzoeksteam bevestigde een videorecorder op een cardanische ophanging en een selfiestick waarmee ze stabiele beelden konden maken vanuit het perspectief van een hond, ongeveer ter hoogte van de taille van een mens of iets lager.

Ze gebruikten het apparaat om een video van een half uur te maken met scènes die betrekking hebben op het leven van de meeste honden. Activiteiten waren onder meer honden die door mensen werden geaaid en traktaties van mensen kregen. Op scènes met honden was ook te zien dat ze snuffelen, spelen, eten of aan de lijn liepen. Activiteitscènes toonden auto's, fietsen of een scooter die op een weg voorbij reden; een kat die in een huis loopt; een hert dat een pad kruist; mensen zitten; mensen knuffelen of kussen; mensen die een rubberen bot of een bal aanbieden aan de camera; en mensen die eten.

De videogegevens werden op tijdstempels gesegmenteerd in verschillende classificaties, waaronder objectgebaseerde classificaties (zoals hond, auto, mens, kat) en actiegebaseerde classificaties (zoals snuiven, spelen of eten).

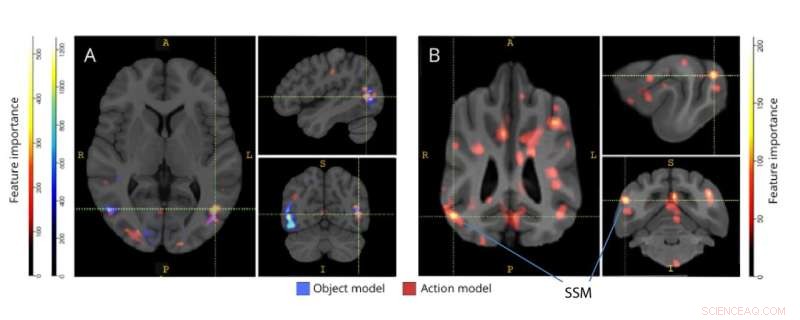

Regio's die belangrijk zijn voor de discriminatie van drie-klassenobjecten en vijf-klassen actiemodellen. (A) mensen en (B) honden deelnemers. Voxels werden gerangschikt op basis van hun functiebelang met behulp van een willekeurige bosclassificatie, gemiddeld over alle iteraties van de modellen. De top 5% van de voxels (d.w.z. die worden gebruikt om modellen te trainen) worden hier gepresenteerd, geaggregeerd per soort en getransformeerd naar groepsruimte voor visualisatiedoeleinden. Labels tonen hersengebieden van honden met hoge scores voor het belang van kenmerken, gebaseerd op die geïdentificeerd door Johnson et al. Afkorting:SSM =de suprasylvian gyrus. Credit:Journal of Visualized Experiments (2022). DOI:10.3791/64442

Slechts twee van de honden die waren getraind voor experimenten in een fMRI hadden de focus en het temperament om volkomen stil te liggen en de 30 minuten durende video zonder pauze te bekijken, inclusief drie sessies van in totaal 90 minuten. Deze twee "superster"-hoektanden waren Daisy, een gemengd ras dat mogelijk deels Boston Terriër is, en Bhubo, een gemengd ras dat mogelijk deels bokser is.

"Ze hadden zelfs geen traktaties nodig", zegt Phillips, die de dieren tijdens de fMRI-sessies in de gaten hield en op de video toekeek hoe hun ogen volgden. "Het was grappig omdat het serieuze wetenschap is, en er is veel tijd en moeite in gestoken, maar het kwam erop neer dat deze honden video's keken van andere honden en mensen die zich een beetje dom deden."

Twee mensen ondergingen ook hetzelfde experiment, waarbij ze dezelfde video van 30 minuten in drie afzonderlijke sessies bekeken, terwijl ze in een fMRI lagen.

De hersengegevens kunnen worden toegewezen aan de videoclassificaties met behulp van tijdstempels.

Een machine-learning-algoritme, een neuraal netwerk dat bekend staat als Ivis, werd op de gegevens toegepast. Een neuraal net is een methode om machinaal te leren door een computer trainingsvoorbeelden te laten analyseren. In dit geval werd het neurale netwerk getraind om de inhoud van hersengegevens te classificeren.

De resultaten voor de twee menselijke proefpersonen toonden aan dat het model dat is ontwikkeld met behulp van het neurale net 99% nauwkeurigheid vertoonde bij het in kaart brengen van de hersengegevens op zowel de object- als actiegebaseerde classificaties.

In het geval van het decoderen van video-inhoud van de honden, werkte het model niet voor de objectclassificaties. Het was echter 75% tot 88% nauwkeurig bij het decoderen van de actieclassificaties voor de honden.

De resultaten suggereren grote verschillen in hoe de hersenen van mensen en honden werken.

"Wij mensen zijn erg objectgericht", zegt Berns. "Er zijn 10 keer zoveel zelfstandige naamwoorden als er werkwoorden zijn in de Engelse taal, omdat we een bepaalde obsessie hebben met het benoemen van objecten. Honden lijken minder bezig te zijn met wie of wat ze zien en meer met de actie zelf."

Honden en mensen hebben ook grote verschillen in hun visuele systemen, merkt Berns op. Honden zien alleen in de kleuren blauw en geel, maar hebben een iets hogere dichtheid van zichtreceptoren die zijn ontworpen om beweging te detecteren.

"Het is volkomen logisch dat de hersenen van honden in de eerste plaats zeer afgestemd zullen zijn op acties", zegt hij. "Dieren moeten erg bezorgd zijn over de dingen die in hun omgeving gebeuren om te voorkomen dat ze worden opgegeten of om dieren in de gaten te houden waarop ze misschien willen jagen. Actie en beweging zijn van het grootste belang."

Voor Philips is het belangrijk om te begrijpen hoe verschillende dieren de wereld waarnemen voor haar huidige veldonderzoek naar de invloed van de herintroductie van roofdieren in Mozambique op ecosystemen. "Historisch gezien is er niet veel overlap in informatica en ecologie", zegt ze. "Maar machine learning is een groeiend veld dat bredere toepassingen begint te vinden, ook in de ecologie."

Andere auteurs van het artikel zijn onder meer Daniel Dilks, universitair hoofddocent psychologie bij Emory, en Kirsten Gillette, die aan het project werkte als een master neurowetenschappen en gedragsbiologie van Emory. Gilette is sindsdien afgestudeerd en volgt nu een postbaccalaureaatsprogramma aan de Universiteit van North Carolina.

Daisy is eigendom van Rebecca Beasley en Bhubo is eigendom van Ashwin Sakhardande. + Verder verkennen

Het dilemma van een hond:geven hoektanden de voorkeur aan lof of voedsel?

Een kaart van reacties helpt bij het controleren van moleculaire eigenschappen

Een kaart van reacties helpt bij het controleren van moleculaire eigenschappen LSU Chemical Engineering onthult nieuwe destillatiekolommen

LSU Chemical Engineering onthult nieuwe destillatiekolommen Hoe maak je een 1 procent BSA-oplossing

Hoe maak je een 1 procent BSA-oplossing Wetenschappers gaan diep om de eigenschappen van perovskiet te kwantificeren

Wetenschappers gaan diep om de eigenschappen van perovskiet te kwantificeren Microben die samenwerken vermenigvuldigen de conversiemogelijkheden van biomassa

Microben die samenwerken vermenigvuldigen de conversiemogelijkheden van biomassa

Hoofdlijnen

- Chimpansees die het huis verlaten stellen het ouderschap uit

- Het belang van diffusie in organismen

- Nieuwe heremietkreeft gebruikt levend koraal als thuis

- 2 kiwivogels zijn zeldzaam lichtpuntje in grimmig uitstervingsrapport

- Dolfijnengezondheidscontrole toont toestand van onze oceanen

- Een eetbare cel maken

- Hoe verlaat mRNA de kern?

- Netwerken gebruiken om weefselspecifieke genregulatie te begrijpen

- S-fase: wat gebeurt er tijdens deze subfase van de celcyclus?

- Suikerpoep kan worden gebruikt om destructieve plantenplagen naar hun ondergang te lokken

- De voordelen van anaërobe ademhaling

- Het gedrag van primaten veranderde toen dierentuinen gesloten waren wegens pandemie, suggereert onderzoek

- 3 Eigenschappen van een cel

- Hoe de hormonen van de hypofyse te onthouden

'S Werelds eerste kameleonsatelliet verlaat inheemse Britse kusten

'S Werelds eerste kameleonsatelliet verlaat inheemse Britse kusten De energiecrisis in Zuid-Afrika heeft geleid tot veel slechte ideeën voor het beheer van nutsvoorzieningen

De energiecrisis in Zuid-Afrika heeft geleid tot veel slechte ideeën voor het beheer van nutsvoorzieningen Probleem met nieuwe Amerikaanse weersatelliet kan van invloed zijn op foto's (update)

Probleem met nieuwe Amerikaanse weersatelliet kan van invloed zijn op foto's (update) Hoe te graven voor goud

Hoe te graven voor goud  Waarom zingen mensen onder de douche?

Waarom zingen mensen onder de douche?  Interessante feiten over woestijnplanten

Interessante feiten over woestijnplanten  Hoe sociale netwerken helpen de cyclus van segregatie in stand te houden

Hoe sociale netwerken helpen de cyclus van segregatie in stand te houden Colloïdale kwantumstippen van gelijke grootte maken

Colloïdale kwantumstippen van gelijke grootte maken

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com