Wetenschap

Hoe mensen nepnieuws op Twitter en Facebook onderzoeken - of juist niet doen

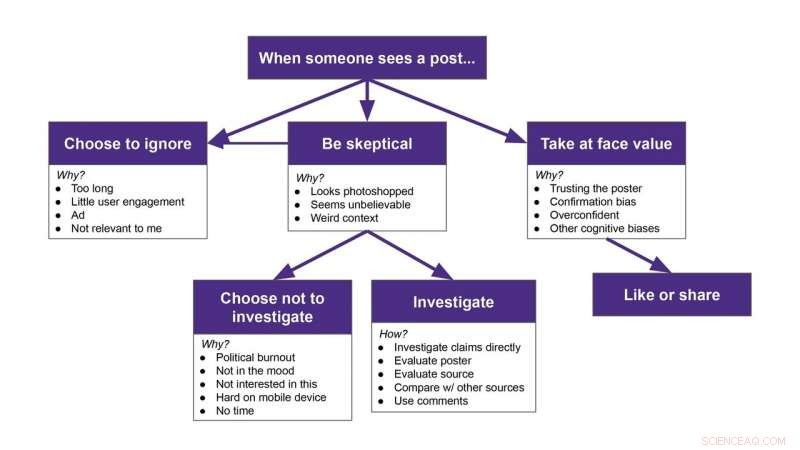

Deelnemers hadden verschillende reacties op het tegenkomen van een nepbericht:sommigen negeerden het regelrecht, sommigen namen het tegen de nominale waarde, sommigen onderzochten of het waar was, en sommigen waren er argwanend over, maar kozen er toen voor om het te negeren. Credit:Franziska Roesner/Universiteit van Washington

Sociale mediaplatforms, zoals Facebook en Twitter, mensen veel informatie geven, maar het wordt steeds moeilijker om te bepalen wat echt is en wat niet.

Onderzoekers van de Universiteit van Washington wilden weten hoe mensen mogelijk verdachte berichten op hun eigen feeds onderzochten. Het team zag 25 deelnemers door hun Facebook- of Twitter-feeds scrollen terwijl, buiten het medeweten van hen, een Google Chrome-extensie heeft willekeurig ontmaskerde inhoud toegevoegd bovenop enkele van de echte berichten. Deelnemers hadden verschillende reacties op het tegenkomen van een nepbericht:sommigen negeerden het regelrecht, sommigen namen het tegen de nominale waarde, sommigen onderzochten of het waar was, en sommigen waren er argwanend over, maar kozen er toen voor om het te negeren. Deze resultaten zijn geaccepteerd voor de 2020 ACM CHI-conferentie over Human Factors in Computing Systems.

"We wilden begrijpen wat mensen doen als ze nepnieuws of verkeerde informatie in hun feeds tegenkomen. Merken ze het op? Wat doen ze eraan?" zei senior auteur Franziska Roesner, een UW universitair hoofddocent aan de Paul G. Allen School of Computer Science &Engineering. "Er zijn veel mensen die goede consumenten van informatie proberen te zijn en ze hebben het daar moeilijk mee. Als we kunnen begrijpen wat deze mensen aan het doen zijn, we kunnen misschien tools ontwerpen die hen kunnen helpen."

Eerder onderzoek naar hoe mensen omgaan met verkeerde informatie, vroeg deelnemers om inhoud van een door een onderzoeker gemaakt account te bekijken, niet van iemand die ze kozen om te volgen.

"Dat kan mensen automatisch achterdochtig maken, " zei hoofdauteur Christine Geeneg, een UW-promovendus aan de Allen School. "We hebben ervoor gezorgd dat alle berichten eruitzagen alsof ze afkomstig waren van mensen die onze deelnemers volgden."

De onderzoekers rekruteerden deelnemers van 18 tot 74 jaar uit de hele omgeving van Seattle, uitleggend dat het team geïnteresseerd was in hoe mensen sociale media gebruiken. Deelnemers gebruikten minimaal één keer per week Twitter of Facebook en gebruikten de social media platforms vaak op een laptop.

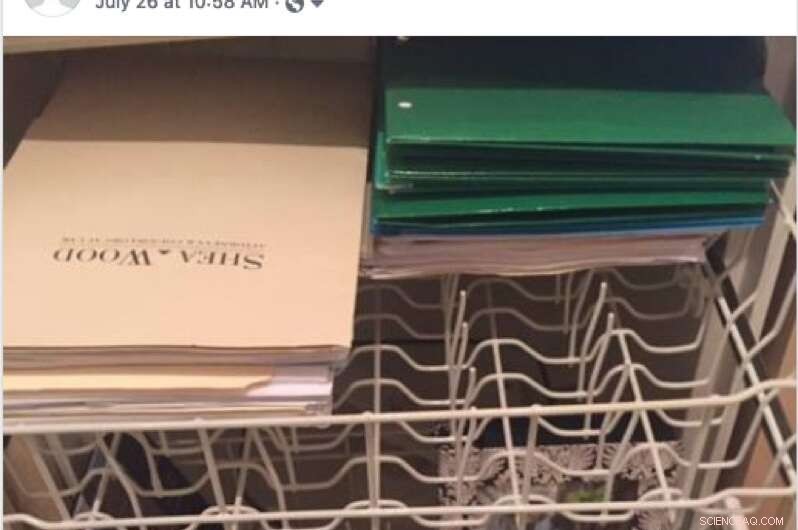

Een voorbeeld van een nepbericht dat een deelnemer tijdens het onderzoek op zijn Facebook-feed zou kunnen zien. Een deelnemer zei dat ze dit bericht hadden overgeslagen omdat ze het woord 'Florida' zagen en besloten dat het niet op hen van toepassing was. Credit:Geeng et al./2020 ACM CHI-conferentie over menselijke factoren in computersystemen

Vervolgens ontwikkelde het team een Chrome-extensie die willekeurig nepberichten of memes die door de feitencontrolewebsite Snopes.com waren ontkracht, zou toevoegen aan echte berichten, zodat het tijdelijk leek alsof ze werden gedeeld door mensen op de feeds van deelnemers. Dus in plaats van de post van een neef te zien over een recente vakantie, een deelnemer zou in plaats daarvan zien dat hun neef een van de nepverhalen deelt.

De onderzoekers installeerden de extensie op de laptop van de deelnemer of de deelnemer logde in op hun account op de laptop van de onderzoeker, waarvoor de extensie was ingeschakeld. Het team vertelde de deelnemers dat de extensie hun feeds zou wijzigen - de onderzoekers zeiden niet hoe - en hun likes en shares tijdens het onderzoek zou volgen, hoewel, in feite, het volgde niets. De extensie werd aan het einde van het onderzoek van de laptops van de deelnemers verwijderd.

"We zouden ze door hun feeds laten scrollen met de extensie actief, " zei Geeng. "Ik zei tegen hen dat ze hardop moesten nadenken over wat ze aan het doen waren of wat ze zouden doen als ze in een situatie zouden verkeren zonder mij in de kamer. Dus dan zouden mensen praten over 'Oh ja, Ik zou dit artikel lezen, ' of 'Ik zou dit overslaan.' Soms stelde ik vragen als:'Waarom sla je dit over? Waarom zou je dat willen?'"

Deelnemers konden de nepberichten niet leuk vinden of delen. Op Twitter, een "retweet" zou de echte inhoud onder het nepbericht delen. De ene keer dat een deelnemer inhoud retweet onder de neppost, de onderzoekers hielpen hen om het ongedaan te maken nadat het onderzoek was afgelopen. Op Facebook, de like- en share-knoppen werkten helemaal niet.

Nadat de deelnemers alle nepberichten tegenkwamen - negen voor Facebook en zeven voor Twitter - stopten de onderzoekers het onderzoek en legden uit wat er aan de hand was.

"Het was niet zoals we zeiden, 'Hallo, er stonden een paar nepberichten in.' We zeiden, 'Het is moeilijk om verkeerde informatie te herkennen. Hier waren alle nepberichten die je net zag. Deze waren nep, en je vrienden hebben ze niet echt gepost, '" Zei Geeng. "Ons doel was niet om deelnemers te misleiden of hen het gevoel te geven blootgesteld te worden. We wilden de moeilijkheid om te bepalen wat nep is en wat niet, normaliseren."

Een voorbeeld van een nepbericht dat een deelnemer tijdens het onderzoek op zijn Facebook-feed zou kunnen zien. Credit:Geeng et al./2020 ACM CHI-conferentie over menselijke factoren in computersystemen

De onderzoekers sloten het interview af door de deelnemers te vragen welke soorten strategieën ze gebruiken om verkeerde informatie op te sporen.

In het algemeen, de onderzoekers ontdekten dat deelnemers veel berichten negeerden, vooral degenen die ze te lang vonden, overly political or not relevant to them.

But certain types of posts made participants skeptical. Bijvoorbeeld, people noticed when a post didn't match someone's usual content. Sometimes participants investigated suspicious posts—by looking at who posted it, evaluating the content's source or reading the comments below the post—and other times, people just scrolled past them.

"I am interested in the times that people are skeptical but then choose not to investigate. Do they still incorporate it into their worldviews somehow?" Roesner said. "At the time someone might say, 'That's an ad. I'm going to ignore it.' But then later do they remember something about the content, and forget that it was from an ad they skipped? That's something we're trying to study more now."

While this study was small, it does provide a framework for how people react to misinformation on social media, zei de ploeg. Now researchers can use this as a starting point to seek interventions to help people resist misinformation in their feeds.

"Participants had these strong models of what their feeds and the people in their social network were normally like. They noticed when it was weird. And that surprised me a little, " Roesner said. "It's easy to say we need to build these social media platforms so that people don't get confused by fake posts. But I think there are opportunities for designers to incorporate people and their understanding of their own networks to design better social media platforms."

Hoofdlijnen

- Diabetesmedicijn helpt bij het repareren van UV-beschadigd DNA in cellen van maankinderen

- De verschillen tussen mannelijke pollen en vrouwelijke zaden dennenappels

- Gebruik van recombinant DNA in Agriculture

- High School Biology Topics

- Nieuwe technologie maakt detectie van eikenverwelking sneller, betaalbaarder

- Een RNA TREAT voor Halloween

- Houden mannelijke vissen ze liever groot en kleurrijk?

- Hoe uw dieet het dierenwelzijn kan verbeteren

- Diepe wortels in planten aangedreven door bodemhydrologie

- Onderzoek toont de kracht aan van het heroriënteren van stress bij studenten in de overgang naar de middelbare school

- COVID-19 en heropening van scholen:dit is het moment om buitenonderwijs te omarmen

- Studie onderzoekt waarom volwassen kinderen de banden met ouders verbreken

- Studenten van de eerste generatie zijn sterk afhankelijk van media voor verwachtingen, studie toont

- Dumpen vliegtuigen routinematig hun brandstof voordat ze landen?

Vrouwen accepteren net zoveel kans als mannen om een loonkloof tussen mannen en vrouwen te accepteren als ze er baat bij hebben

Vrouwen accepteren net zoveel kans als mannen om een loonkloof tussen mannen en vrouwen te accepteren als ze er baat bij hebben Zware stikstofmoleculen onthullen touwtrekken op planetaire schaal

Zware stikstofmoleculen onthullen touwtrekken op planetaire schaal Een nieuwe niet-fullereenacceptor voor binnentoepassingen voor zonne-energie

Een nieuwe niet-fullereenacceptor voor binnentoepassingen voor zonne-energie Onderzoeker onderzoekt leergewoonten van skateboarders

Onderzoeker onderzoekt leergewoonten van skateboarders Nieuwe methaanconcentratietechnologieën voor monitoring van broeikasgasemissies

Nieuwe methaanconcentratietechnologieën voor monitoring van broeikasgasemissies Antropologen beschrijven derde orang-oetansoort

Antropologen beschrijven derde orang-oetansoort Dit bosbrandseizoen in de VS is een van de ergste:hier is waarom:

Dit bosbrandseizoen in de VS is een van de ergste:hier is waarom: Populaire maaltijdpakkettenbedrijven creëren mogelijk lage lonen, doodlopende banen, studie vondsten

Populaire maaltijdpakkettenbedrijven creëren mogelijk lage lonen, doodlopende banen, studie vondsten

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com