Wetenschap

Onderzoekers creëren grootste, langste multiphysics aardbevingssimulatie tot nu toe

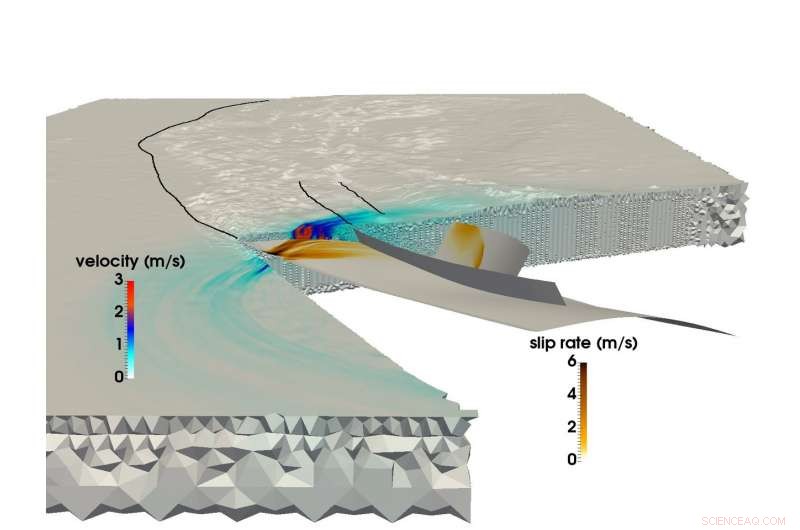

Met behulp van de SuperMUC-supercomputer van LRZ, een gezamenlijk onderzoeksteam van de Technische Universiteit van München en Ludwigs-Maximilians-Uni München waren in staat om de grootste multifysische simulatie van een aardbeving en tsunami te creëren. Deze afbeelding toont de voortplanting van breuken en het resulterende seismische golfveld tijdens de aardbeving in Sumatra en Andaman in 2004. Krediet:C. Uphoff, S.Rettenberger, M. Bader, Technische Universiteit van München. E. Madden, T. Ulrich, S. Wolherr, A. Gabriël, Ludwigs-Maximilians-Universität.

Even voor 8.00 uur lokale tijd op 26 december 2004, mensen in Zuidoost-Azië begonnen hun dagen toen de derde sterkste geregistreerde aardbeving in de geschiedenis een 1 scheurde Scheur van 500 kilometer in de oceaanbodem voor de kust van het Indonesische eiland Sumatra.

De aardbeving duurde tussen de 8 en 10 minuten (een van de langste ooit gemeten), en tilde de oceaanbodem enkele meters op, het creëren van een tsunami met golven van 30 meter die hele gemeenschappen verwoestten. De gebeurtenis veroorzaakte bijna 200, 000 doden in 15 landen, en boven en onder de grond evenveel energie vrijgemaakt als meerdere eeuwen energieverbruik in de VS.

De aardbeving in Sumatra-Andaman, zoals dat heet, was even verrassend als gewelddadig. Ondanks de grote vooruitgang in aardbevingsmonitoring- en waarschuwingssystemen in de afgelopen 50 jaar, aardwetenschappers konden het niet voorspellen omdat er relatief weinig gegevens zijn over dergelijke grootschalige seismologische gebeurtenissen. Onderzoekers hebben een schat aan informatie over semi-reguliere, aardbevingen van lage tot gemiddelde sterkte, maar rampen zoals de Sumatra-Andaman - gebeurtenissen die slechts om de paar honderd jaar plaatsvinden - zijn te zeldzaam om betrouwbare datasets te creëren.

Om deze gebeurtenissen beter te begrijpen, en hopelijk betere voorspellings- en mitigatiemethoden bieden, een team van onderzoekers van de Ludwig-Maximilians-Universität München (LMU) en de Technische Universiteit van München (TUM) gebruikt supercomputerbronnen in het Leibniz Supercomputing Center (LRZ) om deze zeldzame, uiterst gevaarlijke seismische verschijnselen.

"Onze algemene motivatie is om het hele proces beter te begrijpen waarom sommige aardbevingen en de daaruit voortvloeiende tsunami's zoveel groter zijn dan andere, " zei TUM-professor Dr. Michael Bader. "Soms zien we relatief kleine tsunami's als aardbevingen groot zijn, of verrassend grote tsunami's in verband met relatief kleine aardbevingen. Simulatie is een van de tools om inzicht te krijgen in deze gebeurtenissen."

Het team streeft naar "gekoppelde" simulaties van zowel aardbevingen als daaropvolgende tsunami's. Het heeft onlangs zijn grootste aardbevingssimulatie tot nu toe voltooid. Met behulp van de SuperMUC-supercomputer bij LRZ, het team was in staat om 1 te simuleren 500 kilometer niet-lineaire breukmechanica - de bron van de aardbeving - gekoppeld aan seismische golven die naar India en Thailand reizen gedurende iets meer dan 8 minuten van de aardbeving in Sumatra-Andaman. Door verschillende interne computationele innovaties, het team bereikte een 13-voudige verbetering in tijd tot oplossing. Als erkenning voor deze prestatie, het project werd genomineerd voor de beste papierprijs op SC17, een van 's werelds belangrijkste supercomputingconferenties, gehouden dit jaar op 12-17 november in Denver, Colorado.

Megathrust aardbevingen, grootschalige simulaties

Aardbevingen gebeuren als gesteente onder het aardoppervlak plotseling breekt, vaak als gevolg van de langzame beweging van tektonische platen.

Een ruwe voorspeller van het vermogen van een aardbeving in de oceaan om een grote tsunami te ontketenen, is of platen tegen elkaar schuren of frontaal botsen. Als twee of meer platen botsen, de ene plaat zal vaak de andere eronder dwingen. Regio's waar dit proces plaatsvindt, worden subductiezones genoemd en kunnen zeer grote, ondiep dalende fouten - zogenaamde "megathrusts". Het vrijkomen van energie over zulke enorme zwaktezones heeft de neiging om gewelddadige tsunami's te creëren, naarmate de oceaanbodem aanzienlijk stijgt, tijdelijk grote hoeveelheden water verdringen.

Tot voor kort, Hoewel, onderzoekers die computationele geofysica deden, hadden grote problemen om subductie-aardbevingen op het noodzakelijke niveau van detail en nauwkeurigheid te simuleren. Grootschalige aardbevingssimulaties zijn over het algemeen moeilijk, maar subductiegebeurtenissen zijn nog complexer.

"Het modelleren van aardbevingen is een multischaalprobleem in zowel ruimte als tijd, " zei Dr. Alice Gabriel, de hoofdonderzoeker van de LMU-kant van het team. "De werkelijkheid is complex, wat betekent dat het opnemen van de waargenomen complexiteit van aardbevingsbronnen altijd het gebruik van numerieke methoden inhoudt, zeer efficiënte simulatiesoftware, en, natuurlijk, high-performance computing (HPC). Alleen door gebruik te maken van HPC kunnen we modellen maken die zowel de dynamische spanningsafgifte als breuken die optreden bij een aardbeving kunnen oplossen en tegelijkertijd de verplaatsing van de zeebodem over duizenden kilometers kunnen simuleren."

Wanneer onderzoekers een aardbeving simuleren, ze gebruiken een rekenraster om de simulatie in vele kleine stukjes te verdelen. Vervolgens berekenen ze specifieke vergelijkingen voor verschillende aspecten van de simulatie, zoals gegenereerd seismisch schudden of verplaatsing van de oceaanbodem, onder andere, over "tijdstappen, " of simulatiesnapshots in de loop van de tijd die het in beweging helpen zetten, net als een flipboek.

Hoe fijner het raster, hoe nauwkeuriger de simulatie, maar hoe meer rekenkracht het wordt. In aanvulling, hoe complexer de geometrie van de aardbeving, hoe complexer het raster wordt, de berekening nog ingewikkelder maken. Om subductie-aardbevingen te simuleren, computationele wetenschappers moeten een groot raster maken dat ook nauwkeurig de zeer ondiepe hoeken kan weergeven waaronder de twee continentale platen elkaar ontmoeten. Dit vereist dat de rastercellen rond het subductiegebied extra klein zijn, en vaak slank van vorm.

In tegenstelling tot continentale aardbevingen, die beter zijn gedocumenteerd door berekening en observatie, subductiegebeurtenissen gebeuren vaak diep in de oceaan, wat betekent dat het veel moeilijker is om een simulatie te beperken door grondschuddende waarnemingen en gedetailleerde, betrouwbare gegevens van directe observatie en laboratoriumexperimenten.

Verder, het berekenen van een gekoppelde, grootschalige aardbeving-tsunami-simulatie vereist het gebruik van gegevens uit een breed scala aan bronnen. Onderzoekers moeten rekening houden met de vorm van de zeebodem, de vorm en sterkte van de plaatgrens die door de aardbeving is verbroken en het materiaalgedrag van de aardkorst op elk niveau, onder andere aspecten. Het team heeft de afgelopen jaren methoden ontwikkeld om deze ongelijksoortige gegevensbronnen efficiënter te integreren in een consistent model.

Om de enorme rekentijd te verminderen, het team maakte gebruik van een methode genaamd 'local time stepping'. In gebieden waar de simulaties veel meer ruimtelijk detail vereisen, onderzoekers moeten de simulatie ook "vertragen" door meer tijdstappen in deze gebieden uit te voeren. Andere secties die minder details vereisen, kunnen veel grotere en dus veel minder tijdstappen uitvoeren.

Als het team zijn hele simulatie met een uniforme kleine tijdstap zou moeten uitvoeren, het zou ongeveer 3 miljoen individuele iteraties hebben vereist. Echter, slechts enkele cellen van het rekenraster hadden deze tijdstapgrootte nodig. Grote delen kunnen worden berekend met veel grotere tijdstappen, sommige vereisen slechts 3000 tijdstappen. Dit verminderde de computationele vraag aanzienlijk en leidde tot een groot deel van de 13-voudige versnelling van het team. Deze vooruitgang leidde er ook toe dat de simulatie van het team de grootste, langste eerste-principe simulatie van een aardbeving van dit type.

Voorwaartse beweging

Door de nauwe samenwerking met de medewerkers van LRZ, het team had de mogelijkheid om de hele SuperMUC-machine te gebruiken voor zijn simulaties. Bader gaf aan dat deze extreem grootschalige runs van onschatbare waarde zijn voor het team om dieper inzicht te krijgen in zijn onderzoek. "Er is een groot verschil of je op een kwart van een machine draait of op een volle machine, aangezien die laatste factor 4 vaak de kritische knelpunten aan het licht brengt, " hij zei.

Het vermogen van het team om ten volle te profiteren van de huidige generatie supercomputerbronnen, maakt het enthousiast voor de toekomst. Het is niet per se belangrijk dat machines van de volgende generatie de LMU-TUM-onderzoekers de mogelijkheid bieden om "grotere" simulaties uit te voeren - huidige simulaties kunnen effectief een geografisch gebied simuleren dat groot genoeg is. Liever, het team is enthousiast over de mogelijkheid om de invoergegevens te wijzigen en nog veel meer iteraties uit te voeren gedurende een bepaalde hoeveelheid rekentijd.

"We hebben één individuele simulatie gedaan, proberen de startconfiguratie nauwkeurig te raden, zoals de initiële spanningen en krachten, maar al deze zijn nog onzeker, "Zei Bader. "Dus we willen onze simulatie uitvoeren met veel verschillende instellingen om te zien hoe kleine veranderingen in het foutsysteem of andere factoren het onderzoek zouden beïnvloeden. Dit zouden grotere parameterstudies zijn, dat is een andere prestatielaag die een computer zou moeten bieden."

Gabriel zei ook dat machines van de volgende generatie hopelijk urgente, realtime scenario's die kunnen helpen bij het voorspellen van gevaren, aangezien deze verband houden met waarschijnlijke naschokregio's. Het team is verheugd om de volgende generatie architecturen te zien bij LRZ en de andere Gauss Center for Supercomputing-centra, het High-Performance Computing Center Stuttgart en het Jülich Supercomputing Center.

Volgens Bader het recente werk van het team vertegenwoordigt niet alleen de grootste simulatie tot nu toe, maar ook de steeds sterkere samenwerking tussen de domeinwetenschappers en computationele wetenschappers in de groep. "Dit papier heeft een sterke seismologische component en een sterke HPC-component, " zei hij. "Dit is echt een 50-50 papier voor ons. Onze samenwerking verloopt goed, en het is omdat het niet gaat om het onze of het hunne krijgen. Beide groepen profiteren, en dit is echt mooi gezamenlijk werk."

Organische elektronica:een nieuwe halfgeleider in de koolstofnitride-familie

Organische elektronica:een nieuwe halfgeleider in de koolstofnitride-familie 3D-beeldvormingsonderzoek onthult hoe atomen zijn verpakt in amorfe materialen

3D-beeldvormingsonderzoek onthult hoe atomen zijn verpakt in amorfe materialen Metalen nanokatalysatoren imiteren de structuur van enzymen

Metalen nanokatalysatoren imiteren de structuur van enzymen Onderzoekers creëren ultralicht keramisch materiaal dat bestand is tegen extreme temperaturen

Onderzoekers creëren ultralicht keramisch materiaal dat bestand is tegen extreme temperaturen Onderzoekers beeld atomaire structuur van belangrijke immuunregulator af

Onderzoekers beeld atomaire structuur van belangrijke immuunregulator af

Westerse rivieren krijgen te maken met knijpen als een ander droog jaar vorm krijgt

Westerse rivieren krijgen te maken met knijpen als een ander droog jaar vorm krijgt NASA-NOAA-satellieten kijken 's nachts naar tropische storm Kiko

NASA-NOAA-satellieten kijken 's nachts naar tropische storm Kiko Hoe inkomen en houding de uitstoot van broeikasgassen beïnvloeden

Hoe inkomen en houding de uitstoot van broeikasgassen beïnvloeden Bosbranden woeden na warmste zomer in Australië ooit

Bosbranden woeden na warmste zomer in Australië ooit Reproductie van planten en dieren

Reproductie van planten en dieren

Hoofdlijnen

- Hoe zangvogels een nieuw lied leren

- Rapport benadrukt kansen en risico's in verband met synthetische biologie en bio-engineering

- Hoe vrije radicalen uw lichaam beïnvloeden

- Bloedbad vreest race om zeldzame Australische papegaai te redden

- Wat zijn de zes menselijke zintuigen?

- Welke sequenties zorgen ervoor dat DNA uitpakt en ademt?

- Wanneer is de beste tijd van de dag om een beslissing te nemen?

- Zelfvernietiging van muggen

- Dieren in overvloed, ruimte voor een premie in de oudste dierentuin van Afrika

- Uitdaging en verlangen in Antarctische meteorologie en klimaat

- New Jersey keurt gasleiding door beschermd Pinelands goed

- Antropoceen:waarom de stoel het symbool zou moeten zijn voor onze zittende tijd

- Neerslag wordt steeds variabeler naarmate het klimaat warmer wordt

- NASA vindt de sterkste stormen van Harvey

Vrouwen hebben de neiging om meer geavanceerde politieke campagnes te voeren

Vrouwen hebben de neiging om meer geavanceerde politieke campagnes te voeren Oud DNA werpt licht op de bevolking van de Marianen

Oud DNA werpt licht op de bevolking van de Marianen Bugs op het menu zetten, veilig

Bugs op het menu zetten, veilig Hersenachtige computerchips kunnen privacyproblemen en broeikasgasemissies aanpakken

Hersenachtige computerchips kunnen privacyproblemen en broeikasgasemissies aanpakken Klimaatwetenschapper ziet decor voor herhaling van ergste droogte hongersnood

Klimaatwetenschapper ziet decor voor herhaling van ergste droogte hongersnood Veel planetenstelsels verdampen voortijdig in de lucht

Veel planetenstelsels verdampen voortijdig in de lucht Latex specificaties en eigenschappen

Latex specificaties en eigenschappen  Virus-nabootsende nanodeeltjes kunnen langdurige immuniteit stimuleren

Virus-nabootsende nanodeeltjes kunnen langdurige immuniteit stimuleren

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Portuguese | Swedish | German | Dutch | Danish | Norway | Spanish |

-

Wetenschap © https://nl.scienceaq.com