Wetenschap

Genereren van cross-modale sensorische data voor robotische visueel-tactiele perceptie

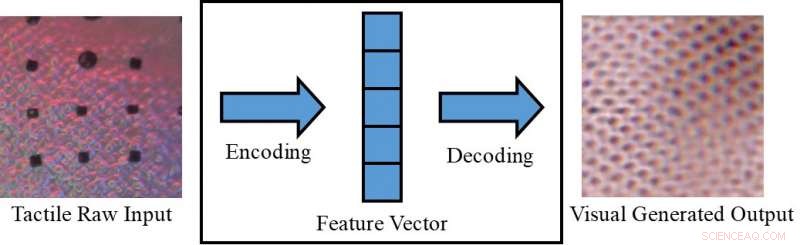

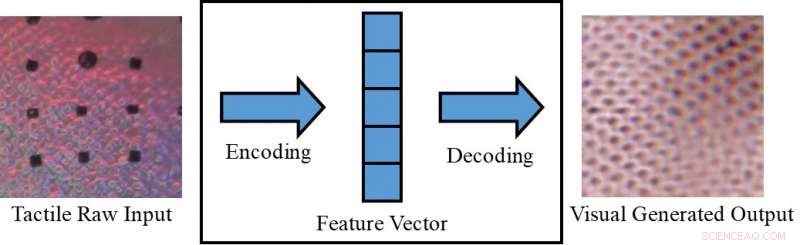

Conversie van een tactiele afbeelding naar een visuele afbeelding. Krediet:Lee, Bollegala &Luo.

Een object alleen visueel waarnemen (bijvoorbeeld op een scherm) of alleen door het aan te raken, kunnen soms beperken wat we erover kunnen afleiden. Mensen, echter, hebben het aangeboren vermogen om visuele en tactiele stimuli te integreren, gebruik te maken van alle sensorische gegevens die beschikbaar zijn om hun dagelijkse taken uit te voeren.

Onderzoekers van de Universiteit van Liverpool hebben onlangs een nieuw raamwerk voorgesteld om cross-modale sensorische gegevens te genereren, die zou kunnen helpen om zowel visuele als tactiele informatie te repliceren in situaties waarin een van de twee niet direct toegankelijk is. Hun kader zou, bijvoorbeeld, mensen in staat stellen objecten op een scherm (bijvoorbeeld kledingstukken op e-commercesites) zowel visueel als tactisch waar te nemen.

"In onze dagelijkse ervaring, we kunnen cognitief een visualisatie van een object creëren op basis van een tactiele respons, of een tactiele reactie bij het bekijken van de textuur van een oppervlak, "Dr. Shan Luo, een van de onderzoekers die het onderzoek heeft uitgevoerd, vertelde TechXplore. "Dit perceptuele fenomeen, synesthesie genoemd, waarbij de stimulatie van een zintuig een onwillekeurige reactie veroorzaakt in een of meer van de andere zintuigen, kan worden gebruikt om een ontoegankelijke zin te verzinnen. Bijvoorbeeld, wanneer men een object grijpt, ons zicht wordt belemmerd door de hand, maar er wordt een aanrakingsreactie gegenereerd om de bijbehorende functies te 'zien'."

Het door Dr. Luo beschreven perceptuele fenomeen treedt meestal op wanneer een waarnemingsbron niet beschikbaar is (bijv. wanneer u voorwerpen in een tas aanraakt zonder ze te kunnen zien). In dergelijke situaties, mensen kunnen "aanraken om te zien" of "zien om te voelen, " het interpreteren van kenmerken die verband houden met een bepaald zintuig op basis van informatie die is verzameld met behulp van hun andere zintuigen. Indien gerepliceerd in machines, dit visueel-tactiele mechanisme zou verschillende interessante toepassingen kunnen hebben, met name op het gebied van robotica en e-commerce.

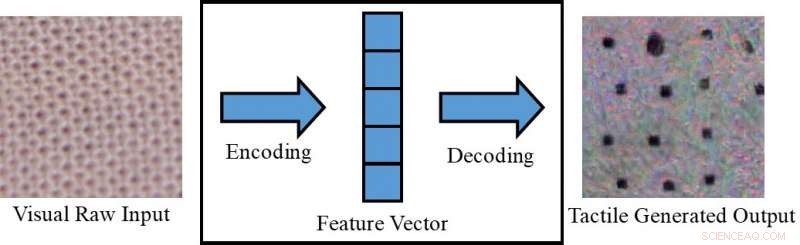

Conversie van een visueel beeld naar een tactiele afbeelding. Krediet:Lee, Bollegala &Luo.

Als robots visuele en tactiele waarneming zouden kunnen integreren, ze zouden hun grijp- en manipulatiestrategieën effectiever kunnen plannen op basis van de visuele kenmerken van de objecten waarmee ze werken (bijv. maat, enzovoort.). Met andere woorden, robots zouden de algemene tactiele eigenschappen van objecten waarnemen voordat ze ze vastgrepen, met behulp van visuele informatie verzameld door camera's. Terwijl u een object buiten het gezichtsveld van de camera vastpakt, anderzijds, ze zouden tactiele reacties gebruiken om het gebrek aan beschikbare visuele informatie te compenseren.

Indien gekoppeld met een tactiel apparaat, die nog niet is ontwikkeld, het door Dr. Luo en zijn collega's voorgestelde raamwerk kan ook worden gebruikt in e-commerce, bijvoorbeeld, waardoor klanten de stof van kleding kunnen voelen voordat ze ze kopen. Met deze toepassing in gedachten, de onderzoekers gebruikten conditionele generatieve vijandige netwerken om pseudo-visuele beelden te genereren met behulp van tactiele gegevens en vice versa (d.w.z. om tactiele outputs te genereren met behulp van visuele gegevens).

"Op online marktplaatsen, klanten winkelen door foto's van kleding of andere items te bekijken, "Zei Dr. Luo. "Echter, ze kunnen deze items niet aanraken om hun materialen te voelen. Een item voelen is heel belangrijk tijdens het winkelen, vooral bij het kopen van delicate items, zoals ondergoed. Gebruikers in staat stellen om items thuis te voelen, met behulp van een tactiel apparaat dat nog moet worden ontwikkeld, het cross-modale schema voor het genereren van sensorische gegevens dat in onze paper wordt voorgesteld, kan e-commerceklanten helpen beter geïnformeerde keuzes te maken."

Dr. Luo en zijn collega's evalueerden hun model op de VITac-dataset, die macrobeelden en tactiele metingen bevat (vastgelegd met een GelSight-sensor) van 100 verschillende soorten stof. Ze ontdekten dat het sensorische outputs voor één zintuig (d.w.z. zicht of aanraking) effectief kon voorspellen met behulp van gegevens die relevant zijn voor het andere.

GelSight-sensor. Krediet:Lee, Bollegala &Luo.

"We nemen textuurperceptie als voorbeeld:visuele invoerbeelden van een doektextuur worden gebruikt om een pseudo-tactiele lezing van hetzelfde stuk doek te genereren; omgekeerd, tactiele metingen van een doek worden gebruikt om een visueel beeld van hetzelfde doek te voorspellen, " legde Dr. Luo uit. "De texturen van stoffen, d.w.z., de garendistributiepatronen, verschijnen op dezelfde manier in een visueel beeld en een drukverdeling (d.w.z. tactiele) lezing. Echter, dit werk kan ook worden uitgebreid om cross-modale visueel-tactiele gegevensgeneratie te bereiken voor de perceptie van andere objecteigenschappen, door rekening te houden met de verschillen tussen de twee domeinen."

De studie uitgevoerd door Dr. Luo en zijn collega's behaalde opmerkelijke resultaten bij het genereren van realistische tactiele en visuele patronen voor verschillende stoffen in afwezigheid van tactiele of visuele informatie, overeenkomstig. Met behulp van hun kader, de onderzoekers 'repliceerden' met succes tactiele elementen van stoffen met behulp van visuele gegevens, en vice versa.

"Voor zover wij weten, dit werk is de eerste poging om robotische cross-modale visueel-tactiele gegevensgeneratie te bereiken, die ook kan worden uitgebreid tot cross-modale gegevensgeneratie voor andere modaliteiten, "Zei Dr. Luo. "De praktische implicaties van onze studie zijn dat we andere zintuigen kunnen gebruiken om een ontoegankelijke zin te verzinnen."

In de toekomst, het door Dr. Luo en zijn collega's voorgestelde raamwerk zou kunnen worden gebruikt om grijp- en manipulatiestrategieën in robots te verbeteren, evenals om online winkelervaringen te verbeteren. Hun methode zou ook kunnen worden gebruikt om datasets uit te breiden voor classificatietaken, door zintuiglijke gegevens te genereren die anders ontoegankelijk zouden zijn.

Krediet:Lee, Bollegala &Luo.

"Bij toekomstig onderzoek we zullen proberen onze methode toe te passen op een aantal verschillende taken, zoals visuele en tactiele classificatie in een echte wereldomgeving, met objecten die qua uiterlijk verschillen (bijv. vorm, kleur enz.), " zei Dr. Luo. Bovendien, de voorgestelde visueel-tactiele methode voor het genereren van gegevens zal worden gebruikt om robottaken te vergemakkelijken, zoals grijpen en manipuleren."

Het artikel waarin deze recente studie wordt geschetst, voorgepubliceerd op arXiv, zal worden gepresenteerd op de 2019 International Conference on Robotics and Automation (ICRA), die zal plaatsvinden in Montreal, Canada, tussen 20 en 24 mei. Bij de conferentie, Dr. Luo zal ook een workshop geven over het onderwerp van zijn studie, genaamd "ViTac:Integratie van visie en aanraking voor multimodale en cross-modale perceptie."

© 2019 Wetenschap X Netwerk

Eigenschappen en gebruik van koolstofstaal

Eigenschappen en gebruik van koolstofstaal Polymeren met verschillende lengtes kweken

Polymeren met verschillende lengtes kweken Actief leren versnelt het ontdekken van redox-flow-batterijen

Actief leren versnelt het ontdekken van redox-flow-batterijen Onderzoekers creëren smartphonesysteem om te testen op lood in water

Onderzoekers creëren smartphonesysteem om te testen op lood in water efficiënt, stabiele thermo-elektrische module op basis van hoogwaardige vloeistofachtige materialen

efficiënt, stabiele thermo-elektrische module op basis van hoogwaardige vloeistofachtige materialen

Gefossiliseerde boom en ijskernen helpen bij het dateren van enorme vulkaanuitbarsting 1, 000 jaar geleden tot binnen drie maanden

Gefossiliseerde boom en ijskernen helpen bij het dateren van enorme vulkaanuitbarsting 1, 000 jaar geleden tot binnen drie maanden Sterke aardbeving treft afgelegen berggebied in India

Sterke aardbeving treft afgelegen berggebied in India Definitie van een bewaarde fossiel

Definitie van een bewaarde fossiel De natuur biedt mensen meer dan materiële voordelen

De natuur biedt mensen meer dan materiële voordelen Het prehistorische verleden verbinden met de wereldwijde toekomst

Het prehistorische verleden verbinden met de wereldwijde toekomst

Hoofdlijnen

- Verschillen tussen codering en sjabloondraden

- Factoren die het succes van translocaties van grizzlyberen beïnvloeden

- Wetenschappers pleiten voor verbeterde technologieën om bedreigde Californische zalm te redden

- Wat zijn de verschillen tussen een plant en een dierlijke cel onder een microscoop?

- Slangenmans gifgewoonte houdt hoop op nieuw tegengif

- Wat is een extra ring van DNA in bacteriën?

- Het verschil tussen een sporofyt en gametofyt

- Monitoring van microben om marsonauten gezond te houden

- Wereldwijd belang van honingbijen voor natuurlijke habitats vastgelegd in nieuw rapport

Wat zijn de soorten rotsen in de Appalachen?

Wat zijn de soorten rotsen in de Appalachen?  De selectie van leiders van politieke partijen door middel van voorverkiezingen benadeelt vrouwen

De selectie van leiders van politieke partijen door middel van voorverkiezingen benadeelt vrouwen Moleculaire dynamische simulaties onthullen mechanismen waardoor metalen nanodraden vervormen of breken onder spanning

Moleculaire dynamische simulaties onthullen mechanismen waardoor metalen nanodraden vervormen of breken onder spanning Een systeem puur voor het ontwikkelen van hoogwaardige, big data-codes

Een systeem puur voor het ontwikkelen van hoogwaardige, big data-codes Geschiedenis van de slinger

Geschiedenis van de slinger  Condoommechanica van grafeen

Condoommechanica van grafeen Onderzoekers willen Colombiaanse gemeenschappen helpen die zijn getroffen door illegale goudwinning

Onderzoekers willen Colombiaanse gemeenschappen helpen die zijn getroffen door illegale goudwinning Wolkenkrabbers van de toekomst kunnen van hout worden gemaakt

Wolkenkrabbers van de toekomst kunnen van hout worden gemaakt

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com