Wetenschap

Visuele weergave van vormen op 2D-weergaveapparaten aan de hand van handgebaren

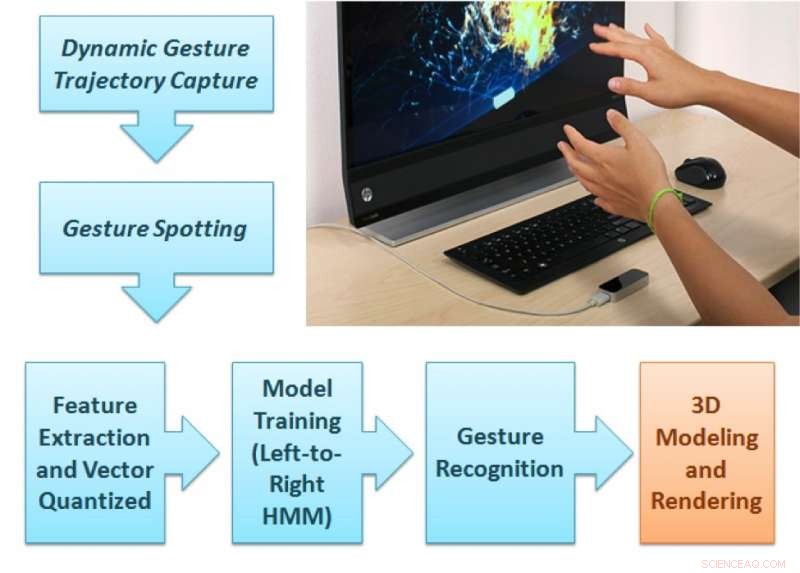

Het voorgestelde raamwerk voor gebarenanalyse. Krediet:Singla, Roy, en Dogra.

Onderzoekers van NIT Kurukshetra, IIT Roorkee en IIT Bhubaneswar hebben een nieuwe op Leap Motion-controller gebaseerde methode ontwikkeld die de weergave van 2D- en 3D-vormen op weergaveapparaten zou kunnen verbeteren. Deze nieuwe methode, geschetst in een paper dat vooraf is gepubliceerd op arXiv, volgt vingerbewegingen terwijl gebruikers natuurlijke gebaren maken binnen het gezichtsveld van een sensor.

In recente jaren, onderzoekers hebben geprobeerd om innovatieve, touchless gebruikersinterfaces. Dergelijke interfaces kunnen gebruikers in staat stellen om te communiceren met elektronische apparaten, zelfs als hun handen vuil of niet-geleidend zijn, terwijl ook mensen met een gedeeltelijke lichamelijke handicap worden geholpen. Studies naar deze mogelijkheden zijn verbeterd door de opkomst van goedkope sensoren, zoals die worden gebruikt door Leap Motion, Kinect- en RealSense-apparaten.

"We wilden een technologie ontwikkelen die een boeiende leerervaring kan bieden aan studenten die kleikunst leren of zelfs kinderen die basisalfabet leren, "Dr. Debi Prosad Dogra, vertelde een van de onderzoekers die het onderzoek uitvoerden aan TechXplore. "Inzicht in het feit dat kinderen beter leren van visuele prikkels, we hebben een bekend apparaat voor het vastleggen van handbewegingen gebruikt om deze ervaring te bieden. We wilden een raamwerk ontwerpen dat de gebaren van de leraar kan identificeren en de beelden op het scherm kan weergeven. De opstelling kan worden gebruikt voor toepassingen die handgebaren-geleide visuele weergave vereisen."

Het door Dr. Dogra en zijn collega's voorgestelde raamwerk bestaat uit twee verschillende delen. In het eerste deel, de gebruiker maakt een natuurlijk gebaar uit de 36 soorten gebaren die beschikbaar zijn binnen het gezichtsveld van het Leap Motion-apparaat.

"De twee IR-camera's in de sensor kunnen de bewegingsreeks opnemen, "Zei Dr. Dogra. "De voorgestelde machine learning-module kan de klasse van gebaren voorspellen en een weergave-eenheid geeft de overeenkomstige vorm op het scherm weer."

De handtrajecten van de gebruiker worden geanalyseerd om uitgebreide Npen++-functies in 3D te extraheren. Deze kenmerken, vertegenwoordigen de vingerbewegingen van de gebruiker tijdens de gebaren, worden toegevoerd aan een unidirectioneel van links naar rechts verborgen Markov-model (HMM) voor training. Het systeem voert vervolgens een één-op-één mapping uit tussen gebaren en vormen. Eindelijk, de vormen die overeenkomen met deze gebaren worden weergegeven op het scherm met behulp van de MuPad-interface.

"Vanuit het perspectief van een ontwikkelaar, het voorgestelde raamwerk is een typisch open raamwerk, " Dr. Dogra legde uit. "Om meer gebaren toe te voegen, een ontwikkelaar hoeft alleen maar gegevens over gebarenreeksen te verzamelen van een aantal vrijwilligers en het machine learning-model (ML) opnieuw te trainen voor nieuwe klassen. Dit ML-model kan een algemene representatie leren."

Als onderdeel van hun studie hebben de onderzoekers creëerden een dataset van 5400 monsters opgenomen door 10 vrijwilligers. Hun dataset bevat 18 geometrische en 18 niet-geometrische vormen, inclusief cirkel, rechthoek, bloem, ijshoorntje, gebied, en nog veel meer.

"Functieselectie is een van de essentiële onderdelen voor een typische machine learning-toepassing, "Zei Dr. Dogra. "In ons werk, we hebben de bestaande 2-D Npen++-functies in 3D uitgebreid. Het is aangetoond dat uitgebreide functies de prestaties aanzienlijk verbeteren. De 3D Npen++-functies kunnen ook worden gebruikt voor andere soorten signalen, zoals lichaamshoudingsdetectie, activiteitsherkenning, enzovoort."

Dr. Dogra en zijn collega's evalueerden hun methode met een vijfvoudige kruisvalidatie en ontdekten dat deze een nauwkeurigheid van 92,87 procent bereikte. Hun uitgebreide 3D-functies presteerden beter dan bestaande 3D-functies voor vormweergave en classificatie. In de toekomst, de door de onderzoekers bedachte methode zou kunnen helpen bij de ontwikkeling van nuttige mens-computerinteractietoepassingen (HCI) voor slimme weergaveapparaten.

"Onze benadering van gebarenherkenning is vrij algemeen, " Dr. Dogra toegevoegd. "We zien deze technologie als een hulpmiddel voor de communicatie van doven en gehandicapten. We willen nu het systeem gebruiken om de gebaren te begrijpen en ze om te zetten in geschreven formaat of vormen, om mensen te helpen in het dagelijkse leven gesprekken. Met de komst van geavanceerde machine learning-modellen zoals recurrente neurale netwerken (RNN) en lange korte termijn geheugen (LSTM), er zijn ook voldoende mogelijkheden in temporele signaalclassificatie."

© 2018 Wetenschap X Netwerk

Wetenschappers ontwikkelen metallo-enzym biosensor voor het monitoren van ethyleenniveaus in fruit

Wetenschappers ontwikkelen metallo-enzym biosensor voor het monitoren van ethyleenniveaus in fruit Dopaminereceptoren in hun oorspronkelijke habitat bekijken

Dopaminereceptoren in hun oorspronkelijke habitat bekijken Enzymbiofabrieken om navelstrengbloedtransplantaties te verbeteren

Enzymbiofabrieken om navelstrengbloedtransplantaties te verbeteren Wat is Inconel?

Wat is Inconel?  Kleine biologisch afbreekbare circuits voor het vrijgeven van pijnstillers in het lichaam

Kleine biologisch afbreekbare circuits voor het vrijgeven van pijnstillers in het lichaam

Verschil tussen een rode vos en een coyote

Verschil tussen een rode vos en een coyote  Grote instorting van de Groenlandse gletsjer 90 jaar geleden in verband met klimaatverandering

Grote instorting van de Groenlandse gletsjer 90 jaar geleden in verband met klimaatverandering Recente bosbranden in Australië verergerd door houtkap

Recente bosbranden in Australië verergerd door houtkap Kunnen koralen zich aanpassen aan klimaatverandering?

Kunnen koralen zich aanpassen aan klimaatverandering? Verdrinkingsangsten in het westen van de VS terwijl rivieren deinen met smeltende sneeuw

Verdrinkingsangsten in het westen van de VS terwijl rivieren deinen met smeltende sneeuw

Hoofdlijnen

- Geslachtschromosomen (Allosome): definitie, feiten en voorbeelden

- Buiktyfustoxine heeft een zoetekauw

- De verschillen in broederlijke en vaderlijke tweelingen

- Een garnalenverhaal - winnaars en verliezers in klimaatverandering

- Top 5 manieren om plezier te hebben in 2050

- Waarvoor gebruikt het lichaam nucleïnezuren?

- Herenbaarden dragen meer bacteriën dan hondenbont,

- Onderzoekers rapporteren tandeloze bevindingen in odontode-dragende meervalstudie

- Gespecialiseerde cellen in het lichaam

- Robot beheerst menselijke evenwichtsoefening

- Vietnamezen rollen op Transformers geïnspireerde robot uit met groene boodschap

- FTC, staten verhogen druk op Facebook op privacy (Update)

- Waarom spoorloze trams klaar zijn om lightrail te vervangen

- Nieuw milieudetectie- en monitoringsysteem getest en geëvalueerd

Zullen in 2070 echt drie miljard mensen leven in temperaturen die zo heet zijn als de Sahara?

Zullen in 2070 echt drie miljard mensen leven in temperaturen die zo heet zijn als de Sahara? Het publiekelijk te schande maken van pesters kan populair zijn, maar het brengt geen gerechtigheid

Het publiekelijk te schande maken van pesters kan populair zijn, maar het brengt geen gerechtigheid Nadat AT&T's hebben gewonnen, hier komt het verwachte Comcast-Fox-bod

Nadat AT&T's hebben gewonnen, hier komt het verwachte Comcast-Fox-bod Drie soorten oorzaken van opwarming van de aarde

Drie soorten oorzaken van opwarming van de aarde Toonaangevende duurzaamheidsexperts vragen om een efficiëntere aanpak om VN-doelen te halen

Toonaangevende duurzaamheidsexperts vragen om een efficiëntere aanpak om VN-doelen te halen Opruimen van vervuiling door mijnbouw in een rivier die op de Werelderfgoedlijst staat

Opruimen van vervuiling door mijnbouw in een rivier die op de Werelderfgoedlijst staat Kaas, koeien en mest - systeembenadering maakt moeilijke beslissingen gemakkelijker verteerbaar

Kaas, koeien en mest - systeembenadering maakt moeilijke beslissingen gemakkelijker verteerbaar 'S Werelds krachtigste akoestische trekstraal kan de weg vrijmaken voor zwevende mensen

'S Werelds krachtigste akoestische trekstraal kan de weg vrijmaken voor zwevende mensen

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com