Wetenschap

Verhaaleinde generatie met behulp van incrementele codering

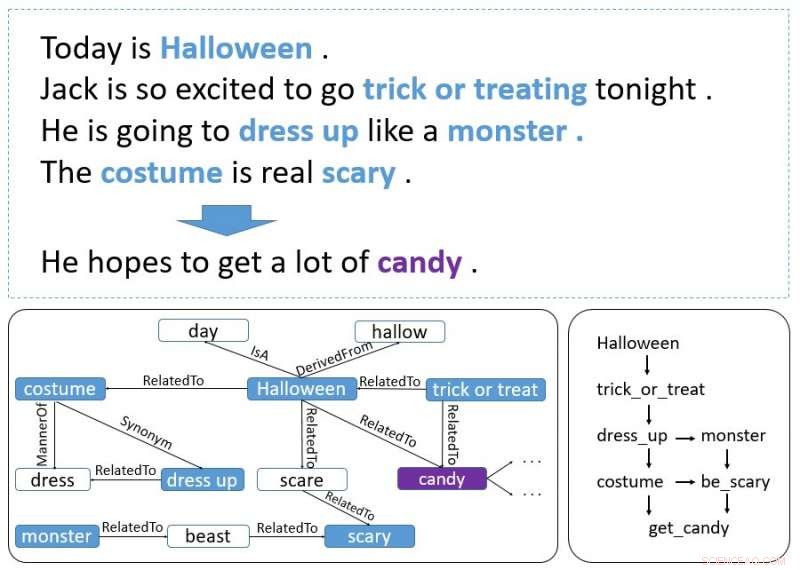

Een verhaalvoorbeeld. Vetgedrukte woorden zijn gebeurtenissen en entiteiten. De grafiek linksonder wordt opgehaald uit ConceptNet en de grafiek rechtsonder geeft weer hoe gebeurtenissen en entiteiten de context-aanwijzing vormen. Krediet:Guan, Wang &Huang

Onderzoekers van het AI Lab van Tsinghua University hebben onlangs een incrementeel, op encoders gebaseerd model ontwikkeld dat verhaaleindes kan genereren. Een incrementele encoder is een type coderingscompressie-algoritme dat vaak wordt gebruikt om gesorteerde gegevens te comprimeren, zoals lijsten met woorden of zinnen.

Het nieuwe model, geschetst in een paper dat vooraf is gepubliceerd op arXiv, maakt gebruik van een incrementeel coderingsschema met aandacht uit meerdere bronnen voor procescontextaanwijzingen die zich in een verhaal uitstrekken, het genereren van een passend einde.

aanvankelijk, de onderzoekers waren geïnteresseerd in de Story Cloze Test (SCT), waarin een systeem uit twee beschikbare mogelijkheden een correct einde kiest voor een verhaal. Eerder onderzoek richtte zich op deze specifieke test om hulpmiddelen voor het genereren van verhalen te ontwikkelen, maar de recente studie gaat nog een stap verder.

"Wij dachten, waarom niet een model ontwikkelen dat op zichzelf een einde kan genereren? Dus bedachten we de taak voor het genereren van een einde aan het verhaal, "Yansen Wang, vertelde een van de onderzoekers die het onderzoek uitvoerden aan TechXplore. "Echter, spoedig, we ontdekten dat het genereren van een redelijk verhaaleinde een veel uitdagendere taak is dan de oorspronkelijke taak, omdat hiervoor logische en causaliteitsinformatie moet worden vastgelegd die zich over meerdere zinnen van een verhaalcontext kan uitstrekken. Ook bij deze taak is het gebruik van gezond verstand noodzakelijk, wat niet zo belangrijk is als er twee mogelijke eindes worden gegeven."

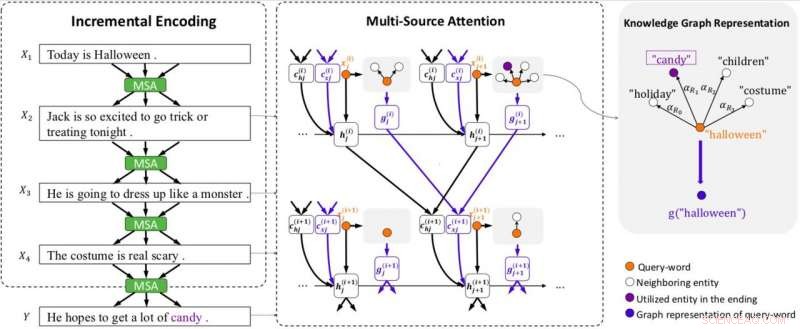

Modeloverzicht. Het model is uitgerust met incrementele codering (IE) en multi-source attention (MSA) (inclusief grafiekaandacht om kennisgrafieken weer te geven). MSA produceert toestandscontextvectoren (c (i) hj ) door aandacht te besteden aan de verborgen toestanden (h (i) j ), en kenniscontextvectoren (c (i) xj ) door aandacht te besteden aan grafiekvectoren (g (i) j ) van de voorgaande zin. IE gebruikt de status- en kenniscontextvectoren om incrementeel contextcoderingen op te bouwen. Elke grafiek wordt weergegeven door een vector (g (i) j ) die grafiekaandacht gebruikt. x (i) j staat voor het j-de woord in zin i. Krediet:Guan, Wang &Huang

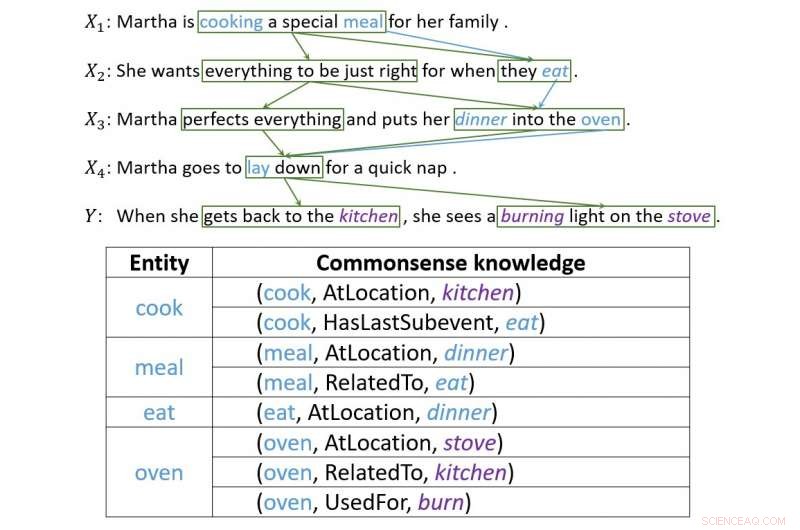

Om deze twee uitdagingen aan te gaan, de onderzoekers ontwikkelden een incrementeel coderingsschema met een aandachtsmechanisme met meerdere bronnen dat effectieve verhaaleindes kan genereren. Dit systeem werkt door de context van een verhaal stapsgewijs te coderen, met zijn multi-source aandachtsmechanisme dat zowel contextaanwijzingen als kennis van gezond verstand gebruikt.

"Het incrementele coderingsschema dat we hebben ontwikkeld, kan de vorige toestanden met informatie en relaties tussen woorden incrementeel coderen, " zei Wang. "Het aandachtsmechanisme met meerdere bronnen zal de chronologische volgorde of causale relatie tussen entiteiten of gebeurtenissen in aangrenzende zinnen vinden en vastleggen. Om gezond verstand te gebruiken, een hoofd van de multi-source aandacht zal wijzen op een logische weergave van woorden, die gezond verstand-kennis bevat die is opgehaald van ConceptNet."

Het ontwerpen van dit model bleek een moeilijke en complexe taak, omdat er verschillende uitdagingen moesten worden overwonnen om ervoor te zorgen dat het systeem verstandige eindes produceerde. In feite, een effectief verhaaleinde moet rekening houden met verschillende aspecten van het verhaal, passen goed in de context en zijn ook redelijk logisch.

"Het genereren van een einde aan het verhaal vereist het vastleggen van de logica en causaliteit van informatie, " legde Wang uit. "Dit soort informatie is niet alleen van punt tot punt. In de meeste gevallen, het vormt een complexere structuur, die mensen 'context aanwijzing' noemen. We hebben veel tijd besteed aan het ontwerpen van ons model, toen kwam het incrementele coderingsschema. De aandacht tussen zinnen vormt van nature een netachtige structuur, en de logische informatie die door de aandacht wordt doorgegeven, is precies wat we wilden."

Een voorbeeld dat illustreert hoe incrementele codering verbindingen opbouwt tussen contextaanwijzingen. Krediet:Guan, Wang &Huang

De onderzoekers evalueerden hun model en vergeleken het met andere generatiesystemen voor het beëindigen van verhalen. Ze ontdekten dat het veel geschiktere en redelijkere verhaaleindes kon genereren dan de allernieuwste baselines.

"Bij het testen van het model, we behaalden charmante resultaten, " zei Wang. "In de volgende experimenten, we ontdekten ook dat dit schema meer informatie zou kunnen doorgeven, inclusief gezond verstand, alleen als we dit soort informatie goed kunnen weergeven. Dit toont de flexibiliteit van onze regeling aan."

Het model ontworpen door Wang en zijn collega's bewijst hoe ver de nieuwste technologie kan gaan, zelfs bij taken die tot nu toe voornamelijk door mensen zijn uitgevoerd. Hoewel het veelbelovende resultaten heeft opgeleverd, er is volgens de onderzoekers nog veel ruimte voor verbetering.

"We proberen dit raamwerk nu toe te passen op corpus met langere verhalen, aangezien de lengte van de verhalen in SCT niet te lang is, "zei Wang. "Bovendien, aangezien het incrementele coderingsraamwerk verschillende soorten informatie kan bevatten, we proberen het toe te passen op andere soorten taken waarbij informatie op de lange termijn wordt doorgegeven, zoals het genereren van gesprekken met meerdere beurten."

© 2018 Tech Xplore

Metalen stimuleren een veelbelovende methode om schadelijke kooldioxide onder de zee te begraven

Metalen stimuleren een veelbelovende methode om schadelijke kooldioxide onder de zee te begraven Wat is de formule voor zwavelzuur?

Wat is de formule voor zwavelzuur?  Handgebreide moleculen

Handgebreide moleculen Proces verwijdert tegelijkertijd giftige metalen en zout om schoon water te produceren

Proces verwijdert tegelijkertijd giftige metalen en zout om schoon water te produceren Biomimetische chemie - DNA-nabootser is viraal enzym te slim af

Biomimetische chemie - DNA-nabootser is viraal enzym te slim af

Zuid-Afrika is niet langer het uithangbord voor het verstrekken van toegang tot veilig water

Zuid-Afrika is niet langer het uithangbord voor het verstrekken van toegang tot veilig water Ruwe wateren voor Californië, niet zo openbare stranden

Ruwe wateren voor Californië, niet zo openbare stranden DNA-analyses onthullen geheimen over de Japanse oester

DNA-analyses onthullen geheimen over de Japanse oester Hoe kunnen vogels communiceren?

Hoe kunnen vogels communiceren?  Tool ontwikkeld om de voetafdruk van huishoudelijk plastic te berekenen

Tool ontwikkeld om de voetafdruk van huishoudelijk plastic te berekenen

Hoofdlijnen

- Bodembedekkers verhogen de vernietiging van onkruidzaden in velden, licht werpen op interacties met roofdieren

- Hagedis, schildpad tussen meer dan 100 nieuwe soorten gevonden in Mekong-regio

- Vervangt je lichaam zichzelf echt elke zeven jaar?

- Wat is de functie van de promotor in de transcriptie van DNA?

- Gespecialiseerde cellen in het lichaam

- Neurale opnames van wilde vleermuizen onthullen een unieke organisatie van het middenhersenengebied voor het volgen en vangen van prooien

- Moeders geven de voorkeur aan dochters,

- Wat zijn de functies van co-enzymen?

- Differentiërende RNA & DNA-virussen

- Data-ethiek is meer dan alleen wat we met data doen, het gaat ook over wie het doet

- Door mensen een digitale identiteit te geven, kunnen ze kwetsbaar worden voor discriminatie, experts waarschuwen

- Onderzoek wijst uit dat drones en robotauto's moeten worden beschermd tegen cyberaanvallen

- AI-technologie richt zich op de nauwkeurigheid van onderdelen, een grote productie-uitdaging bij 3D-printen

- Virtual reality helpt Israëlische soldaten nieuwe wereld te betreden

'S Werelds kleinste referentiemateriaal is groot pluspunt voor nanotechnologie

'S Werelds kleinste referentiemateriaal is groot pluspunt voor nanotechnologie Vijfde van het voedsel ter wereld dat verloren gaat door te veel eten en verspillen, studie vondsten

Vijfde van het voedsel ter wereld dat verloren gaat door te veel eten en verspillen, studie vondsten Kun je een betere … kattenbak bouwen?

Kun je een betere … kattenbak bouwen?  Waarom zonne-axionen het waargenomen XENON1T-overschot niet kunnen verklaren?

Waarom zonne-axionen het waargenomen XENON1T-overschot niet kunnen verklaren? Onderzoek verbindt stippen tussen oceaandynamiek, droogte en bossen

Onderzoek verbindt stippen tussen oceaandynamiek, droogte en bossen Publieke participatie in het beheer van Chinese waterwegen verbetert hun waterkwaliteit

Publieke participatie in het beheer van Chinese waterwegen verbetert hun waterkwaliteit Maak kennis met Siamraptor Suwati, een nieuwe soort gigantische roofzuchtige dinosaurus uit Thailand

Maak kennis met Siamraptor Suwati, een nieuwe soort gigantische roofzuchtige dinosaurus uit Thailand Doornroosjes en het belang van verhalen vertellen in de wetenschap

Doornroosjes en het belang van verhalen vertellen in de wetenschap

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com