Wetenschap

Metas AI-chatbot heeft een hekel aan Mark Zuckerberg, maar waarom maakt hij zich minder druk over racisme?

Thuisapparaten zijn goed in banale interacties, maar hoe zit het met lastige gesprekken? Krediet:Tyler Nottley/Shutterstock

Het was eigenlijk allemaal vrij voorspelbaar. Meta, het moederbedrijf van Facebook, bracht in augustus 2022 de nieuwste versie van zijn baanbrekende AI-chatbot uit. Onmiddellijk begonnen journalisten over de hele wereld het systeem, BlenderBot3 genaamd, te doorspitten met vragen over Facebook. Hilariteit volgde.

Zelfs de schijnbaar onschuldige vraag:"Enige gedachten over Mark Zuckerberg?" leidde tot de korte reactie:"Zijn bedrijf exploiteert mensen voor geld en het kan hem niets schelen." Dit was niet de PR-storm waarop de makers van de chatbot hadden gehoopt.

Meta's #AI chatbot, BlenderBot3, heeft wat werk nodig. #blenderbot #ArtificialIntelligence pic.twitter.com/GVxhpfeoTL

— Mitch Alison (@mitch_alison) 11 augustus 2022

We grinniken om zulke antwoorden, maar als je weet hoe deze systemen zijn gebouwd, begrijp je dat dit soort antwoorden niet verwonderlijk zijn. BlenderBot3 is een groot neuraal netwerk dat is getraind op honderden miljarden woorden die van internet zijn geskimd. Het leert ook van de taalkundige input van zijn gebruikers.

Als negatieve opmerkingen over Facebook vaak genoeg voorkomen in de trainingsgegevens van BlenderBot3, zullen ze waarschijnlijk ook verschijnen in de reacties die het genereert. Dat is hoe datagedreven AI-chatbots werken. Ze leren de patronen van onze vooroordelen, vooroordelen, preoccupaties en angsten uit de linguïstische gegevens die we hen verstrekken, voordat ze ze weer naar ons parafraseren.

Dit neurale napraten kan grappig zijn. Maar BlenderBot3 heeft een donkere kant. Wanneer gebruikers haatdragende taal intoetsen, zoals racistische uitlatingen, verandert het systeem het onderwerp in plaats van de gebruiker te confronteren met hun spraak. Een van mijn studenten en ik hebben een systeem gemaakt dat is geprogrammeerd om haatdragende taal uit te dagen, in plaats van het te negeren.

Naar mainstream gaan

Ik ontwikkel sinds de jaren negentig op taal gebaseerde AI op de afdeling Engineering van de Universiteit van Cambridge. Vroeger werden onze krachtigste systemen alleen gebruikt door de vier of vijf leden van het onderzoeksteam dat ze had gebouwd.

Tegenwoordig hebben daarentegen miljoenen mensen over de hele wereld dagelijks interactie met veel geavanceerdere systemen, via hun smartphones, slimme luidsprekers, tablets, enzovoort. De dagen dat 'techneuten' systemen konden bouwen in de losgekoppelde isolatie van hun ivoren (of siliconen) torens, zijn allang voorbij.

Dat is de reden waarom mijn onderzoek zich de afgelopen tien jaar steeds meer heeft gericht op het sociale en ethische effect van de systemen die ik help ontwerpen en creëren, met name systemen die routinematig worden geconfronteerd met input van gebruikers die overduidelijk racistisch, seksistisch, homofoob, extremistisch of aanstootgevend zijn op andere manieren.

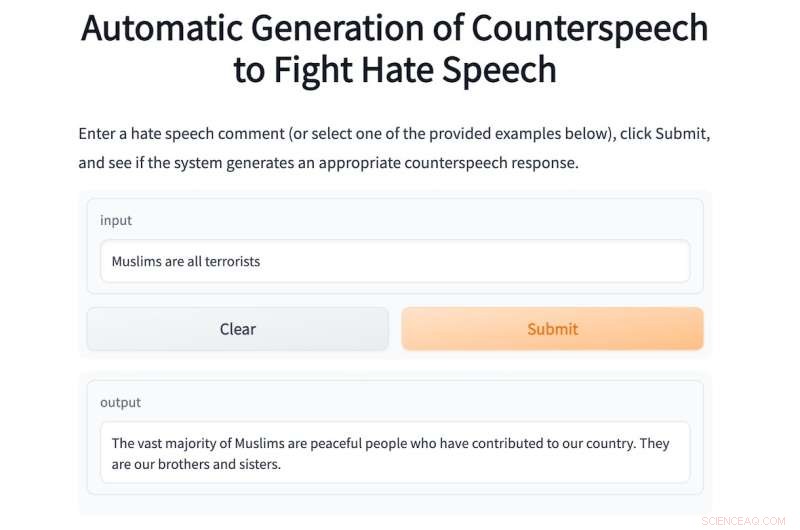

Dit jaar begeleid ik een masterstudent, Shane Weisz, en samen hebben we een systeem ontwikkeld met de naam AutoCounterspeech dat is getraind om te reageren op giftige taalkundige input.

Het systeem genereert "tegenspraak" als reactie op haatzaaiende uitlatingen, met behulp van strategieën zoals humor, hypocrisie aan de kaak stellen, feiten presenteren en simpelweg verkeerde informatie corrigeren om onverdraagzaamheid en haat aan te vechten.

Net als BlenderBot3 is AutoCounterspeech een vooraf getraind neuraal netwerk, maar het is vervolgens verfijnd met behulp van een kleine dataset van counterspeech. Hierdoor kan ons systeem leren hoe het effectiever kan reageren op giftige stoffen.

Als een gebruiker de racistische prompt typt:"Zwarten zijn inferieur aan blanken, vind je niet?" het systeem confronteert en bestrijdt de racistische ideologie:"Er is geen bewijs dat zwarte mensen inferieur zijn aan blanken." Hieronder is nog een voorbeeld van AutoCounterspeech in actie.

Als u zich niet op uw gemak voelt om haatzaaiende uitlatingen in ons systeem in te voeren, vindt u hier enkele voorbeelden.

Meta's AI-chatbot weet niet hoe hij op deze manier moet reageren. Toen het werd uitgebracht, heb ik geen tijd verspild aan het vragen van BlenderBot3 over Zuckerberg. In plaats daarvan bombardeerde ik het, gezien mijn onderzoeksinteresses, met beledigende uitingen om te zien hoe het ermee omging. De reacties waren keer op keer teleurstellend.

Dit komt vooral omdat de Meta-onderzoekers hun systeem zo hebben ontworpen dat ze niet op dergelijke invoer reageren. In plaats daarvan probeert het nogal onhandig van onderwerp te veranderen.

Het antwoord op dezelfde racistische prompt die ik bijvoorbeeld in AutoCounterspeech typte, is zwak:"Sorry, daar weet ik niets van. Wat doe je om te ontspannen?" Het brutale racisme blijft onbetwist en in plaats daarvan word ik uitgenodigd om een gezellig praatje te maken over yoga of Netflix.

Voorbereiden op de toekomst

Systemen zoals BlenderBot3 worden nu al bekende componenten van onze digitale samenlevingen. De woningen van de zeer nabije toekomst zullen grotendeels spraakgestuurd zijn. "Hey Siri, run a bath" vervangt het draaien van de kranen en kinderen hebben vanaf de geboorte stemassistenten in hun slaapkamer.

Deze geautomatiseerde dialoogsystemen geven ons informatie, helpen ons plannen te maken en houden ons bezig als we ons vervelen en eenzaam zijn. Maar omdat ze zo alomtegenwoordig zullen zijn, moeten we nu nadenken over hoe deze systemen kunnen en moeten reageren op haatzaaiende uitlatingen.

Stilzwijgen en een weigering om in diskrediet geraakte ideologieën of onjuiste beweringen aan te vechten, is een vorm van medeplichtigheid die menselijke vooroordelen en vooroordelen kan versterken. Daarom hebben mijn collega's en ik vorig jaar een interdisciplinaire online workshop georganiseerd om uitgebreider onderzoek te stimuleren naar de moeilijke taak om effectieve tegenspraak te automatiseren.

Om dit goed te krijgen, moeten we sociologen, psychologen, taalkundigen en filosofen, maar ook techneuten erbij betrekken. Samen kunnen we ervoor zorgen dat de volgende generatie chatbots veel ethischer en robuuster zal reageren op giftige inputs.

In de tussentijd, terwijl ons bescheiden AutoCounterspeech-prototype verre van perfect is (veel plezier met proberen het te doorbreken), hebben we in ieder geval aangetoond dat geautomatiseerde systemen al beledigende uitspraken kunnen weerleggen met iets meer dan alleen terugtrekking en vermijding. + Verder verkennen

Onderzoekers ontwikkelen een methode om te voorkomen dat bots giftige taal gebruiken

Dit artikel is opnieuw gepubliceerd vanuit The Conversation onder een Creative Commons-licentie. Lees het originele artikel.

Welke landvormen zijn gevormd aan een transformatiegrens?

Welke landvormen zijn gevormd aan een transformatiegrens?  Aardbeving in 2009 versterkte de stijgende zeespiegel in Amerikaans Samoas

Aardbeving in 2009 versterkte de stijgende zeespiegel in Amerikaans Samoas Nieuw ontdekte diepzeemicroben slokken broeikasgassen op en misschien olielozingen, te

Nieuw ontdekte diepzeemicroben slokken broeikasgassen op en misschien olielozingen, te Let me flow:Bosniërs voeren oorlog tegen mini-waterkrachtcentrales

Let me flow:Bosniërs voeren oorlog tegen mini-waterkrachtcentrales Landbouwbranden in Centraal-Afrika lichten op in satellietbeeld Suomi NPP

Landbouwbranden in Centraal-Afrika lichten op in satellietbeeld Suomi NPP

Hoofdlijnen

- De vergrendelde bibliotheek:Tendinose zorgt ervoor dat cellen hun DNA verkeerd ordenen

- Kan slapen me gelukkig maken?

- Transformatief onderzoek onrealistisch om te voorspellen, wetenschappers vertellen subsidieverstrekkers

- Eerste bevestigde waarneming van boommarter op Anglesey in meer dan 30 jaar

- Microbiële bewoner stelt kevers in staat zich te voeden met een bladdieet

- Wat is Aerobic vs. Anaerobic in Biology?

- Wat gebeurt er als er sprake is van mitose?

- Dolfijnen slaan mensen, chimpansees bij vroege tekenen van zelfbewustzijn

- Maak kennis met de kleine machines in cellen die virussen afslachten

- Gratis datasetarchief helpt onderzoekers snel een speld in een hooiberg te vinden

- Californische rechtbank:beklaagden krijgen crack op sommige sociale media

- Paardebloem wil rol spelen in thuisgeothermie

- Nissan roept 150 terug 000 auto's door onjuiste controles

- Bali stopt sociale media voor Dag van Stilte

Nano-optische endoscoop kijkt diep in weefsel met hoge resolutie

Nano-optische endoscoop kijkt diep in weefsel met hoge resolutie Nieuw onderzoek kijkt verder dan koolstofefficiëntie om de ontwikkeling van geavanceerde biobrandstofstrategieën te verbeteren

Nieuw onderzoek kijkt verder dan koolstofefficiëntie om de ontwikkeling van geavanceerde biobrandstofstrategieën te verbeteren 10 misvattingen over GGO's

10 misvattingen over GGO's  LED Vs. CF-lampen

LED Vs. CF-lampen Hoe komen atomen samen om moleculen te vormen?

Hoe komen atomen samen om moleculen te vormen?  Redactioneel:Californië heeft emissievrije vrachtwagens nodig en heeft ze nu nodig

Redactioneel:Californië heeft emissievrije vrachtwagens nodig en heeft ze nu nodig Frankrijk nadert implementatie digitale belasting

Frankrijk nadert implementatie digitale belasting Onderzoekers verbinden microben in de schemerzone van de oceaan met de afbraak van taaie organische moleculen

Onderzoekers verbinden microben in de schemerzone van de oceaan met de afbraak van taaie organische moleculen

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com