Wetenschap

Stop met gokken met black box en verklaarbare modellen voor beslissingen met hoge inzetten

Cynthia Rudin. Krediet:Duke University

Nu de modewoorden 'machine learning' steeds populairder worden, meer industrieën wenden zich tot computeralgoritmen om belangrijke vragen te beantwoorden, inclusief high-stakes gebieden zoals gezondheidszorg, financiën en strafrecht. Hoewel deze trend kan leiden tot grote verbeteringen op deze gebieden, het kan ook tot grote problemen leiden wanneer het machine learning-algoritme een zogenaamde 'black box' is.

Een black box is een machine learning-programma dat niet uitlegt hoe het tot zijn conclusies komt, ofwel omdat het te ingewikkeld is voor een mens om te begrijpen of omdat de innerlijke werking ervan eigendom is. Als reactie op de bezorgdheid dat dit soort modellen mogelijk onrechtvaardige innerlijke werkingen bevatten, zoals racisme, is een andere groeiende trend om extra modellen te creëren om deze zwarte dozen te 'verklaren'.

In een nieuw redactioneel gepubliceerd in Natuur Machine Intelligentie , Cynthia Rudin, universitair hoofddocent informatica, elektrotechniek en computertechniek, wiskunde, en statistische wetenschappen aan de Duke University, stelt dat black box-modellen moeten worden opgegeven voor beslissingen met een hoge inzet. Zelfs wanneer zogenaamde verklaringsmodellen worden gecreëerd, ze zegt, besluitvormers moeten kiezen voor interpreteerbare modellen, die volledig transparant en gemakkelijk te begrijpen zijn voor de gebruikers.

Verklaarbare modellen zijn fout

"Verklaarbare" machine learning-modellen zijn gebouwd in een poging om te begrijpen wat er in een zwarte doos gebeurt. Als het dezelfde resultaten kan opleveren, mensen gaan ervan uit dat het een nauwkeurige weergave is.

Maar dat is het niet.

Verklaarbare algoritmen bieden verklaringen die per definitie onnauwkeurig zijn - anders zou de complexe interne werking van de zwarte doos niet nodig zijn. Hoewel een verklaringsmodel vergelijkbare of zelfs exacte resultaten kan opleveren als het originele black box-algoritme, er is geen manier om te weten of het dezelfde parameters gebruikt of niet.

"Als een tiende van de verklaringen fout is, je kunt de uitleg niet vertrouwen, en dus kun je de originele zwarte doos niet vertrouwen, " zegt Rudin. "Als we niet zeker kunnen weten of onze uitleg correct is, we weten niet of we de verklaring of het originele model moeten vertrouwen."

Meer is niet gelijk aan beter

Mensen gaan er meestal van uit dat alleen omdat een algoritme voor machine learning ingewikkeld is, dat het nauwkeuriger is dan een eenvoudige. Maar dit geloof is ongegrond.

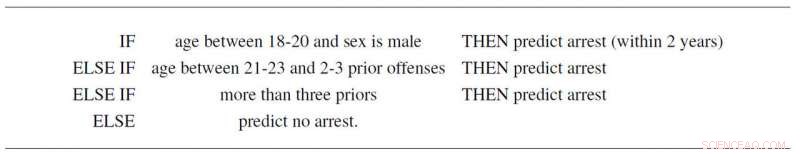

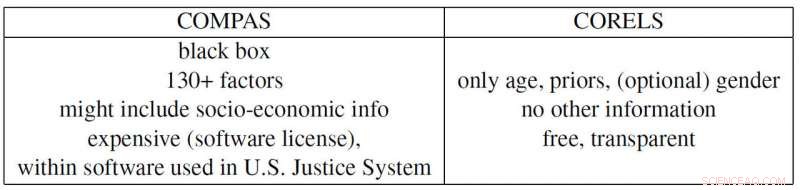

Bijvoorbeeld, Rudin en medewerkers Elaine Angelino, Margo Seltzer, Nicholas Larus-Stone en Daniel Alabi hebben een eenvoudig interpreteerbaar model voor criminele recidive gemaakt op basis van alleen leeftijd, geslacht en voorgeschiedenis. Het volgt niet alleen drie eenvoudige regels die iedereen kan begrijpen, het voorspelt de waarschijnlijkheid van toekomstige arrestaties net zo goed als het controversiële "COMPAS"-programma, die op grote schaal wordt gebruikt in het Amerikaanse rechtssysteem. En behalve dat het een zwarte doos is waarvan veel verdachten racistische vooroordelen gebruiken, COMPAS gebruikt meer dan 130 stukjes informatie om zijn voorspellingen te doen, wat op zichzelf al een groot probleem is.

"Als de mensen die deze gegevens invoeren slechts één procent van de tijd een typfout maken, dan zal gemiddeld meer dan 1 op de 2 enquêtes minstens één fout bevatten, " zegt Rudin. "Bovendien kan een al te gecompliceerd black box-model gebrekkig zijn zonder dat iemand het door heeft, omdat het moeilijk is om problemen op te lossen."

Het Propublica-voorbeeld

ProPublica beschuldigde onlangs het COMPAS-algoritme voor recidive van de zwarte doos ervan racistisch bevooroordeeld te zijn omdat ze een verklaarbaar model op basis van ras creëerden dat de resultaten van COMPAS reproduceert. Maar omdat maatschappelijke druk een strafrechtelijk systeem heeft gecreëerd waarin criminele geschiedenis en leeftijd in elke dataset gecorreleerd zijn met ras, de eigenlijke COMPAS-zwarte doos vertrouwt misschien alleen op de eerste twee variabelen. Maar dan opnieuw, het zou ook ras als factor kunnen gebruiken, zoals ProPublica beweert. Het probleem is dat het onmogelijk te zeggen is omdat COMPAS een (dure) propriëtaire zwarte doos is waar niemand anders dan de eigenaars in kunnen kijken.

Rudin wijst ook op een aantal andere hedendaagse problematische voorbeelden. De gepatenteerde zwarte doos BreezoMeter vertelde gebruikers in Californië dat hun luchtkwaliteit prima was, terwijl de luchtkwaliteit volgens meerdere andere modellen gevaarlijk slecht was. Een machine learning-model dat is ontworpen om röntgenfoto's te lezen, pikte het woord 'draagbaar' op in een röntgenbeeld, het type röntgenapparatuur weergeeft in plaats van de medische inhoud van het beeld, en dus slechte conclusies rapporteren.

"Er is een verantwoordelijkheidsconflict bij het gebruik van black box-modellen voor beslissingen met een hoge inzet. De bedrijven die profiteren van deze modellen zijn niet noodzakelijkerwijs verantwoordelijk voor de kwaliteit van individuele voorspellingen, ", zegt Rudin. "Een gevangene die een te lange straf uitzit vanwege een fout die is ingevoerd in een te gecompliceerde risicoscore, kan jarenlang lijden, terwijl het bedrijf dat dit model heeft ontwikkeld, profiteert van de complexiteit en betrouwbaarheid ervan. Op die manier, de ontwerpers van het model worden niet gestimuleerd om voorzichtig te zijn in het ontwerp, prestaties en gebruiksgemak. Dit zijn enkele van dezelfde soorten problemen die de kredietbeoordelaars treffen die in 2008 de prijzen van hypotheken hebben bepaald."

"Ik hoop dat mensen zich bewust zijn van de risico's van verklaarbare modellen en dat ze eigenlijk helemaal geen zwarte dozen nodig hebben. Ze kunnen modellen gebruiken die volledig interpreteerbaar zijn, " zegt Rudin. "Ik zou graag een systeem zien waarin geen black box-algoritme wordt gebruikt voor een beslissing met hoge inzetten, tenzij er geen even nauwkeurig interpreteerbaar model is. Ik heb aan veel verschillende toepassingen gewerkt:medische zorg, energie, KREDIETRISICO, criminele recidive, computervisie - en ik heb nog nooit een toepassing gevonden waar een zwarte doos echt nodig is."

Een mooie reactie daarop:nieuwe synthetische routes voor diverse aromatische verbindingen

Een mooie reactie daarop:nieuwe synthetische routes voor diverse aromatische verbindingen Methode levert een hoog percentage D-lactaat op met behulp van cyanobacteriën, kan een revolutie teweegbrengen in de productie van bioplastic

Methode levert een hoog percentage D-lactaat op met behulp van cyanobacteriën, kan een revolutie teweegbrengen in de productie van bioplastic Fatale fout ontdekt in groen gepigmenteerd beton

Fatale fout ontdekt in groen gepigmenteerd beton Chemical Engineering Research Paper Onderwerpen

Chemical Engineering Research Paper Onderwerpen  Vloeibare honing, harige spinazie en glanzende appels:verrassende feiten over je eten

Vloeibare honing, harige spinazie en glanzende appels:verrassende feiten over je eten

Mariene hittegolven zijn door mensen gemaakt

Mariene hittegolven zijn door mensen gemaakt Afbeelding:Amazonebranden

Afbeelding:Amazonebranden aardmantel, niet de kern, kan een vroeg magnetisch veld van planeten hebben gegenereerd

aardmantel, niet de kern, kan een vroeg magnetisch veld van planeten hebben gegenereerd Zeespiegelstijging zorgt voor lekkage van afvalwater naar kustwateren

Zeespiegelstijging zorgt voor lekkage van afvalwater naar kustwateren Onzekerheden over de ijskap kunnen betekenen dat de zeespiegel meer stijgt dan voorspeld

Onzekerheden over de ijskap kunnen betekenen dat de zeespiegel meer stijgt dan voorspeld

Hoofdlijnen

- Welke organellen worden beschouwd als het cellen recyclingscentrum?

- Duizenden johannesbroodbomen geplant terwijl Cyprus het zwarte goud doet herleven

- De Krebs-cyclus en de Homeostasis

- Sleutel tot betere asperges geïdentificeerd in evolutie van geslachtschromosomen

- Een flitsende gele keelzanger? Daar zijn genen voor

- Exon: definitie, functie en belang in RNA Splicing

- Metabolisme heeft een directe invloed op de kans op het ontwikkelen van malaria

- Herbivoren helpen ecosystemen te beschermen tegen klimaatverandering

- Zijn psychische aandoeningen genetisch bepaald?

- Indias Jet verlengt internationale annuleringen terwijl luchtvaartmaatschappij wankelt

- ONS, China bereikt een ZTE-deal van $ 1,4 miljard naarmate er tekenen verschijnen van voortgang van de handelsbesprekingen

- Ultradunne zonnecellen behalen een record van bijna 20 procent efficiëntie

- Uber verwerpt de prijslimiet voor ritjes die in Honolulu is aangenomen

- Intel en Softbank pas op. Open source komt naar de chipbusiness

Verminderde impact houtkap schaadt nog steeds de biodiversiteit in tropische regenwouden

Verminderde impact houtkap schaadt nog steeds de biodiversiteit in tropische regenwouden Waterstofeffecten in metaal observeren

Waterstofeffecten in metaal observeren De typen zeebodembodems

De typen zeebodembodems  Balanceert de westerse cultuur op het koord tussen wetenschap en geesteswetenschappen?

Balanceert de westerse cultuur op het koord tussen wetenschap en geesteswetenschappen? Video:Het duizend jaar oude ei

Video:Het duizend jaar oude ei Model identificeert een hoge mate van schommelingen in gluonen als essentieel voor het verklaren van de protonstructuur

Model identificeert een hoge mate van schommelingen in gluonen als essentieel voor het verklaren van de protonstructuur Gas stijgt wereldwijd terwijl groene groepen huilen

Gas stijgt wereldwijd terwijl groene groepen huilen Studie toont aan dat flamingo's in de Sunshine State voorkomen

Studie toont aan dat flamingo's in de Sunshine State voorkomen

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Swedish | Dutch | Danish | Norway | Portuguese | German |

-

Wetenschap © https://nl.scienceaq.com