Wetenschap

Een AI-systeem voor het bewerken van muziek in video's

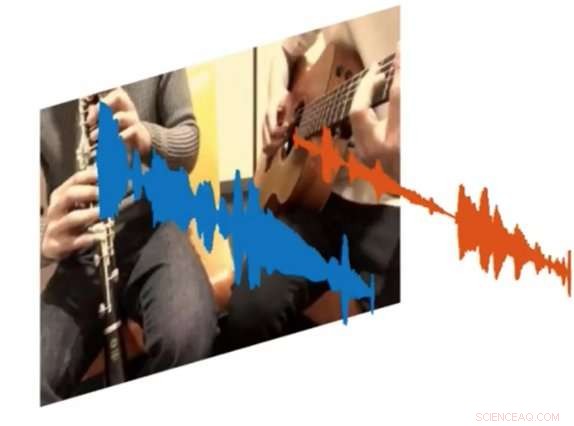

Een nieuw AI-systeem genaamd PixelPlayer kan naar een afbeelding kijken en bepalen welke set pixels verantwoordelijk is voor het maken van specifieke sets geluidsgolven. Krediet:MIT CSAIL

Zowel amateur- als professionele muzikanten kunnen urenlang YouTube-clips doorzoeken om erachter te komen hoe ze bepaalde delen van hun favoriete nummers precies moeten spelen. Maar wat als er een manier was om een video af te spelen en het enige instrument te isoleren dat je wilde horen?

Dat is het resultaat van een nieuw AI-project van MIT's Computer Science and Artificial Intelligence Laboratory (CSAIL):een diepgaand leersysteem dat naar een video van een muziekuitvoering kan kijken, en isoleer de geluiden van specifieke instrumenten en maak ze luider of zachter.

Het systeem, dat is "zelf-gecontroleerd, " vereist geen menselijke aantekeningen over wat de instrumenten zijn of hoe ze klinken.

Getraind in meer dan 60 uur aan video's, het "PixelPlayer"-systeem kan een nooit eerder vertoonde muzikale uitvoering bekijken, identificeren van specifieke instrumenten op pixelniveau, en extraheer de geluiden die bij die instrumenten horen.

Bijvoorbeeld, het kan een video zijn van een tuba en een trompet die het themalied "Super Mario Brothers" speelt, en scheid de geluidsgolven die bij elk instrument horen.

De onderzoekers zeggen dat de mogelijkheid om het volume van individuele instrumenten te veranderen, betekent dat in de toekomst, dergelijke systemen kunnen technici mogelijk helpen de geluidskwaliteit van oude concertbeelden te verbeteren. Je zou je zelfs kunnen voorstellen dat producers specifieke instrumentpartijen nemen en een voorproefje geven van hoe ze zouden klinken met andere instrumenten (d.w.z. een elektrische gitaar die is ingeruild voor een akoestische).

In een nieuwe krant het team toonde aan dat PixelPlayer de geluiden van meer dan 20 veelvoorkomende instrumenten kan identificeren. Hoofdauteur Hang Zhao zegt dat het systeem veel meer instrumenten zou kunnen identificeren als het meer trainingsgegevens had. hoewel het nog steeds moeite kan hebben met het omgaan met subtiele verschillen tussen subklassen van instrumenten (zoals een altsax versus een tenor).

Eerdere pogingen om de geluidsbronnen te scheiden, waren uitsluitend gericht op audio, waarvoor vaak uitgebreide menselijke etikettering vereist is. In tegenstelling tot, PixelPlayer introduceert het element visie, waarvan de onderzoekers zeggen dat het menselijke labels overbodig maakt, zoals visie zelf-supervisie biedt.

Het systeem lokaliseert eerst de beeldgebieden die geluiden produceren, en scheidt vervolgens de invoergeluiden in een set componenten die het geluid van elke pixel vertegenwoordigen.

"We verwachtten een best-case scenario waarin we zouden kunnen herkennen welke instrumenten welke soorten geluiden maken, " zegt Zhao, een doctoraat student aan CSAIL. "We waren verrast dat we de instrumenten daadwerkelijk ruimtelijk op pixelniveau konden lokaliseren. Dat opent veel mogelijkheden, zoals het kunnen bewerken van de audio van individuele instrumenten door een enkele klik op de video."

PixelPlayer gebruikt methoden van "deep learning, " wat betekent dat het patronen in gegevens vindt met behulp van zogenaamde "neurale netwerken" die zijn getraind op bestaande video's. één neuraal netwerk analyseert de beelden van de video, men analyseert de audio, en een derde "synthesizer" associeert specifieke pixels met specifieke geluidsgolven om de verschillende geluiden te scheiden.

PixelPlayer bevat ook een interface waarmee gebruikers het volume van specifieke instrumenten in de mix kunnen wijzigen. Krediet:MIT CSAIL

Het feit dat PixelPlayer gebruik maakt van zogenaamd "zelf-gesuperviseerd" deep learning, betekent dat het MIT-team niet expliciet elk aspect begrijpt van hoe het leert welke instrumenten welke geluiden maken.

Echter, Zhao zegt dat hij kan zien dat het systeem daadwerkelijke elementen van de muziek lijkt te herkennen. Bijvoorbeeld, bepaalde harmonische frequenties lijken te correleren met instrumenten als viool, terwijl snelle pulsachtige patronen overeenkomen met instrumenten zoals de xylofoon.

Zhao zegt dat een systeem als PixelPlayer zelfs op robots kan worden gebruikt om de omgevingsgeluiden die andere objecten maken beter te begrijpen. zoals dieren of voertuigen.

Dit verhaal is opnieuw gepubliceerd met dank aan MIT News (web.mit.edu/newsoffice/), een populaire site met nieuws over MIT-onderzoek, innovatie en onderwijs.

Diep, slow-slip actie kan de grootste aardbevingen en hun tsunami's leiden

Diep, slow-slip actie kan de grootste aardbevingen en hun tsunami's leiden Draagt koude natuurbrandrook bij aan waterafstotende bodems in verbrande gebieden?

Draagt koude natuurbrandrook bij aan waterafstotende bodems in verbrande gebieden? Zwangere vrouwen hebben een hoger risico om vroeg te bevallen op ongebruikelijk warme dagen

Zwangere vrouwen hebben een hoger risico om vroeg te bevallen op ongebruikelijk warme dagen Kenmerken van zaadloze vaatplanten

Kenmerken van zaadloze vaatplanten  2018-2022 worden naar verwachting abnormaal warme jaren

2018-2022 worden naar verwachting abnormaal warme jaren

Hoofdlijnen

- Hoge opbrengst, eiwit met sojabonengen

- Onderzoekers ontdekken dat stress tijdens de zwangerschap de grootte van de baby beïnvloedt

- Wat zijn de functies van longblaasjes in de longen?

- Wetenschappers werken samen aan onderzoek om bedreigde Afrikaanse pinguïns te redden

- Waarom heeft de evolutie ons niet het vermogen gegeven om zoet water te ruiken?

- Bloem of vlees? Genetica verklaart de voorkeur van muggen

- Macht overdragen aan staten zal de bescherming van bedreigde diersoorten niet verbeteren

- Wat is het principe van parsimony in de biologie?

- Hoe overleef je een massale uitsterving?

- Chinese smartphonegigant Xiaomi debuteert in Londen

- Bespotten wolkenkrabbers, gesimuleerde regen in zelfrijdend testcentrum in Singapore

- Infraroodcamera om hoogwaardige 3D-reproduceerbaarheid van onderdelen te garanderen

- Amazons onthult dat zijn Prime-service 100 miljoen leden heeft

- Zelfrijdende shuttles:waar wachten we nog op?

Zes decennia kosmologie

Zes decennia kosmologie Plotselinge opwarming van de stratosfeer gekoppeld aan open water in poolijs

Plotselinge opwarming van de stratosfeer gekoppeld aan open water in poolijs Stroom meten met een oscilloscoop

Stroom meten met een oscilloscoop Hoe stereo voor het eerst werd verkocht aan een sceptisch publiek

Hoe stereo voor het eerst werd verkocht aan een sceptisch publiek Afgestudeerde bio-engineering maakt furore in MR-onderzoek met een 3D-geprinte fantoomkop

Afgestudeerde bio-engineering maakt furore in MR-onderzoek met een 3D-geprinte fantoomkop Beloften, belooft:Facebooks geschiedenis met privacy

Beloften, belooft:Facebooks geschiedenis met privacy Een manier om een twee-nikkelkatalysator te gebruiken om cyclopentenen te synthetiseren

Een manier om een twee-nikkelkatalysator te gebruiken om cyclopentenen te synthetiseren Relatie tussen maanstanden en getijden

Relatie tussen maanstanden en getijden

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com