Wetenschap

De toekomst van AI heeft hardwareversnellers nodig op basis van analoge geheugenapparaten

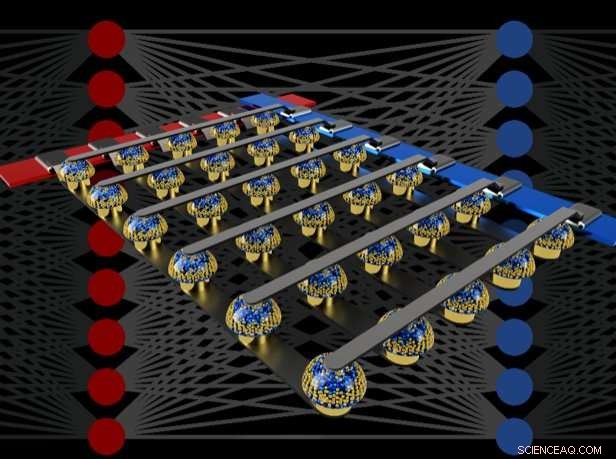

Crossbar-arrays van niet-vluchtige herinneringen kunnen de training van volledig verbonden neurale netwerken versnellen door berekeningen uit te voeren op de locatie van de gegevens. Krediet:IBM

Stel je gepersonaliseerde kunstmatige intelligentie (AI) voor, waar uw smartphone meer een intelligente assistent wordt - uw stem herkennen, zelfs in een rumoerige kamer, de context van verschillende sociale situaties begrijpen of alleen de informatie presenteren die echt relevant voor je is, geplukt uit de stortvloed aan gegevens die elke dag binnenkomt. Dergelijke mogelijkheden liggen misschien binnenkort binnen ons bereik, maar om daar te komen, is een snelle, krachtig, energiezuinige AI-hardwareversnellers.

In een recent artikel gepubliceerd in Natuur , ons IBM Research AI-team demonstreerde diepe neurale netwerktraining (DNN) met grote reeksen analoge geheugenapparaten met dezelfde nauwkeurigheid als een op grafische verwerkingseenheid (GPU) gebaseerd systeem. We geloven dat dit een grote stap is op weg naar het soort hardwareversnellers dat nodig is voor de volgende AI-doorbraken. Waarom? Omdat het leveren van de toekomst van AI een enorme uitbreiding van de schaal van AI-berekeningen vereist.

DNN's moeten groter en sneller worden, zowel in de cloud als aan de rand - en dit betekent dat de energie-efficiëntie drastisch moet verbeteren. Hoewel betere GPU's of andere digitale versnellers tot op zekere hoogte kunnen helpen, dergelijke systemen besteden onvermijdelijk veel tijd en energie aan het verplaatsen van gegevens van het geheugen naar de verwerking en terug. We kunnen zowel snelheid als energie-efficiëntie verbeteren door AI-berekeningen uit te voeren in het analoge domein met precies op de locatie van de gegevens - maar dit heeft alleen zin als de resulterende neurale netwerken net zo slim zijn als die geïmplementeerd met conventionele digitale hardware.

analoge technieken, met continu variabele signalen in plaats van binaire nullen en enen, hebben inherente grenzen aan hun precisie - daarom zijn moderne computers over het algemeen digitale computers. Echter, AI-onderzoekers beginnen zich te realiseren dat hun DNN-modellen nog steeds goed werken, zelfs wanneer de digitale precisie wordt teruggebracht tot niveaus die veel te laag zouden zijn voor bijna elke andere computertoepassing. Dus, voor DNN's, het is mogelijk dat analoge berekening ook zou kunnen werken.

Echter, tot nu, niemand had overtuigend bewezen dat dergelijke analoge benaderingen hetzelfde werk konden doen als de huidige software die op conventionele digitale hardware draait. Dat is, kunnen DNN's echt worden getraind tot gelijkwaardige hoge nauwkeurigheid met deze technieken? Het heeft weinig zin om sneller of energiezuiniger te zijn bij het trainen van een DNN als de resulterende classificatienauwkeurigheden altijd onaanvaardbaar laag zullen zijn.

In onze krant, we beschrijven hoe analoge niet-vluchtige geheugens (NVM) het "backpropagation" -algoritme dat de kern vormt van veel recente AI-vooruitgangen, efficiënt kunnen versnellen. Met deze geheugens kunnen de "vermenigvuldigen-accumuleren"-bewerkingen die in deze algoritmen worden gebruikt, worden geparallelliseerd in het analoge domein, op de locatie van gewichtsgegevens, met behulp van onderliggende fysica. In plaats van grote circuits om te vermenigvuldigen en digitale getallen bij elkaar op te tellen, we laten gewoon een kleine stroom door een weerstand in een draad lopen, en verbind vervolgens veel van dergelijke draden met elkaar om de stromen te laten opbouwen. Hierdoor kunnen we veel berekeningen tegelijk uitvoeren, in plaats van de een na de ander. En in plaats van digitale gegevens te verzenden op lange reizen tussen digitale geheugenchips en verwerkingschips, we kunnen alle berekeningen uitvoeren in de analoge geheugenchip.

Echter, vanwege verschillende onvolkomenheden die inherent zijn aan de huidige analoge geheugenapparaten, eerdere demonstraties van DNN-training die direct op grote arrays van echte NVM-apparaten werden uitgevoerd, slaagden er niet in om classificatienauwkeurigheden te bereiken die overeenkwamen met die van software-getrainde netwerken.

Door langetermijnopslag in Phase-Change Memory (PCM)-apparaten te combineren, bijna-lineaire update van conventionele Complementary Metal-Oxide Semiconductor (CMOS)-condensatoren en nieuwe technieken om de variabiliteit van apparaat tot apparaat op te heffen, we hebben deze onvolkomenheden verfijnd en software-equivalente DNN-nauwkeurigheden bereikt op verschillende netwerken. Deze experimenten gebruikten een gemengde hardware-softwarebenadering, het combineren van softwaresimulaties van systeemelementen die gemakkelijk nauwkeurig te modelleren zijn (zoals CMOS-apparaten) samen met een volledige hardware-implementatie van de PCM-apparaten. Het was essentieel om echte analoge geheugenapparaten te gebruiken voor elk gewicht in onze neurale netwerken, omdat modelleringsbenaderingen voor dergelijke nieuwe apparaten vaak niet het volledige scala van apparaat-naar-apparaat-variabiliteit die ze kunnen vertonen, vastleggen.

Met behulp van deze aanpak, we hebben geverifieerd dat volledige chips inderdaad een gelijkwaardige nauwkeurigheid moeten bieden, en dus hetzelfde werk doen als een digitale versneller - maar sneller en met een lager vermogen. Gezien deze bemoedigende resultaten, we zijn al begonnen met het verkennen van het ontwerp van prototype hardwareversnellerchips, als onderdeel van een IBM Research Frontiers Institute-project.

Van deze vroege ontwerpinspanningen die we konden bieden, als onderdeel van onze Nature-paper, eerste schattingen voor het potentieel van dergelijke NVM-gebaseerde chips voor het trainen van volledig verbonden lagen, in termen van de computationele energie-efficiëntie (28, 065 GOP/sec/W) en doorvoer per gebied (3,6 TOP/sec/mm2). Deze waarden overtreffen de specificaties van de huidige GPU's met twee ordes van grootte. Verder, volledig verbonden lagen zijn een soort neurale netwerklaag waarvoor de werkelijke GPU-prestaties vaak ver onder de nominale specificaties vallen.

Dit artikel geeft aan dat onze op NVM gebaseerde aanpak software-equivalente trainingsnauwkeurigheden kan opleveren, evenals ordes van grootte verbetering in versnelling en energie-efficiëntie, ondanks de onvolkomenheden van bestaande analoge geheugenapparaten. De volgende stappen zullen zijn om dezelfde software-equivalentie aan te tonen op grotere netwerken die grote, volledig verbonden lagen - zoals de herhaaldelijk verbonden Long Short Term Memory (LSTM) en Gated Recurrent Unit (GRU) -netwerken achter recente ontwikkelingen in machinevertaling, ondertiteling en tekstanalyse - en om te ontwerpen, implementeren en verfijnen van deze analoge technieken op prototype NVM-gebaseerde hardwareversnellers. Nieuwe en betere vormen van analoog geheugen, geoptimaliseerd voor deze toepassing, zou kunnen helpen om zowel de oppervlaktedichtheid als de energie-efficiëntie verder te verbeteren.

Elektrochemische reactie stimuleert nieuwe medicijnontdekkingen

Elektrochemische reactie stimuleert nieuwe medicijnontdekkingen Aanpak maakt weg vrij voor nieuwe generatie antimicrobiële materialen

Aanpak maakt weg vrij voor nieuwe generatie antimicrobiële materialen Snelle vloeistofverpakking:watersilhouetten insluiten in 3D-polymeermembranen voor lab-in-a-drop-experimenten

Snelle vloeistofverpakking:watersilhouetten insluiten in 3D-polymeermembranen voor lab-in-a-drop-experimenten Onderzoekers testen Lamborghini's koolstofvezelmaterialen in de ruimte

Onderzoekers testen Lamborghini's koolstofvezelmaterialen in de ruimte Drie voorbeelden van eenvoudige destillatiemengsels

Drie voorbeelden van eenvoudige destillatiemengsels

Numerieke modellering van niet-puntige verontreinigingen in de Chinese Bohai Zee

Numerieke modellering van niet-puntige verontreinigingen in de Chinese Bohai Zee Onderzoek toont aan dat zeegras een sterk potentieel heeft om erosie tegen te gaan

Onderzoek toont aan dat zeegras een sterk potentieel heeft om erosie tegen te gaan Toekomstige tsunami's mogelijk in de Rode Zee Golf van Elat-Aqaba

Toekomstige tsunami's mogelijk in de Rode Zee Golf van Elat-Aqaba Studie:Droogte brekende regens zeldzamer, grillig in het westen van de VS

Studie:Droogte brekende regens zeldzamer, grillig in het westen van de VS Biden, Warren stelt nieuwe plannen voor om klimaatverandering tegen te gaan

Biden, Warren stelt nieuwe plannen voor om klimaatverandering tegen te gaan

Hoofdlijnen

- Wetenschappers maken cellen die de tastzin mogelijk maken

- Wat onderscheidt mensen van chimpansees en andere apen?

- Nieuwe sorghumcultivars kunnen duizenden liters ethanol produceren

- Wat is Ribonucleic Acid?

- Onderscheid Rigor Mortis van een Cadaveric Spasm

- Lokale elektrische reacties in bladeren maken fotosynthese hittetolerant

- Is het DNA tussen genen echt rommel?

- Wetenschappers roepen de VS op om onderzoek naar potmedicijnen voor huisdieren toe te staan

- Hoe hersenspoeling werkt

- T-Mobile lanceert 5G-service in de VS

- Amazon wint .amazon-domeinnaam, Zuid-Amerikaanse regio verergeren en digitale commons ondermijnen

- Een oplaaddoos voor Skydio 2-drones kan zakelijke gebruikers aantrekken

- Computerondersteund ontwerp aanpassen

- Slimme materialen geven realtime inzicht in de emoties van de drager

Definitie van biologische opvolging

Definitie van biologische opvolging  Stephen Hawking:Onze eigen domheid blijft een bedreiging voor de mensheid

Stephen Hawking:Onze eigen domheid blijft een bedreiging voor de mensheid  Bailout of subsidie:olie in tijden van pandemie

Bailout of subsidie:olie in tijden van pandemie Smeltende gletsjers hebben beperkte impact op Zwitserse waterkrachtproductie

Smeltende gletsjers hebben beperkte impact op Zwitserse waterkrachtproductie Ghosn:een magnaat vol verrassingen

Ghosn:een magnaat vol verrassingen Ongewervelde dieren inspireren eerste volledig 3D-geprinte actieve materialen voor robots

Ongewervelde dieren inspireren eerste volledig 3D-geprinte actieve materialen voor robots Botsingscursus:amateurastronomen spelen een rol bij inspanningen om de ruimte veilig te houden

Botsingscursus:amateurastronomen spelen een rol bij inspanningen om de ruimte veilig te houden Door kauwgom! Wetenschappers vinden nieuwe schat van 110 miljoen jaar oud

Door kauwgom! Wetenschappers vinden nieuwe schat van 110 miljoen jaar oud

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com