Wetenschap

Geslacht is persoonlijk - niet computationeel

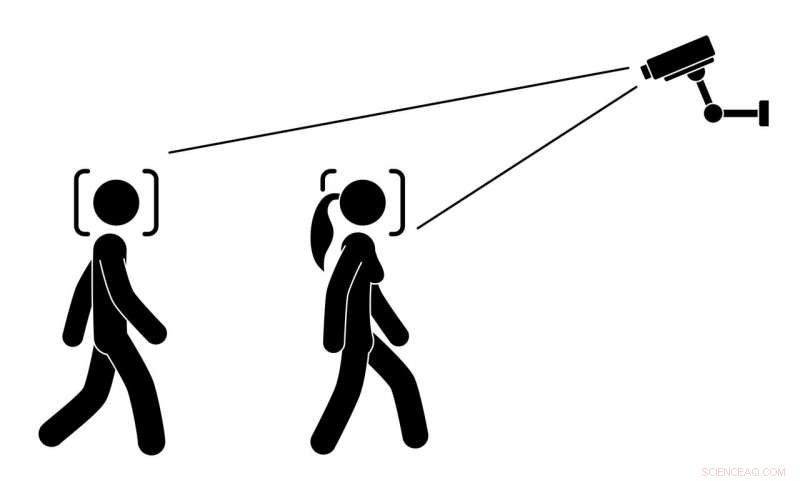

Moet een algoritme proberen te raden welk geslacht mensen zijn aan de hand van hoe ze eruitzien? Krediet:all_is_magic/Shutterstock.com

Stel je voor dat je over straat loopt en ziet dat reclameschermen hun inhoud veranderen op basis van hoe je loopt, hoe je praat, of zelfs de vorm van je borst. Deze schermen zijn afhankelijk van verborgen camera's, microfoons en computers om te raden of je een man of een vrouw bent. Dit klinkt misschien futuristisch, maar klanten in een Noorse pizzeria ontdekten dat het precies was wat er gebeurde:vrouwen zagen advertenties voor salade en mannen zagen advertenties voor vleesopties. De software waarop een digitaal reclamebord draait, heeft de bonen gemorst toen het crashte en de onderliggende code weergaf. De motivatie achter het gebruik van deze technologie kan zijn geweest om de advertentiekwaliteit of gebruikerservaring te verbeteren. Hoe dan ook, veel klanten werden er onaangenaam door verrast.

Dit soort situaties is niet alleen griezelig en invasief. Het is nog erger:pogingen tot automatische geslachtsherkenning - met behulp van algoritmen om het geslacht van een persoon te raden op basis van afbeeldingen, video of audio – leiden tot belangrijke sociale en ethische zorgen die nog niet volledig zijn onderzocht. Het meeste huidige onderzoek naar automatische genderherkenningstechnologieën richt zich in plaats daarvan op technologische details.

Uit ons recente onderzoek bleek dat mensen met verschillende genderidentiteiten, inclusief degenen die zich identificeren als transgender of niet-binair geslacht, zijn met name bezorgd dat deze systemen ze verkeerd kunnen categoriseren. Mensen die hun geslacht anders uiten dan de stereotiepe mannelijke en vrouwelijke normen, ervaren al discriminatie en schade als gevolg van verkeerd gecategoriseerd of verkeerd begrepen worden. Ideaal, technologieontwerpers zouden systemen moeten ontwikkelen om deze problemen minder vaak voor te brengen, niet meer zo.

Algoritmen gebruiken om mensen te classificeren

Naarmate digitale technologieën krachtiger en geavanceerder worden, hun ontwerpers proberen ze te gebruiken om complexe menselijke kenmerken te identificeren en te categoriseren, zoals seksuele geaardheid, geslacht en etniciteit. Het idee is dat met voldoende training over overvloedige gebruikersgegevens, algoritmen kunnen leren om het uiterlijk en gedrag van mensen te analyseren - en misschien op een dag ook mensen te karakteriseren, of zelfs beter dan andere mensen wel.

Gender is een moeilijk onderwerp voor mensen om mee om te gaan. Het is een complex concept met een belangrijke rol als culturele constructie en als kernaspect van de identiteit van een individu. onderzoekers, geleerden en activisten onthullen steeds meer de diverse, vloeiende en veelzijdige aspecten van gender. In het proces, ze vinden dat het negeren van deze diversiteit kan leiden tot zowel schadelijke ervaringen als sociale onrechtvaardigheid. Bijvoorbeeld, volgens de Nationale Transgender-enquête van 2016, 47 procent van de transgender-deelnemers verklaarde op hun werkplek enige vorm van discriminatie te hebben ervaren vanwege hun genderidentiteit. Meer dan de helft van de transgenders die werden lastiggevallen, aangevallen of uitgezet vanwege hun genderidentiteit een zelfmoordpoging hadden ondernomen.

Veel mensen hebben, op een of ander moment, verrast geweest, of verward of zelfs boos om te merken dat ze worden aangezien voor een persoon van een ander geslacht. Als dat gebeurt met iemand die transgender is - naar schatting 0,6 procent van de Amerikanen, of 1,4 miljoen mensen, zijn – het kan aanzienlijke stress en angst veroorzaken.

Effecten van automatische geslachtsherkenning

In ons recente onderzoek hebben we interviewden 13 transgender en gender-niet-conforme mensen, over hun algemene indruk van automatische genderherkenningstechnologie. We vroegen hen ook om hun reacties op denkbeeldige toekomstscenario's te beschrijven waarin ze het zouden kunnen tegenkomen. Alle 13 deelnemers maakten zich zorgen over deze technologie en betwijfelden of het hun gemeenschap voordelen zou kunnen bieden.

Van bijzonder belang was het vooruitzicht erdoor misleid te worden; in hun ervaring, geslacht is grotendeels een interne, subjectief kenmerk, niet iets dat noodzakelijkerwijs of geheel naar buiten wordt uitgedrukt. Daarom, noch mensen noch algoritmen kunnen het geslacht nauwkeurig lezen door middel van fysieke kenmerken, zoals het gezicht, lichaam of stem.

Ze beschreven hoe verkeerd geslacht worden door algoritmen mogelijk erger zou kunnen voelen dan wanneer mensen het zouden doen. Technologie wordt vaak gezien als objectief en onbevooroordeeld, dus verkeerd gecategoriseerd worden door een algoritme zou de misvatting benadrukken dat een transgenderidentiteit niet authentiek is. Een deelnemer beschreef hoe ze zich gekwetst zouden voelen als een "miljoen dollar stuk software ontwikkeld door zoveel mensen" zou besluiten dat ze niet zijn wie ze zelf denken dat ze zijn.

Privacy en transparantie

De mensen die we interviewden deelden de algemene bezorgdheid van het publiek dat geautomatiseerde camera's zouden kunnen worden gebruikt voor bewaking zonder hun toestemming of medeweten; voor jaren, onderzoekers en activisten hebben rode vlaggen gehesen over toenemende bedreigingen voor de privacy in een wereld die wordt bevolkt door sensoren en camera's.

Maar onze deelnemers beschreven hoe de effecten van deze technologieën groter zouden kunnen zijn voor transgenders. Bijvoorbeeld, ze kunnen als ongebruikelijk worden aangemerkt omdat ze er anders uitzien of zich anders gedragen dan de onderliggende algoritmen verwachten. Sommige deelnemers waren zelfs bezorgd dat systemen ten onrechte zouden kunnen vaststellen dat ze iemand anders proberen te zijn en het systeem te misleiden.

Hun bezorgdheid strekte zich ook uit tot cisgender-mensen die er anders uitzien of zich anders gedragen dan de meerderheid, zoals mensen van verschillende rassen, mensen die de algoritmen als androgyn beschouwen, en mensen met unieke gezichtsstructuren. Dit gebeurt al met mensen met een raciale en etnische minderheidsachtergrond, die regelmatig verkeerd worden geïdentificeerd door gezichtsherkenningstechnologie. Bijvoorbeeld, bestaande gezichtsherkenningstechnologie in sommige camera's kan de gezichten van Aziatische gebruikers niet goed detecteren en berichten sturen om te stoppen met knipperen of hun ogen te openen.

Onze geïnterviewden wilden meer weten over hoe automatische genderherkenningssystemen werken en waarvoor ze worden gebruikt. Ze wilden geen diepe technische details weten, maar wilden er zeker van zijn dat de technologie hun privacy of identiteit niet in gevaar zou brengen. Ze wilden ook dat meer transgenders betrokken werden bij de vroege stadia van het ontwerp en de ontwikkeling van deze systemen, ruim voordat ze worden ingezet.

Inclusieve automatische systemen creëren

Onze resultaten laten zien hoe ontwerpers van automatische categoriseringstechnologieën onbedoeld schade kunnen aanrichten door aannames te doen over de eenvoud en voorspelbaarheid van menselijke kenmerken. Ons onderzoek draagt bij aan een groeiend oeuvre dat probeert gender op een meer doordachte manier in technologie te integreren.

Minderheden zijn van oudsher weggelaten uit gesprekken over grootschalige technologie-inzet, inclusief etnische minderheden en mensen met een handicap. Nog, zowel wetenschappers als ontwerpers weten dat het meenemen van inbreng van minderheidsgroepen tijdens het ontwerpproces kan leiden tot technische innovaties waar alle mensen baat bij hebben. We pleiten voor een meer genderinclusieve en mensgerichte benadering van automatisering die verschillende perspectieven omvat.

Naarmate digitale technologieën zich ontwikkelen en volwassen worden, ze kunnen leiden tot indrukwekkende innovaties. Maar zoals mensen dat werk leiden, ze moeten vermijden om menselijke vooroordelen en vooroordelen die negatief en beperkend zijn, te versterken. In het geval van automatische geslachtsherkenning, we concluderen niet noodzakelijkerwijs dat deze algoritmen moeten worden opgegeven. Liever, ontwerpers van deze systemen moeten inclusief zijn, en gevoelig voor, de diversiteit en complexiteit van de menselijke identiteit.

Dit artikel is oorspronkelijk gepubliceerd op The Conversation. Lees het originele artikel.

Vrijgave van medicijnen uit een supramoleculaire kooi

Vrijgave van medicijnen uit een supramoleculaire kooi Nieuwe kristallijne ijsvorm:wetenschappers verhelderen kristalstructuur voor exotisch ijs XIX

Nieuwe kristallijne ijsvorm:wetenschappers verhelderen kristalstructuur voor exotisch ijs XIX Gekleurd borduurgaren op aanvraag bespaart tijd, geld en het milieu

Gekleurd borduurgaren op aanvraag bespaart tijd, geld en het milieu Leervervuiling verminderen met gesmolten zouten

Leervervuiling verminderen met gesmolten zouten Kwantumfysica en origami voor de ultieme beterschapskaart

Kwantumfysica en origami voor de ultieme beterschapskaart

NASA vindt ontwikkeling van tropische depressie 16W

NASA vindt ontwikkeling van tropische depressie 16W Ze hebben het bos voor altijd beheerd. Daarom zijn ze de sleutel tot de strijd tegen klimaatverandering

Ze hebben het bos voor altijd beheerd. Daarom zijn ze de sleutel tot de strijd tegen klimaatverandering De ontdekking van fantoomvulkanen geeft nieuwe hoop aan voor olie- en gasexploratie in de Noordzee

De ontdekking van fantoomvulkanen geeft nieuwe hoop aan voor olie- en gasexploratie in de Noordzee De overgang naar een koolstofarme economie moet inclusief zijn, zeggen onderzoekers

De overgang naar een koolstofarme economie moet inclusief zijn, zeggen onderzoekers Siberische regio vecht om permafrost te behouden terwijl planeet opwarmt

Siberische regio vecht om permafrost te behouden terwijl planeet opwarmt

Hoofdlijnen

- Inzicht in onze levensduur van meer dan 50 jaar die nog steeds in ontwikkeling is, genetische studie toont aan

- Mitzi en de gigantische haarbal

- Macht overdragen aan staten zal de bescherming van bedreigde diersoorten niet verbeteren

- Supercoiling duwt moleculaire handboeien langs chromatinevezels

- Paranoia zal vernietigen:wanneer overschrijdt gezonde angst de grens in paranoia?

- Beren hebben geen last van een dieet met veel verzadigde vetten

- Wie eet wie? Hoe klimaatverandering de interacties tussen vissen en roofdieren verandert

- Experts:broederij in Idaho die is gebouwd om zalm te redden doodt ze

- Ontwikkeling van een kweekset voor kunstmatige orchideeën

- Vooruitgang wijst de weg naar kleinere, veiliger batterijen

- Tornado-uitbraak herinnering om smartphones rampklaar te maken

- Headers met koppeltekens voor datamining:verbetering van de herkenning van entiteiten op naam

- Apple koopt abonnementsdienst voor digitale tijdschriften

- Verbetering van de verticale mobiliteit van de zesbenige robot RHex met behulp van microspines

Ethische code heeft geen invloed op beslissingen van softwareontwikkelaars

Ethische code heeft geen invloed op beslissingen van softwareontwikkelaars Ringresonatoren hoeklicht

Ringresonatoren hoeklicht Hoe de boog van St. Louis tegen alle verwachtingen in staat

Hoe de boog van St. Louis tegen alle verwachtingen in staat  Het tweaken van kwantumdots maakt dubbele beglazing op zonne-energie mogelijk

Het tweaken van kwantumdots maakt dubbele beglazing op zonne-energie mogelijk Kenmerken van pitloze vasculaire planten

Kenmerken van pitloze vasculaire planten Skelet van sabeltandtijger geveild

Skelet van sabeltandtijger geveild Kledingvoorschriften kunnen sociale ambities onthullen, politieke idealen, zegt geleerde

Kledingvoorschriften kunnen sociale ambities onthullen, politieke idealen, zegt geleerde Saguaro en andere torenhoge cactussen hebben een roerige geschiedenis

Saguaro en andere torenhoge cactussen hebben een roerige geschiedenis

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com