Wetenschap

YouTube zal eerder video's over verkiezingsfraude aanbevelen aan gebruikers die al sceptisch zijn over de legitimiteit van de verkiezingen van 2020

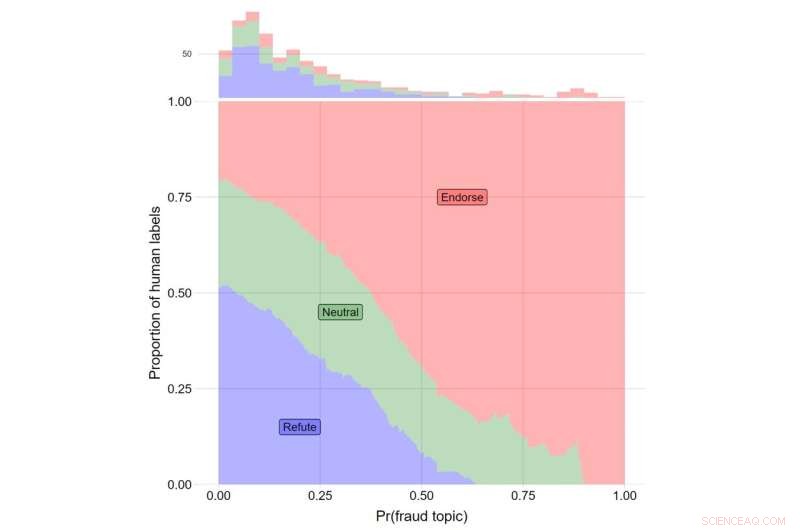

De y-as geeft het aandeel aan van menselijke labels voor video's die de beweringen van Trump weerleggen (in blauw), voor video's die neutraal rapporteren over de beweringen van Trump (groen) en voor video's die de beweringen van Trump onderschrijven (rood). De x-as geeft de θ-waarde aan voor onderwerp #108. Het totale aantal video's dat in elke categorie valt, wordt aangegeven met het histogram bovenaan de plot. Krediet:Journal of Online Trust and Safety (2022). https://doi.org/10.54501/jots.v1i3.60

YouTube zou eerder video's over verkiezingsfraude aanbevelen aan gebruikers die al sceptisch waren over de legitimiteit van de Amerikaanse presidentsverkiezingen van 2020, blijkt uit een nieuwe studie die de impact van de algoritmen van de site onderzoekt.

De resultaten van het onderzoek, dat is gepubliceerd in het Journal of Online Trust and Safety , toonde aan dat degenen die het meest sceptisch waren over de legitimiteit van de verkiezingen, drie keer zoveel video's met verkiezingsfraude te zien kregen als de minst sceptische deelnemers - ongeveer 8 aanvullende aanbevelingen van de ongeveer 400 video's die aan elke studiedeelnemer werden voorgesteld.

Hoewel de algemene prevalentie van dit soort video's laag was, leggen de bevindingen de gevolgen bloot van een aanbevelingssysteem dat gebruikers de inhoud biedt die ze willen. Voor degenen die zich het meest zorgen maken over mogelijke verkiezingsfraude, bood het tonen van gerelateerde inhoud een mechanisme waarmee verkeerde informatie, desinformatie en samenzweringen hun weg kunnen vinden naar degenen die ze het meest waarschijnlijk zullen geloven, observeer de auteurs van het onderzoek. Belangrijk is dat deze patronen de onafhankelijke invloed van het algoritme weerspiegelen op wat echte gebruikers te zien krijgen tijdens het gebruik van het platform.

"Onze bevindingen onthullen de nadelige gevolgen van aanbevelingsalgoritmen en doen twijfel rijzen over de opvatting dat online informatieomgevingen uitsluitend worden bepaald door de keuze van de gebruiker", zegt James Bisbee, die het onderzoek leidde als postdoctoraal onderzoeker aan het Center for Social Media and Politics van de New York University. (CSMaP).

Bijna twee jaar na de presidentsverkiezingen van 2020 geloven grote aantallen Amerikanen, vooral Republikeinen, niet in de legitimiteit van de uitkomst.

"Ongeveer 70% van de Republikeinen ziet Biden niet als de legitieme winnaar", ondanks "meerdere hertellingen en audits die de overwinning van Joe Biden bevestigden", schreef PolitiFact van het Poynter Institute eerder dit jaar.

Hoewel het bekend is dat sociale-mediaplatforms, zoals YouTube, inhoud naar gebruikers sturen op basis van hun zoekvoorkeuren, worden de gevolgen van deze dynamiek mogelijk niet volledig gerealiseerd.

In de CSMaP-studie namen de onderzoekers in november en december 2020 een steekproef van meer dan 300 Amerikanen met YouTube-accounts. De proefpersonen werd gevraagd hoe bezorgd ze waren over een aantal aspecten van verkiezingsfraude, waaronder het tellen van frauduleuze stembiljetten, het weggooien van geldige stembiljetten, buitenlandse regeringen die zich ermee bemoeien, en niet-Amerikaanse burgers die stemmen, naast andere vragen.

Deze deelnemers werd vervolgens gevraagd om een browserextensie te installeren die de lijst met aanbevelingen die ze te zien kregen, zou vastleggen. De proefpersonen kregen vervolgens de opdracht om op een willekeurig toegewezen YouTube-video (de "seed" -video) te klikken en vervolgens op een van de aanbevelingen te klikken die ze kregen volgens een willekeurig toegewezen "traversal rule". Gebruikers die zijn toegewezen aan de 'tweede doorloopregel' zouden bijvoorbeeld altijd op de tweede video moeten klikken in de lijst met weergegeven aanbevelingen, ongeacht de inhoud ervan. By restricting user behavior in these ways, the researchers were able to isolate the recommendation algorithm's influence on what real users were being suggested in real time.

The subjects then proceeded through a sequence of YouTube recommended videos, allowing the researchers to observe what the YouTube algorithm suggested to its users. Bisbee and his colleagues then compared the number of videos about election fraud in the 2020 U.S. presidential election that were recommended to participants who were more skeptical about the legitimacy of the election to those recommended to participants who were less skeptical. These results showed that election skeptics were recommended an average of eight additional videos about possible fraud in the 2020 US election, relative to non-skeptical participants (12 vs. 4).

"Many believe that automated recommendation algorithms have little influence on online 'echo chambers' in which users only see content that reaffirms their preexisting views," observes Bisbee, now an assistant professor at Vanderbilt University.

"Our study, however, suggests that YouTube's recommendation algorithm was able to determine which users were more likely to be concerned about fraud in the 2020 U.S. presidential election and then suggested up to three times as many videos about election fraud to these users compared to those less concerned about election fraud. This highlights the need for further investigation into how opaque recommendation algorithms operate on an issue-by-issue basis." + Verder verkennen

YouTube to remove misleading videos about the outcome of the U.S. presidential election

Onthulling van de regels achter de constructie van virussteigers

Onthulling van de regels achter de constructie van virussteigers Nieuwe ontdekking opent nieuwe weg voor productie met hoge titer van drop-in biobrandstoffen

Nieuwe ontdekking opent nieuwe weg voor productie met hoge titer van drop-in biobrandstoffen Vlakke en gebogen pyrrool-gefuseerde azacoronenen

Vlakke en gebogen pyrrool-gefuseerde azacoronenen Nieuwe methode keert de zelfassemblage van vloeibare kristallen om

Nieuwe methode keert de zelfassemblage van vloeibare kristallen om Fijne structuur onthuld van potentieel alternatief voor loodverbinding gebruikt in sensoren

Fijne structuur onthuld van potentieel alternatief voor loodverbinding gebruikt in sensoren

De karakteristieken van een Hurricane

De karakteristieken van een Hurricane Super vulkaanuitbarstingen onderbreken ozonherstel

Super vulkaanuitbarstingen onderbreken ozonherstel Congestieverminderende infrastructuur speelt een inhaalslag op lang verwaarloosde behoeften

Congestieverminderende infrastructuur speelt een inhaalslag op lang verwaarloosde behoeften Offshore-olieboringen in Florida komen mogelijk weer op tafel

Offshore-olieboringen in Florida komen mogelijk weer op tafel VN waarschuwt voor perfecte hongersnood klimaatverandering

VN waarschuwt voor perfecte hongersnood klimaatverandering

Hoofdlijnen

- Wat is een kruisverwijzingssysteem?

- Wetenschappers ontdekken dat schorpioenen zich richten op hun gif

- Celmodellen voor wetenschapsprojecten

- Darmbacteriën veroorzaken indirect symptomen door het microbioom van fruitvliegen te veranderen

- Onderzoek naar superstil gemaakte DNA hints naar nieuwe manieren om cellen te herprogrammeren

- Nieuwe studie verifieert meer manieren om te overleven voor bedreigde Chinook-zalm in de winter

- Mensen gebruiken niet zoveel denkkracht als we graag denken

- Uitbreiding tonijnquota stap achteruit voor instandhouding

- Sterke gastheren helpen parasieten zich verder te verspreiden

- Studie:Prehistorische paarden waren huislichamen

- Waarom is het lawaai van de menigte belangrijk?

- Onderzoekers ontdekken dat bosbranden in Californië de meningsverschillen over klimaatveranderingsstrategieën doen krimpen

- COVID-19 in het toerisme:antropologisch inzicht in de banalisering van dood en leven

- Wat als je in een lift zat en de kabel brak?

Te midden van spanningen in de Nijldam, Egypte roept Aswan 50 jaar later terug

Te midden van spanningen in de Nijldam, Egypte roept Aswan 50 jaar later terug Ride-share-bedrijven omarmen verkiezingswaanzin

Ride-share-bedrijven omarmen verkiezingswaanzin Vrouwen in gesimuleerde ruimtemissies demonstreren duurzamer leiderschap

Vrouwen in gesimuleerde ruimtemissies demonstreren duurzamer leiderschap Door de mens gemaakt universum binnenkort beschikbaar?

Door de mens gemaakt universum binnenkort beschikbaar?  Jonge reuzenplaneet biedt aanwijzingen voor de vorming van exotische werelden

Jonge reuzenplaneet biedt aanwijzingen voor de vorming van exotische werelden Hoeveel protonen heeft calcium?

Hoeveel protonen heeft calcium?  Weer een kortzichtige aanval op de planning?

Weer een kortzichtige aanval op de planning? Kleine lichtgevende sondes geven onderzoekers een betere optie voor niet-invasieve beeldvorming van levend weefsel

Kleine lichtgevende sondes geven onderzoekers een betere optie voor niet-invasieve beeldvorming van levend weefsel

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com