Wetenschap

Nieuw klimaatmodel dat vanaf de grond moet worden opgebouwd

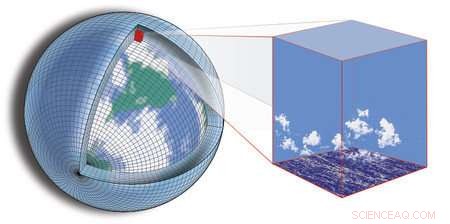

De huidige klimaatmodellering is gebaseerd op het verdelen van de wereld in een raster en vervolgens berekenen wat er in elke sector van het raster gebeurt, en hoe de sectoren met elkaar omgaan. Krediet:Tapio Schneider/Kyle Pressel/Momme Hell/Caltech

Geconfronteerd met de zekerheid van een veranderend klimaat in combinatie met de onzekerheid die blijft bestaan in voorspellingen over hoe het zal veranderen, wetenschappers en ingenieurs uit het hele land werken samen om een nieuw type klimaatmodel te bouwen dat is ontworpen om nauwkeurigere en bruikbare voorspellingen te doen.

Door gebruik te maken van recente ontwikkelingen in de computationele en datawetenschappen, de alomvattende inspanning kapitaliseert op enorme hoeveelheden gegevens die nu beschikbaar zijn en op steeds krachtigere computermogelijkheden, zowel voor het verwerken van gegevens als voor het simuleren van het aardsysteem.

Het nieuwe model zal worden gebouwd door een consortium van onderzoekers onder leiding van Caltech, in samenwerking met MIT; de Naval Postgraduate School (NPS); en JPL, die Caltech voor NASA beheert. het consortium, genaamd de Climate Modeling Alliance (CliMA), plannen om aardobservaties en simulaties met hoge resolutie samen te smelten tot een model dat belangrijke kleinschalige kenmerken vertegenwoordigt, zoals wolken en turbulentie, betrouwbaarder dan bestaande klimaatmodellen. Het doel is een klimaatmodel dat toekomstige veranderingen in kritieke variabelen zoals bewolking, regenval, en zee-ijs nauwkeuriger - met onzekerheden die minstens twee keer kleiner zijn dan bestaande modellen.

"Projecties met huidige klimaatmodellen, bijvoorbeeld van hoe kenmerken zoals extreme regenval zullen veranderen - hebben nog steeds grote onzekerheden, en de onzekerheden zijn slecht gekwantificeerd, " zegt Tapio Schneider, Caltech's Theodore Y. Wu hoogleraar milieuwetenschappen en techniek, senior onderzoeker bij JPL, en hoofdonderzoeker van CliMA. "Voor steden die hun infrastructuur voor regenwaterbeheer plannen om de komende 100 jaar aan overstromingen te weerstaan, dit is een serieus probleem; concrete antwoorden over het waarschijnlijke bereik van klimaatresultaten zijn essentieel voor planning."

Het consortium zal opereren in een snel, start-up-achtige sfeer, en hoopt het nieuwe model binnen de komende vijf jaar operationeel te hebben - een agressieve tijdlijn voor het bouwen van een klimaatmodel dat in wezen helemaal opnieuw is.

"Een nieuwe start geeft ons de mogelijkheid om het model vanaf het begin zo te ontwerpen dat het effectief kan draaien op moderne en snel evoluerende computerhardware. en dat de atmosferische en oceaanmodellen nauwe neven van elkaar zijn, dezelfde numerieke algoritmen delen, " zegt Frank Giraldo, hoogleraar toegepaste wiskunde aan de NPS.

De huidige klimaatmodellering is gebaseerd op het opdelen van de wereld in een raster en vervolgens berekenen wat er in elke sector van het raster gebeurt, en hoe de sectoren met elkaar omgaan. De nauwkeurigheid van een bepaald model hangt gedeeltelijk af van de resolutie waarmee het model de aarde kan bekijken, dat wil zeggen, de grootte van de sectoren van het net. Beperkingen in de beschikbare rekenkracht van computers zorgen ervoor dat die sectoren doorgaans niet kleiner kunnen zijn dan tientallen kilometers per zijde. Maar voor klimaatmodellering de duivel zit in de details - details die worden gemist in een te groot raster.

Bijvoorbeeld, laaggelegen wolken hebben een aanzienlijke impact op het klimaat door zonlicht te weerkaatsen, maar de turbulente pluimen die ze ondersteunen zijn zo klein dat ze door de scheuren van bestaande modellen vallen. evenzo, veranderingen in het Arctische zee-ijs zijn in verband gebracht met brede effecten op alles, van het poolklimaat tot droogte in Californië, maar het is moeilijk te voorspellen hoe dat ijs in de toekomst zal veranderen, omdat het gevoelig is voor de dichtheid van de bewolking boven het ijs en de temperatuur van de oceaanstromingen eronder, die beide niet kunnen worden opgelost door de huidige modellen.

Om de grootschalige impact van deze kleinschalige functies vast te leggen, het team zal simulaties met hoge resolutie ontwikkelen die de functies in geselecteerde regio's van de wereld in detail modelleren. Die simulaties worden genest binnen het grotere klimaatmodel. Het effect is een model dat kan "inzoomen" op geselecteerde regio's, het verstrekken van gedetailleerde lokale klimaatinformatie over die gebieden en het informeren van de modellering van kleinschalige processen overal elders.

"De oceaan neemt veel van de warmte en koolstof op die zich in het klimaatsysteem ophopen. hoeveel het in beslag neemt, hangt af van turbulente wervelingen in de bovenste oceaan, die te klein zijn om in klimaatmodellen op te lossen, " zegt Raffaele Ferrari, Cecil en Ida Green hoogleraar oceanografie aan het MIT. "Het samensmelten van geneste simulaties met hoge resolutie met nieuw beschikbare metingen van, bijvoorbeeld, een vloot van duizenden autonome drijvers kan een sprong in de nauwkeurigheid van oceaanvoorspellingen mogelijk maken."

Terwijl bestaande modellen vaak worden getest door voorspellingen te toetsen aan waarnemingen, het nieuwe model gaat een stap verder met de grondwaarheid door gebruik te maken van tools voor gegevensassimilatie en machine learning om het model te "leren" zichzelf in realtime te verbeteren, gebruikmakend van zowel aardobservaties als de geneste simulaties met hoge resolutie.

"Het succes van computationele weersvoorspellingen toont de kracht aan van het gebruik van gegevens om de nauwkeurigheid van computermodellen te verbeteren; we streven ernaar hetzelfde succes te brengen bij klimaatvoorspelling, " zegt Andrew Stuart, Caltech's Bren hoogleraar informatica en wiskundige wetenschappen.

Elk van de partnerinstellingen brengt een andere sterkte en onderzoeksexpertise in het project. Bij Caltech, Schneider en Stuart zullen zich richten op het creëren van de data-assimilatie en machine-learning algoritmen, evenals modellen voor wolken, turbulentie, en andere sfeerkenmerken. Bij het MIT, Ferrari en John Marshall, ook een Cecil en Ida Green hoogleraar oceanografie, zal een team leiden dat de oceaan zal modelleren, inclusief de grootschalige circulatie en turbulente menging. Bij NPS, Giraldo zal in samenwerking met Jeremy Kozdon en Lucas Wilcox de ontwikkeling van de computationele kern van het nieuwe atmosfeermodel leiden. Bij JPL, een groep wetenschappers zal samenwerken met het team op de campus van Caltech om procesmodellen voor de atmosfeer te ontwikkelen, biosfeer, en cryosfeer.

structurele kleuren, zonder de glans

structurele kleuren, zonder de glans Magneten gebruiken om chemische reacties te beheersen die gericht zijn op de afgifte van medicijnen in het lichaam

Magneten gebruiken om chemische reacties te beheersen die gericht zijn op de afgifte van medicijnen in het lichaam Wetenschapsexperimenten met betrekking tot de osmose van een aardappel

Wetenschapsexperimenten met betrekking tot de osmose van een aardappel Wat zijn de twee manieren om enzymactiviteit te remmen?

Wat zijn de twee manieren om enzymactiviteit te remmen?  Hoe het aantal atomen te berekenen gezien de massa's van gram en atoom

Hoe het aantal atomen te berekenen gezien de massa's van gram en atoom

Studie schat meer dan 100, 000 gevallen van kanker kunnen het gevolg zijn van verontreinigingen in leidingwater

Studie schat meer dan 100, 000 gevallen van kanker kunnen het gevolg zijn van verontreinigingen in leidingwater Klimaatdoelen moeten worden gesteld op het opwarmingspotentieel en niet op de emissies

Klimaatdoelen moeten worden gesteld op het opwarmingspotentieel en niet op de emissies 5 manieren om uw kinderen te leren over waterbehoud

5 manieren om uw kinderen te leren over waterbehoud  Antarctica vergroent door klimaatverandering

Antarctica vergroent door klimaatverandering Veel aanrijdingen tussen dieren en voertuigen te voorkomen

Veel aanrijdingen tussen dieren en voertuigen te voorkomen

Hoofdlijnen

- Mitochondria-afweer van dieren ontdekt in planten

- Wat zijn lobben in een kern?

- De cyanideverdediging:hoe één bacterie roofdieren remt met gif

- Veel dierenartsen praten niet graag over dikke katten

- Hoe beïnvloedt DNA-replicatie je lichaam?

- Verschillen en overeenkomsten tussen eencellig en cellulair

- Levenslange bloedproductie is afhankelijk van honderden cellen die zich vóór de geboorte vormen

- Wat is een kruisverwijzingssysteem?

- Is het kennen van je volledige genoom een recht of een voorrecht?

- Vergelijking van continentale hydrologische modellen helpt het waterbeheer te verbeteren

- Waarom een emissiedaling van 17% niet betekent dat we klimaatverandering aanpakken

- Saint-Tropez ruimt op na olieramp in Middellandse Zee

- Klimaatcrisis:de hoop op een grens van 1,5°C levend houden is van vitaal belang om wereldwijde actie aan te zwengelen

- De effecten van tyfoons

Kijken naar licht dat een model fotokatalysator bijna in realtime afbreekt

Kijken naar licht dat een model fotokatalysator bijna in realtime afbreekt Daimler gevraagd om honderdduizenden dieselvoertuigen terug te roepen

Daimler gevraagd om honderdduizenden dieselvoertuigen terug te roepen Karakterisering van zonnecellen met precisie op nanoschaal

Karakterisering van zonnecellen met precisie op nanoschaal Bewijs dat nanodeeltjes in zonnebrandmiddelen giftig kunnen zijn als ze per ongeluk worden gegeten

Bewijs dat nanodeeltjes in zonnebrandmiddelen giftig kunnen zijn als ze per ongeluk worden gegeten Terug in het spel:SpaceX-schip schiet weg met 2 astronauten (update)

Terug in het spel:SpaceX-schip schiet weg met 2 astronauten (update) Een nieuwe stap naar het gebruik van grafeen in elektronische toepassingen

Een nieuwe stap naar het gebruik van grafeen in elektronische toepassingen Een nieuwe manier om kosmische zwarte gaten te meten

Een nieuwe manier om kosmische zwarte gaten te meten Hoe een hondenhok voor een grote hond te bouwen

Hoe een hondenhok voor een grote hond te bouwen

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | German | Dutch | Danish | Norway | Swedish |

-

Wetenschap © https://nl.scienceaq.com