Wetenschap

Hebben AI-systemen echt hun eigen geheime taal?

Krediet:Giannis Daras / DALL-E

Een nieuwe generatie modellen voor kunstmatige intelligentie (AI) kan on-demand "creatieve" afbeeldingen produceren op basis van een tekstprompt. Mensen als Imagen, MidJourney en DALL-E 2 beginnen de manier te veranderen waarop creatieve inhoud wordt gemaakt, met gevolgen voor auteursrechten en intellectueel eigendom.

Hoewel de output van deze modellen vaak opvallend is, is het moeilijk om precies te weten hoe ze hun resultaten produceren. Vorige week maakten onderzoekers in de VS de intrigerende bewering dat het DALL-E 2-model zijn eigen geheime taal zou hebben uitgevonden om over objecten te praten.

Door DALL-E 2 te vragen afbeeldingen met tekstbijschriften te maken en de resulterende (brabbeltaal) bijschriften vervolgens terug in het systeem te voeren, concludeerden de onderzoekers dat DALL-E 2 denkt dat Vicootes "groenten" betekent, terwijl Wa ch zod rea verwijst naar "zeedieren die een walvis zou kunnen eten".

Deze beweringen zijn fascinerend, en als ze waar zijn, kunnen ze belangrijke implicaties hebben voor de beveiliging en interpretatie van dit soort grote AI-modellen. Dus wat is er precies aan de hand?

Heeft DALL-E 2 een geheime taal?

DALL-E 2 heeft waarschijnlijk geen "geheime taal". Het is misschien nauwkeuriger om te zeggen dat het zijn eigen vocabulaire heeft, maar zelfs dan weten we het niet zeker.

Allereerst is het in dit stadium erg moeilijk om claims over DALL-E 2 en andere grote AI-modellen te verifiëren, omdat slechts een handvol onderzoekers en creatieve beoefenaars er toegang toe hebben. Alle afbeeldingen die openbaar worden gedeeld (bijvoorbeeld op Twitter) moeten met een vrij grote korrel zout worden genomen, omdat ze door een mens zijn "geplukt" uit vele uitvoerafbeeldingen die door de AI zijn gegenereerd.

Zelfs degenen met toegang kunnen deze modellen slechts op beperkte manieren gebruiken. DALL-E 2-gebruikers kunnen bijvoorbeeld wel afbeeldingen genereren of wijzigen, maar kunnen (nog) niet dieper met het AI-systeem communiceren, bijvoorbeeld door de code achter de schermen aan te passen. Dit betekent dat 'verklaarbare AI'-methoden om te begrijpen hoe deze systemen werken niet kunnen worden toegepast, en het systematisch onderzoeken van hun gedrag is een uitdaging.

Wat is er dan aan de hand?

Een mogelijkheid is dat de "brabbeltaal"-zinnen gerelateerd zijn aan woorden uit niet-Engelse talen. Zo lijkt Apoploe, dat afbeeldingen van vogels lijkt te creëren, op de Latijnse Apodidae, de binominale naam van een familie van vogelsoorten.

Dit lijkt een plausibele verklaring. DALL-E 2 is bijvoorbeeld getraind op een zeer grote verscheidenheid aan gegevens die van internet zijn geschraapt, waaronder veel niet-Engelse woorden.

Soortgelijke dingen zijn eerder gebeurd:grote natuurlijke taal AI-modellen hebben toevallig geleerd computercode te schrijven zonder opzettelijke training.

Gaat het allemaal om de tokens?

Een punt dat deze theorie ondersteunt, is het feit dat AI-taalmodellen tekst niet lezen zoals jij en ik. In plaats daarvan splitsen ze invoertekst op in "tokens" voordat ze deze verwerken.

Verschillende "tokenization"-benaderingen hebben verschillende resultaten. Elk woord als een token behandelen lijkt een intuïtieve benadering, maar veroorzaakt problemen wanneer identieke tokens verschillende betekenissen hebben (zoals hoe "match" verschillende dingen betekent wanneer u tennis speelt en wanneer u een vuur maakt).

Aan de andere kant levert het behandelen van elk karakter als een token een kleiner aantal mogelijke tokens op, maar elk geeft veel minder betekenisvolle informatie.

DALL-E 2 (en andere modellen) gebruiken een tussenbenadering die byte-pair-codering (BPE) wordt genoemd. Het inspecteren van de BPE-representaties voor enkele van de wartaalwoorden suggereert dat dit een belangrijke factor zou kunnen zijn bij het begrijpen van de "geheime taal".

Niet het hele plaatje

De "geheime taal" zou ook gewoon een voorbeeld kunnen zijn van het "garbage in, garbage out"-principe. DALL-E 2 kan niet zeggen "Ik weet niet waar je het over hebt", dus het genereert altijd een soort afbeelding van de gegeven invoertekst.

Hoe dan ook, geen van deze opties is een volledige uitleg van wat er gebeurt. Het verwijderen van individuele tekens uit wartaalwoorden lijkt bijvoorbeeld de gegenereerde afbeeldingen op zeer specifieke manieren te corrumperen. En het lijkt erop dat individuele wartaalwoorden niet noodzakelijkerwijs samengaan om coherente samengestelde beelden te produceren (zoals ze zouden doen als er echt een geheime 'taal' onder de dekens zou zijn).

Waarom dit belangrijk is

Naast intellectuele nieuwsgierigheid, vraag je je misschien af of dit echt belangrijk is.

Het antwoord is ja. De "geheime taal" van DALL-E is een voorbeeld van een "tegenaanval" op een machine learning-systeem:een manier om het beoogde gedrag van het systeem te doorbreken door opzettelijk inputs te kiezen die de AI niet goed aankan.

Een reden waarom vijandige aanvallen zorgwekkend zijn, is dat ze ons vertrouwen in het model op de proef stellen. Als de AI wartaal op onbedoelde manieren interpreteert, kan het ook betekenisvolle woorden op onbedoelde manieren interpreteren.

Tegengestelde aanvallen roepen ook veiligheidsproblemen op. DALL-E 2 filtert invoertekst om te voorkomen dat gebruikers schadelijke of beledigende inhoud genereren, maar een "geheime taal" van wartaalwoorden kan gebruikers in staat stellen deze filters te omzeilen.

Recent onderzoek heeft tegenstrijdige "trigger-frases" ontdekt voor sommige AI-modellen in taal - korte nonsenszinnen zoals "zoning tapping fiennes" die de modellen op betrouwbare wijze kunnen activeren om racistische, schadelijke of bevooroordeelde inhoud uit te spuien. Dit onderzoek maakt deel uit van de voortdurende inspanningen om te begrijpen en te controleren hoe complexe deep learning-systemen leren van gegevens.

Ten slotte doen fenomenen zoals de "geheime taal" van DALL-E 2 problemen met de interpreteerbaarheid rijzen. We willen dat deze modellen zich gedragen zoals een mens verwacht, maar het zien van gestructureerde output als reactie op wartaal vertroebelt onze verwachtingen.

Een licht schijnen op bestaande zorgen

Je herinnert je misschien het gedoe in 2017 over enkele Facebook-chatbots die "hun eigen taal uitvonden". De huidige situatie is vergelijkbaar in die zin dat de resultaten zorgwekkend zijn, maar niet in de zin van "Skynet komt de wereld over te nemen".

In plaats daarvan benadrukt de "geheime taal" van DALL-E 2 bestaande zorgen over de robuustheid, veiligheid en interpreteerbaarheid van deep learning-systemen.

Totdat deze systemen op grotere schaal beschikbaar zijn - en in het bijzonder, totdat gebruikers met een bredere set niet-Engelse culturele achtergronden ze kunnen gebruiken - zullen we niet echt weten wat er aan de hand is.

Als je in de tussentijd echter wilt proberen wat van je eigen AI-afbeeldingen te genereren, kun je een vrij verkrijgbaar kleiner model bekijken, DALL-E mini. Wees voorzichtig met de woorden die u gebruikt om het model te vragen (Engels of brabbeltaal - uw oproep).

Materiaalwetenschappers laten zien hoe duurzame kunstpezen kunnen worden gemaakt van verbeterde hydrogels

Materiaalwetenschappers laten zien hoe duurzame kunstpezen kunnen worden gemaakt van verbeterde hydrogels Stabiele en functionele kleurstoffen voor nabij-infrarood fluorescentiebeeldvorming van levende onderwerpen

Stabiele en functionele kleurstoffen voor nabij-infrarood fluorescentiebeeldvorming van levende onderwerpen Verschillende manieren om ijsblokjes te smelten

Verschillende manieren om ijsblokjes te smelten 3D-printen elimineert ongewenste eigenschappen in conventionele superlegeringen

3D-printen elimineert ongewenste eigenschappen in conventionele superlegeringen Vooruitgang in de richting van een nieuwe griepbehandeling, dankzij een kleine aanpassing

Vooruitgang in de richting van een nieuwe griepbehandeling, dankzij een kleine aanpassing

Geowetenschappers roepen op tot actie om raciale ongelijkheid in het veld aan te pakken

Geowetenschappers roepen op tot actie om raciale ongelijkheid in het veld aan te pakken Puerto Rico, Maagdeneilanden zetten zich schrap voor orkaan Maria

Puerto Rico, Maagdeneilanden zetten zich schrap voor orkaan Maria Ingenieurs creëren besluitvormingstool voor het opruimen van olievlekken

Ingenieurs creëren besluitvormingstool voor het opruimen van olievlekken Grondwaterpompen kunnen riviersystemen verwoesten

Grondwaterpompen kunnen riviersystemen verwoesten Plantenleven in het naaldbos

Plantenleven in het naaldbos

Hoofdlijnen

- Bereidheid om risico's te nemen - een persoonlijkheidskenmerk

- 10 slechtste aanpassingen in het dierenrijk

- Röntgenfoto's van het skelet van Dolly vertonen geen tekenen van abnormale artrose

- Voordelen van embryonale stamcelonderzoek

- Video van vier bobcats in een buitenwijk toont gezonde populatie

- Teams van sperma zwemmen soepeler tegen de stroom in

- Worden je hersenen moe zoals de rest van je lichaam?

- Nieuwe CRISPR-tool richt zich op RNA in zoogdiercellen

- Hoe het eerste katachtige sabeltandroofdier werd ontdekt en waarom het verschilt van moderne katten

- Groepen roepen burgemeester van Chicago op om het gebruik van gezichtsherkenningstechnologie in steden te verbieden

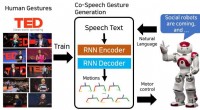

- End-to-end leren van het genereren van co-spraakgebaren voor humanoïde robots

- Robots kunnen toekomstige boerderijen runnen, onderzoekers zeggen:

- Onderzoekers gebruiken machine learning om filmvoorkeuren te analyseren

- Big Tech overdrijft AI als de oplossing voor online extremisme

Maple Vs. Eiken hout

Maple Vs. Eiken hout  Natuurkundigen leggen verband tussen symmetrie en Mott-fysica

Natuurkundigen leggen verband tussen symmetrie en Mott-fysica Onderzoek onthult nieuwe onkruidbestrijdingsopties voor aardbeientelers

Onderzoek onthult nieuwe onkruidbestrijdingsopties voor aardbeientelers Schoolkinderen hebben te veel telefoontijd, niet genoeg speeltijd

Schoolkinderen hebben te veel telefoontijd, niet genoeg speeltijd VK besluit volgende week over Huawei 5G

VK besluit volgende week over Huawei 5G Hoe u de groei van het opladen van elektrische auto's kunt voorspellen en beheren om elektriciteitsnetwerken betrouwbaar en betaalbaar te houden

Hoe u de groei van het opladen van elektrische auto's kunt voorspellen en beheren om elektriciteitsnetwerken betrouwbaar en betaalbaar te houden Herbruikbare katalysator maakt oxidatie van C–H-bindingen met zuurstof eenvoudiger en efficiënter

Herbruikbare katalysator maakt oxidatie van C–H-bindingen met zuurstof eenvoudiger en efficiënter Europa verkennen mogelijk met silicium-germanium-transistortechnologie

Europa verkennen mogelijk met silicium-germanium-transistortechnologie

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com