Wetenschap

Leren diepe perceptuele hashing te doorbreken

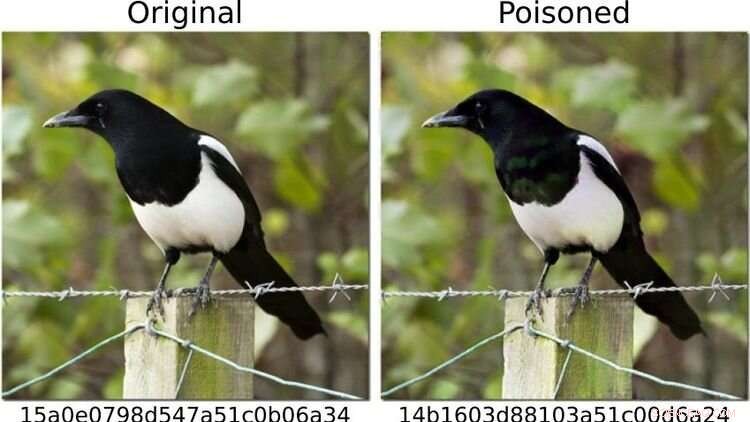

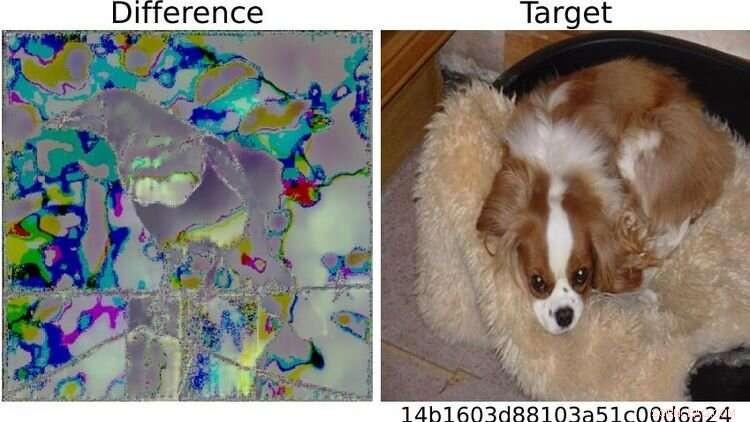

Om het systeem op de proef te stellen, definieerden de onderzoekers afbeeldingen van honden als "gevaarlijk" en veranderden ze andere fotomotieven - zoals die van de links afgebeelde ekster - zodat (net als rechts) de vingerafdruk overeenkwam met die van een hond beeld. Voor het menselijk oog zien beide foto's er identiek uit. Krediet:https://arxiv.org/abs/2111.06628

Kunnen methoden voor kunstmatige intelligentie (AI) op betrouwbare wijze kinderpornografische afbeeldingen op eindapparaten detecteren?

Een onderzoek waarbij de Oldenburger informaticus Daniel Neider betrokken was, roept twijfels op of dit op dit moment mogelijk is. Het onderzoek is gepubliceerd in Proceedings of the 2022 ACM Conference on Fairness, Accountability, and Transparency .

Hier bespreekt Neider zijn bevindingen:

Dhr. Neider, heb je een virusscanner op je computer?

Ik denk dat elke Windows-computer wordt geleverd met een antivirusprogramma, dus ja.

Apple installeerde vorig jaar zijn NeuralHash-programma, dat beeldbestanden automatisch scant op kinderpornografie, op eindapparaten. Werkt het op dezelfde manier als een antivirusprogramma?

NeuralHash doet iets soortgelijks, hoewel de manier waarop het werkt anders is:de software scant eindapparaten op een specifiek type inhoud - niet, zoals bij antivirusprogramma's, op malware, maar op illegale afbeeldingen. Dit staat bekend als scannen aan de clientzijde, wat verwijst naar het scannen van bestanden op het apparaat van de gebruiker.

Hoe werkt NeuralHash precies?

Het programma is gebaseerd op kunstmatige intelligentiemethoden en maakt gebruik van zogenaamde neurale netwerken. Simpel gezegd, het is een computerprogramma dat is getraind om bepaalde patronen in afbeeldingen te herkennen. Het programma kent aan elke afbeelding een soort code toe, in feite een reeks cijfers en letters. Deze codes worden hashes genoemd. Je kunt ze voorstellen als vingerafdrukken die voor elke afbeelding worden gegenereerd. De truc is dat afbeeldingen die er hetzelfde uitzien, dezelfde hash krijgen, dus alle afbeeldingen met zwarte katten kunnen bijvoorbeeld de hash 3x580ac97e krijgen. Apple heeft een grote database van dergelijke hashes, die kunnen worden toegewezen aan afbeeldingen van kinderpornografie. En wanneer een gebruiker een afbeelding probeert te uploaden met een hash die in de database staat, wordt de afbeelding gemarkeerd zonder dat de gebruiker het merkt. Dergelijke afbeeldingen kunnen niet worden doorgestuurd.

Betekent dit dat Apple weet welke afbeeldingen op mijn mobiele telefoon staan?

Nee, Apple kijkt niet naar de afbeeldingen. Het heeft alleen de database met de codes. Het idee is dat het bedrijf samenwerkt met kinderbeschermingsorganisaties. En op basis van materiaal dat afkomstig is van wetshandhavingsinstanties, gebruiken deze organisaties een programma om hashes voor de database te genereren.

U analyseerde NeuralHash in een onderzoeksproject met collega's van de Technische Universiteit van Darmstadt. Hoe is het project tot stand gekomen?

Neurale netwerken werken niet altijd zoals we denken dat ze werken. De technologie is veelbelovend, maar niet altijd honderd procent nauwkeurig. Het is vaak moeilijk te achterhalen waarom het een bepaald resultaat oplevert, omdat de procedure niet expliciet is geprogrammeerd. Deze technologie heeft in principe simpelweg bepaalde patronen in de data leren herkennen. Dit kan echter ook worden misbruikt om het programma te misleiden - en het werkt alarmerend vaak. Dus vroegen we ons af:wat betekent dit voor een systeem dat bedoeld is om illegale inhoud te beoordelen? Wat gebeurt er als je bijvoorbeeld afbeeldingen iets aanpast?

Waarom heb je je op NeuralHash gefocust?

In 2021 leverde Apple een prototype van NeuralHash samen met een update van het besturingssysteem voor eindapparaten - eigenlijk alle apparaten die foto's naar de iCloud-cloudopslagservice kunnen sturen, zoals iPhones of Macs. Het prototype was nog niet geactiveerd, dus het programma begon niet met het controleren van afbeeldingen op de Apple-apparaten. Maar deze stap maakte de technologie voor ons beschikbaar; we waren in staat om het programma te extraheren en zo toegang te krijgen tot het neurale netwerk. We wilden eens kijken hoe een groot bedrijf zo'n taak zou aanpakken. Apple zag er later van af NeuralHash officieel uit te rollen vanwege massale kritiek op het massale toezicht en de inbreuk op de privacy die het met zich meebracht.

Wat heb je precies getest?

We hebben getest hoe het systeem misbruikt kan worden. Om niet met kinderpornografisch materiaal te hoeven werken, hebben we afbeeldingen van honden als "gevaarlijk" gedefinieerd. Vervolgens hebben we hun "digitale vingerafdrukken" berekend. In het eerste scenario namen we foto's van andere dingen, bijvoorbeeld van een kat, en probeerden we deze enigszins aan te passen, zodat het resultaat een "vingerafdruk" van een hond was.

Is het gelukt?

Ja, en het bleek relatief eenvoudig te zijn. Je hebt toegang nodig tot het neurale netwerk - dat we hadden omdat het programma op de apparaten was geïnstalleerd - en je hebt enige kennis nodig van hoe machine learning werkt. Maar dan is het vrij eenvoudig om de kattenafbeeldingen te wijzigen zodat ze andere hash genereren. Voor het menselijk oog lijken de gemanipuleerde foto's bijna op het origineel, je kunt het verschil niet echt zien.

Aan de rechterkant is de afbeelding van de hond op testbasis als "gevaarlijk" gedefinieerd. Vanwege de zichtbare verschillen tussen de twee eksterbeelden aan de linkerkant, sloeg het systeem alarm voor de foto die op deze manier was gewijzigd. Iedereen die bekend is met machine learning kan dus "relatief gemakkelijk" trucjes uithalen met het systeem, zegt Neider. Krediet:https://arxiv.org/abs/2111.06628

En dat is wanneer dingen problematisch worden...

Rechts. Omdat ik je een gemanipuleerde foto zou kunnen sturen, en op het moment dat je deze probeert te uploaden naar je cloud of naar iemand anders stuurt via een berichten-app, wordt het systeem geactiveerd zonder dat je het merkt. Je weet niet eens waarom de upload- of doorstuurfunctie is geblokkeerd. Maar het echte probleem is dat Apple ook merkt dat je geprobeerd hebt een verdachte afbeelding te verzenden. En als dit te vaak gebeurt, decodeert Apple het materiaal en meldt het, indien nodig, aan de lokale wetshandhavingsinstanties. Dit betekent dat er materiaal op iemand kan worden geplant om hem te beschuldigen.

Wat heb je nog meer getest?

We stelden ook de tegenovergestelde vraag:kan ik het systeem omzeilen? Kan ik een afbeelding met een vingerafdruk in de database zodanig manipuleren dat er een andere vingerafdruk ontstaat? In één scenario gingen we er opnieuw van uit dat de gebruiker via zijn apparaat toegang heeft tot de AI, bekend is met het neurale netwerk en enige kennis heeft van machine learning.

En kunnen de afbeeldingen worden gemanipuleerd zodat ze er niet verdacht uitzien?

Ja, het werkt heel goed. Maar wat we ook ontdekten is dat zelfs als je geen toegang hebt tot het systeem en heel eenvoudige wijzigingen aanbrengt in een foto die iedereen kan maken met hun mobiele telefoon, het mogelijk is om het programma te misleiden. Door bijvoorbeeld een afbeelding eenvoudig 90 graden te draaien, kunt u de "vingerafdruk" aanzienlijk wijzigen. Dit is natuurlijk niet goed, want je kunt deze wijziging ongedaan maken door de afbeelding 90 graden in de andere richting te draaien. De volledige informatie in de afbeelding blijft behouden. This shows that it's relatively easy to trick the system.

What conclusions do you draw from the study?

In my view, we don't know enough about neural networks at the moment to be able to use them safely. These programs are not robust enough for such sensitive tasks—as we saw in this case study. Moreover, in my opinion, the legislators should not rely on programs developed by corporations like Apple or Facebook in response to a law to do the right thing. For example, there is the danger that these companies will block more content than necessary, as a pre-emptive measure, so to speak, to avoid getting into trouble and having to pay high fines. Something similar is already happening in reaction to the Network Enforcement Law (also known as the Facebook Act).

So should we not use technology to automatically prevent the uploading of indexed images?

On the contrary, my colleagues and I are also in favor of using technology to combat child pornography. But we think it's important that there is a public discourse about what image recognition using neural networks can do, what it can't do, and what we are prepared to accept as collateral damage. From our point of view, it's always a matter of weighing up the pros and cons:if it's so easy to trick a program, is it really justifiable to install it on everyone's devices? After all, there is a risk of false alarms. At the same time, anyone who wants to can bypass the system relatively easily. So doesn't it actually do more harm than good? Of course, it's not up to us computer scientists to make the decisions here. Our contribution is to point out the problems with the technology so that a meaningful discussion can take place on that basis. + Verder verkennen

Apple can scan your photos for child abuse and still protect your privacy

Activering met zichtbaar licht maakt transformatie van stabiele sulfonen naar waardevolle glycosiden mogelijk

Activering met zichtbaar licht maakt transformatie van stabiele sulfonen naar waardevolle glycosiden mogelijk Onderzoekers verkrijgen nieuwe resultaten over het corrosiegedrag van legeringsmaterialen onder extreme omgevingen

Onderzoekers verkrijgen nieuwe resultaten over het corrosiegedrag van legeringsmaterialen onder extreme omgevingen Onderzoekers bestuderen aanwezigheid van gefluoreerde chemicaliën in brandweerkleding

Onderzoekers bestuderen aanwezigheid van gefluoreerde chemicaliën in brandweerkleding Wat planten ons kunnen leren over het opruimen van olievlekken en microfluïdica

Wat planten ons kunnen leren over het opruimen van olievlekken en microfluïdica Voor zeer actieve duurzame katalysatoren, voeg gewoon fosfor toe

Voor zeer actieve duurzame katalysatoren, voeg gewoon fosfor toe

Vergelijkingen van biologische en conventionele landbouw moeten worden verbeterd, zeggen onderzoekers

Vergelijkingen van biologische en conventionele landbouw moeten worden verbeterd, zeggen onderzoekers Nieuw bewijs toont aan dat beplanting rond schoolpleinen kinderen beschermt tegen luchtvervuiling

Nieuw bewijs toont aan dat beplanting rond schoolpleinen kinderen beschermt tegen luchtvervuiling Planeet dreigt nu richting broeikas-aarde te gaan

Planeet dreigt nu richting broeikas-aarde te gaan Antarctisch Schiereiland warmt op door hitte in Tasmanzee

Antarctisch Schiereiland warmt op door hitte in Tasmanzee Dode zones in het meer kunnen vissen doden en drinkwater vergiftigen

Dode zones in het meer kunnen vissen doden en drinkwater vergiftigen

Hoofdlijnen

- Een vogel in de bush is $223 waard, 851 in de hand

- Welke moleculen kunnen er zonder hulp door het plasmamembraan passeren?

- RNA-bewerkingstool een snelle, gevoelige test voor COVID-19

- Onderzoekers ontwikkelen vergelijkingen om kantelpunten van de meest bedreigde ecosystemen van onze aardbol te voorspellen en te vergelijken

- Onderzoekers rapporteren bevindingen over de controle van celdeling

- Hoe een tRNA-reeks te krijgen van een DNA-reeks

- Wilgenroosje:de roze pionier

- Een functionele genomics-database voor onderzoeken naar het microbioom van planten

- Dit is wat de wetenschap zegt over dierengevoel

- Frankrijk ziet rood na Spaanse rose wijn gevonden in binnenlandse flessen

- Een kijkje in de toekomst:elektrisch vliegtuig vliegt door de lucht boven Noorwegen

- Facebook verscherpt de regels voor politieke advertenties in aanloop naar de EU-verkiezingen

- 3D-printen van metalen micro-objecten

- Een nieuwe manier om automatisch wegenkaarten te maken van luchtfoto's

NASA's Webb-telescoop zal een telling van jonge sterren in de sterrenkraamkamer verzorgen

NASA's Webb-telescoop zal een telling van jonge sterren in de sterrenkraamkamer verzorgen Onderzoekers ontrafelen de fysica van supergeleiders bij hoge temperaturen

Onderzoekers ontrafelen de fysica van supergeleiders bij hoge temperaturen Shadows on the Moon - een verhaal van kortstondige schoonheid, mensen en overmoed

Shadows on the Moon - een verhaal van kortstondige schoonheid, mensen en overmoed Natuurkundigen produceren 's werelds eerste neutronenrijke, radioactieve tantaalionen

Natuurkundigen produceren 's werelds eerste neutronenrijke, radioactieve tantaalionen Onderzoek toont aan dat standaardkeuzes ertoe doen, vooral voor armere, lager opgeleide personen

Onderzoek toont aan dat standaardkeuzes ertoe doen, vooral voor armere, lager opgeleide personen Als mensen thuis blijven, De aarde wordt wilder en schoner

Als mensen thuis blijven, De aarde wordt wilder en schoner Inheemse talen moeten meer aan bod komen in wetenschapscommunicatie

Inheemse talen moeten meer aan bod komen in wetenschapscommunicatie Welke vaardigheden heeft een cybersecurityprofessional nodig?

Welke vaardigheden heeft een cybersecurityprofessional nodig?

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com