Wetenschap

Vertrouwen in algoritmisch advies van computers kan ons blind maken voor fouten, zegt onderzoek

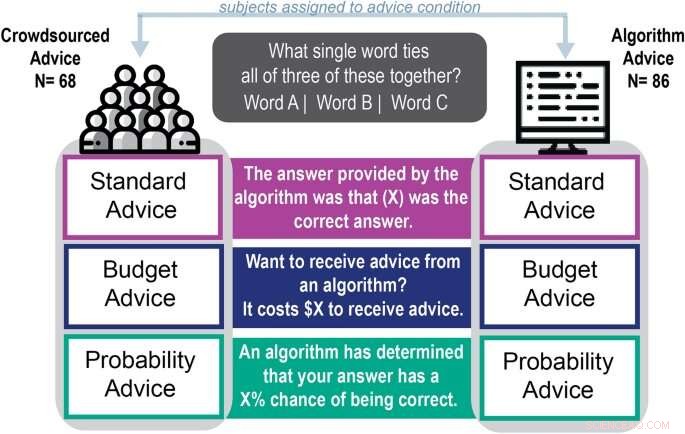

Schema van experimentele procedure. Krediet:Wetenschappelijke rapporten (2022). DOI:10.1038/s41598-022-18638-2

Met autocorrectie en automatisch gegenereerde e-mailreacties bieden algoritmen veel hulp om mensen te helpen zich uit te drukken.

Maar uit nieuw onderzoek van de Universiteit van Georgia blijkt dat mensen die afhankelijk zijn van computeralgoritmen voor hulp bij taalgerelateerde, creatieve taken hun prestaties niet verbeterden en meer geneigd waren om advies van lage kwaliteit te vertrouwen.

Aaron Schecter, een assistent-professor in managementinformatiesystemen aan het Terry College of Business, publiceerde deze maand zijn studie "Human preferenties in de richting van algoritmisch advies in een woordassociatietaak" in Scientific Reports . Zijn co-auteurs zijn Nina Lauharatanahirun, een assistent-professor biogedragsgezondheid aan de Pennsylvania State University, en de recente Terry College Ph.D. afgestudeerde en huidige assistent-professor Eric Bogert van de Northeastern University.

De paper is de tweede in het onderzoek van het team naar individueel vertrouwen in door algoritmen gegenereerde adviezen. In een paper van april 2021 ontdekte het team dat mensen meer afhankelijk waren van algoritmisch advies bij het tellen van taken dan van advies dat zogenaamd door andere deelnemers werd gegeven.

Dit onderzoek was bedoeld om te testen of mensen het advies van een computer uitstelden bij het aanpakken van creatievere en taalafhankelijke taken. Het team ontdekte dat deelnemers 92,3% meer kans hadden om advies te gebruiken dat aan een algoritme werd toegeschreven dan om advies aan te nemen dat aan mensen werd toegeschreven.

"Deze taak vereiste niet hetzelfde soort denken (als de teltaak in de eerdere studie), maar in feite zagen we dezelfde vooroordelen," zei Schecter. "Ze zouden het antwoord van het algoritme nog steeds gebruiken en er een goed gevoel over hebben, ook al helpt het hen niet om het beter te doen."

Een algoritme gebruiken tijdens woordassociatie

Om te zien of mensen meer zouden vertrouwen op door de computer gegenereerd advies voor taalgerelateerde taken, gaven Schecter en zijn co-auteurs 154 online deelnemers delen van de Remote Associates Test, een woordassociatietest die al zes decennia wordt gebruikt om de creativiteit van een deelnemer te beoordelen.

"Het is geen pure creativiteit, maar woordassociatie is een fundamenteel ander soort taak dan het maken van een stockprojectie of het tellen van objecten op een foto, omdat het taalkunde omvat en het vermogen om verschillende ideeën te associëren," zei hij. "We beschouwen dit als meer subjectief, ook al is er een goed antwoord op de vragen."

Tijdens de test moesten de deelnemers een woord bedenken dat drie voorbeeldwoorden aan elkaar koppelde. Als de woorden bijvoorbeeld base, room en bowling waren, zou het antwoord bal zijn.

Deelnemers kozen een woord om de vraag te beantwoorden en kregen een hint toegewezen aan een algoritme of een hint toegeschreven aan een persoon en mochten hun antwoorden wijzigen. De voorkeur voor van een algoritme afgeleid advies was sterk, ondanks de moeilijkheid van de vraag, de manier waarop het advies werd geformuleerd of de kwaliteit van het advies.

Deelnemers die het advies van het algoritme opvolgden, hadden ook twee keer zoveel vertrouwen in hun antwoorden als mensen die het advies van de persoon gebruikten. Ondanks hun vertrouwen in hun antwoorden, hadden ze 13% minder kans dan degenen die op mensen gebaseerd advies gebruikten om de juiste antwoorden te kiezen.

"Ik ga niet zeggen dat het advies mensen slechter maakte, maar het feit dat ze het niet beter deden en toch een beter gevoel hadden over hun antwoorden, illustreert het probleem," zei hij. "Hun zelfvertrouwen is gestegen, dus ze zullen waarschijnlijk algoritmisch advies gebruiken en zich er goed bij voelen, maar ze zullen niet per se gelijk hebben.

Moet je autocorrectie accepteren bij het schrijven van een e-mail?

"Als ik een functie voor automatisch aanvullen of autocorrectie in mijn e-mail heb waarin ik geloof, denk ik er misschien niet aan of ik er beter van word. Ik ga het gewoon gebruiken omdat ik er zeker van ben dat ik het zal doen."

Schechter en collega's noemen deze neiging om computergegenereerd advies te accepteren zonder oog voor de kwaliteit ervan als automatiseringsbias. Begrijpen hoe en waarom menselijke besluitvormers gebruik maken van machine learning-software om problemen op te lossen, is een belangrijk onderdeel van het begrijpen van wat er mis kan gaan op moderne werkplekken en hoe dit te verhelpen.

"Vaak als we het hebben over de vraag of we algoritmen kunnen toestaan beslissingen te nemen, wordt het hebben van een persoon op de hoogte gebracht als de oplossing om fouten of slechte resultaten te voorkomen," zei Schecter. "Maar dat kan niet de oplossing zijn als mensen eerder geneigd zijn om uit te stellen wat het algoritme adviseert." + Verder verkennen

Mensen kunnen computers meer vertrouwen dan mensen

Loodhoudende benzine is verdwenen – maar loodvervuiling kan nog heel lang aanhouden

Loodhoudende benzine is verdwenen – maar loodvervuiling kan nog heel lang aanhouden Programma's voor het verhuizen van overstromingen zijn meer storend voor degenen die niet in blanke of welvarende buurten wonen

Programma's voor het verhuizen van overstromingen zijn meer storend voor degenen die niet in blanke of welvarende buurten wonen Wetenschapsexperimenten voor kleuters met behulp van ijsberen en pinguïns

Wetenschapsexperimenten voor kleuters met behulp van ijsberen en pinguïns  Terwijl de wetlands van Brazilië branden, regen is alleen maar hoop

Terwijl de wetlands van Brazilië branden, regen is alleen maar hoop Horseshoe Crab Science Project

Horseshoe Crab Science Project

Hoofdlijnen

- Een RNA TREAT voor Halloween

- Handels in huisdieren en medicijnen die van invloed zijn op de plaatselijke tokay-gekkopopulaties, melden ecologen

- Genomische kenmerken verklaard door bepaalde kenmerken van de levensgeschiedenis bij neoaviaire vogels

- Van goot naar darm:hoe antimicrobieel resistente microben van de omgeving naar de mens reizen

- Op feiten gebaseerde tips om uw geheugen te verbeteren

- Kan iemand zich herinneren dat hij geboren is?

- Nieuw ontwikkelde schakelaar activeert genen duizenden keren beter dan de natuur

- Machine learning kan bio-engineering mogelijk maken van het meest voorkomende enzym ter wereld

- Waar worden mensen blij van?

- Familie zegt Ringcamera in kamer van 8-jarige dochters toegankelijk door hacker

- Mobiele internetgebruikers leggen zichzelf de privacylast op

- Is Bitcoin de nieuwe gouden standaard of een ander fiat?

- Facebook fall-out:de privacy van Amerikanen loopt gevaar in de hele technologie, informatie-industrie

- Wetenschappers realiseren grote organische zonnecellen die goedkoop, flexibel en efficiënt zijn

SpaceX onthult kijkje in gestroomlijnd nieuw ruimtepak

SpaceX onthult kijkje in gestroomlijnd nieuw ruimtepak Muizen in sociale conflicten vertonen gedrag dat zich aan regels houdt

Muizen in sociale conflicten vertonen gedrag dat zich aan regels houdt Wetenschappers voorspellen de gemiddelde neerslag in de late winter in West-Europa voor het komende decennium

Wetenschappers voorspellen de gemiddelde neerslag in de late winter in West-Europa voor het komende decennium Formules voor opbrengststress

Formules voor opbrengststress  Definitie van Desert Scrub

Definitie van Desert Scrub Kustaanpassing tegen zeespiegelstijging is economisch zinvol

Kustaanpassing tegen zeespiegelstijging is economisch zinvol Onderzoekers tonen aan dat vliegtuigbrandstoffen gemaakt van planten kostenconcurrerend kunnen zijn met conventionele fossiele brandstoffen

Onderzoekers tonen aan dat vliegtuigbrandstoffen gemaakt van planten kostenconcurrerend kunnen zijn met conventionele fossiele brandstoffen Facebook-winst stijgt samen met gebruikersbestand

Facebook-winst stijgt samen met gebruikersbestand

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com