Wetenschap

Door robots harde liefde te tonen, kunnen ze slagen, vindt nieuwe studie

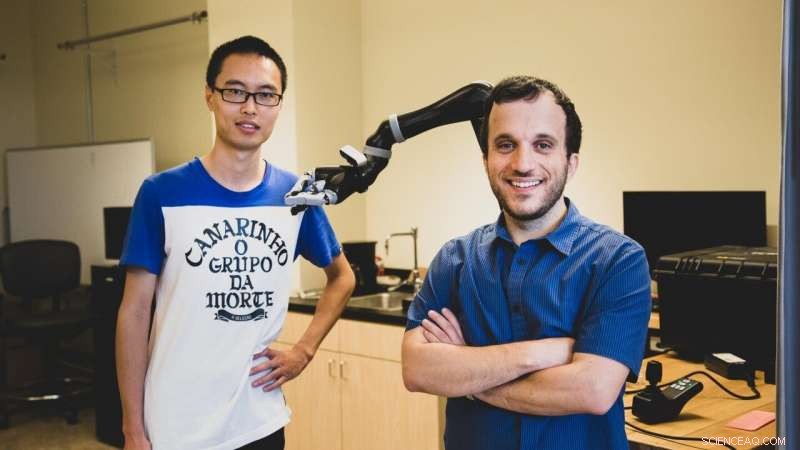

USC-promovendus Jiali Duan (links) en Stefanos Nikolaidis, een assistent-professor in de informatica, gebruik versterkend leren, een techniek waarbij kunstmatige-intelligentieprogramma's 'leren' van herhaald experimenteren. Krediet:Haotian Mai.

Volgens een nieuwe studie van computerwetenschappers van het USC, om een robot te helpen slagen, misschien moet je het wat harde liefde tonen.

In een computergesimuleerde manipulatietaak, de onderzoekers ontdekten dat het trainen van een robot met een menselijke tegenstander zijn greep op objecten aanzienlijk verbeterde.

"Dit is de eerste leerinspanning voor robots waarbij gebruik wordt gemaakt van vijandige menselijke gebruikers, " zei co-auteur Stefanos Nikolaidis van de studie, een assistent-professor in de informatica.

"Stel je het voor alsof je aan het sporten bent:als je tennis speelt met iemand die je altijd laat winnen, je wordt er niet beter van. Hetzelfde met robotten. Als we willen dat ze een manipulatietaak leren, zoals grijpen, zodat ze mensen kunnen helpen, we moeten ze uitdagen."

De studie, "Robotleren via Human Adversarial Games, " werd op 4 november gepresenteerd op de International Conference on Intelligent Robots and Systems. USC PhD-studenten Jiali Duan en Qian Wang zijn hoofdauteurs, geadviseerd door professor C.C. Jay Kuo, met extra co-auteur Lerrel Pinto van Carnegie Mellon University.

Leren van de praktijk

Nikolaïden, die in 2018 toetrad tot de USC Viterbi School of Engineering, en zijn team gebruiken versterkend leren, een techniek waarbij kunstmatige-intelligentieprogramma's "leren" van herhaald experimenteren.

In plaats van beperkt te zijn tot het uitvoeren van een klein aantal repetitieve taken, zoals industriële robots, het robotsysteem "leert" op basis van eerdere voorbeelden, in theorie vergroot het aantal taken dat het kan uitvoeren.

Maar het maken van robots voor algemene doeleinden is notoir uitdagend, mede door de benodigde opleiding. Robotsystemen hebben een enorm aantal voorbeelden nodig om te leren hoe ze een object op een mensachtige manier kunnen manipuleren.

Bijvoorbeeld, Het indrukwekkende robotsysteem van OpenAI leerde een Rubiks kubus op te lossen met een mensachtige hand, maar vereist het equivalent van 10, 000 jaar gesimuleerde training om de kubus te leren manipuleren.

Belangrijker, de behendigheid van de robot is heel specifiek. Zonder uitgebreide opleiding, het kan geen object oppakken, manipuleer het met een andere greep, of een ander object vastpakken en hanteren.

"Als mens, zelfs als ik de locatie van het object weet, Ik weet niet precies hoeveel het weegt of hoe het zal bewegen of zich gedragen als ik het oppak, toch doen we dit bijna altijd met succes, ' zei Nikolaidis.

"Dat komt omdat mensen heel intuïtief zijn over hoe de wereld zich gedraagt, maar de robot is als een pasgeboren baby."

Met andere woorden, robotsystemen vinden het moeilijk om te generaliseren, een vaardigheid die mensen als vanzelfsprekend beschouwen. Dit lijkt misschien triviaal, maar het kan ernstige gevolgen hebben. Als ondersteunende robotapparaten, zoals grijprobots, zijn om hun belofte na te komen om mensen met een handicap te helpen, robotsystemen moeten betrouwbaar kunnen werken in reële omgevingen.

Mens in de lus

Een onderzoekslijn die behoorlijk succesvol is geweest in het oplossen van dit probleem, is het hebben van een 'mens in de lus'. Met andere woorden, de mens geeft feedback aan het robotsysteem door aan te tonen dat hij de taak kan voltooien.

Maar, tot nu, deze algoritmen gaan er sterk van uit dat een samenwerkende menselijke supervisor de robot assisteert.

"Ik heb altijd gewerkt aan samenwerking tussen mens en robot, maar in werkelijkheid, mensen zullen niet altijd samenwerken met robots in het wild, ' zei Nikolaidis.

Als voorbeeld, wijst hij op een studie van Japanse onderzoekers, die een robot losliet in een openbaar winkelcomplex en meermaals zag dat kinderen "gewelddadig" tegen hem handelden.

Dus, dacht Nikolaidis, wat als we onze menselijke neiging zouden gebruiken om het de robot moeilijker te maken? In plaats van hem te laten zien hoe hij een object beter kan pakken, wat als we het proberen weg te trekken? Door uitdaging toe te voegen, het denken gaat, het systeem zou leren robuuster te zijn voor de complexiteit van de echte wereld.

Element van uitdaging

Het experiment ging ongeveer als volgt:in een computersimulatie, de robot probeert een object te grijpen. De mens, op de computer, observeert de greep van de gesimuleerde robot. Als de greep succesvol is, de mens probeert het object uit de greep van de robot te grijpen, het toetsenbord gebruiken om richting aan te geven.

Door dit uitdagingselement toe te voegen, leert de robot het verschil tussen een zwakke greep (bijvoorbeeld met een fles aan de bovenkant), versus een stevige greep (in het midden vasthouden), wat het voor de menselijke tegenstander veel moeilijker maakt om weg te rukken.

Het was een beetje een gek idee, geeft toe Nikolaidis, maar het werkte.

De onderzoekers ontdekten dat het systeem dat was getraind met de menselijke tegenstander onstabiele grepen afwees, en leerde snel robuuste grepen voor deze objecten. In een experiment, het model behaalde een slagingspercentage van 52 procent bij een menselijke tegenstander versus een slagingspercentage van 26.5 procent bij een menselijke medewerker.

"De robot leerde niet alleen objecten steviger vast te pakken, maar ook vaker slagen met nieuwe objecten in een andere oriëntatie, omdat het een stabielere greep heeft geleerd, ' zei Nikolaidis.

Ze ontdekten ook dat het model getraind met een menselijke tegenstander beter presteerde dan een gesimuleerde tegenstander, die een slagingspercentage van 28 procent had. Dus, robotsystemen leren het beste van tegenstanders van vlees en bloed.

"Dat komt omdat mensen stabiliteit en robuustheid beter kunnen begrijpen dan geleerde tegenstanders, " legde Nikolaidis uit.

"De robot probeert dingen op te rapen en, als de mens probeert te verstoren, het leidt tot stabielere grepen. En omdat het een stabielere greep heeft geleerd, het zal vaker lukken, zelfs als het object zich in een andere positie bevindt. Met andere woorden, het is geleerd om te generaliseren. Dat is een groot probleem."

Een balans vinden

Nikolaidis hoopt het systeem binnen een jaar op een echte robotarm te hebben. Dit zal een nieuwe uitdaging vormen - in de echte wereld, het minste beetje wrijving of geluid in de gewrichten van een robot kan dingen afschudden. Maar Nikolaidis is hoopvol over de toekomst van vijandig leren voor robotica.

"Ik denk dat we net het oppervlak hebben bekrast van mogelijke toepassingen van leren via vijandige menselijke games, ' zei Nikolaidis.

"We zijn verheugd om human-in-the-loop vijandig leren ook in andere taken te onderzoeken, zoals het vermijden van obstakels voor robotarmen en mobiele robots, zoals zelfrijdende auto's."

Dit roept de vraag op:hoe ver zijn we bereid om vijandig leren te gaan? Zouden we bereid zijn om robots te schoppen en te verslaan tot onderwerping? Het antwoord, zei Nikolaidis, ligt in het vinden van een balans tussen harde liefde en aanmoediging met onze robotica-tegenhangers.

"Ik heb het gevoel dat harde liefde - in de context van het algoritme dat we voorstellen - weer als een sport is:het valt binnen specifieke regels en beperkingen, ' zei Nikolaidis.

"Als de mens de grijper van de robot breekt, de robot zal voortdurend falen en nooit leren. Met andere woorden, de robot moet worden uitgedaagd, maar toch slagen om te leren."

Team ontwikkelt snelle authenticatiemethode voor Chinese medicijnen

Team ontwikkelt snelle authenticatiemethode voor Chinese medicijnen Oplossen van molecuulinformatie in dynamisch lipidemembraan met meta-oppervlakken

Oplossen van molecuulinformatie in dynamisch lipidemembraan met meta-oppervlakken Hoe gebruiken planten water in fotosynthese?

Hoe gebruiken planten water in fotosynthese?  Nikkelferriet bevordert de capaciteit en cyclusstabiliteit van lithium-zwavelbatterijen

Nikkelferriet bevordert de capaciteit en cyclusstabiliteit van lithium-zwavelbatterijen Nieuw apparaat detecteert snel schadelijke bacteriën in bloed

Nieuw apparaat detecteert snel schadelijke bacteriën in bloed

Plastic vergiftigt oceaanbacteriën die de mariene voedselketen ondersteunen

Plastic vergiftigt oceaanbacteriën die de mariene voedselketen ondersteunen Aarde recycleert oceaanbodem tot diamanten

Aarde recycleert oceaanbodem tot diamanten Langs, hard kijken onder de grond is vereist om netto nul te bereiken, zeggen experts

Langs, hard kijken onder de grond is vereist om netto nul te bereiken, zeggen experts Maart 2020 bij heetste ooit:EU

Maart 2020 bij heetste ooit:EU Maakt een beperkte ondergrondse waterberging planten minder vatbaar voor droogte?

Maakt een beperkte ondergrondse waterberging planten minder vatbaar voor droogte?

Hoofdlijnen

- Chimpansees in het wild wijzigen waarschuwingen op basis van wat anderen in hun groep al weten, studie vondsten

- Hoe het placebo-effect werkt

- Deze pijnbomen leunen bijna altijd naar de evenaar

- De verschillen tussen Catecholamines en Cortisol

- Technologie verhoogt melkgift met 9 procent

- Hoe vogelgriep werkt

- Wat doet een skelet bewegen?

Het skelet is het starre raamwerk dat een lichaam zijn algemene vorm geeft, maar op zichzelf is het niet in staat tot beweging. Wat een skelet doet bewegen is de samentrekking en ontspanning van spieren die ermee verbon

- Waarom wordt natrium gebruikt in DNA-extractie?

- Wat bepaalt de productie van eiwitten in uw lichaam?

- BMW roept 323 terug, 700 dieselauto's boven brandgevaar:rapport

- Hideo Kojima:raadselachtige maker van games geïnspireerd door films

- Ouders kunnen niet verwijderen wat kinderen vertellen aan de stemassistent van Amazon

- Uber bereikt deal in Tsjechië over licenties, belasting

- AI-aangedreven tool voorspelt celgedrag tijdens ziekte en behandeling

State of the Polar Oceans 2018 gepubliceerd

State of the Polar Oceans 2018 gepubliceerd EPA-boetes tegen vervuilers dalen fors

EPA-boetes tegen vervuilers dalen fors Klassiek experiment met twee spleten in een nieuw licht

Klassiek experiment met twee spleten in een nieuw licht Wanneer moeten banken achter schulden aangaan? Nieuwe methode kan hen helpen beslissen

Wanneer moeten banken achter schulden aangaan? Nieuwe methode kan hen helpen beslissen Survival of the fittest en meest wendbare zal retailers maken of breken naarmate de lockdown versoepelt

Survival of the fittest en meest wendbare zal retailers maken of breken naarmate de lockdown versoepelt Hoe de snelheid van twee verschillende katrollen te berekenen

Hoe de snelheid van twee verschillende katrollen te berekenen Zelfgemaakte vulkaan alternatief voor zuiveringszout en azijn

Zelfgemaakte vulkaan alternatief voor zuiveringszout en azijn  Samsung ontkent dat de verbrande nieuwe Galaxy-telefoon defect is geraakt

Samsung ontkent dat de verbrande nieuwe Galaxy-telefoon defect is geraakt

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | German | Dutch | Danish | Norway | Swedish |

-

Wetenschap © https://nl.scienceaq.com