Wetenschap

AI-agent biedt beweegredenen met behulp van alledaagse taal om zijn acties uit te leggen

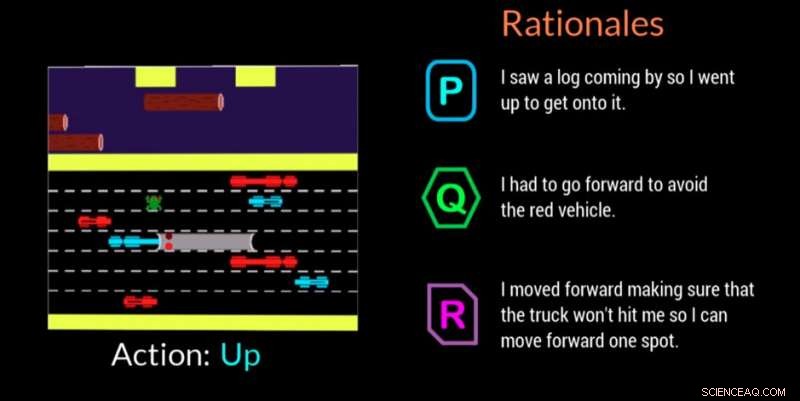

Een AI-agent geeft de reden voor het nemen van een beslissing in deze videogame. Krediet:Georgia Tech

Onderzoekers van het Georgia Institute of Technology, in samenwerking met Cornell University en University of Kentucky, hebben een kunstmatig intelligente (AI) agent ontwikkeld die automatisch natuurlijke taalverklaringen in realtime kan genereren om de motivaties achter zijn acties over te brengen. Het werk is ontworpen om mensen die betrokken zijn bij AI-agenten of robots het vertrouwen te geven dat de agent de taak correct uitvoert en een fout of foutief gedrag kan verklaren.

De agent gebruikt ook alledaagse taal die niet-experts kunnen begrijpen. de uitleg, of 'rationales' zoals de onderzoekers ze noemen, zijn ontworpen om herkenbaar te zijn en vertrouwen te wekken bij degenen die op de werkplek met AI-machines werken of met hen omgaan in sociale situaties.

"Als de kracht van AI moet worden gedemocratiseerd, het moet voor iedereen toegankelijk zijn, ongeacht hun technische vaardigheden, " zei Upol Ehsan, doctoraat student aan de School of Interactive Computing aan Georgia Tech en hoofdonderzoeker.

"Omdat AI alle aspecten van ons leven doordringt, er is een duidelijke behoefte aan mensgericht AI-ontwerp dat black-boxed AI-systemen begrijpelijk maakt voor alledaagse gebruikers. Ons werk is een belangrijke stap in de richting van het begrijpen van de rol van op taal gebaseerde verklaringen en hoe mensen ze waarnemen."

Het onderzoek werd ondersteund door het Office of Naval Research (ONR).

Onderzoekers ontwikkelden een deelnemersonderzoek om te bepalen of hun AI-agent beweegredenen kon bieden die menselijke reacties nabootsten. Toeschouwers keken hoe de AI-agent de videogame Frogger speelde en rangschikten vervolgens drie redenen op het scherm in volgorde van hoe goed elk de spelbeweging van de AI beschreef.

Van de drie geanonimiseerde rechtvaardigingen voor elke beweging - een door mensen gegenereerde reactie, de reactie van de AI-agent, en een willekeurig gegenereerde reactie - de deelnemers gaven eerst de voorkeur aan de door mensen gegenereerde redenen, maar de AI-gegenereerde reacties waren een goede tweede.

Frogger bood de onderzoekers de kans om een AI te trainen in een "sequentiële besluitvormingsomgeving, " wat een belangrijke onderzoeksuitdaging is, omdat beslissingen die de agent al heeft genomen, toekomstige beslissingen beïnvloeden. het uitleggen van de redenering aan experts is moeilijk, en nog meer bij het communiceren met niet-experts, volgens onderzoekers.

De menselijke toeschouwers begrepen het doel van Frogger om de kikker veilig thuis te brengen zonder geraakt te worden door rijdende voertuigen of te verdrinken in de rivier. De eenvoudige spelmechanica van omhoog gaan, omlaag, links of rechts, liet de deelnemers zien wat de AI aan het doen was, en om te evalueren of de beweegredenen op het scherm de verhuizing duidelijk rechtvaardigden.

De toeschouwers beoordeelden de beweegredenen op basis van:

- Vertrouwen - de persoon heeft vertrouwen in de AI om zijn taak uit te voeren

- Menselijke gelijkenis - het lijkt alsof het door een mens is gemaakt

- Adequate rechtvaardiging - rechtvaardigt de ondernomen actie adequaat

- Begrijpelijkheid:helpt de persoon het gedrag van de AI te begrijpen

AI-gegenereerde beweegredenen die door de deelnemers hoger werden gerangschikt, waren die die herkenning van omgevingscondities en aanpassingsvermogen toonden, evenals degenen die het bewustzijn van opkomende gevaren communiceerden en voor hen hadden gepland. Overbodige informatie die zojuist het voor de hand liggende of verkeerd gekarakteriseerde milieu vermeldde, bleek een negatief effect te hebben.

"Dit project gaat meer over het begrijpen van menselijke percepties en voorkeuren van deze AI-systemen dan over het bouwen van nieuwe technologieën, "zei Ehsan. "De kern van verklaarbaarheid is betekenisgeving. We proberen die menselijke factor te begrijpen."

Een tweede gerelateerde studie valideerde de beslissing van de onderzoekers om hun AI-agent te ontwerpen om een van twee verschillende soorten beweegredenen te kunnen bieden:

- Beknopt, "gerichte" beweegredenen of

- Holistische, "compleet plaatje" beweegredenen

In deze tweede studie deelnemers kregen alleen AI-gegenereerde beweegredenen aangeboden na het bekijken van het AI-spel Frogger. Ze werden gevraagd het antwoord te selecteren dat hun voorkeur had in een scenario waarin een AI een fout maakte of zich onverwachts gedroeg. Ze wisten niet dat de beweegredenen waren gegroepeerd in de twee categorieën.

Met een 3-tegen-1 marge, deelnemers gaven de voorkeur aan antwoorden die werden geclassificeerd in de categorie "volledig beeld". Uit reacties bleek dat mensen het op prijs stelden dat AI nadacht over toekomstige stappen in plaats van alleen wat er op dat moment was, waardoor ze meer geneigd zijn om nog een fout te maken. Mensen wilden ook meer weten, zodat ze de AI direct konden helpen het dwalende gedrag op te lossen.

"Het gesitueerde begrip van de percepties en voorkeuren van mensen die met AI-machines werken, geeft ons een krachtige reeks bruikbare inzichten die ons kunnen helpen om beter mensgerichte, rationale-genererende, autonome agenten, " zei Mark Riedl, hoogleraar Interactive Computing en hoofd faculteitslid van het project.

Een mogelijke toekomstige richting voor het onderzoek zal de bevindingen toepassen op autonome agenten van verschillende typen, zoals begeleidende agenten, en hoe ze kunnen reageren op basis van de taak die voorhanden is. Onderzoekers zullen ook kijken naar hoe agenten in verschillende scenario's kunnen reageren, zoals tijdens een noodsituatie of bij het helpen van leraren in de klas.

Het onderzoek werd in maart gepresenteerd op de Association for Computing Machinery's Intelligent User Interfaces 2019 Conference. Het artikel is getiteld "Automated Rational Generation:A Technique for Explainable AI and its Effects on Human Perceptions." Ehsan zal een position paper presenteren waarin de ontwerp- en evaluatie-uitdagingen van mensgerichte Explainable AI-systemen worden benadrukt tijdens de komende Emerging Perspectives in Human-Centered Machine Learning-workshop op de ACM CHI 2019-conferentie, 4-9 mei, in Glasgow, Schotland.

Duitse chemiesector verhoogt prognose voor 2017 in sterk derde kwartaal

Duitse chemiesector verhoogt prognose voor 2017 in sterk derde kwartaal Niet-ontvlambare elektrolyt voor hoogwaardige kaliumbatterijen

Niet-ontvlambare elektrolyt voor hoogwaardige kaliumbatterijen Ontdekking kan leiden tot zelfrijdende robots

Ontdekking kan leiden tot zelfrijdende robots Moleculen maken met tandenstokers en marshmallows

Moleculen maken met tandenstokers en marshmallows Wetenschappers vinden een kunstmatige neus uit voor continue bacteriële monitoring

Wetenschappers vinden een kunstmatige neus uit voor continue bacteriële monitoring

NASA ziet tropische cycloon Keni zich ontwikkelen in de Stille Zuidzee

NASA ziet tropische cycloon Keni zich ontwikkelen in de Stille Zuidzee Onderzoek koppelt achteruitgang in hemlock-bossen aan veranderingen in watervoorraden

Onderzoek koppelt achteruitgang in hemlock-bossen aan veranderingen in watervoorraden Hoe passen planten en dieren zich aan de woestijn aan?

Hoe passen planten en dieren zich aan de woestijn aan?  Economische vlindervleugels kunnen een tornado voor klimaatactie veroorzaken

Economische vlindervleugels kunnen een tornado voor klimaatactie veroorzaken De relatie tussen droogte en hongersnood - lessen uit de Hoorn van Afrika

De relatie tussen droogte en hongersnood - lessen uit de Hoorn van Afrika

Hoofdlijnen

- Bronnen van het lactase-enzym

- Waarom gifkikkers zichzelf niet vergiftigen?

- Wat zijn de verschillen tussen een plant en een dierlijke cel onder een microscoop?

- Eenvoudige manieren om de structuren van de Skull

- Welke soorten cellen en organismen ondergaan mitose en meiose?

- Gestresste stokstaartjes helpen minder snel groep

- Mussenkuikens kunnen het nummer identificeren vanaf de openingsnoot

- De Atlantische steuren verblijven

- Vijf soorten aseksuele reproductie

- Voor het maken van veiligere en krachtigere lithium-ionbatterijen is het juiste recept nodig

- Besluitvorming van vijf nanoseconden:nieuw chipontwerp om onderzoekers snel te kunnen rekenen

- Deense goedkope luchtvaartmaatschappij Primera vouwt vleugels

- Twitter zegt dat wereldleiders niet boven zijn regels staan

- Verbeterde microgrid-technologie:een nieuwe manier voor betrouwbare stroom

Informatie over hydraulische aansluitingen

Informatie over hydraulische aansluitingen Je hoeft geen raket te bouwen om te bewijzen dat de aarde niet plat is - hier is de simpele wetenschap

Je hoeft geen raket te bouwen om te bewijzen dat de aarde niet plat is - hier is de simpele wetenschap ARM-gearomatiseerde Chrome voor Windows is een smakelijke inspanning voor Microsoft, Google, Qualcomm

ARM-gearomatiseerde Chrome voor Windows is een smakelijke inspanning voor Microsoft, Google, Qualcomm Gevestigde massaproductietechnologie voor nanodeeltjes van vaste-oplossinglegeringen

Gevestigde massaproductietechnologie voor nanodeeltjes van vaste-oplossinglegeringen Nieuw beeldvormingssysteem onthult defecten aan zonnepanelen, zelfs in fel zonlicht

Nieuw beeldvormingssysteem onthult defecten aan zonnepanelen, zelfs in fel zonlicht Metalen asteroïde Psyche is helemaal klaar voor een vroeg bezoek van NASA

Metalen asteroïde Psyche is helemaal klaar voor een vroeg bezoek van NASA Wie is kwetsbaar voor de gevolgen van tropische cyclonen en waarom?

Wie is kwetsbaar voor de gevolgen van tropische cyclonen en waarom? Onderzoekers presenteren nieuwe strategie om de ductiliteit in een enkelfasige legering uit te breiden

Onderzoekers presenteren nieuwe strategie om de ductiliteit in een enkelfasige legering uit te breiden

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com