Wetenschap

Onderzoekers ontwikkelen een nieuwe manier om machine learning-algoritmen te testen die zelfrijdende auto's besturen

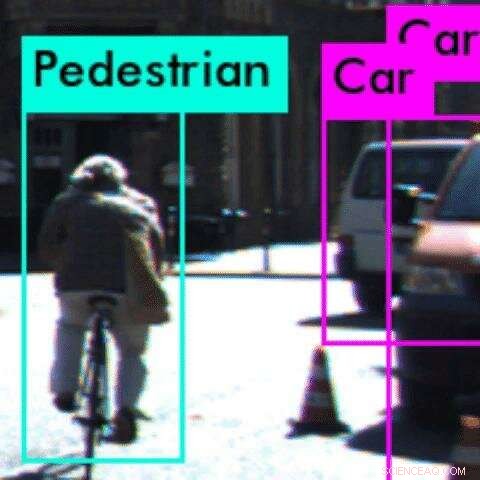

In dit voorbeeld, een perceptie-algoritme classificeert de fietser verkeerd als een voetganger Credit:Anand Balakrishnan

Het is een grote vraag voor veel mensen in drukke steden als Los Angeles:wanneer komen zelfrijdende auto's? Maar na een reeks spraakmakende ongevallen in de Verenigde Staten, veiligheidsproblemen zouden de autonome droom tot stilstand kunnen brengen.

Bij het USC, onderzoekers hebben een nieuwe studie gepubliceerd die een al lang bestaand probleem voor ontwikkelaars van autonome voertuigen aanpakt:het testen van de waarnemingsalgoritmen van het systeem, waardoor de auto kan "begrijpen" wat hij "ziet".

In samenwerking met onderzoekers van de Arizona State University, de nieuwe wiskundige methode van het team is in staat om afwijkingen of bugs in het systeem te identificeren voordat de auto de weg op gaat.

Perceptie-algoritmen zijn gebaseerd op convolutionele neurale netwerken, aangedreven door machine learning, een vorm van diep leren. Deze algoritmen zijn notoir moeilijk te testen, omdat we niet helemaal begrijpen hoe ze hun voorspellingen doen. Dit kan verwoestende gevolgen hebben in veiligheidskritieke systemen zoals autonome voertuigen.

"Het robuust maken van perceptie-algoritmen is een van de belangrijkste uitdagingen voor autonome systemen, " zei de hoofdauteur van de studie, Anand Balakrishnan, een USC informatica Ph.D. student.

"Met deze methode ontwikkelaars kunnen veel sneller fouten in de waarnemingsalgoritmen opsporen en deze informatie gebruiken om het systeem verder te trainen. Op dezelfde manier waarop auto's crashtests moeten ondergaan om de veiligheid te garanderen, deze methode biedt een preventieve test om fouten in autonome systemen op te sporen."

De krant, getiteld Specificeren en evalueren van kwaliteitsstatistieken voor op visie gebaseerde waarnemingssystemen, gepresenteerd op de Design, Automatisering en testen in Europa conferentie in Italië, 28 maart.

Leren over de wereld

Typisch autonome voertuigen "leren" over de wereld via machine learning-systemen, die enorme datasets van wegbeelden krijgen voordat ze zelf objecten kunnen identificeren.

Maar het systeem kan fout gaan. In het geval van een dodelijk ongeval tussen een zelfrijdende auto en een voetganger in Arizona afgelopen maart, de software classificeerde de voetganger als een "vals positief" en besloot dat het niet hoefde te stoppen.

"Wij dachten, er is duidelijk een probleem met de manier waarop dit perceptie-algoritme is getraind, " zei co-auteur van de studie Jyo Deshmukh, een USC-professor computerwetenschappen en voormalig onderzoeks- en ontwikkelingsingenieur voor Toyota, gespecialiseerd in de veiligheid van autonome voertuigen.

"Als een mens een video waarneemt, er zijn bepaalde aannames over volharding die we impliciet gebruiken:als we een auto in een videoframe zien, we verwachten in het volgende videoframe een auto op een nabijgelegen locatie te zien. Dit is een van de vele 'gezonde voorwaarden' waaraan het perceptie-algoritme moet voldoen voordat het wordt ingezet."

Bijvoorbeeld, een object kan niet van het ene frame naar het andere verschijnen en verdwijnen. Zo ja, het schendt een "gezondheidsvoorwaarde, " of basiswet van de fysica, wat suggereert dat er een fout in het waarnemingssysteem zit.

Deshmukh en zijn Ph.D. student Balakrishnan, samen met USC Ph.D. student Xin Qin en masterstudent Aniruddh Puranic, werkte samen met drie onderzoekers van de Arizona State University om het probleem te onderzoeken.

Geen ruimte voor fouten

Het team formuleerde een nieuwe wiskundige logica, genaamd Timed Quality Temporal Logic, en gebruikte het om twee populaire machine learning-tools te testen - Squeeze Det en YOLO - met behulp van onbewerkte videodatasets van rijscènes.

De logica is met succes aangescherpt op gevallen van machine learning-tools die "gezonde voorwaarden" over meerdere frames in de video schenden. Meestal, de machine learning-systemen konden een object niet detecteren of een object verkeerd geclassificeerd.

Bijvoorbeeld, in een voorbeeld, het systeem kon een fietser van achteren niet herkennen, toen de band van de fiets eruitzag als een dunne verticale lijn. In plaats daarvan, het verkeerd geclassificeerd de fietser als een voetganger. In dit geval, het systeem kan mogelijk niet correct anticiperen op de volgende zet van de fietser, die tot een ongeval kunnen leiden.

Fantoomobjecten - waarbij het systeem een object waarneemt als er geen is - waren ook gebruikelijk. Dit kan ertoe leiden dat de auto per ongeluk op de rem slaat - nog een potentieel gevaarlijke zet.

De methode van het team kan worden gebruikt om anomalieën of bugs in het perceptie-algoritme te identificeren voordat ze op de weg worden ingezet en stelt de ontwikkelaar in staat om specifieke problemen op te sporen.

Het idee is om problemen met het perceptie-algoritme op te sporen bij virtueel testen, waardoor de algoritmen veiliger en betrouwbaarder worden. Cruciaal, omdat de methode gebaseerd is op een bibliotheek van "sanity conditions, "Het is niet nodig dat mensen objecten in de testdataset labelen - een tijdrovend en vaak gebrekkig proces.

In de toekomst, het team hoopt de logica op te nemen om de perceptie-algoritmen opnieuw te trainen wanneer het een fout vindt. Het kan ook worden uitgebreid tot realtime gebruik, terwijl de auto rijdt, als een realtime veiligheidsmonitor.

Nieuw proces kan waterstofperoxide beschikbaar maken op afgelegen plaatsen

Nieuw proces kan waterstofperoxide beschikbaar maken op afgelegen plaatsen Dunne film zet warmte van elektronica om in energie

Dunne film zet warmte van elektronica om in energie Analyse van magnetische materialen was nog nooit zo begrijpelijk

Analyse van magnetische materialen was nog nooit zo begrijpelijk Kunstmatige cellen reageren op veranderingen in de omgeving

Kunstmatige cellen reageren op veranderingen in de omgeving Ontwikkeling van multifunctionele composietmaterialen voor ruimtevaarttoepassingen

Ontwikkeling van multifunctionele composietmaterialen voor ruimtevaarttoepassingen

Hoofdlijnen

- Hoe zijn genen, DNA en chromosomen met elkaar verbonden?

- Hoe te differentiëren tussen mitose en cytokinese

- Otzi the Iceman at een vetrijke laatste maaltijd

- Roofzuchtige bacteriën gevonden in studie van longmicrobioom van patiënten met cystische fibrose

- Dit is het seizoen om waakzaam te zijn:het risico op chocoladevergiftiging bij honden piekt met Kerstmis

- Opwarming van het klimaat zou de bacteriële impact op Chesapeake Bay-schelpdieren kunnen vergroten, recreatie

- Waarom stak de olifant de weg over? In Maleisië, ze proberen het antwoord te vinden

- Aardappelziekte chemisch aanvalsmechanisme uitgelegd

- Het is onwaarschijnlijk dat de jacht op trofeeën de evolutie beïnvloedt

- Facebook had apps van derden nodig om te groeien. Nu zit het met een privacycrisis

- Drone-project heeft tot doel de drijvende sloppenwijk van Lagos op de kaart te zetten

- S&P verlaagt de vooruitzichten voor de kredietwaardigheid van Boeing naar negatief

- Het reguleren van Facebook kan kleine bedrijven met buitenlandse klanten belemmeren

- Alibaba richt AI-onderzoekscentrum op in Singapore

Warm of koud, plattelandsbewoners kwetsbaarder voor extreme temperaturen

Warm of koud, plattelandsbewoners kwetsbaarder voor extreme temperaturen Ruimtegegevens voor monitoring van muggen in naam van de volksgezondheid

Ruimtegegevens voor monitoring van muggen in naam van de volksgezondheid Solo, toch tutti:App zet orkest in je woonkamer

Solo, toch tutti:App zet orkest in je woonkamer Het is tijd dat milieuactivisten spraken over het bevolkingsprobleem

Het is tijd dat milieuactivisten spraken over het bevolkingsprobleem Sporenmateriaal vinden in afvalstoffen

Sporenmateriaal vinden in afvalstoffen Hoe meten we pijn?

Hoe meten we pijn?  Bacteriën hebben tastzin

Bacteriën hebben tastzin Een nieuwe gevoelige en stabiele zelfaangedreven fotodetector

Een nieuwe gevoelige en stabiele zelfaangedreven fotodetector

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com