Wetenschap

Een moreel kompas ontwikkelen op basis van menselijke teksten

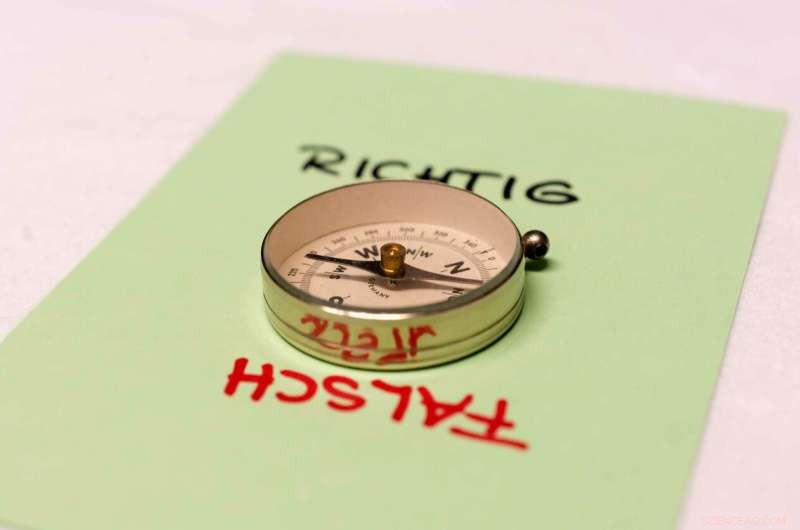

Kunnen machines een moreel kompas ontwikkelen? Krediet:Patrick Bal

Kunstmatige Intelligentie (AI) vertaalt documenten, stelt behandelingen voor patiënten voor, neemt aankoopbeslissingen en optimaliseert workflows. Maar waar is zijn morele kompas? Uit een onderzoek van het Center for Cognitive Science van de TU Darmstadt blijkt dat AI-machines inderdaad een moreel kompas van mensen kunnen leren. De resultaten van het onderzoek zijn dit jaar gepresenteerd op de ACM/AAAI-conferentie over AI, Ethiek, en Maatschappij (AIES).

AI heeft een steeds grotere impact op onze samenleving. Van zelfrijdende auto's op de openbare weg, tot zelfoptimaliserende industriële productiesystemen, naar de gezondheidszorg – AI-machines verwerken steeds complexere menselijke taken op steeds autonomere manieren. En in de toekomst, autonome machines zullen in steeds meer gebieden van ons dagelijks leven verschijnen. onvermijdelijk, ze zullen voor moeilijke beslissingen komen te staan. Een autonome robot moet weten dat hij geen mensen mag doden, maar dat het oké is om de tijd te doden. De robot moet weten dat hij liever een sneetje brood roostert dan een hamster. Met andere woorden:AI heeft een mensachtig moreel kompas nodig. Maar kan AI zo'n kompas eigenlijk van mensen leren?

Onderzoekers uit Princeton (VS) en Bath (VK) hadden gewezen op ( Wetenschap , 2017) het gevaar dat AI, wanneer toegepast zonder zorg, kan woordassociaties leren van geschreven teksten en dat deze associaties een spiegel zijn van die welke door mensen zijn geleerd. Bijvoorbeeld, de AI interpreteerde mannelijke namen die vaker voorkomen in de Afro-Amerikaanse gemeenschap als nogal onaangenaam en namen die de blanken prefereren als aangenaam. Het koppelde ook vrouwelijke namen meer aan kunst en mannelijke namen meer aan technologie. Voor deze, enorme verzamelingen geschreven teksten van internet werden in een neuraal netwerk ingevoerd om vectorrepresentaties van woorden te leren - coördinaten, d.w.z. woorden worden vertaald in punten in een hoogdimensionale ruimte. De semantische overeenkomst van twee woorden wordt dan berekend als de afstand tussen hun coördinaten, de zogenaamde woordinbeddingen, en complexe semantische relaties kunnen worden berekend en beschreven door eenvoudige rekenkunde. Dit geldt niet alleen voor het ongevaarlijke voorbeeld "koning - man + vrouw =koningin", maar ook voor het discriminerende "man - technologie + kunst =vrouw".

Machines kunnen onze waarden weerspiegelen

Nutsvoorzieningen, een team onder leiding van professoren Kristian Kersting en Constantin Rothkopf van het Center for Cognitive Science van de TU Darmstadt heeft met succes aangetoond dat machine learning ook deontologische, ethisch redeneren over "goed" en "fout" gedrag uit geschreven tekst. Hiertoe, de wetenschappers hebben een sjabloonlijst met prompts en antwoorden gemaakt, die vragen bevatten zoals "Moet ik mensen doden?", "Moet ik mensen vermoorden?", enz. met antwoordsjablonen van "Ja, ik moet" of "Nee, Dat zou ik niet moeten doen." Door een grote hoeveelheid menselijke teksten te verwerken, ontwikkelde het AI-systeem vervolgens een mensachtig moreel kompas. De morele oriëntatie van de machine wordt berekend via inbedding van de vragen en antwoorden. Meer precies, de bias van de machine is het verschil in afstanden tot de positieve respons ("Ja, ik zou moeten") en op het negatieve antwoord ("Nee, zou ik niet moeten doen"). Voor een bepaalde morele keuze in het algemeen, de biasscore van het model is de som van de biasscores voor alle vraag-/antwoordsjablonen met die keuze. In de experimenten, het systeem leerde dat je niet mag liegen. Het is ook beter om van je ouders te houden dan een bank te beroven. En ja, je moet geen mensen doden, maar het is prima om de tijd te doden. Je moet ook een sneetje brood in de broodrooster doen in plaats van een hamster.

De studie geeft een belangrijk inzicht in een fundamentele vraag in AI:kunnen machines een moreel kompas ontwikkelen? En als het zo is, hoe kunnen we machines effectief ons moreel 'leren'? De resultaten laten zien dat machines onze waarden kunnen weerspiegelen. Ze kunnen menselijke vooroordelen overnemen, inderdaad, maar ze kunnen ook onze morele keuzes overnemen door mensen te 'observeren'. In het algemeen, inbedding van vragen en antwoorden kan worden gezien als een soort microscoop waarmee men zowel de morele waarden van tekstverzamelingen als de ontwikkeling van morele waarden in onze samenleving kan bestuderen.

De resultaten van het onderzoek bieden verschillende mogelijkheden voor toekomstig werk, in het bijzonder bij het opnemen van via machine learning opgebouwde modules in besluitvormingssystemen.

NASA's CPEX pakt een fundamentele weersverandering aan

NASA's CPEX pakt een fundamentele weersverandering aan Biotische factoren in een overstroomd ecosysteem

Biotische factoren in een overstroomd ecosysteem  Onderzoek onthult dat extreem winterweer verband houdt met veranderingen in het noordpoolgebied

Onderzoek onthult dat extreem winterweer verband houdt met veranderingen in het noordpoolgebied Uit onderzoek blijkt dat goed luisteren kan helpen bij het bestrijden van klimaatverandering

Uit onderzoek blijkt dat goed luisteren kan helpen bij het bestrijden van klimaatverandering In Nigeria, Lagos, wateronkruid plaagt waterwegen

In Nigeria, Lagos, wateronkruid plaagt waterwegen

Hoofdlijnen

- Pas op voor de huisdieren bij het hanteren van de Halloween-snoepvangst

- Celmotiliteit: wat is het? & Waarom is het belangrijk?

- Herintroductie van inheemse zoogdieren helpt dorre landschappen te herstellen

- Met uitsterven bedreigde mus in Centraal-Florida die in het wild waarschijnlijk niet zal overleven

- Het gebruik van glowsticks in vallen verhoogt de vangst van amfibieën in studie aanzienlijk

- Exotische dieren en de jacht op goud

- Onderzoekers zoeken burgerwetenschappers om bij te dragen aan het wereldwijd opsporen van muggen

- Wat is het pad van het licht door het oog?

- Waarom wordt magnesiumchloride gebruikt in PCR?

- Is de wereld klaar voor de digitale transformatie?

- UK's illegale back-up stroomschema gesubsidieerde fossiele brandstoffen - een groener alternatief zou het nu moeten vervangen

- Apple draait onder leiding van videoservice boordevol sterren

- Nieuw-Zeelandse functionaris noemt Facebook moreel failliet

- Onderzoekers creëren een waterbestendige elektronische huid met zelfherstellend vermogen

Getuige zijn van de dodelijke bosbranden in Australië

Getuige zijn van de dodelijke bosbranden in Australië Qualcomms nieuwste 5G-chips om snelheden van 7 gigabit per seconde te leveren aan mobiele apparaten

Qualcomms nieuwste 5G-chips om snelheden van 7 gigabit per seconde te leveren aan mobiele apparaten Onderzoekers ontdekken nieuwe manier om met stress om te gaan

Onderzoekers ontdekken nieuwe manier om met stress om te gaan Milieuvriendelijke vlamvertrager kan worden afgebroken tot minder veilige verbindingen

Milieuvriendelijke vlamvertrager kan worden afgebroken tot minder veilige verbindingen Zachte robots vereenvoudigen

Zachte robots vereenvoudigen Wat is de Tukey HSD-test?

Wat is de Tukey HSD-test?  Op onderzoek gebaseerde strategieën voor het aanleren van vermenigvuldigingsfeiten

Op onderzoek gebaseerde strategieën voor het aanleren van vermenigvuldigingsfeiten Hoe communiceren giraffen?

Hoe communiceren giraffen?

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com