Wetenschap

AI zou onbetrouwbare lipsynchronisatie tot het verleden kunnen maken

Met het systeem kunnen filmeditors de uitdrukking en hoofdpositie van een acteur veranderen nadat het filmen is voltooid. Krediet:Universiteit van Bath

Onderzoekers hebben een systeem ontwikkeld met behulp van kunstmatige intelligentie dat de gezichtsuitdrukkingen van acteurs kan bewerken om nauwkeurig nagesynchroniseerde stemmen te matchen, tijdwinst en kostenbesparing voor de filmindustrie. Het kan ook worden gebruikt om de blik en hoofdhouding te corrigeren in videoconferenties, en biedt nieuwe mogelijkheden voor video-postproductie en visuele effecten.

De techniek is ontwikkeld door een internationaal team onder leiding van een groep van het Max Planck Instituut voor Informatica en met onderzoekers van de Universiteit van Bath, Technicolor, TU München en Stanford University. Het werk, genaamd diepe videoportretten, werd voor het eerst gepresenteerd op de SIGGRAPH 2018-conferentie in Vancouver op 16 augustus.

In tegenstelling tot eerdere methoden die alleen gericht zijn op bewegingen van de binnenkant van het gezicht, Diepe videoportretten kunnen ook het hele gezicht animeren, inclusief ogen, wenkbrauwen, en hoofdpositie in video's, met behulp van besturingselementen die bekend zijn uit computergraphics gezichtsanimatie. Het kan zelfs een plausibele statische video-achtergrond synthetiseren als het hoofd wordt verplaatst.

Hyeongwoo Kim van het Max Planck Instituut voor Informatica legt uit:"Het werkt door gebruik te maken van op modellen gebaseerde 3D-opname van gezichtsprestaties om de gedetailleerde bewegingen van de wenkbrauwen vast te leggen, mond, neus, en hoofdpositie van de nasynchronisatieacteur in een video. Het transponeert deze bewegingen vervolgens naar de 'target'-acteur in de film om de bewegingen van de lippen en het gezicht nauwkeurig te synchroniseren met de nieuwe audio."

Het onderzoek bevindt zich momenteel in de proof-of-concept-fase en moet nog in realtime werken, de onderzoekers verwachten echter dat de aanpak een echt verschil kan maken voor de visuele entertainmentindustrie.

Professor Christian Theobalt, van het Max Planck Instituut voor Informatica, zei:"Ondanks uitgebreide manipulatie na de productie, het nasynchroniseren van films in vreemde talen levert altijd een mismatch op tussen de acteur op het scherm en de nagesynchroniseerde stem.

"Onze nieuwe Deep Video Portrait-aanpak stelt ons in staat om het uiterlijk van een doelwitacteur te wijzigen door de hoofdhouding over te brengen, gezichtsuitdrukkingen, en oogbewegingen met een hoog niveau van realisme."

Mede-auteur van het artikel, Dr. Christian Richardt, van het motion capture onderzoekscentrum CAMERA van de Universiteit van Bath, voegt toe:"Deze techniek zou ook kunnen worden gebruikt voor postproductie in de filmindustrie, waar computergraphics-bewerking van gezichten al op grote schaal wordt gebruikt in de speelfilms van vandaag."

Een goed voorbeeld is 'The Curious Case of Benjamin Button', waar het gezicht van Brad Pitt in bijna elk frame van de film werd vervangen door een aangepaste grafische computerversie. Dit werk blijft een zeer tijdrovend proces, vaak vele weken werk van opgeleide kunstenaars.

"Deep Video Portraits laat zien hoe zo'n visueel effect in de toekomst met minder inspanning kan worden gecreëerd. Met onze aanpak kunnen zelfs de positionering van het hoofd van een acteur en hun gezichtsuitdrukking gemakkelijk worden bewerkt om de camerahoeken te veranderen of de kadrering van een scène subtiel te veranderen om het verhaal beter te vertellen."

In aanvulling, deze nieuwe aanpak kan ook in andere toepassingen worden gebruikt, die de auteurs laten zien op hun projectwebsite, bijvoorbeeld in video- en VR-teleconferenties, waar het kan worden gebruikt om de blik en hoofdhouding te corrigeren, zodat een meer natuurlijke gespreksomgeving wordt bereikt. De software maakt veel nieuwe creatieve toepassingen mogelijk in de productie van visuele media, maar de auteurs zijn zich ook bewust van het potentieel van misbruik van moderne videobewerkingstechnologie.

Dr. Michael Zollhofer, van de Stanford-universiteit, legt uit:"De media-industrie retoucheert al jaren foto's met fotobewerkingssoftware, wat betekent dat de meesten van ons hebben geleerd om wat we op foto's zien met een korreltje zout te nemen. Met steeds betere videobewerkingstechnologie, we moeten ook kritischer worden over de videocontent die we elke dag consumeren, zeker als er geen bewijs van herkomst is. Wij zijn van mening dat het gebied van digitaal forensisch onderzoek in de toekomst veel meer aandacht moet en zal krijgen om benaderingen te ontwikkelen die automatisch de authenticiteit van een videoclip kunnen bewijzen. Dit zal leiden tot steeds betere benaderingen die dergelijke wijzigingen kunnen herkennen, zelfs als wij mensen ze misschien niet met onze eigen ogen kunnen zien."

Dit behandelen, het onderzoeksteam gebruikt dezelfde technologie om in tandem neurale netwerken te ontwikkelen die zijn getraind om synthetisch gegenereerde of bewerkte video met hoge precisie te detecteren om het gemakkelijker te maken om vervalsingen te herkennen. De auteurs zijn niet van plan om de software publiekelijk beschikbaar te maken, maar stellen dat alle software die de vele creatieve use-cases implementeert, watermerkschema's moet bevatten om wijzigingen duidelijk te markeren.

Het verminderen van zout in Parmigiano Reggiano-kaas heeft mogelijk geen negatieve invloed op de smaak

Het verminderen van zout in Parmigiano Reggiano-kaas heeft mogelijk geen negatieve invloed op de smaak Veiligheidscontrolelijst vóór het lassen

Veiligheidscontrolelijst vóór het lassen  Nieuw ontdekte hybride moleculen zouden kunnen dienen als een nieuwe categorie antikankermiddelen

Nieuw ontdekte hybride moleculen zouden kunnen dienen als een nieuwe categorie antikankermiddelen Wetenschappers voorspellen een nieuw superhard materiaal met unieke eigenschappen

Wetenschappers voorspellen een nieuw superhard materiaal met unieke eigenschappen Een nieuwe eiwit-spin-labelingtechniek

Een nieuwe eiwit-spin-labelingtechniek

Hoofdlijnen

- Een benadering van het hele lichaam om chemosensorische cellen te begrijpen

- Een plantencel maken uit gerecycleerde materialen

- Wat zijn de kenmerken van een cel die een interfase ondergaat?

- Vroege bloeiers:statistische tool onthult effecten van klimaatverandering op planten

- Californische vogels nestelen een week eerder dan een eeuw geleden

- Nieuw voorspellingsmodel voor kantelpunten biedt inzicht in afnemende bijenvolken

- Sumatraanse tijgers op weg naar herstel in gevaar UNESCO-werelderfgoed

- Australische soorten hebben een onafhankelijke kampioen nodig

- Zien in het donker - hoe plantenwortels water waarnemen door middel van groei

- Zwitserse waakhond in contact met cryptogeld-backers van Facebook

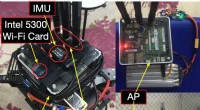

- Een indoor MAV pose-schattingssysteem dat gebruikmaakt van bestaande Wi-Fi-infrastructuur

- Netflix stimuleert productie Europese series

- Uber, Cabify-chauffeurs protesteren in Madrid tegen regelwijzigingen

- Team vindt storing die van invloed kan zijn op meer dan 100 wetenschappelijke onderzoeken

Geknikte nanoporiën vertragen de DNA-passage voor eenvoudigere sequencing

Geknikte nanoporiën vertragen de DNA-passage voor eenvoudigere sequencing Voor de eerste keer, onderzoekers meten krachten die kristallen op één lijn brengen en helpen ze in elkaar te klikken

Voor de eerste keer, onderzoekers meten krachten die kristallen op één lijn brengen en helpen ze in elkaar te klikken Plastic afval heeft enig economisch voordeel voor ontwikkelingslanden

Plastic afval heeft enig economisch voordeel voor ontwikkelingslanden Nanotechnologie verandert het gedrag van materialen

Nanotechnologie verandert het gedrag van materialen Californische dierenwelzijnswetten leidden tot hogere eierprijzen, lagere productie

Californische dierenwelzijnswetten leidden tot hogere eierprijzen, lagere productie VS trekt regelgeving over industriële methaanlekken terug

VS trekt regelgeving over industriële methaanlekken terug Zeolietkatalysatoren effenen de weg naar decentrale chemische processen

Zeolietkatalysatoren effenen de weg naar decentrale chemische processen Hoe zal de toekomst van architectuur de manier waarop we leven veranderen?

Hoe zal de toekomst van architectuur de manier waarop we leven veranderen?

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com