Wetenschap

AI die de patronen van menselijke taal kan leren

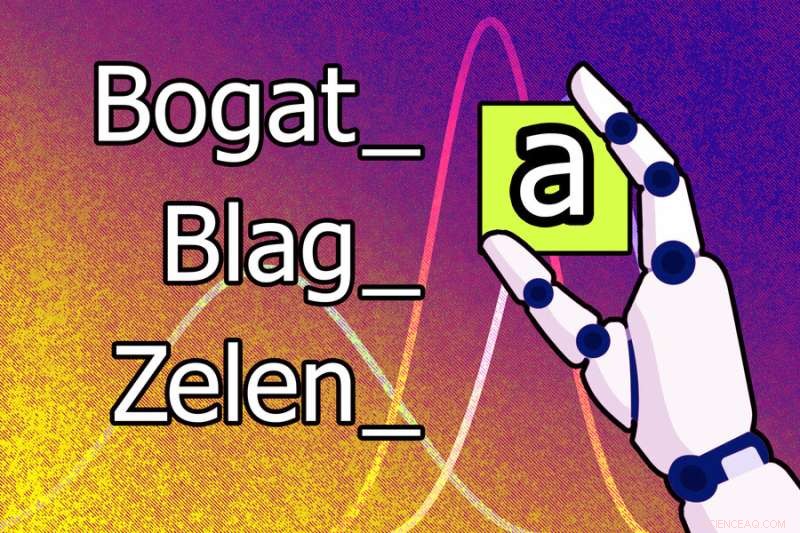

Een nieuw machine learning-model zou kunnen leren dat de letter "a" aan het einde van een woord moet worden toegevoegd om de mannelijke vorm vrouwelijk te maken in het Servo-Kroatisch. De mannelijke vorm van het woord 'bogat' wordt bijvoorbeeld het vrouwelijke 'bogata'. Krediet:Jose-Luis Olivares, MIT

Menselijke talen zijn notoir complex en taalkundigen hebben lang gedacht dat het onmogelijk zou zijn om een machine te leren hoe spraakklanken en woordstructuren te analyseren zoals menselijke onderzoekers dat doen.

Maar onderzoekers van MIT, Cornell University en McGill University hebben een stap in deze richting gezet. Ze hebben een systeem voor kunstmatige intelligentie gedemonstreerd dat zelfstandig de regels en patronen van menselijke talen kan leren.

Wanneer woorden en voorbeelden worden gegeven van hoe die woorden veranderen om verschillende grammaticale functies (zoals tijd, hoofdletters of geslacht) in één taal uit te drukken, komt dit machine-learningmodel met regels die verklaren waarom de vormen van die woorden veranderen. Het kan bijvoorbeeld leren dat de letter "a" aan het einde van een woord moet worden toegevoegd om de mannelijke vorm vrouwelijk te maken in het Servo-Kroatisch.

Dit model kan ook automatisch taalpatronen van een hoger niveau leren die op veel talen van toepassing kunnen zijn, waardoor het betere resultaten kan behalen.

De onderzoekers trainden en testten het model met behulp van problemen uit taalkundige handboeken met 58 verschillende talen. Elk probleem had een reeks woorden en bijbehorende woordvormveranderingen. Het model was in staat om voor 60% van de problemen een correcte set regels te bedenken om die woordvormveranderingen te beschrijven.

Dit systeem zou kunnen worden gebruikt om taalhypothesen te bestuderen en subtiele overeenkomsten te onderzoeken in de manier waarop verschillende talen woorden transformeren. Het is vooral uniek omdat het systeem modellen ontdekt die gemakkelijk door mensen kunnen worden begrepen, en het haalt deze modellen uit kleine hoeveelheden gegevens, zoals enkele tientallen woorden. En in plaats van één enorme dataset voor een enkele taak te gebruiken, gebruikt het systeem veel kleine datasets, wat dichter bij de manier waarop wetenschappers hypothesen stellen – ze kijken naar meerdere gerelateerde datasets en komen met modellen om fenomenen in die datasets te verklaren.

"Een van de motivaties van dit werk was onze wens om systemen te bestuderen die modellen van datasets leren die worden weergegeven op een manier die mensen kunnen begrijpen. Kan het model, in plaats van gewichten te leren, uitdrukkingen of regels leren? En we wilden zien of we zou dit systeem zo kunnen bouwen dat het zou leren van een hele reeks onderling gerelateerde datasets, om het systeem een beetje te laten leren hoe elk ervan beter kan worden gemodelleerd", zegt Kevin Ellis, een assistent-professor informatica aan de Cornell University en hoofdauteur van het papier.

Naast Ellis op het papier zijn MIT-faculteitsleden Adam Albright, een professor in de taalkunde; Armando Solar-Lezama, een professor en associate director van het Computer Science and Artificial Intelligence Laboratory (CSAIL); en Joshua B. Tenenbaum, Paul E. Newton Professor in Cognitive Science and Computation in de afdeling Brain and Cognitive Sciences en lid van CSAIL; evenals senior auteur Timothy J. O'Donnell, assistent-professor in de afdeling Linguïstiek aan McGill University, en Canada CIFAR AI Chair aan het Mila-Quebec Artificial Intelligence Institute.

Het onderzoek is vandaag gepubliceerd in Nature Communications .

Kijken naar taal

In hun zoektocht om een AI-systeem te ontwikkelen dat automatisch een model kan leren uit meerdere gerelateerde datasets, kozen de onderzoekers ervoor om de interactie tussen fonologie (de studie van geluidspatronen) en morfologie (de studie van woordstructuur) te onderzoeken.

Gegevens uit taalkundige leerboeken vormden een ideaal testbed omdat veel talen kernkenmerken delen en leerboekproblemen specifieke taalkundige fenomenen aan het licht brengen. Problemen met leerboeken kunnen ook door universiteitsstudenten op een vrij eenvoudige manier worden opgelost, maar die studenten hebben doorgaans voorkennis over fonologie uit eerdere lessen die ze gebruiken om over nieuwe problemen te redeneren.

Ellis, die zijn Ph.D. aan het MIT en werd gezamenlijk geadviseerd door Tenenbaum en Solar-Lezama, leerde voor het eerst over morfologie en fonologie in een MIT-klas die mede werd gegeven door O'Donnell, die toen postdoc was, en Albright.

"Linguïsten hebben gedacht dat om de regels van een menselijke taal echt te begrijpen, om je in te leven in wat het systeem drijft, je een mens moet zijn. We wilden zien of we de soorten kennis en redeneringen kunnen evenaren die mensen (linguïsten) nemen de taak op zich", zegt Albright.

Om een model te bouwen dat een reeks regels zou kunnen leren voor het samenstellen van woorden, wat een grammatica wordt genoemd, gebruikten de onderzoekers een machine-learningtechniek die bekend staat als Bayesian Program Learning. Met deze techniek lost het model een probleem op door een computerprogramma te schrijven.

In dit geval is het programma de grammatica die volgens het model de meest waarschijnlijke verklaring is van de woorden en betekenissen in een taalkundig probleem. Ze bouwden het model met Sketch, een populaire programmasynthesizer die aan het MIT werd ontwikkeld door Solar-Lezama.

Maar Sketch kan veel tijd kosten om te redeneren over het meest waarschijnlijke programma. Om dit te omzeilen lieten de onderzoekers het model stuk voor stuk werken, een klein programma schrijven om bepaalde gegevens uit te leggen, en vervolgens een groter programma schrijven dat dat kleine programma aanpast om meer gegevens te dekken, enzovoort.

Ze hebben het model ook zo ontworpen dat het leert hoe 'goede' programma's eruitzien. Het kan bijvoorbeeld enkele algemene regels leren over eenvoudige Russische problemen die het zou toepassen op een complexer probleem in het Pools omdat de talen vergelijkbaar zijn. Dit maakt het voor het model gemakkelijker om het Poolse probleem op te lossen.

Problemen met leerboeken aanpakken

Toen ze het model testten met 70 leerboekproblemen, was het in staat om in 60% van de gevallen een grammatica te vinden die overeenkwam met de hele reeks woorden in het probleem, en in 79% van de problemen correct met de meeste woordvormveranderingen.

De onderzoekers probeerden het model ook voor te programmeren met enige kennis die het 'zou moeten' hebben geleerd als het een taalkundecursus volgde, en toonden aan dat het alle problemen beter kon oplossen.

"Een uitdaging van dit werk was om erachter te komen of wat het model deed redelijk was. Dit is geen situatie waarin er één nummer is dat het enige juiste antwoord is. Er is een reeks mogelijke oplossingen die je als goed zou kunnen accepteren, dicht bij rechts, enz.", zegt Albright.

Het model kwam vaak met onverwachte oplossingen. In één geval ontdekte het het verwachte antwoord op een Pools-taalprobleem, maar ook een ander correct antwoord dat misbruik maakte van een fout in het leerboek. Dit toont aan dat het model taalkundige analyses kan "debuggen", zegt Ellis.

De onderzoekers voerden ook tests uit die aantoonden dat het model enkele algemene sjablonen van fonologische regels kon leren die op alle problemen konden worden toegepast.

"Een van de meest verrassende dingen was dat we verschillende talen konden leren, maar het leek geen enorm verschil te maken", zegt Ellis. "Dat suggereert twee dingen. Misschien hebben we betere methoden nodig om over problemen heen te leren. En misschien, als we die methoden niet kunnen bedenken, kan dit werk ons helpen om verschillende ideeën te onderzoeken die we hebben over welke kennis we over problemen heen moeten delen."

In de toekomst willen de onderzoekers hun model gebruiken om onverwachte oplossingen te vinden voor problemen in andere domeinen. Ze zouden de techniek ook kunnen toepassen op meer situaties waarin kennis van een hoger niveau kan worden toegepast op onderling gerelateerde datasets. Misschien kunnen ze bijvoorbeeld een systeem ontwikkelen om differentiaalvergelijkingen af te leiden uit datasets over de beweging van verschillende objecten, zegt Ellis.

"Dit werk laat zien dat we een aantal methoden hebben die tot op zekere hoogte inductieve vooroordelen kunnen leren. Maar ik denk niet dat we, zelfs voor deze leerboekproblemen, de inductieve vooringenomenheid waarmee een taalkundige de plausibele grammatica's accepteert en verwerp de belachelijke", voegt hij eraan toe.

"Dit werk opent veel spannende locaties voor toekomstig onderzoek. Ik ben vooral geïntrigeerd door de mogelijkheid dat de benadering die door Ellis en collega's (Bayesian Program Learning, BPL) is onderzocht, zou kunnen spreken over hoe baby's taal verwerven", zegt T. Florian Jaeger, een hoogleraar hersen- en cognitieve wetenschappen en informatica aan de Universiteit van Rochester, die geen auteur was van dit artikel.

"Toekomstig werk zou zich bijvoorbeeld kunnen afvragen onder welke aanvullende inductievooroordelen (aannames over universele grammatica) de BPL-benadering met succes mensachtig leergedrag kan bereiken op het type gegevens dat baby's observeren tijdens taalverwerving. Ik denk dat het fascinerend zou zijn om te zien of het nu gaat om inductieve vooroordelen die nog abstracter zijn dan die van Ellis en zijn team, zoals vooroordelen die hun oorsprong vinden in de limieten van menselijke informatieverwerking (bijv. geheugenbeperkingen op afhankelijkheidslengte of capaciteitslimieten in de hoeveelheid informatie die per tijd kan worden verwerkt ) - zou voldoende zijn om enkele van de patronen te induceren die in menselijke talen worden waargenomen." + Verder verkennen

Machine learning-model kan de actie in een videoclip identificeren en labelen, zonder de hulp van mensen

Hoe flamingo's de filtering van organisch materiaal in zoute wetlands beïnvloeden

Hoe flamingo's de filtering van organisch materiaal in zoute wetlands beïnvloeden Begrijpen hoe vissers op koraalriffen vissen, kan strategieën voor visserijbeheer informeren

Begrijpen hoe vissers op koraalriffen vissen, kan strategieën voor visserijbeheer informeren Nieuw onderzoeksnetwerk onderzoekt voorwaarden voor meer voedselzekerheid

Nieuw onderzoeksnetwerk onderzoekt voorwaarden voor meer voedselzekerheid Heeft Plastic Corrode?

Heeft Plastic Corrode?  Naarmate het klimaat verandert, een kleine toename van de regenval kan leiden tot wijdverbreide wegonderbrekingen

Naarmate het klimaat verandert, een kleine toename van de regenval kan leiden tot wijdverbreide wegonderbrekingen

Hoofdlijnen

- De positieve kant van een besmettelijk eiwit:stresssensoren bevorderen de overleving van gistcellen

- Wetenschappers ontwikkelen muggen die geen malaria kunnen verspreiden

- Chimpstudie onthult hoe de hersenstructuur onze evolutie heeft gevormd

- Wat is een eencellige eukaryoot?

- Panspermia:zorgden buitenaardse zaden ervoor dat het leven op aarde explodeerde?

- Hebben plantencellen flagella?

- Wilt u dat luidruchtige mijnwerkers minder despotisch zijn? Denk twee keer na voordat je je tuin vult met nectarrijke bloemen

- Wat is de chemische samenstelling van de meeste sterren?

- Maak een lijst van de 3 stappen die zich voordoen tijdens de interfase

- Google maakt 1, 000 nieuwe satellietbeelden met hoge resolutie beschikbaar in Earth View

- Studie onderzoekt minachting wanneer mensen een plek een shithole noemen

- Facebook vernieuwt privacytools nu strengere EU-regels dichterbij komen

- Uber stuurt richting blockbuster IPO terwijl de weg er rotsachtig uitziet (update)

- Een duurzame batterij met een biologisch afbreekbare elektrolyt gemaakt van krabschalen

Stoffen die de impact voor wetenschapsprojecten absorberen

Stoffen die de impact voor wetenschapsprojecten absorberen  Infrarood NASA-beelden bieden Paulettes temperatuurpalet

Infrarood NASA-beelden bieden Paulettes temperatuurpalet De smaak behouden, het verminderen van het zout

De smaak behouden, het verminderen van het zout Beleid waarvan wordt aangenomen dat het het financiële systeem stabiliseert, kan in feite het tegenovergestelde doen, studie vondsten

Beleid waarvan wordt aangenomen dat het het financiële systeem stabiliseert, kan in feite het tegenovergestelde doen, studie vondsten Een gebeurtenis die eens in de miljard jaar wordt uitgelegd:een perfecte storm van vuur en ijs heeft mogelijk geleid tot een sneeuwbaleffect op de aarde

Een gebeurtenis die eens in de miljard jaar wordt uitgelegd:een perfecte storm van vuur en ijs heeft mogelijk geleid tot een sneeuwbaleffect op de aarde Ongebruikelijke neutronenster die elke 76 seconden ronddraait ontdekt op sterrenkerkhof

Ongebruikelijke neutronenster die elke 76 seconden ronddraait ontdekt op sterrenkerkhof NASA selecteert voorstellen om de zon te bestuderen, ruimte omgeving

NASA selecteert voorstellen om de zon te bestuderen, ruimte omgeving Onderzoeksteam ontwikkelt sonde voor batterijonderzoek

Onderzoeksteam ontwikkelt sonde voor batterijonderzoek

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com