Wetenschap

AI kan nu emoties lezen, maar zou dat ook moeten?

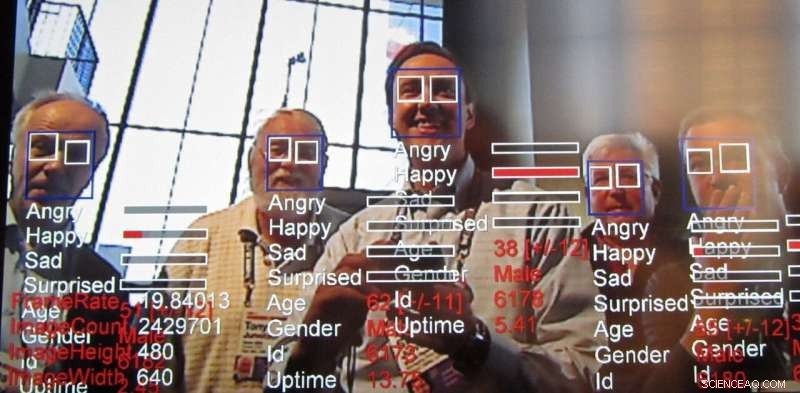

Emotieherkenningstechnologie, een uitvloeisel van gezichtsherkenningstechnologie, gaat snel vooruit. Krediet:Steve Jurvetson / flickr, CC BY-SA

In haar jaarverslag, het AI Now Instituut, een interdisciplinair onderzoekscentrum dat de maatschappelijke implicaties van kunstmatige intelligentie bestudeert, riep op tot een verbod op technologie die is ontworpen om de emoties van mensen in bepaalde gevallen te herkennen. specifiek, de onderzoekers zeiden de herkenningstechnologie te beïnvloeden, ook wel emotieherkenningstechnologie genoemd, mag niet worden gebruikt bij beslissingen die "van invloed zijn op het leven van mensen en de toegang tot kansen, " zoals aanwervingsbeslissingen of pijnbeoordelingen, omdat het niet voldoende nauwkeurig is en kan leiden tot vooringenomen beslissingen.

Wat is deze technologie, die al wordt gebruikt en op de markt wordt gebracht, en waarom baart het zorgen?

Uitgroei van gezichtsherkenning

Onderzoekers hebben actief gewerkt aan computervisie-algoritmen die de emoties en intentie van mensen kunnen bepalen, samen met het maken van andere gevolgtrekkingen, voor minstens een decennium. Analyse van gezichtsuitdrukkingen bestaat al sinds 2003. Computers kunnen emoties nog langer begrijpen. Deze nieuwste technologie is gebaseerd op de datacentrische technieken die bekend staan als "machine learning, " algoritmen die gegevens verwerken om te "leren" beslissingen te nemen, om een nog nauwkeurigere affectherkenning te bereiken.

De uitdaging van het lezen van emoties

Onderzoekers zijn altijd op zoek naar nieuwe dingen door voort te bouwen op wat eerder is gedaan. Emotieherkenning is aanlokkelijk omdat, op de een of andere manier, wij als mensen kunnen dit al van jongs af aan relatief goed, en toch is het nog steeds een uitdaging om die menselijke vaardigheid te repliceren met behulp van computervisie. Hoewel het mogelijk is om behoorlijk opmerkelijke dingen te doen met afbeeldingen, zoals het stileren van een foto om het te laten lijken alsof het door een beroemde kunstenaar is getekend en zelfs fotorealistische gezichten te creëren - om nog maar te zwijgen van het maken van zogenaamde deepfakes - het vermogen om eigenschappen zoals menselijke emoties af te leiden uit een echt beeld heeft altijd interessant voor onderzoekers.

Emoties zijn moeilijk omdat ze vaak afhankelijk zijn van de context. Bijvoorbeeld, wanneer iemand zich op iets concentreert, kan het lijken alsof hij gewoon denkt. Gezichtsherkenning heeft een lange weg afgelegd met behulp van machine learning, maar het identificeren van iemands emotionele toestand louter gebaseerd op het kijken naar iemands gezicht, mist belangrijke informatie. Emoties worden niet alleen uitgedrukt door de uitdrukking van een persoon, maar ook door waar ze zijn en wat ze doen. Deze contextuele aanwijzingen zijn zelfs moeilijk in te voeren in moderne algoritmen voor machine learning. Dit behandelen, er zijn actieve inspanningen om kunstmatige-intelligentietechnieken te verbeteren om context te overwegen, niet alleen voor emotieherkenning maar voor allerlei toepassingen.

Emoties van werknemers lezen

Het rapport uitgebracht door AI Now werpt licht op enkele manieren waarop AI wordt toegepast op het personeelsbestand om de productiviteit van werknemers te evalueren en zelfs al in de interviewfase. Analyseren van beelden van interviews, speciaal voor werkzoekenden op afstand, is al aan de gang. Als managers van interview tot evaluatie een idee kunnen krijgen van de emoties van hun ondergeschikten, besluitvorming over andere arbeidszaken zoals loonsverhogingen, promoties of opdrachten kunnen uiteindelijk worden beïnvloed door die informatie. Maar er zijn veel andere manieren waarop deze technologie kan worden gebruikt.

Waarom de zorgen?

Dit soort systemen hebben bijna altijd eerlijkheid, verantwoordelijkheid, transparantie en ethische ("FATE") gebreken ingebakken in hun patroonovereenkomst. Bijvoorbeeld, een onderzoek wees uit dat gezichtsherkenningsalgoritmen gezichten van zwarte mensen als bozer beoordeelden dan blanke gezichten, zelfs als ze lachten.

Veel onderzoeksgroepen pakken dit probleem aan, maar het lijkt op dit moment duidelijk dat het probleem niet uitsluitend op technologisch niveau kan worden opgelost. Kwesties met betrekking tot FATE in AI vereisen een voortdurende en gezamenlijke inspanning van degenen die de technologie gebruiken om zich bewust te zijn van deze problemen en ze aan te pakken. Zoals het AI Now-rapport benadrukt:"Ondanks de toename van de inhoud van AI-ethiek … richten ethische principes en verklaringen zich zelden op hoe AI-ethiek kan worden geïmplementeerd en of ze effectief zijn." Het merkt op dat dergelijke ethische verklaringen over AI grotendeels voorbijgaan aan vragen over hoe, waar, en wie dergelijke richtlijnen in werking zal stellen. In werkelijkheid, het is waarschijnlijk dat iedereen zich bewust moet zijn van de soorten vooroordelen en zwakheden die deze systemen vertonen, vergelijkbaar met hoe we ons bewust moeten zijn van onze eigen vooroordelen en die van anderen.

Het probleem met algemene technologieverboden

Grotere nauwkeurigheid en gemak bij aanhoudende monitoring brengen andere zorgen met zich mee dan ethiek. Er zijn ook tal van algemene technologiegerelateerde privacykwesties, variërend van de verspreiding van camera's die dienen als politiefeeds tot het mogelijk anoniem maken van gevoelige gegevens.

Met deze ethische en privacykwesties, een natuurlijke reactie zou kunnen zijn om te pleiten voor een verbod op deze technieken. Zeker, AI toepassen op de resultaten van sollicitatiegesprekken of strafrechtelijke veroordelingsprocedures lijkt gevaarlijk als de systemen leren vooroordelen of anderszins onbetrouwbaar zijn. Er zijn echter handige toepassingen, bijvoorbeeld bij het helpen herkennen van waarschuwingsborden om zelfmoord onder jongeren te voorkomen en bij het opsporen van dronken bestuurders. Dat is een reden waarom zelfs bezorgde onderzoekers, regelgevers en burgers zijn over het algemeen gestopt met oproepen tot algemene verboden op AI-gerelateerde technologieën.

Combinatie van AI en menselijk oordeel

uiteindelijk, technologieontwerpers en de samenleving als geheel moeten goed kijken hoe informatie uit AI-systemen wordt geïnjecteerd in besluitvormingsprocessen. Deze systemen kunnen net als elke andere vorm van intelligentie onjuiste resultaten geven. Ze zijn ook notoir slecht in het beoordelen van hun eigen zelfvertrouwen, niet anders dan mensen, zelfs bij eenvoudigere taken zoals het vermogen om objecten te herkennen. Er blijven ook aanzienlijke technische uitdagingen bij het lezen van emoties, met name rekening houdend met de context om emoties af te leiden.

Als mensen vertrouwen op een systeem dat niet nauwkeurig is bij het nemen van beslissingen, de gebruikers van dat systeem zijn slechter af. Het is ook bekend dat mensen deze systemen meer vertrouwen dan andere gezagsdragers. In het licht hiervan, wij als samenleving moeten zorgvuldig nadenken over de eerlijkheid van deze systemen, verantwoordelijkheid, transparantie en ethiek, zowel tijdens ontwerp als toepassing, altijd een mens als de uiteindelijke beslisser houden.

Dit artikel is opnieuw gepubliceerd vanuit The Conversation onder een Creative Commons-licentie. Lees het originele artikel.

Hoe pathogene bacteriën een plakkerig adhesie-eiwit bereiden

Hoe pathogene bacteriën een plakkerig adhesie-eiwit bereiden Gebruikmaken van geometrische frustratie om batterijen af te stemmen voor meer vermogen

Gebruikmaken van geometrische frustratie om batterijen af te stemmen voor meer vermogen Chemici nemen de plek waar water en lucht samenkomen onder de loep

Chemici nemen de plek waar water en lucht samenkomen onder de loep Synthetische bedrukte polymeren herkend door DNA

Synthetische bedrukte polymeren herkend door DNA Nieuwe combinatie van materialen zorgt voor recordbrekende lithium-metaalcel

Nieuwe combinatie van materialen zorgt voor recordbrekende lithium-metaalcel

Bosnische hoofdstad Sarajevo getroffen door gevaarlijke luchtvervuiling

Bosnische hoofdstad Sarajevo getroffen door gevaarlijke luchtvervuiling Studie onderzoekt de impact van zwarte mangroven op het voedselweb van kwelder

Studie onderzoekt de impact van zwarte mangroven op het voedselweb van kwelder Ozonafbrekende chemische alternatieven die in ons voedsel en water terechtkomen

Ozonafbrekende chemische alternatieven die in ons voedsel en water terechtkomen Onderzoekers ontdekken nieuwe stikstofbron in Arctisch gebied

Onderzoekers ontdekken nieuwe stikstofbron in Arctisch gebied Onmogelijk om aan te passen:Verrassend snel smelten van ijs in het verleden verhoogt de angst voor zeespiegelstijging

Onmogelijk om aan te passen:Verrassend snel smelten van ijs in het verleden verhoogt de angst voor zeespiegelstijging

Hoofdlijnen

- "Recessive Allele: What is it?", 3, [[& Waarom gebeurt het? (met eigenschappenkaart)

- De nadelen van biotechnologie

- Waarom het uitsterven van parasieten een probleem kan zijn voor bedreigde woylies

- Voetafdrukken gebruiken om reuzenpanda's in het wild te identificeren en te volgen

- Soorten instrumenten die worden gebruikt voor het meten van lichaamstemperaturen

- Interessante feiten over plantencellen

- Wat gebeurt er met een dierlijke cel in een hypotone oplossing?

- Wetenschapsprojecten: roken en de effecten ervan op de longen

- Inheemse vissoorten lopen gevaar na verwijdering van water uit de Colorado-rivier

- privacy, eens verborgen onderwerp, krijgt aandacht op CES tech show

- Ingenieurs helpen met water onder de brug en andere moeilijke milieubeslissingen

- Een nieuwe methode om robotonvermogen uit te drukken

- De onbenutte kracht van brandstofcellen

- Verlammende kosten van oorlogsverslaggeving en onderzoeksjournalistiek

Deze klimaatactivisten willen dat je de hoop opgeeft

Deze klimaatactivisten willen dat je de hoop opgeeft Afgestudeerde student ziet als eerste asteroïde voorbij de aarde razen

Afgestudeerde student ziet als eerste asteroïde voorbij de aarde razen Waarom vormen de meeste atomen chemische bindingen?

Waarom vormen de meeste atomen chemische bindingen?  Nieuwe verwarmde jas houdt politie, militairen en anderen warm bij barre wintertemperaturen

Nieuwe verwarmde jas houdt politie, militairen en anderen warm bij barre wintertemperaturen Om het elektriciteitsnet van koolstof te ontdoen, ondersteuning van groene energie ondersteunen

Om het elektriciteitsnet van koolstof te ontdoen, ondersteuning van groene energie ondersteunen Dierenartsen voeren de eerste bekende hersenoperatie uit om hydrocephalus bij pelsrobben te behandelen

Dierenartsen voeren de eerste bekende hersenoperatie uit om hydrocephalus bij pelsrobben te behandelen Wetenschappers onderzoeken impact van zeer ernstige branden op naaldbossen

Wetenschappers onderzoeken impact van zeer ernstige branden op naaldbossen Het gebruik van sociale media door kinderen creëert een nieuw type digital native

Het gebruik van sociale media door kinderen creëert een nieuw type digital native

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Swedish | Dutch | Danish | Norway | Portuguese | German |

-

Wetenschap © https://nl.scienceaq.com