Wetenschap

Groeien en snoeien AI bootst hersenontwikkeling na, vermindert energieverbruik

Princeton-onderzoekers, onder leiding van professor elektrotechniek Niraj Jha, ontwikkelde een techniek die geavanceerde kunstmatige-intelligentieprogramma's produceert voor draagbare apparaten zoals een smartwatch. Door de ontwikkelingsboog van de hersenen na te bootsen, de nieuwe aanpak leidt tot benchmarknauwkeurigheid met een fractie van de energie van andere systemen. Van links:Prerit Terway, Hongxu Yin, Niraj Jha, Seyed Shayan Hassantabar. Krediet:Sameer A. Khan/Fotobuddy

Het kan als een schok komen voor ouders die geconfronteerd worden met de dagelijkse chaos van het peuterleven, maar de complexiteit van de hersenen piekt rond de leeftijd van drie.

Het aantal verbindingen tussen neuronen explodeert vrijwel in onze eerste jaren. Daarna beginnen de hersenen ongebruikte delen van dit enorme elektrische netwerk weg te snoeien, afvallen tot ongeveer de helft van het aantal tegen de tijd dat we volwassen zijn. De over-voorziening van het peuterbrein stelt ons in staat om taal te verwerven en fijne motoriek te ontwikkelen. Maar wat we niet gebruiken, we verliezen.

Nu heeft deze eb en vloed van biologische complexiteit een team van onderzoekers in Princeton geïnspireerd om een nieuw model voor kunstmatige intelligentie te creëren. het creëren van programma's die voldoen aan of overtreffen de industrienormen voor nauwkeurigheid met slechts een fractie van de energie. In een paar artikelen die eerder dit jaar werden gepubliceerd, lieten de onderzoekers zien hoe te beginnen met een eenvoudig ontwerp voor een AI-netwerk, het netwerk laten groeien door kunstmatige neuronen en verbindingen toe te voegen, Snoei vervolgens ongebruikte porties weg en laat een mager maar zeer effectief eindproduct achter.

"Onze aanpak is wat we een groei-en-snoei-paradigma noemen, ', zegt hoogleraar elektrotechniek Niraj Jha. 'Het is vergelijkbaar met wat een brein doet van baby tot peuter.' het menselijk brein begint verbindingen tussen hersencellen weg te knippen. Dit proces gaat door tot in de volwassenheid, zodat het volledig ontwikkelde brein op ongeveer de helft van zijn synaptische piek werkt.

"Het volwassen brein is gespecialiseerd in de training die we het hebben gegeven, "Zei Jha. "Het is niet zo goed voor algemeen leren als een peuterbrein."

Groeien en snoeien resulteert in software die een fractie van de rekenkracht vereist, en verbruikt dus veel minder energie, even goede voorspellingen over de wereld te doen. Het beperken van het energieverbruik is van cruciaal belang om dit soort geavanceerde AI, machine learning genaamd, op kleine apparaten zoals telefoons en horloges te krijgen.

"Het is erg belangrijk om de machine learning-modellen lokaal uit te voeren, omdat transmissie [naar de cloud] veel energie kost, " zei Xiaoliang Dai, een voormalige Princeton-afgestudeerde student en eerste auteur van de twee papers. Dai is nu onderzoekswetenschapper bij Facebook.

In de eerste studie, de onderzoekers onderzochten opnieuw de fundamenten van machine learning - de abstracte codestructuren die kunstmatige neurale netwerken worden genoemd. Inspiratie putten uit de ontwikkeling van de vroege kinderjaren, het team ontwierp een neurale netwerksynthesetool (NeST) die verschillende top neurale netwerken helemaal opnieuw creëerde, automatisch, met behulp van geavanceerde wiskundige modellen die voor het eerst werden ontwikkeld in de jaren tachtig.

NeST begint met slechts een klein aantal kunstmatige neuronen en verbindingen, neemt toe in complexiteit door meer neuronen en verbindingen aan het netwerk toe te voegen, en zodra het voldoet aan een bepaalde prestatiebenchmark, begint te versmallen met de tijd en training. Eerdere onderzoekers hadden vergelijkbare snoeistrategieën toegepast, maar de combinatie van groeien en snoeien - van het 'babybrein' naar het 'peuterbrein' en afslanken naar het 'volwassenenbrein' - betekende een sprong van oude theorie naar nieuwe demonstratie.

Het tweede papier, waaronder medewerkers van Facebook en de University of California-Berkeley, introduceerde een raamwerk genaamd Chameleon dat begint met de gewenste resultaten en achteruit werkt om de juiste tool voor de klus te vinden. Met honderdduizenden variaties beschikbaar in de specifieke facetten van een ontwerp, ingenieurs worden geconfronteerd met een keuzeparadox die veel verder gaat dan de menselijke capaciteit. Bijvoorbeeld:de architectuur voor het aanbevelen van films lijkt niet op de architectuur die tumoren herkent. Het systeem dat is afgestemd op longkanker ziet er anders uit dan dat voor baarmoederhalskanker. Dementie-assistenten kunnen er voor vrouwen en mannen anders uitzien. Enzovoort, tot in het oneindige.

Jha beschreef Chameleon als het sturen van ingenieurs naar een gunstige subset van ontwerpen. "Het geeft me een goede buurt, en ik kan het in CPU-minuten doen, "Jha zei, verwijzend naar een maat voor computationele procestijd. "Dus ik kan heel snel de beste architectuur krijgen." In plaats van de hele uitgestrekte metropool, men hoeft maar een paar straten te zoeken.

Chameleon werkt door het trainen en samplen van een relatief klein aantal architecturen die een breed scala aan opties vertegenwoordigen, voorspelt vervolgens de prestaties van die ontwerpen met een bepaalde reeks voorwaarden. Omdat het de aanloopkosten verlaagt en werkt binnen lean platforms, de zeer adaptieve benadering "kan de toegang tot neurale netwerken uitbreiden voor onderzoeksorganisaties die momenteel niet over de middelen beschikken om van deze technologie te profiteren, " volgens een blogpost van Facebook.

Hoofdlijnen

- Afnemende babyzangvogels hebben bossen nodig om droogte te overleven

- Canadese kariboes, habitat blijft afnemen:rapport

- Een studie schakelt over van genetische naar metabole analyse om het evolutionaire proces te reconstrueren

- De jacht op een van de Top 50 meest gezochte schimmels is voorbij

- Evolutionair gewasonderzoek:Egoplanten geven lagere opbrengst

- Is intelligentie een genetisch kenmerk?

- Amerikaanse eiken delen een gemeenschappelijke noordelijke voorouder

- Dengue Achilleshiel inzicht biedt hoop op betere vaccins

- Op bewijs gebaseerde tips om uw geheugen te verbeteren

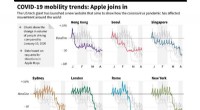

- Apple-gegevens tonen dramatische impact van virus op beweging

- Qantas onderzocht over het gebruik van een crisis om rivaal tot zinken te brengen

- Piloten British Airways blazen derde staking af

- Zonne-energie - grootste studie tot nu toe ontdekt 25 procent stroomverlies in het VK

- Tesla-aandelen stuiteren omdat Musk het risico als overdreven wordt beschouwd

Soorten spijsverteringsenzymen

Soorten spijsverteringsenzymen  Hubbles op de eerste rij wanneer sterrenstelsels botsen

Hubbles op de eerste rij wanneer sterrenstelsels botsen Wassen van roestvast staal

Wassen van roestvast staal Door Gannett gesteunde Scroll lanceert abonnementsservice voor advertentievrije journalistiek

Door Gannett gesteunde Scroll lanceert abonnementsservice voor advertentievrije journalistiek Recordbrekende oceaantemperaturen wijzen op trends van het broeikaseffect

Recordbrekende oceaantemperaturen wijzen op trends van het broeikaseffect Eerste directe datering van Homo antecessor

Eerste directe datering van Homo antecessor Coördinatiechemie van anionen door halogeenbindingsinteracties

Coördinatiechemie van anionen door halogeenbindingsinteracties Effect van fotochemische smog

Effect van fotochemische smog

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Portuguese | Swedish | German | Dutch | Danish | Norway | Spanish |

-

Wetenschap © https://nl.scienceaq.com