Wetenschap

Online haatzaaien kan worden ingeperkt als een computervirus, onderzoekers zeggen:

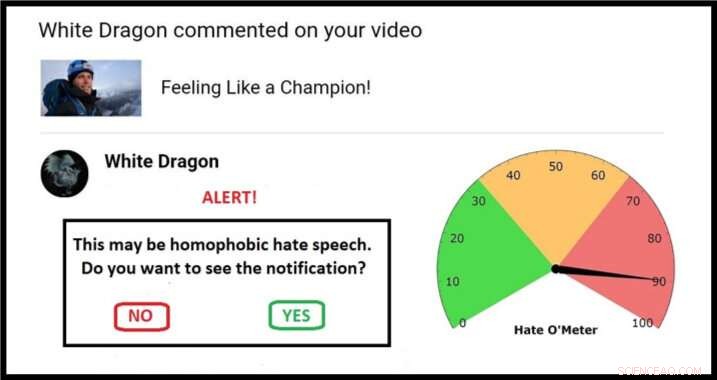

Voorbeeld van een mogelijke aanpak voor een quarantainescherm, compleet met Hate O'Meter. Krediet:Stefanie Ullman

De verspreiding van haatzaaiende uitlatingen via sociale media kan worden aangepakt met dezelfde 'quarantaine'-aanpak die wordt gebruikt om kwaadaardige software te bestrijden, volgens onderzoekers van de Universiteit van Cambridge.

Definities van haatzaaiende uitlatingen verschillen per land, recht en platform, en alleen het blokkeren van trefwoorden heeft geen effect:grafische beschrijvingen van geweld hoeven geen duidelijke etnische laster te bevatten om racistische doodsbedreigingen te vormen, bijvoorbeeld.

Als zodanig, haatdragende taal is moeilijk automatisch te detecteren. Het moet worden gemeld door degenen die eraan worden blootgesteld, nadat de beoogde "psychische schade" is toegebracht, met legers van moderators die nodig zijn om elke zaak te beoordelen.

Dit is de nieuwe frontlinie van een oud debat:vrijheid van meningsuiting versus giftige taal.

Nutsvoorzieningen, een ingenieur en een taalkundige hebben een voorstel in het tijdschrift gepubliceerd Ethiek en informatietechnologie dat gebruikmaakt van cyberbeveiligingstechnieken om controle te geven aan degenen die het doelwit zijn, zonder toevlucht te nemen tot censuur.

De taal- en machine learning-experts van Cambridge gebruiken databases met bedreigingen en gewelddadige beledigingen om algoritmen te bouwen die een score kunnen geven voor de waarschijnlijkheid van een online bericht dat vormen van haatzaaien bevat.

Naarmate deze algoritmen worden verfijnd, potentiële haatzaaiende uitlatingen kunnen worden geïdentificeerd en in quarantaine worden geplaatst. Gebruikers zouden een waarschuwing ontvangen met een "Hate O'Meter" - de score voor de ernst van haatspraak - de naam van de afzender, en een optie om de inhoud te bekijken of ongezien te verwijderen.

Deze aanpak is verwant aan spam- en malwarefilters, en onderzoekers van het project 'Giving Voice to Digital Democracies' geloven dat het de hoeveelheid haatzaaiende uitlatingen die mensen moeten ervaren drastisch kan verminderen. Ze streven ernaar om begin 2020 een prototype klaar te hebben.

"Haatdragende taal is een vorm van opzettelijke online schade, zoals malware, en kan daarom worden afgehandeld door middel van quarantaine, " zei co-auteur en taalkundige Dr. Stefanie Ullman. "In feite, veel haatzaaien wordt eigenlijk gegenereerd door software zoals Twitter-bots."

"Bedrijven als Facebook, Twitter en Google reageren over het algemeen reactief op haatzaaiende uitlatingen, " zei co-auteur en ingenieur Dr. Marcus Tomalin. "Dit is misschien goed voor degenen die het niet vaak tegenkomen. Voor anderen is het te weinig, te laat."

"Veel vrouwen en mensen uit minderheidsgroepen in de publieke belangstelling ontvangen anonieme haatzaaiende uitlatingen omdat ze het aandurven om online aanwezig te zijn. We zien dat dit mensen ervan weerhoudt om het openbare leven binnen te gaan of door te gaan, vaak die van groepen die behoefte hebben aan meer vertegenwoordiging, " hij zei.

De voormalige Amerikaanse minister van Buitenlandse Zaken Hillary Clinton vertelde onlangs aan een Brits publiek dat haatzaaiende uitlatingen een "bedreiging voor democratieën" vormen. in het kielzog van veel vrouwelijke parlementsleden die online misbruik aanhaalden als een van de redenen waarom ze niet langer verkiesbaar zouden zijn.

Terwijl in een adres van de Georgetown University, Facebook-CEO Mark Zuckerberg sprak van "brede meningsverschillen over wat kwalificeert als haat" en betoogde:"we moeten de fout maken aan de kant van meer meningsuiting".

De onderzoekers zeggen dat hun voorstel geen wondermiddel is, maar het zit tussen de "extreem libertaire en autoritaire benaderingen" in van het volledig toestaan of verbieden van bepaalde taal online.

belangrijk, de gebruiker wordt de scheidsrechter. "Veel mensen houden niet van het idee dat een niet-gekozen bedrijf of een micromanagende regering beslist wat we wel en niet tegen elkaar kunnen zeggen. ' zei Tomalin.

"Ons systeem zal aangeven wanneer u voorzichtig moet zijn, maar het is altijd jouw beslissing. Het weerhoudt mensen er niet van om te posten of te bekijken wat ze leuk vinden, maar het geeft de broodnodige controle aan degenen die worden overspoeld met haat."

In de krant, de onderzoekers verwijzen naar detectie-algoritmen die 60% nauwkeurigheid bereiken - niet veel beter dan toeval. Tomalin's machine learning lab heeft dit nu tot 80%, en hij verwacht een voortdurende verbetering van de wiskundige modellering.

In de tussentijd, Ullman verzamelt meer "trainingsgegevens":geverifieerde haatspraak waarvan de algoritmen kunnen leren. Dit helpt bij het verfijnen van de "betrouwbaarheidsscores" die een quarantaine en daaropvolgende Hate O'Meter-uitlezing bepalen, die kan worden ingesteld als een gevoeligheidsknop, afhankelijk van de voorkeur van de gebruiker.

Een eenvoudig voorbeeld zou een woord als 'bitch' kunnen zijn:een vrouwonvriendelijke smet, maar ook een legitieme term in contexten zoals het fokken van honden. Het is de algoritmische analyse van waar zo'n woord syntactisch staat - de soorten omringende woorden en semantische relaties daartussen - die de score voor haatspraak bepaalt.

"Het identificeren van individuele zoekwoorden is niet genoeg, we kijken naar hele zinsstructuren en veel verder. Sociolinguïstische informatie in gebruikersprofielen en postgeschiedenissen kunnen allemaal helpen bij het verbeteren van het classificatieproces, ' zei Ullman.

Tomalin toegevoegd:"Door geautomatiseerde quarantaines die richtlijnen geven over de kracht van hatelijke inhoud, we kunnen degenen aan de ontvangende kant van de haatspraak die onze online verhandelingen vergiftigt, machtigen."

Echter, de onderzoekers, die werken in Cambridge's Centre for Research into Arts, Geesteswetenschappen en Sociale Wetenschappen (CRASSH), zeggen dat - net als bij computervirussen - er altijd een wapenwedloop zal zijn tussen haatzaaiende uitlatingen en systemen om dit te beperken.

Het project is ook begonnen te kijken naar "tegenspraak":de manieren waarop mensen reageren op haatzaaiende uitlatingen. De onderzoekers zijn van plan om discussies aan te zwengelen over hoe virtuele assistenten zoals 'Siri' moeten reageren op bedreigingen en intimidatie.

Wat zijn de 5 nieuwe eigenschappen van water?

Wat zijn de 5 nieuwe eigenschappen van water?  Op cellulose-nanofibril gebaseerde inkapselingsstructuur om de afgifte van geneesmiddelen te regelen

Op cellulose-nanofibril gebaseerde inkapselingsstructuur om de afgifte van geneesmiddelen te regelen Team ontwikkelt productieproces voor biobrandstof in samenwerking met Noord-Amerikaanse onderzoekers

Team ontwikkelt productieproces voor biobrandstof in samenwerking met Noord-Amerikaanse onderzoekers Structureel bewijs voor een dynamische metallocofactor tijdens distikstofreductie door Mo-nitrogenase

Structureel bewijs voor een dynamische metallocofactor tijdens distikstofreductie door Mo-nitrogenase Verschillen tussen grafiet en koolstofvezel

Verschillen tussen grafiet en koolstofvezel

Chinese vee-revolutie vereist nieuwe transitie

Chinese vee-revolutie vereist nieuwe transitie Nieuw onderzoek zal de rundvleesindustrie helpen om de duurzaamheid te vergroten

Nieuw onderzoek zal de rundvleesindustrie helpen om de duurzaamheid te vergroten Historische klimaatgegevens in de Oost-Aziatische regio redden

Historische klimaatgegevens in de Oost-Aziatische regio redden Hoe gymnasten te beschermen tegen gevaarlijke chemicaliën in sportschoolfaciliteiten?

Hoe gymnasten te beschermen tegen gevaarlijke chemicaliën in sportschoolfaciliteiten? Egeïsche vrijwilligers strijden om het tij van plastic afval te keren

Egeïsche vrijwilligers strijden om het tij van plastic afval te keren

Hoofdlijnen

- Wat is een eigenschap die het resultaat is van twee dominante genen?

- Hoe groeit schimmel op brood?

- Hoe erg is zwarte schimmel,

- Wat gebeurt er als een kind wordt geboren met een extra chromosoom in het 23e paar?

- Onderzoekers onthullen nieuwe inzichten in de controle van cellulaire steigers

- nieuwe ontdekking, meer bijen markeren Michigans eerst, volledige bijentelling

- Natuurlijke selectie: definitie, Darwins-theorie, voorbeelden en feiten

- Fysieke aanpassingen van rondwormen

- Een enzym dat de vorming van het DNA katalyseert Molecuul

- Draadloos drukgevoelig oogimplantaat kan blindheid helpen voorkomen

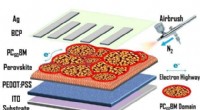

- Onderzoekers lossen grote uitdaging op bij massaproductie van goedkope zonnecellen

- Elektriciteitsgebruik in de cloud

- Motormaker Rolls-Royce maakt weer winst

- Robot gebruikt kunstmatige intelligentie en beeldvorming om bloed af te nemen

Export van gebruikte auto's zorgt voor vervuiling naar ontwikkelingslanden:VN-studie

Export van gebruikte auto's zorgt voor vervuiling naar ontwikkelingslanden:VN-studie Plastic in zee kost de samenleving miljarden dollars

Plastic in zee kost de samenleving miljarden dollars Het produceren van betere handleidingen voor medische beeldanalyse

Het produceren van betere handleidingen voor medische beeldanalyse Japanse capsule met asteroïde-monsters teruggevonden in Australië

Japanse capsule met asteroïde-monsters teruggevonden in Australië Spanningen in het drugsbeleid en de preventiestrategieën voor overdosis

Spanningen in het drugsbeleid en de preventiestrategieën voor overdosis Mojave Indian Tools

Mojave Indian Tools Soorten collageenvezels

Soorten collageenvezels Geweld een kwestie van schaal, niet kwantiteit, onderzoekers laten zien

Geweld een kwestie van schaal, niet kwantiteit, onderzoekers laten zien

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com