Wetenschap

Nieuwe tool laat zien wat generatieve modellen weglaten bij het reconstrueren van een scène

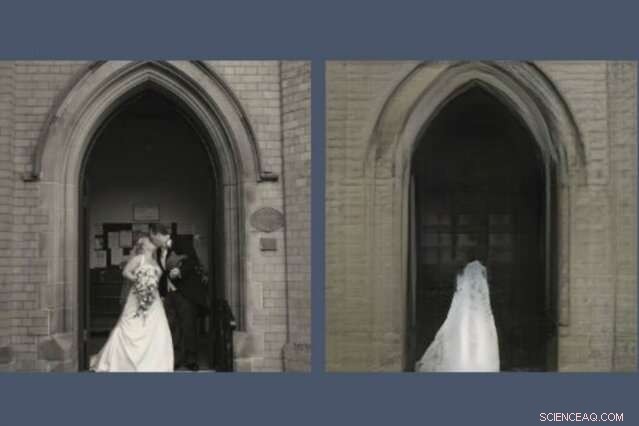

Een nieuwe tool onthult wat AI-modellen weglaten bij het opnieuw creëren van een scène. Hier, een GAN, of generatief vijandig netwerk, heeft het pasgetrouwde stel laten vallen uit de reconstructie (rechts) van de foto die het moest tekenen (links). Krediet:Massachusetts Institute of Technology

Iedereen die tijd op sociale media heeft doorgebracht, heeft waarschijnlijk gemerkt dat GAN's, of generatieve vijandige netwerken, zijn opmerkelijk goed geworden in het tekenen van gezichten. Ze kunnen voorspellen hoe je eruit zult zien als je oud bent en hoe je eruit zou zien als beroemdheid. Maar vraag een GAN om scènes uit de grotere wereld te tekenen en het wordt raar.

Een nieuwe demo van het MIT-IBM Watson AI Lab onthult wat een model dat getraind is op scènes van kerken en monumenten besluit weg te laten wanneer het zijn eigen versie van tekent, zeggen, het Pantheon in Parijs, of de Piazza di Spagna in Rome. De grotere studie, Zien wat een GAN niet kan genereren, werd vorige week gepresenteerd op de International Conference on Computer Vision.

"Onderzoekers richten zich doorgaans op het karakteriseren en verbeteren van wat een machine learning-systeem kan doen - waar het aandacht aan besteedt, en hoe bepaalde inputs leiden tot bepaalde outputs, " zegt David Bau, een afgestudeerde student aan het MIT's Department of Electrical Engineering and Computer Science and Computer Science and Artificial Science Laboratory (CSAIL). "Met dit werk we hopen dat onderzoekers evenveel aandacht zullen besteden aan het karakteriseren van de gegevens die deze systemen negeren."

In een GAN, een paar neurale netwerken werken samen om hyperrealistische beelden te creëren die zijn gemodelleerd naar voorbeelden die ze hebben gekregen. Bau raakte geïnteresseerd in GAN's als een manier om in black-box neurale netwerken te kijken om de redenering achter hun beslissingen te begrijpen. Een eerdere tool ontwikkeld met zijn adviseur, MIT-professor Antonio Torralba, en IBM-onderzoeker Hendrik Strobelt, maakte het mogelijk om de clusters van kunstmatige neuronen te identificeren die verantwoordelijk zijn voor het organiseren van het beeld in echte categorieën zoals deuren, bomen, en wolken. Een verwant hulpmiddel, GANverf, laat amateurkunstenaars die functies toevoegen aan en verwijderen uit hun eigen foto's.

Op een dag, terwijl je een artiest helpt GANPaint te gebruiken, Bau stuitte op een probleem. "Zoals gewoonlijk, we jaagden op de cijfers, numeriek reconstructieverlies proberen te optimaliseren om de foto te reconstrueren, " zegt hij. "Maar mijn adviseur heeft ons altijd aangemoedigd om verder te kijken dan de cijfers en de daadwerkelijke beelden te onderzoeken. Toen we keken, het fenomeen sprong er meteen uit:mensen werden selectief afgehaakt."

Net zoals GAN's en andere neurale netwerken patronen vinden in stapels gegevens, ze negeren patronen, te. Bau en zijn collega's trainden verschillende soorten GAN's op binnen- en buitenscènes. Maar waar de foto's ook zijn genomen, de GAN's lieten consequent belangrijke details weg, zoals mensen, auto's, tekens, fonteinen, en meubels, zelfs wanneer die objecten prominent in het beeld verschenen. In één GAN-reconstructie, een paar pasgehuwden die op de trappen van een kerk zoenen, worden uitgespoken, een griezelige trouwjurktextuur achterlatend op de deur van de kathedraal.

"Wanneer GAN's objecten tegenkomen die ze niet kunnen genereren, ze lijken zich voor te stellen hoe de scène eruit zou zien zonder hen, " zegt Strobelt. "Soms worden mensen struikgewas of verdwijnen ze helemaal in het gebouw achter hen."

De onderzoekers vermoeden dat machinale luiheid de oorzaak kan zijn; hoewel een GAN is getraind om overtuigende afbeeldingen te maken, het kan leren dat het gemakkelijker is om je te concentreren op gebouwen en landschappen en moeilijker te representeren mensen en auto's over te slaan. Onderzoekers weten al lang dat GAN's de neiging hebben om enkele statistisch betekenisvolle details over het hoofd te zien. Maar dit is misschien wel de eerste studie die aantoont dat state-of-the-art GAN's systematisch hele klassen objecten in een afbeelding kunnen weglaten.

Een AI die sommige objecten uit zijn representaties laat vallen, kan zijn numerieke doelen bereiken terwijl hij de details mist die voor ons mensen het belangrijkst zijn. zegt Bau. Terwijl ingenieurs zich tot GAN's wenden om synthetische afbeeldingen te genereren om geautomatiseerde systemen zoals zelfrijdende auto's te trainen, het gevaar bestaat dat mensen, tekens, en andere kritieke informatie kan worden weggelaten zonder dat mensen het beseffen. Het laat zien waarom modelprestaties niet alleen door nauwkeurigheid moeten worden gemeten, zegt Bau. "We moeten begrijpen wat de netwerken wel en niet doen om ervoor te zorgen dat ze de keuzes maken die we willen dat ze maken."

Dit verhaal is opnieuw gepubliceerd met dank aan MIT News (web.mit.edu/newsoffice/), een populaire site met nieuws over MIT-onderzoek, innovatie en onderwijs.

Hoofdlijnen

- Wat zijn lange ketens van aminozuren genaamd?

- Retrovirus versus DNA-virus

- Kunstmatige nesten zijn bedoeld om het broedsucces van de schuwe albatros te vergroten

- Een dodelijke schimmel die het witte-neussyndroom veroorzaakt, kan een achilleshiel hebben, studie onthult

- Het verschil tussen een sporofyt en gametofyt

- Hoe krijgen mensen stikstof in hun lichaam?

- Onderzoek toont aan hoe vrouwelijke immuuncellen hun tweede X-chromosoom uitgeschakeld houden

- Glimlachende menselijke gezichten zijn aantrekkelijk voor honden - dankzij oxytocine

- Zijn getrouwde mensen gelukkiger dan alleenstaanden?

- Nadenken over toekomstige mobiliteit en productietechniek

- Wat is de beste streamingdienst voor jou? Hoe kabelalternatieven zich verhouden voor snoersnijders

- Kubusvormige magnetische bouwstenen voor toepassingen in zachte robotica

- Kunstmatige intelligentie helpt soldaten vele malen sneller te leren in gevechten

- goedkope tarieven, dure brandstof brengt Indiase luchtvaartmaatschappijen in een neerwaartse spiraal

Britse deeltjesversneller om geheimen van 2 te onthullen, 000 jaar oude papyrus

Britse deeltjesversneller om geheimen van 2 te onthullen, 000 jaar oude papyrus Wetenschapsprojecten op gletsjers

Wetenschapsprojecten op gletsjers Een kankervernietigersubstantie met nieuw werkingsmechanisme gevonden

Een kankervernietigersubstantie met nieuw werkingsmechanisme gevonden Met het oog op problemen uit het verleden, Facebook breidt lokale functie uit

Met het oog op problemen uit het verleden, Facebook breidt lokale functie uit Samsung Galaxy Buds draadloze oordopjes zijn $ 130 rivaal voor AirPods

Samsung Galaxy Buds draadloze oordopjes zijn $ 130 rivaal voor AirPods Een kwestie van de kwantumrealiteit

Een kwestie van de kwantumrealiteit Waarom multipartiete virussen planten infecteren in plaats van dieren?

Waarom multipartiete virussen planten infecteren in plaats van dieren? Wetenschapsprojecten over wat Freezer sneller vrst: water of suikerwater?

Wetenschapsprojecten over wat Freezer sneller vrst: water of suikerwater?

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com