Wetenschap

Een nieuw algoritme zorgt voor meer realistische geluidseffecten in VR

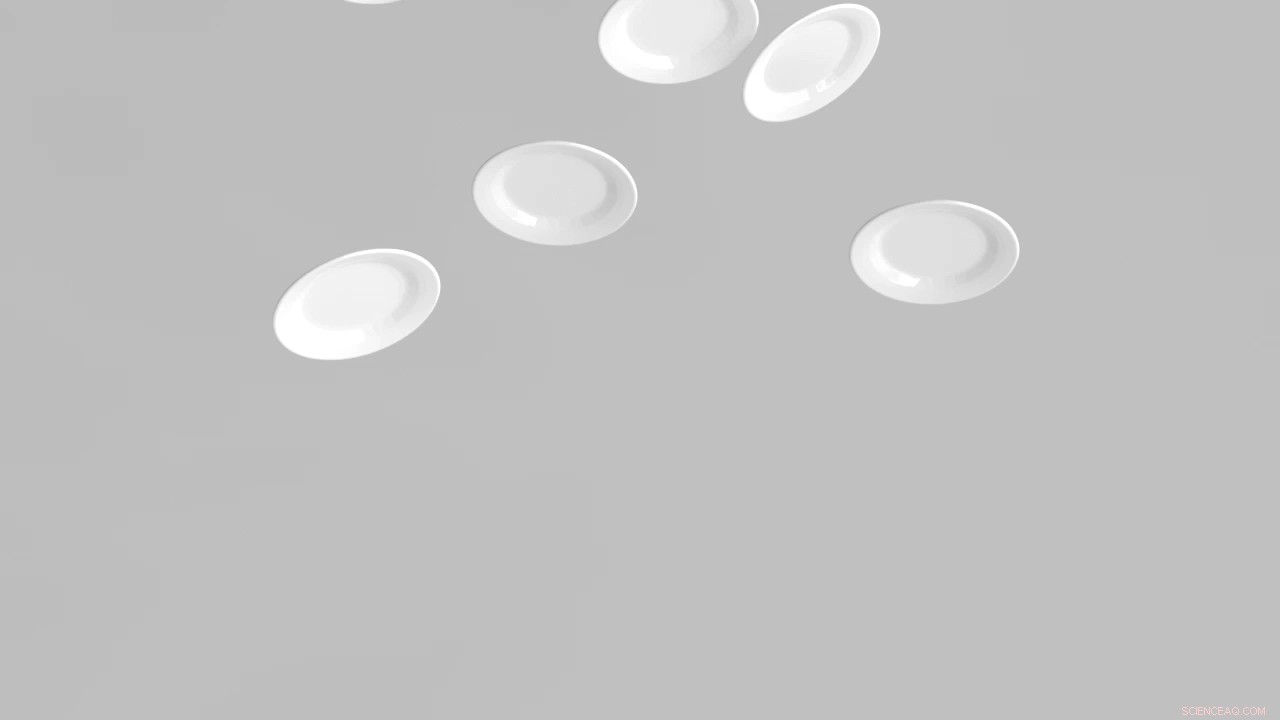

Krediet:Doug James, Stanford universiteit

Als we films kijken of videogames spelen, de juiste geluidseffecten kunnen helpen om scènes realistischer te maken:wanneer een grijze gokker een zilveren dollar over een kaarttafel rolt in een saloon met een zilveren scherm, het geluid lijkt van oor tot oor te gaan, een truc die filmmakers kunnen volbrengen door een vooraf opgenomen geluid in te voegen dat van luidspreker naar luidspreker gaat.

Maar het creëren van dergelijke sensaties in virtual reality was tot nu toe praktisch onmogelijk omdat VR geen script heeft. Het is moeilijk te voorspellen welke geluiden een object kan maken, of waar ze kunnen worden gehoord. Om VR realistisch te laten klinken, ingenieurs zouden een groot aantal 'geluidsmodellen' moeten maken - de geautomatiseerde equivalenten van vooropnames. Elk geluidsmodel zou het VR-systeem in staat stellen om een bepaald geluid te synthetiseren op het precieze moment dat het nodig was. Tot nu toe zou het een cluster van computers vele uren hebben gekost om zelfs maar een enkel geluidsmodel te maken, en aangezien er veel verschillende modellen nodig zouden zijn om veel verschillende potentiële geluiden te synthetiseren, het creëren van realistisch geluid in interactieve omgevingen was een ongrijpbaar doel.

Nu hebben computerwetenschappers van Stanford een algoritme uitgevonden dat binnen enkele seconden geluidsmodellen kan maken, waardoor het kosteneffectief is om geluiden voor veel verschillende objecten in een virtuele omgeving te simuleren. Wanneer een actie plaatsvindt die een geluid vereist, dit nieuwe model kan een geluid synthetiseren dat net zo realistisch is als de geluiden die worden gegenereerd door de veel langzamere en nog steeds experimentele algoritmen uit het verleden. "Door het gemakkelijker te maken om modellen te maken, is het praktisch om interactieve omgevingen te bouwen met realistische geluidseffecten, " zei Doug James, een professor in de informatica met een beleefdheidsaanstelling in de muziek.

Eerdere algoritmen om geluidsmodellen te maken waren gebaseerd op het werk van de 19e-eeuwse wetenschapper Hermann von Helmholtz, die zijn naam gaf aan een vergelijking die beschrijft hoe geluiden zich voortplanten. Op basis van deze theoretische onderbouwing, wetenschappers hebben algoritmen ontworpen om 3D-geluidsmodellen te creëren:softwareroutines die in staat zijn audio te synthetiseren die realistisch lijkt omdat het volume en de richting van het geluid veranderen afhankelijk van waar de actie plaatsvindt ten opzichte van de luisteraar. Tot nu toe vertrouwden de beste algoritmen voor het maken van 3D-geluidsmodellen op de grenselementmethode (BEM), een langzaam proces dat gewoon te duur was voor commercieel gebruik.

James en zijn afgestudeerde student-medewerker, Jui-Hsien Wang, ontwikkelde een algoritme dat geluidsmodellen honderden tot duizenden keren sneller berekent door de Helmholtz-vergelijking en BEM te vermijden. Hun aanpak is geïnspireerd op de 20e-eeuwse Oostenrijkse componist Fritz Heinrich Klein, die een manier vond om een groot aantal pianotonen en noten samen te smelten tot één enkele, aangenaam geluid dat bekend staat als het moederakkoord. De wetenschappers - die hun algoritme KleinPAT noemden in een knipoog naar zijn inspiratie - leggen uit hoe hun aanpak geluidsmodellen creëert in een wetenschappelijk artikel dat ze presenteren op de ACM SIGGRAPH 2019-conferentie over computergraphics en interactieve technieken. "We denken dat dit een game changer is voor interactieve omgevingen, ' zei Jacobus.

Onderzoekers vinden dat de microstructuur van cuttlebones op een goede plek zit

Onderzoekers vinden dat de microstructuur van cuttlebones op een goede plek zit Door genetisch materiaal op te sporen, snelle sensor heeft potentieel gebruik als klinisch hulpmiddel

Door genetisch materiaal op te sporen, snelle sensor heeft potentieel gebruik als klinisch hulpmiddel Hoe kaliumcarbonaat

Hoe kaliumcarbonaat Zelfsteriliserend polymeer blijkt effectief tegen medicijnresistente pathogenen

Zelfsteriliserend polymeer blijkt effectief tegen medicijnresistente pathogenen Gepersonaliseerde kankervaccins:doorbraak kan betere resultaten opleveren

Gepersonaliseerde kankervaccins:doorbraak kan betere resultaten opleveren

Hoofdlijnen

- RNA (ribonucleïnezuur): definitie, functie, structuur

- Tonnen leven diep in het aardoppervlak gevonden

- Verspilde vogelveren veranderd in voedsel

- Archaea: Structure, Characteristics & Domain

- Het bacteriële sociale netwerk hacken

- Hoe de lengte van DNA-fragmenten

- Schimmel is afhankelijk van bacteriën om de belangrijkste componenten van zijn voortplantingsmechanisme te reguleren

- Verschillen tussen Protista en Monera

- Kenmerken van Animal-like Protists

- Amerikaanse bedrijven adverteren op hookup-sites - onbewust

- BMW pauzeert Britse productie van Mini's na Brexit

- Hoe autonome schepen kunnen leiden tot veiliger vaarwegen

- Generieke opladers voor mobiele telefoons vergroten het risico op brandwonden, elektrocutie

- Nieuwe CEO vertelt personeel dat Boeing transparant moet zijn

Structurele kenmerken van blauwgroene algen

Structurele kenmerken van blauwgroene algen  Fossiele voetafdrukken bewijzen dat mensen duizenden jaren eerder Amerika bevolkten dan we dachten

Fossiele voetafdrukken bewijzen dat mensen duizenden jaren eerder Amerika bevolkten dan we dachten Samenwerken met een team van rivalen kan conflicten oplossen en de wetenschap vooruithelpen

Samenwerken met een team van rivalen kan conflicten oplossen en de wetenschap vooruithelpen Rapport:Grote Meren voelen effecten van snelle klimaatopwarming (update)

Rapport:Grote Meren voelen effecten van snelle klimaatopwarming (update) Wetenschappers reiken terug in de tijd om enkele van de meest krachtige sterrenstelsels te ontdekken

Wetenschappers reiken terug in de tijd om enkele van de meest krachtige sterrenstelsels te ontdekken Het coronavirus en onze onderling verbonden economie en biosfeer

Het coronavirus en onze onderling verbonden economie en biosfeer Energiestroom in een plasma vastleggen door verstrooid licht te meten

Energiestroom in een plasma vastleggen door verstrooid licht te meten Waarom is de VS niet op het metrische systeem?

Waarom is de VS niet op het metrische systeem?

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | German | Dutch | Danish | Norway | Swedish |

-

Wetenschap © https://nl.scienceaq.com