Wetenschap

Een aanpak om de uitleg van machine learning te verbeteren

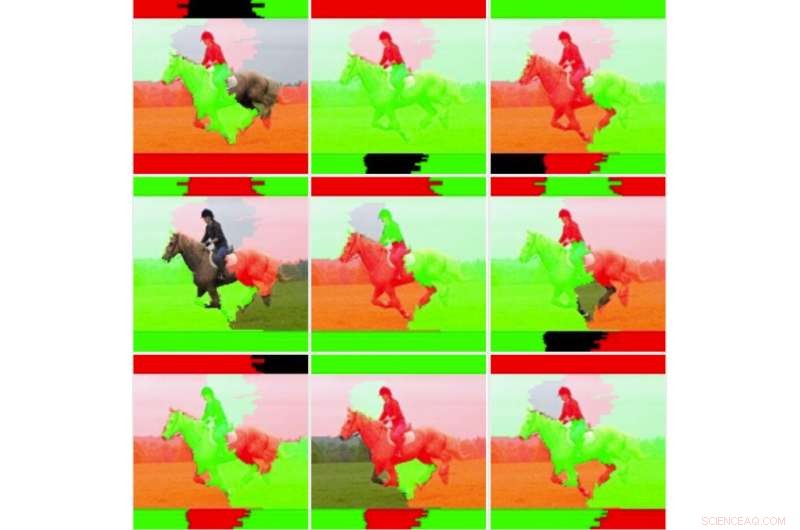

De originele invoerafbeelding. Krediet:Lee et al.

Onderzoekers van IBM Research UK, de Amerikaanse militaire academie en de universiteit van Cardiff hebben onlangs een nieuwe benadering voorgesteld om de gevoeligheid van LIME te verbeteren (Local Interpretable Model Agnostic Explanations), een techniek om de conclusies van machine learning-algoritmen beter te begrijpen. hun papier, gepubliceerd in de digitale bibliotheek SPIE, zou kunnen helpen bij de ontwikkeling van hulpmiddelen voor kunstmatige intelligentie (AI) die uitgebreide uitleg geven over hoe ze tot een bepaald resultaat of een bepaalde conclusie zijn gekomen.

"Wij geloven dat AI en machine learning de menselijke besluitvorming kunnen ondersteunen en verbeteren, maar dat er ook behoefte is aan verklaarbare AI, "Eunjin Lee, co-auteur van de originele onderzoekspaper en Emerging Technology Specialist en Senior Inventor bij IBM Research U.K., vertelde TechXplore. "Vandaag, beslissingen van veel machine learning-systemen zijn onverklaarbaar, d.w.z., wij mensen kunnen op geen enkele manier weten hoe de systemen tot die beslissingen zijn gekomen. Ons onderzoek pakt dit probleem aan door te onderzoeken hoe verklaarbaarheidstechnieken kunnen worden verbeterd die licht werpen op de 'black-box'-aard van machine learning-processen."

LIME is een bijzonder populaire verklaarbaarheidstechniek die op veel machine learning-modellen kan worden toegepast. Ondanks zijn veelzijdigheid, het wordt vaak gezien als onbetrouwbaar en dus ineffectief bij het geven van verklaringen, ook vanwege de variabiliteit in de resultaten die het oplevert. In plaats van een geheel nieuwe verklaarbaarheidstechniek te ontwikkelen, Lee en haar collega's gingen op zoek naar mechanismen die LIME-verklaringen zouden kunnen verbeteren.

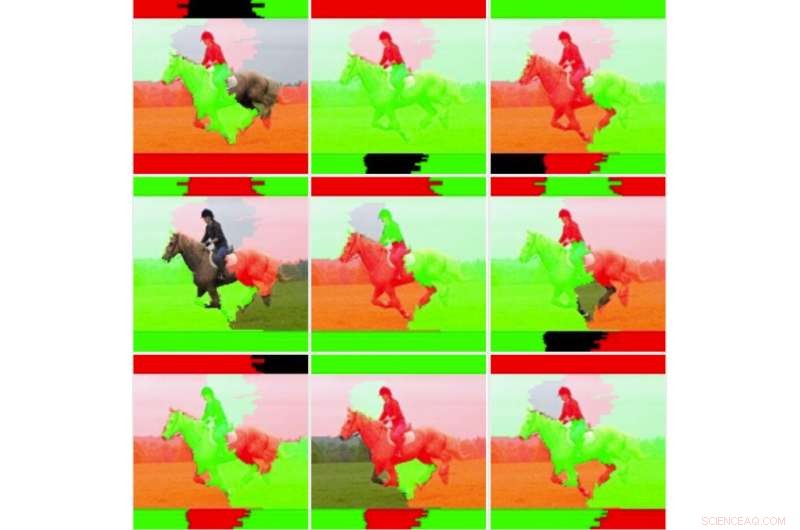

"We wilden eerst dieper ingaan op de instabiliteit die andere onderzoekers hebben waargenomen om te bepalen of LIME echt onstabiel was, " legde Lee uit. "Om dit te doen, we hebben LIME getest tegen onze dataset en machine learning-model zonder de onderliggende code te wijzigen. We ontdekten meteen dat de resulterende uitlegbeelden aanzienlijk varieerden en niet consistent leken. Dit is misschien het punt waarop velen gewoon zouden stoppen met het gebruik van de techniek."

Negen beelduitgangen voor de ongewijzigde LIME-techniek. Krediet:Lee et al.

Toen Lee en haar collega's dieper in de onderliggende statistieken van LIME groeven, ontdekten ze dat hoewel de beelden die het voortbracht "visueel onstabiel, " de standaardverklaring hield geen rekening met alle statistische informatie. het inkleuren van verklarende afbeeldingen was te eenvoudig en hield geen rekening met de volledige onderliggende gegevens (bijv. geen rekening gehouden met technieken zoals arcering of transparantie). Deze bevinding verklaart gedeeltelijk waarom verklaringen die door LIME worden gegenereerd soms niet de zekerheid van classificatie overbrengen op menselijke gebruikers.

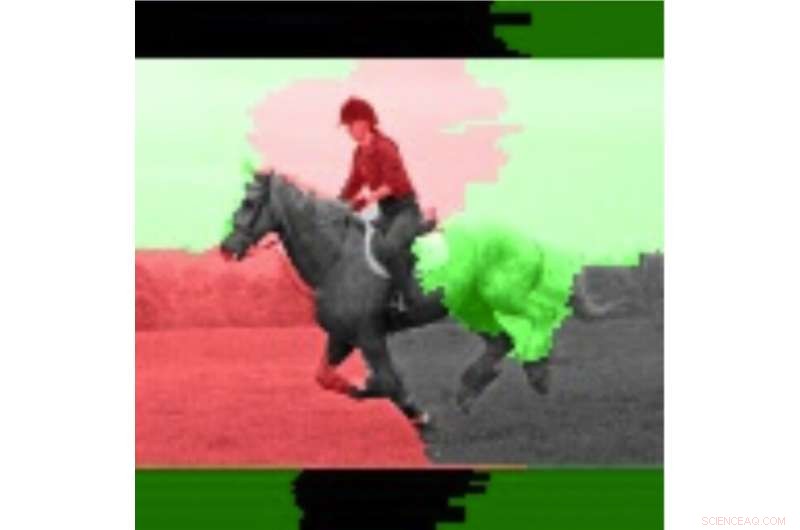

"Het is vaak het geval voor dynamische systemen, zoals degene die we in dit onderzoek hebben onderzocht, dat het uitvoeren van talrijke tests en het onderzoeken van gemiddelde waarden nuttig kan zijn, " zei Lee. "Door deze benadering te volgen, we realiseerden ons dat de stabiliteit van de verklaringen wel verbeterde bij het beschouwen van gemiddelde waarden en standaarddeviaties over meerdere runs in plaats van de verklaring slechts één keer uit te voeren."

In hun studie hebben Lee en haar collega's trainden een convolutioneel neuraal netwerk (CNN) -model met behulp van twee klassen afbeeldingen, namelijk "gun-wielder" en "non-wielder." Ze ontdekten dat de gevoeligheid van LIME verbeterde wanneer verschillende uitvoergewichten voor individuele afbeeldingen werden gemiddeld en gevisualiseerd.

De onderzoekers vergeleken deze gemiddelde afbeeldingen vervolgens met individuele afbeeldingen om de variabiliteit en betrouwbaarheid van de twee LIME-methoden (d.w.z. de traditionele methode en degene die ze voorstelden) te evalueren. Ze ontdekten dat traditionele LIME-technieken, zonder de aanpassingen die ze maakten, leken onstabiel te zijn vanwege de eenvoudige binaire kleur die ze aannamen en het gemak waarmee gekleurde gebieden omdraaiden bij het vergelijken van verschillende analyses. Lee en haar collega's merkten ook op dat de aanzienlijk gewogen gebieden van afbeeldingen consistent waren, terwijl de lager gewogen regio's staten omdraaiden, vanwege de inherente instabiliteit van KALK-technieken.

De afbeelding gemarkeerd met behulp van de gemiddelde informatie. Krediet:Lee et al.

"Technieken zoals LIME zijn veelbelovend voor de verklaarbaarheid van AI, vooral in een tijd waarin er geen gemakkelijke, direct beschikbare uitlegmogelijkheden voor machine learning-systemen, " zei Lee. "Hoewel de waargenomen instabiliteit gerechtvaardigd is, er zijn technieken die dit probleem kunnen helpen verminderen. Deze technieken hebben extra rekenkosten, bijv. de uitleg meerdere keren uitvoeren, wat betekent dat de gebruiker een grotere vertraging zal hebben bij het genereren van de uitleg."

Het onderzoek dat Lee en haar collega's hebben uitgevoerd, biedt een waardevolle verklaring voor enkele van de factoren achter de instabiliteit van LIME, zoals waargenomen in eerder onderzoek. Hun bevindingen suggereren dat het verbeteren van wegingsmethoden voor verklaarbaarheidstechnieken hun stabiliteit kan verbeteren en tot betrouwbaardere verklaringen kan leiden, uiteindelijk een groter vertrouwen in AI bevorderen. Toekomstig onderzoek zou meer geavanceerde numerieke technieken kunnen identificeren om de stabiliteit van LIME en andere verklaarbaarheidsmethoden verder te verbeteren en tegelijkertijd de extra overhead te verminderen.

"We hebben een voortdurende interesse in verantwoordelijke AI-systemen die uitleg bevatten, maar ook vooroordelen verminderen en de robuustheid en transparantie verbeteren, Lee zei. "Het verbeteren van de mogelijkheid voor ontwikkelaars om eenvoudiger verklaarbaarheidstechnieken in hun AI-oplossingen in te bedden, is een belangrijk doel voor ons. Onlangs, IBM heeft een softwareservice gelanceerd die automatisch bias detecteert en uitlegt hoe AI beslissingen neemt."

© 2019 Wetenschap X Netwerk

Wat is de pH-waarde van baking soda?

Wat is de pH-waarde van baking soda?  Wat is het verschil tussen hoge en lage oppervlaktespanning?

Wat is het verschil tussen hoge en lage oppervlaktespanning?  Wat zijn de grondstoffen van plastic flessen?

Wat zijn de grondstoffen van plastic flessen?  Gecko-adhesietechnologie komt dichter bij industrieel gebruik

Gecko-adhesietechnologie komt dichter bij industrieel gebruik Chemische synthese toont aan dat antibioticum uit de menselijke neus werkt door protontranslocatie

Chemische synthese toont aan dat antibioticum uit de menselijke neus werkt door protontranslocatie

De uitstoot van lachgas zal stijgen in de Stille Oceaan

De uitstoot van lachgas zal stijgen in de Stille Oceaan Mogelijke toekomst voor westerse bosbranden:uitbarsting van tien jaar, gevolgd door geleidelijke daling

Mogelijke toekomst voor westerse bosbranden:uitbarsting van tien jaar, gevolgd door geleidelijke daling Welke planten leven in de diepe oceaan?

Welke planten leven in de diepe oceaan?  Zou de oceaan de sleutel kunnen zijn tot het verminderen van koolstofdioxide in de atmosfeer?

Zou de oceaan de sleutel kunnen zijn tot het verminderen van koolstofdioxide in de atmosfeer? NASA bevestigt ontwikkeling van recordbrekende tropische storm Wilfred, einde orkaan lijst

NASA bevestigt ontwikkeling van recordbrekende tropische storm Wilfred, einde orkaan lijst

Hoofdlijnen

- Infectieziekten:CTRL + ALT + Delete

- Hoe Kudzu werkt

- Gebruik van recombinant DNA in Agriculture

- Wat zijn de voordelen van eiwitten die worden geproduceerd door middel van recombinante DNA-technologie?

- Aardappelziekte chemisch aanvalsmechanisme uitgelegd

- Wetenschappers werken aan een periodiek systeem voor ecologie

- Hoe glycolyse aan kinderen te leren

- Waarom is stikstof belangrijk voor levende wezens?

- De voor- en nadelen van klonen

- Dode vissen drijven Noorse cruiseschepen aan

- Frankrijk beschuldigt Google van het schenden van de EU-auteurswet die bedoeld is om nieuwsuitgevers te helpen

- Bionic vision-systeem werkt met augmented reality-bril

- Comcast, Fox verhoogt beide biedingen als ze naar Sky reiken

- Germania airline zegt faillissement aan te vragen annuleert alle vluchten

Supercomputer helpt wetenschappers nieuwe functies te vinden, mechanismen in tornado's

Supercomputer helpt wetenschappers nieuwe functies te vinden, mechanismen in tornado's GPM satellietbeelden Tropische cycloon Flamboyans regenval

GPM satellietbeelden Tropische cycloon Flamboyans regenval Indonesië geeft tsunamiwaarschuwing na aardbeving Molukse Zee

Indonesië geeft tsunamiwaarschuwing na aardbeving Molukse Zee waren technisch, te! Deere, Getijdenmaker gaat naar CES-gadgetshow

waren technisch, te! Deere, Getijdenmaker gaat naar CES-gadgetshow Shell:winst springt omhoog door hoge energieprijzen

Shell:winst springt omhoog door hoge energieprijzen Beperkingen van enzymen gebruikt in Forensic Science

Beperkingen van enzymen gebruikt in Forensic Science Spectrale bibliotheek onthult hoe boreale bomen zonnestraling reflecteren

Spectrale bibliotheek onthult hoe boreale bomen zonnestraling reflecteren Een nieuw paradigma van materiaalidentificatie op basis van grafentheorie

Een nieuw paradigma van materiaalidentificatie op basis van grafentheorie

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway | French |

-

Wetenschap © https://nl.scienceaq.com