Wetenschap

Aanvalsweerstand van convolutionele neurale netwerken certificeren

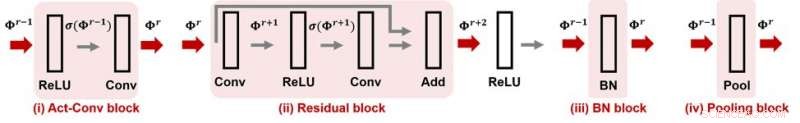

Afbeelding 1. CNN-Cert ondersteunt veel populaire modules en laagbewerkingen in convolutionele neurale netwerken. Krediet:IBM

Bij het kopen van een horloge, u kunt de waterbestendigheidsclassificatie opmerken, wat aangeeft dat het horloge gegarandeerd waterdicht is tot een bepaald niveau. Hoe zit het met je neurale netwerk? Kan men ervoor zorgen dat een neuraal netwerk "aanvalsbestendig" is? wat betekent dat de functionaliteit ervan robuust is tegen vijandige verstoringen? Als, hoe kan dit worden gekwantificeerd met een aanvalsweerstandsgetal? Op AAAI 2019, onze groep onderzoekers van MIT en IBM Research stelt een efficiënte en effectieve methode voor om de aanvalsweerstand van convolutionele neurale netwerken op gegeven invoergegevens te certificeren. Deze paper is geselecteerd voor mondelinge presentatie op AAAI 2019 (30 januari, 14:00-15:30 @ koraal 1).

Van de huidige diepe neurale netwerkmodellen is bekend dat ze kwetsbaar zijn voor vijandige verstoringen. Een zorgvuldig ontworpen maar kleine verstoring van het invoeren van gegevens zou de voorspelling van de modeluitvoer gemakkelijk kunnen manipuleren, inclusief machine learning-taken zoals objectherkenning, spraakvertaling, ondertiteling van afbeeldingen, en tekstclassificatie, om er een paar te noemen. Een gebrek aan robuustheid tegen vijandige verstoringen zorgt voor nieuwe uitdagingen in AI-onderzoek en kan ons vertrouwen in AI-systemen belemmeren.

Gegeven een neuraal netwerk en rekening houdend met een vijandig dreigingsmodel waarin de aanvalssterkte wordt gekenmerkt door de Lp-norm van de verstoring, voor alle gegevensinvoer, de vijandige robuustheid kan worden gekwantificeerd als de minimale aanvalskracht die nodig is om de modelvoorspelling te wijzigen (zie figuur 1 in de vorige post voor een visuele illustratie). Hier, een aanvalsbestendig robuustheidscertificaat voor een ingang specificeert een aanvalssterkte ε en biedt de volgende gegarandeerde aanvalsweerstand:onder het normgebonden dreigingsmodel, geen vijandige verstoringen kunnen de voorspelling van de invoer veranderen als hun aanvalssterkte kleiner is dan ε. Met andere woorden, groter ε betekent dat de invoer robuuster is. Deze robuustheidscertificering kan cruciaal zijn in veiligheidskritieke of kostengevoelige AI-toepassingen die hoge precisie en betrouwbaarheid vereisen, zoals autonome rijsystemen.

Onze voorgestelde methode, CNN-certificaat, biedt een algemeen en efficiënt raamwerk voor het certificeren van het niveau van vijandige robuustheid van convolutionele neurale netwerken voor gegeven invoergegevens. Ons raamwerk is algemeen:we kunnen verschillende architecturen aan, waaronder convolutionele lagen, max-pooling lagen, batch normalisatie laag, resterende blokken, evenals algemene activeringsfuncties zoals ReLU, tan, sigmoïd en arctan. Afbeelding 1 toont enkele veelgebruikte bouwstenen die in ons CNN-Cert-raamwerk worden overwogen. De belangrijkste techniek in CNN-Cert is het afleiden van expliciete netwerkoutput gebonden door rekening te houden met de input/output-relaties van elke bouwsteen, gemarkeerd als rode pijlen. De activeringslaag kan andere algemene activeringen zijn dan ReLU. Onze aanpak is ook efficiënt - door gebruik te maken van de speciale structuur van convolutionele lagen, we bereiken tot 17 en 11 keer sneller in vergelijking met de ultramoderne certificeringsalgoritmen en 366 keer sneller in vergelijking met een standaard dual-LP-benadering, terwijl onze methode vergelijkbare of zelfs betere aanvalsweerstandsgrenzen verkrijgt .

Dit verhaal is opnieuw gepubliceerd met dank aan IBM Research. Lees hier het originele verhaal.

Hoe ontstaan kationen?

Hoe ontstaan kationen?  Nanofiltratiemembranen voor de behandeling van industrieel afvalwater van zware metalen

Nanofiltratiemembranen voor de behandeling van industrieel afvalwater van zware metalen Onderzoek van Stanford kan leiden tot injecteerbare gels die na verloop van tijd medicijnen afgeven

Onderzoek van Stanford kan leiden tot injecteerbare gels die na verloop van tijd medicijnen afgeven Polymeren klikken samen met behulp van groene chemie

Polymeren klikken samen met behulp van groene chemie Wat zijn de componenten van de atoomstructuur?

Wat zijn de componenten van de atoomstructuur?

Van hitte tot sneeuw:in de Rocky Mountains zie je een duik van 60 graden

Van hitte tot sneeuw:in de Rocky Mountains zie je een duik van 60 graden Lucht-zeekoppeling verbetert de simulatie van de westelijke zomermoesson in de noordelijke Stille Oceaan

Lucht-zeekoppeling verbetert de simulatie van de westelijke zomermoesson in de noordelijke Stille Oceaan Monitoren van het trillen - en mogelijke vallen - van natuurlijke rotsbogen

Monitoren van het trillen - en mogelijke vallen - van natuurlijke rotsbogen 17,6 miljoen Amerikanen wonen in de buurt van actieve olie- of gasbronnen

17,6 miljoen Amerikanen wonen in de buurt van actieve olie- of gasbronnen Kleine dorpen, grote overstromingswateren

Kleine dorpen, grote overstromingswateren

Hoofdlijnen

- Japanse walvisjagers naar Antarctica

- Wat gebeurt er met een diercel wanneer deze zich in een hypotone oplossing bevindt?

- Hoe slapende listeria zich in cellen verbergt

- Wanneer gebeurt er wanneer mitose verkeerd gaat en in welke fase zal het verkeerd gaan?

- Ryk heeft een begeleider nodig

- Biofysici ontrafelen de exacte vouwing van een enkel gen

- Hoe te studeren voor menselijke biologie examens

- Meelkracht om voedselzekerheid te vergroten

- Hoe wetenschappers de gezondheid van walvissen in de gaten houden door drones te gebruiken om hun slag op te vangen

- AI en 5G in beeld op top mobiele beurs

- Human-in-the-loop optimalisatie verbetert de functie van zachte, draagbare robots

- Hoe kunnen criminelen cryptocurrency-markten manipuleren?

- Een oude computer verkopen op eBay? Mogelijk geeft u ook gegevens weg waarvan u dacht dat u ze had gewist

- Toyota's magneet vermindert de afhankelijkheid van veelgebruikte zeldzame-aarde-elementen

Nanodeeltjes werken samen om tumoren te detecteren en te behandelen

Nanodeeltjes werken samen om tumoren te detecteren en te behandelen Records onthullen nieuwe trends in Australische extreme temperaturen

Records onthullen nieuwe trends in Australische extreme temperaturen Nieuwe synthesemethode voor de productie van gefluoreerde piperidines

Nieuwe synthesemethode voor de productie van gefluoreerde piperidines Planetaire wetenschappers ontrafelen mysterie van Egyptisch woestijnglas

Planetaire wetenschappers ontrafelen mysterie van Egyptisch woestijnglas Kunstmatige intelligentie helpt soldaten vele malen sneller te leren in gevechten

Kunstmatige intelligentie helpt soldaten vele malen sneller te leren in gevechten Wat gebeurt er als een zuur en een base worden gecombineerd?

Wat gebeurt er als een zuur en een base worden gecombineerd?  Doorbraak in elektrokatalysatoren gemeld

Doorbraak in elektrokatalysatoren gemeld Wetenschapshistoricus bespreekt rapport van de Amerikaanse regering over UFO's

Wetenschapshistoricus bespreekt rapport van de Amerikaanse regering over UFO's

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com