Wetenschap

Eerlijkheid nodig bij algoritmische besluitvorming, deskundigen zeggen

David Madras, een promovendus bij de afdeling informatica, zegt dat er belangrijke vragen moeten worden gesteld over de eerlijkheid van beslissingen die door geautomatiseerde systemen worden genomen. Krediet:Nina Haikara

Universiteit van Toronto Ph.D. student David Madras zegt dat veel van de huidige algoritmen goed zijn in het maken van nauwkeurige voorspellingen, maar weet niet goed om te gaan met onzekerheid. Als een slecht gekalibreerd algoritme de verkeerde beslissing neemt, het is meestal erg fout.

"Een menselijke gebruiker kan een situatie misschien beter begrijpen dan een computer, of het informatie is die niet beschikbaar is omdat deze zeer kwalitatief van aard is, of er gebeurt iets in de echte wereld dat niet in het algoritme is ingevoerd, " zegt Madras, een machine learning-onderzoeker bij de afdeling informatica die ook is verbonden aan het Vector Institute for Artificial Intelligence.

"Beide kunnen erg belangrijk zijn en kunnen een effect hebben op welke voorspellingen [gemaakt] moeten worden."

Madras presenteert zijn onderzoek, "Voorspel verantwoord:eerlijkheid vergroten door te leren uitstellen, " op de International Conference on Learning Representations (ICLR), deze week in Vancouver. De conferentie is gericht op de methoden en prestaties van machine learning en brengt leiders in het veld samen.

Madras zegt dat hij en Toniann Pitassi, een professor in computerwetenschappen en wiskunde aan de U of T-afdelingen en een expert op het gebied van computationele theorie die ook computationele eerlijkheid onderzoekt, evenals Richard Zemel, een U of T-hoogleraar computerwetenschappen en onderzoeksdirecteur van het Vector Institute, hebben hun model ontwikkeld met eerlijkheid in het achterhoofd. Waar een zekere mate van onzekerheid bestaat, een algoritme moet de mogelijkheid hebben om te antwoorden, "Ik weet het niet" en stel zijn beslissing uit aan een menselijke gebruiker.

Madras legt uit of Facebook een algoritme zou gebruiken om mensen automatisch te taggen in afbeeldingen, het is misschien niet zo belangrijk als de tagging verkeerd is gedaan. Maar wanneer individuele resultaten een grote impact hebben, het risico kan groter zijn. Hij zegt dat het model nog niet is toegepast op een specifieke toepassing, maar de onderzoekers denken eerder aan het soort manieren waarop het in echte gevallen zou kunnen worden gebruikt.

"In medische instellingen, het kan belangrijk zijn om iets te produceren dat kan worden geïnterpreteerd - er is enige onzekerheid over de voorspelling ervan - en een arts moet beslissen of behandeling moet worden gegeven."

Madras' afstudeerbegeleider Zemel, die deze zomer een NSERC Industrial Research Chair in Machine Learning zal opnemen, onderzoekt ook hoe machine learning expressiever kan worden gemaakt, controleerbaar en eerlijk.

Zemel zegt dat machine learning gebaseerd is op historische gegevens, zoals of een banklening is goedgekeurd of de lengte van gevangenisstraffen, zal natuurlijk vooroordelen oppikken. En de vooroordelen in de dataset kunnen spelen in de voorspellingen van een machine, hij zegt.

"In deze krant, we denken veel aan een externe beslisser. Om ons model te trainen, we moeten historische beslissingen nemen die door besluitvormers zijn genomen. De resultaten van die beslissingen, gemaakt door bestaande besluitvormers, kunnen zelf bevooroordeeld of in zekere zin onvolledig zijn."

Madras is van mening dat de toegenomen aandacht voor algoritmische eerlijkheid naast privacykwesties, zekerheid en veiligheid, zal helpen om machine learning beter toepasbaar te maken voor toepassingen met een hoge inzet.

"Het roept belangrijke vragen op over de rol van een geautomatiseerd systeem dat belangrijke beslissingen neemt, en hoe we [ze] kunnen laten voorspellen op een manier die wij willen dat ze doen."

Madras zegt dat hij blijft nadenken over kwesties van eerlijkheid en aanverwante gebieden, zoals causaliteit:twee dingen kunnen met elkaar in verband worden gebracht - omdat ze vaak samen voorkomen - maar dat betekent niet dat het een het ander veroorzaakt.

"Als een algoritme beslist wanneer iemand een lening moet geven, het zou kunnen leren dat mensen die in een bepaalde postcode wonen, minder snel leningen terugbetalen. Maar dat kan een bron van oneerlijkheid zijn. Het is niet zo dat als je in een bepaalde postcode woont, je minder snel een lening terugbetaalt, " hij zegt.

"Het is een interessante en belangrijke reeks problemen om aan te werken."

Hoe maak je kristallen sneller groeien

Hoe maak je kristallen sneller groeien  Illinois-onderzoekers theorie van transport op porieschaal om verbeterde stroombatterijen mogelijk te maken

Illinois-onderzoekers theorie van transport op porieschaal om verbeterde stroombatterijen mogelijk te maken Chemici ontwerpen sneller productieproces voor essentiële suikers

Chemici ontwerpen sneller productieproces voor essentiële suikers Feedback van duizenden ontwerpen kan eiwittechnologie transformeren

Feedback van duizenden ontwerpen kan eiwittechnologie transformeren Onderzoekers maken een doorbraak in de richting van de volgende generatie geheugenapparaten

Onderzoekers maken een doorbraak in de richting van de volgende generatie geheugenapparaten

Hoe groot kan een tsunami zijn in het Caribisch gebied?

Hoe groot kan een tsunami zijn in het Caribisch gebied? Klimaatwetenschappers creëren model voor wereldwijde bosgroei tot 2060

Klimaatwetenschappers creëren model voor wereldwijde bosgroei tot 2060 Australiër breekt wereldrecord met Everest-top

Australiër breekt wereldrecord met Everest-top Het voorspellen van de intensiteit van een orkaan kan moeilijk zijn

Het voorspellen van de intensiteit van een orkaan kan moeilijk zijn Jordanië wordt geconfronteerd met waarschijnlijkheid van veel frequentere lange en ernstige droogtes

Jordanië wordt geconfronteerd met waarschijnlijkheid van veel frequentere lange en ernstige droogtes

Hoofdlijnen

- De functie van macromoleculen

- Waarom kunnen we de voetstappen van anderen horen,

- DNA-replicatie vergelijken en contrasteren in prokaryoten en eukaryoten

- Tandwortelpulp wordt een rijke bron van stamcellen

- Hoe evolueert de mens?

- Selenium beschermt specifieke interneuronen in de hersenen

- Zwarte neushoorn keert terug naar Tsjaad na deal met Zuid-Afrika

- Vissers in Istanbul houden traditie in stand ondanks voorraadalarm

- Ontrafelen wat genomics kan doen

- Meer beenruimte, minder gesprek voor Uber-rijders die betalen

- Bezorgd over vliegen op een 737 Max? Uw opties zijn misschien weinig

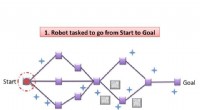

- SLAP:gelijktijdige lokalisatie en planning voor autonome robots

- Onderzoekers doen baanbrekende ontdekking in rekbare elektronische materialen

- Nieuwe ontwerp- en bagageoplossingen om vliegreizen te verkorten

De meeste van de op één na grootste pinguïnkolonie van Antarcticas is volledig verdwenen na een ijsplank Collapse

De meeste van de op één na grootste pinguïnkolonie van Antarcticas is volledig verdwenen na een ijsplank Collapse Beste bewijs tot nu toe voor het bestaan van wie dan ook

Beste bewijs tot nu toe voor het bestaan van wie dan ook Volksgezondheidsautoriteiten moeten opnieuw beoordelen hoe ze op de markt brengen aan geracialiseerde groepen

Volksgezondheidsautoriteiten moeten opnieuw beoordelen hoe ze op de markt brengen aan geracialiseerde groepen Een innovatief proces voorkomt onomkeerbaar energieverlies in batterijen

Een innovatief proces voorkomt onomkeerbaar energieverlies in batterijen Het imitatiespel:wetenschappers beschrijven en emuleren nieuwe kwantumtoestanden van verstrengelde fotonen

Het imitatiespel:wetenschappers beschrijven en emuleren nieuwe kwantumtoestanden van verstrengelde fotonen Met behulp van Thoreau, wetenschappers meten de impact van klimaatverandering op wilde bloemen

Met behulp van Thoreau, wetenschappers meten de impact van klimaatverandering op wilde bloemen Werkgelegenheidsrealiteit komt niet overeen met de dromen van mensen

Werkgelegenheidsrealiteit komt niet overeen met de dromen van mensen Een van de grootste wapenvoorraden uit de ijzertijd in West-Duitsland opgegraven

Een van de grootste wapenvoorraden uit de ijzertijd in West-Duitsland opgegraven

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | German | Dutch | Danish | Norway | Portuguese | Swedish |

-

Wetenschap © https://nl.scienceaq.com