Wetenschap

Hoe het Facebook-targetingmodel van Cambridge Analytica echt werkte – volgens de persoon die het heeft gebouwd

Hoe nauwkeurig kun je online worden geprofileerd? Krediet:Andrew Krasovitckii/Shutterstock.com

De onderzoeker wiens werk centraal staat in de Facebook-Cambridge Analytica-gegevensanalyse en het tumult in politieke advertenties, heeft onthuld dat zijn methode ongeveer hetzelfde werkte als de methode die Netflix gebruikt om films aan te bevelen.

In een e-mail aan mij, Cambridge University-wetenschapper Aleksandr Kogan legde uit hoe zijn statistische model Facebook-gegevens verwerkte voor Cambridge Analytica. De nauwkeurigheid die hij beweert, suggereert dat het ongeveer even goed werkt als gevestigde methoden voor het targeten van kiezers op basis van demografische gegevens zoals ras, leeftijd en geslacht.

Indien bevestigd, Kogan's account zou betekenen dat de digitale modellering die Cambridge Analytica gebruikte nauwelijks de virtuele kristallen bol was die sommigen hebben beweerd. Maar de cijfers die Kogan levert, laten ook zien wat wel en niet mogelijk is door persoonlijke gegevens te combineren met machine learning voor politieke doeleinden.

Wat betreft een belangrijke publieke zorg, Hoewel, Kogan's cijfers suggereren dat informatie over de persoonlijkheden van gebruikers of 'psychografische gegevens' slechts een bescheiden onderdeel was van hoe het model zich richtte op burgers. Het was strikt genomen geen persoonlijkheidsmodel, maar eerder een die de demografie neerzette, sociale invloeden, persoonlijkheid en al het andere in een grote gecorreleerde klont. Deze benadering van alle-correlatie-en-noem-het-persoonlijkheid lijkt een waardevol campagne-instrument te hebben gecreëerd, zelfs als het verkochte product niet helemaal was zoals het werd gefactureerd.

De belofte van persoonlijkheidstargeting

In de nasleep van de onthullingen dat campagneadviseurs van Trump, Cambridge Analytica, gegevens van 50 miljoen Facebook-gebruikers hebben gebruikt om digitale politieke advertenties te targeten tijdens de Amerikaanse presidentsverkiezingen van 2016, Facebook heeft miljarden aan beurswaarde verloren, regeringen aan beide zijden van de Atlantische Oceaan hebben onderzoeken geopend, en een opkomende sociale beweging roept gebruikers op om #DeleteFacebook te gebruiken.

Maar een belangrijke vraag is onbeantwoord gebleven:was Cambridge Analytica echt in staat om campagneboodschappen effectief op burgers te richten op basis van hun persoonlijkheidskenmerken – of zelfs hun ‘innerlijke demonen, " zoals een klokkenluider van een bedrijf beweerde?

Als iemand zou weten wat Cambridge Analytica deed met zijn enorme hoeveelheid Facebook-gegevens, het zouden Aleksandr Kogan en Joseph Chancellor zijn. Het was hun startup Global Science Research die profielinformatie verzamelde van 270, 000 Facebook-gebruikers en tientallen miljoenen van hun vrienden met behulp van een persoonlijkheidstest-app genaamd "thisisyourdigitallife".

Een deel van mijn eigen onderzoek richt zich op het begrijpen van machine learning-methoden, en mijn aanstaande boek bespreekt hoe digitale bedrijven aanbevelingsmodellen gebruiken om een publiek op te bouwen. Ik had een vermoeden hoe het model van Kogan en Chancellor werkte.

Dus ik heb Kogan een e-mail gestuurd om te vragen. Kogan is nog steeds onderzoeker aan de universiteit van Cambridge; zijn medewerker Chancellor werkt nu bij Facebook. In een opmerkelijke blijk van academische hoffelijkheid, antwoordde Kogan.

Zijn reactie vereist wat uitpakken, en wat achtergrond.

Van de Netflix-prijs tot "psychometrie"

Terug in 2006, toen het nog een dvd-per-postbedrijf was, Netflix loofde een beloning van $ 1 miljoen uit aan iedereen die een betere manier had ontwikkeld om voorspellingen te doen over de filmranglijst van gebruikers dan het bedrijf al had. Een verrassende topconcurrent was een onafhankelijke softwareontwikkelaar die het pseudoniem Simon Funk gebruikte, wiens basisaanpak uiteindelijk werd opgenomen in de inzendingen van alle topteams. Funk paste een techniek toe die "singular value decomposition, " het condenseren van gebruikersbeoordelingen van films in een reeks factoren of componenten - in wezen een reeks afgeleide categorieën, gerangschikt op belangrijkheid. Zoals Funk in een blogpost uitlegde, "Dus, bijvoorbeeld, een categorie kan actiefilms vertegenwoordigen, met films met veel actie aan de top, en langzame films onderaan, en dienovereenkomstig gebruikers die van actiefilms aan de top houden, en degenen die de voorkeur geven aan langzame films onderaan."

Factoren zijn kunstmatige categorieën, die niet altijd hetzelfde zijn als het soort categorieën waar mensen mee zouden komen. De belangrijkste factor in het vroege Netflix-model van Funk werd bepaald door gebruikers die dol waren op films als 'Pearl Harbor' en 'The Wedding Planner', terwijl ze ook een hekel hadden aan films als 'Lost in Translation' of 'Eternal Sunshine of the Spotless Mind'. Zijn model liet zien hoe machine learning verbanden kan vinden tussen groepen mensen, en groepen films, die mensen zelf nooit zouden zien.

De algemene benadering van Funk gebruikte de 50 of 100 belangrijkste factoren voor zowel gebruikers als films om een goede schatting te maken van hoe elke gebruiker elke film zou beoordelen. Deze methode, vaak dimensionaliteitsreductie of matrixfactorisatie genoemd, was niet nieuw. Onderzoekers in de politicologie hadden aangetoond dat vergelijkbare technieken met behulp van hoofdelijke stemgegevens de stemmen van leden van het Congres met een nauwkeurigheid van 90 procent konden voorspellen. In de psychologie was het 'Big Five'-model ook gebruikt om gedrag te voorspellen door persoonlijkheidsvragen te clusteren die meestal op dezelfde manier werden beantwoord.

Nog altijd, Het model van Funk was een grote vooruitgang:hierdoor kon de techniek goed werken met enorme datasets, zelfs die met veel ontbrekende gegevens - zoals de Netflix-dataset, waar een typische gebruiker slechts enkele tientallen films beoordeelde van de duizenden in de bibliotheek van het bedrijf. Meer dan een decennium nadat de Netflix Prize-wedstrijd eindigde, SVD-gebaseerde methoden, of gerelateerde modellen voor impliciete gegevens, zijn nog steeds de favoriete tool voor veel websites om te voorspellen wat gebruikers zullen lezen, kijk maar, of kopen.

Deze modellen kunnen andere dingen voorspellen, te.

Facebook weet of je een Republikein bent

In 2013, Cambridge University-onderzoekers Michal Kosinski, David Stillwell en Thore Graepel publiceerden een artikel over de voorspellende kracht van Facebook-gegevens, met behulp van informatie die is verzameld via een online persoonlijkheidstest. Hun eerste analyse was bijna identiek aan die van de Netflix-prijs, SVD gebruiken om zowel gebruikers als dingen die ze "leuk" vonden te categoriseren in de top 100 van factoren.

Het artikel toonde aan dat een factormodel gemaakt met alleen Facebook-likes van gebruikers 95 procent nauwkeurig was in het onderscheiden van zwarte en blanke respondenten. 93 procent nauwkeurig in het onderscheiden van mannen van vrouwen, en 88 procent nauwkeurig in het onderscheiden van mensen die zich identificeerden als homoseksuele mannen van mannen die zich identificeerden als hetero. Het kon zelfs 85 procent van de tijd de Republikeinen correct van de Democraten onderscheiden. Het was ook handig, hoewel niet zo nauwkeurig, voor het voorspellen van de scores van gebruikers op de "Big Five" persoonlijkheidstest.

Er was publieke verontwaardiging als reactie; binnen enkele weken had Facebook de likes van gebruikers standaard privé gemaakt.

Kogan en kanselier, ook onderzoekers van Cambridge University in die tijd, begonnen Facebook-gegevens te gebruiken voor verkiezingstargeting als onderdeel van een samenwerking met Cambridge Analytica's moederbedrijf SCL. Kogan nodigde Kosinski en Stillwell uit om deel te nemen aan zijn project, maar het viel niet mee. Kosinski vermoedde naar verluidt dat Kogan en Chancellor het 'vind-ik-leuks'-model van Facebook voor Cambridge Analytica zouden hebben aangepast. Kogan ontkende dit, zeggen dat zijn project "al onze modellen heeft gebouwd met behulp van onze eigen gegevens, verzameld met onze eigen software."

Wat deden Kogan en Chancellor eigenlijk?

Terwijl ik de ontwikkelingen in het verhaal volgde, het werd duidelijk dat Kogan en Chancellor inderdaad veel van hun eigen gegevens hadden verzameld via de app thisisyourdigitallife. Ze hadden zeker een voorspellend SVD-model kunnen bouwen zoals dat in het gepubliceerde onderzoek van Kosinski en Stillwell.

Dus ik heb Kogan een e-mail gestuurd om te vragen of hij dat had gedaan. Enigszins tot mijn verbazing, schreef hij terug.

"We gebruikten niet bepaald SVD, " Hij schreef, opmerkend dat SVD het moeilijk kan hebben als sommige gebruikers veel meer "vind-ik-leuks" hebben dan andere. In plaats daarvan, Kogan legde uit, "De techniek was iets dat we zelf hebben ontwikkeld... Het is niet iets dat zich in het publieke domein bevindt." Zonder in details te treden, Kogan beschreef hun methode als "een multi-step co-occurrence-benadering."

Echter, zijn bericht bevestigde verder dat zijn aanpak inderdaad vergelijkbaar was met SVD of andere matrixfactorisatiemethoden, zoals in de Netflix Prize-competitie, en het Kosinki-Stillwell-Graepel Facebook-model. Dimensionaliteitsreductie van Facebook-gegevens was de kern van zijn model.

Hoe nauwkeurig was het?

Kogan suggereerde dat het exacte gebruikte model er niet veel toe doet, hoewel - waar het om gaat, is de nauwkeurigheid van de voorspellingen. Volgens Kogan, de "correlatie tussen voorspelde en werkelijke scores ... was ongeveer [30 procent] voor alle persoonlijkheidsdimensies." Ter vergelijking, iemands eerdere Big Five-scores zijn ongeveer 70 tot 80 procent nauwkeurig in het voorspellen van hun scores wanneer ze de test opnieuw afleggen.

De nauwkeurigheidsclaims van Kogan kunnen niet onafhankelijk worden geverifieerd, natuurlijk. En iedereen die midden in zo'n spraakmakend schandaal zit, heeft misschien een reden om zijn of haar bijdrage te onderschatten. In zijn verschijning op CNN, Kogan legde aan een steeds ongeloviger Anderson Cooper uit dat, in feite, de modellen hadden eigenlijk niet zo goed gewerkt.

In feite, de nauwkeurigheid die Kogan claimt lijkt een beetje laag, maar aannemelijk. Kosinski, Stillwell en Graepel rapporteerden vergelijkbare of iets betere resultaten, net als verschillende andere academische onderzoeken die digitale voetafdrukken gebruiken om persoonlijkheid te voorspellen (hoewel sommige van die onderzoeken meer gegevens bevatten dan alleen "likes" van Facebook). Het is verrassend dat Kogan en Chancellor de moeite zouden nemen om hun eigen propriëtaire model te ontwerpen als kant-en-klare oplossingen net zo nauwkeurig zouden lijken.

belangrijk, Hoewel, de nauwkeurigheid van het model op persoonlijkheidsscores maakt vergelijkingen van Kogan's resultaten met ander onderzoek mogelijk. Gepubliceerde modellen met een gelijkwaardige nauwkeurigheid in het voorspellen van persoonlijkheid zijn allemaal veel nauwkeuriger in het raden van demografische en politieke variabelen.

Bijvoorbeeld, het vergelijkbare Kosinski-Stillwell-Graepel SVD-model was 85 procent nauwkeurig in het raden van partijlidmaatschap, zelfs zonder andere profielinformatie dan vind-ik-leuks te gebruiken. Kogan's model had een vergelijkbare of betere nauwkeurigheid. Het toevoegen van zelfs een kleine hoeveelheid informatie over vrienden of demografische gegevens van gebruikers zou deze nauwkeurigheid waarschijnlijk tot boven de 90 procent verhogen. Gissen over geslacht, ras, seksuele geaardheid en andere kenmerken zouden waarschijnlijk ook voor meer dan 90 procent nauwkeurig zijn.

Kritisch, deze gissingen zouden vooral goed zijn voor de meest actieve Facebook-gebruikers - de mensen waarop het model zich voornamelijk richtte. Gebruikers met minder activiteit om te analyseren, zijn waarschijnlijk toch niet veel op Facebook.

Wanneer psychografie voornamelijk demografie is

Weten hoe het model is opgebouwd, helpt Cambridge Analytica's ogenschijnlijk tegenstrijdige uitspraken te verklaren over de rol - of het gebrek daaraan - die persoonlijkheidsprofilering en psychografische gegevens speelden bij het modelleren. Ze zijn allemaal technisch consistent met wat Kogan beschrijft.

Een model als dat van Kogan zou schattingen geven voor elke variabele die beschikbaar is voor elke groep gebruikers. Dat betekent dat het automatisch de Big Five-persoonlijkheidsscores voor elke kiezer zou schatten. Maar deze persoonlijkheidsscores zijn de output van het model, niet de invoer. Het enige dat het model weet, is dat bepaalde Facebook-likes, and certain users, tend to be grouped together.

Met dit model, Cambridge Analytica could say that it was identifying people with low openness to experience and high neuroticism. But the same model, with the exact same predictions for every user, could just as accurately claim to be identifying less educated older Republican men.

Kogan's information also helps clarify the confusion about whether Cambridge Analytica actually deleted its trove of Facebook data, when models built from the data seem to still be circulating, and even being developed further.

The whole point of a dimension reduction model is to mathematically represent the data in simpler form. It's as if Cambridge Analytica took a very high-resolution photograph, resized it to be smaller, and then deleted the original. The photo still exists – and as long as Cambridge Analytica's models exist, the data effectively does too.

Dit artikel is oorspronkelijk gepubliceerd op The Conversation. Lees het originele artikel.

Nieuw materiaal verlaagt het energieverbruik in verband met de productie van ethyleen

Nieuw materiaal verlaagt het energieverbruik in verband met de productie van ethyleen Enzymmodel Wetenschapsprojecten

Enzymmodel Wetenschapsprojecten  Biphilic oppervlakken verminderen ontdooitijden in warmtewisselaars

Biphilic oppervlakken verminderen ontdooitijden in warmtewisselaars Tips voor het onthouden van sterke zuren en basen

Tips voor het onthouden van sterke zuren en basen

Als je de namen van sterke zuren en basen voor een chemie-examen moet onthouden, raak dan niet in paniek. Als eenvoudige herhaling niet werkt, probeer dan lijsten te schrijven of gebruik een mnemoni

Wat zijn de eigenschappen van vloeibaar?

Wat zijn de eigenschappen van vloeibaar?

Amerikaanse stromen bevatten een verrassend uitgebreid mengsel van verontreinigende stoffen

Amerikaanse stromen bevatten een verrassend uitgebreid mengsel van verontreinigende stoffen Oceanen warmen nog sneller op dan eerder werd gedacht

Oceanen warmen nog sneller op dan eerder werd gedacht Dramatische opwarming voorspeld in de grote steden ter wereld tegen 2050

Dramatische opwarming voorspeld in de grote steden ter wereld tegen 2050 Onderzoeker vindt goedkope manier om invasieve kokosnoten vanuit de ruimte te identificeren

Onderzoeker vindt goedkope manier om invasieve kokosnoten vanuit de ruimte te identificeren Kolencentraleplannen in India zijn in strijd met klimaatverplichtingen

Kolencentraleplannen in India zijn in strijd met klimaatverplichtingen

Hoofdlijnen

- Verschillende soorten enzymen

- Vergelijking van de hoeveelheid energie die twee soorten Galapagos-schildpadden nodig hebben om om te keren als ze eenmaal zijn omgedraaid

- Philadelphia Zoo euthanaseert populaire Aziatische zwarte beer

- Belofte van nieuwe antibiotica ligt in het aanhaken van kleine giftige tetherballs aan bacteriën

- Kerkuilen blijken geen gehoorverlies te hebben naarmate ze ouder worden

- Instructies voor het maken van een JELL-O Cell

- Huilende olifanten en giechelende ratten - dieren hebben gevoelens, te

- Septate vs. Non-Septate Hyphae

- Is geluk besmettelijk?

- Franse IT-servicegroep Atos koopt Syntel of US

- Is de kerstman echt? Een versie van Alexa omzeilt enkele kindervragen

- Nieuwe haptische arm plaatst robotica binnen handbereik

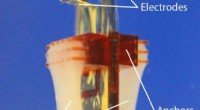

- Verbeterde integratie van levende spieren in robots

- Neurale netwerken hebben geleerd soortgelijke objecten op video's te herkennen zonder verslechtering van de nauwkeurigheid

AI kan een revolutie teweegbrengen in DNA-bewijs, maar op dit moment kunnen we de machines niet vertrouwen

AI kan een revolutie teweegbrengen in DNA-bewijs, maar op dit moment kunnen we de machines niet vertrouwen Afbeelding:De schoonheid van ijs

Afbeelding:De schoonheid van ijs Hoe de HondaJet werkt

Hoe de HondaJet werkt  Buitenlands afval als een schat in het plastic dorp van Indonesië

Buitenlands afval als een schat in het plastic dorp van Indonesië Hoe onderzoekers water uit de lucht oogsten

Hoe onderzoekers water uit de lucht oogsten  Wetenschappers maken sensoren met vallen voor vrije radicalen

Wetenschappers maken sensoren met vallen voor vrije radicalen Waarom is water belangrijk voor levende organismen?

Waarom is water belangrijk voor levende organismen?  Een kunstmatige tong van goud om ahornsiroop te proeven

Een kunstmatige tong van goud om ahornsiroop te proeven

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Spanish | Portuguese | Swedish | German | Dutch | Danish | Italian | Norway |

-

Wetenschap © https://nl.scienceaq.com