Wetenschap

De mens voor de gek houden via wijzigingen in afbeeldingen

Krediet:OpenAI

We zullen, zozeer voor een veronderstelling die nu te gemakkelijk klinkt om te accepteren - dat het prachtige menselijke brein het elke dag boven een machine heeft. Werkelijk? Interpreteren we de wereld nauwkeuriger dan een 'convolutioneel neuraal netwerk' kan?

Zoals zelfs Ackerman opmerkte, "wanneer een CNN [convolutioneel neuraal netwerk] een afbeelding krijgt, het kijkt naar een statisch raster van rechthoekige pixels."

We kijken naar beelden en zien ze correct, zoals mensen en dieren; CNN's kijken meer naar computers.

Een onderzoeksteam stelt vragen over gemakkelijke aannames, echter. Ze onderzoeken wat er gebeurt met vijandige voorbeelden met betrekking tot mensen.

Inputs voor machine learning-modellen die zijn ontworpen om ervoor te zorgen dat de modellen een fout maken, zijn 'tegenstrijdige voorbeelden'. Tegenstrijdige voorbeelden, als zodanig, mogelijk gevaarlijk kan zijn.

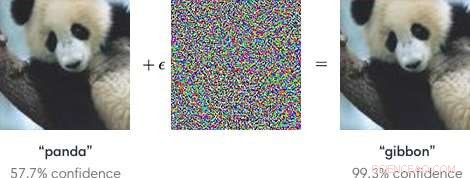

Simpel gezegd, "Adversariële voorbeelden zijn kwaadaardige invoer die is ontworpen om machine learning-modellen voor de gek te houden, " volgens een Google Research-pagina.

Zoals een blogpost in OpenAI uitlegde, aanvallers kunnen zich richten op autonome voertuigen door stickers of verf te gebruiken om een vijandig stopbord te creëren dat het voertuig zou interpreteren als een 'opbrengst' of ander teken.

De onderzoekers, door te praten over modellen voor machinaal leren als kwetsbaar voor voorbeelden van tegenstanders, merkte op dat kleine veranderingen in afbeeldingen ertoe kunnen leiden dat computervisiemodellen fouten maken, zoals het identificeren van een schoolbus als een struisvogel.

De blog van OpenAI verwees naar tegenstrijdige voorbeelden als een concreet probleem in AI-veiligheid.

Dat gezegd te hebben, hoe zit het met tegenstrijdige voorbeelden die mensen voor de gek houden? Kan dat gebeuren?

Het team, zei Zelfs Ackerman in IEEE-spectrum , "besloten om te proberen uit te zoeken of dezelfde technieken die kunstmatige neurale netwerken voor de gek houden, ook de biologische neurale netwerken in ons hoofd voor de gek kunnen houden."

De onderzoekspaper die hun werk beschrijft, is "Adversarial Voorbeelden that Fool both Human and Computer Vision, " op arXiv.

"Hier, we creëren de eerste vijandige voorbeelden die zijn ontworpen om mensen voor de gek te houden, " schreven ze. Ze ontdekten dat "tegenstrijdige voorbeelden die sterk worden overgedragen over computervisiemodellen, de classificaties beïnvloeden die worden gemaakt door in de tijd beperkte menselijke waarnemers." (Ackerman merkte op dat in het onderzoek, mensen hadden slechts tussen de 60 en 70 milliseconden om naar elke afbeelding te kijken en een beslissing te nemen.)

IEEE-spectrum 's Even Ackerman besprak wat ze deden en presenteerde een set van twee afbeeldingen van Google Brain om zijn uitleg te ondersteunen.

Ackerman toonde "links een foto van een kat. kun je zien of het een foto is van dezelfde kat, of een foto van een soortgelijk uitziende hond? Het verschil tussen de twee afbeeldingen is dat de afbeelding aan de rechterkant een beetje is aangepast door een algoritme om het moeilijk te maken voor een type computermodel dat een convolutioneel neuraal netwerk (CNN) wordt genoemd, om te kunnen vertellen wat het werkelijk is. In dit geval, de CNN denkt dat het naar een hond kijkt in plaats van naar een kat, maar wat opmerkelijk is, is dat de meeste mensen hetzelfde denken."

Wat? Hoe kunnen mensen dezelfde fout maken? Ackerman zei dat het mogelijk zou kunnen zijn om de ontwikkeling van een vijandig beeld op mensen te richten "door modellen te kiezen die zo goed mogelijk aansluiten bij het menselijke visuele systeem."

Maar wat knoeit er precies met het vermogen van de mens om correct te zijn? Ackerman zei dat de onderzoekers erop wezen dat "onze tegenstrijdige voorbeelden zijn ontworpen om de menselijke perceptie voor de gek te houden, dus we moeten voorzichtig zijn met het gebruik van subjectieve menselijke perceptie om te begrijpen hoe ze werken."

Hij zei dat ze bereid waren enkele generalisaties te maken "over een paar verschillende categorieën van wijzigingen, inclusief 'verstorende objectranden, vooral door middenfrequentiemodulaties loodrecht op de rand; randen verbeteren, zowel door het contrast te vergroten als door textuurgrenzen te creëren; het wijzigen van textuur; en profiteren van donkere gebieden in het beeld, waar de perceptuele omvang van kleine verstoringen groter kan zijn.'"

Hoe ze testten:proefpersonen met een normaal of gecorrigeerd zicht namen deel aan het experiment.

"Voor elke groep een succesvol vijandig imago was in staat om mensen voor de gek te houden door het verkeerde lid van de groep te kiezen, door het te identificeren als een hond terwijl het eigenlijk een kat is, of vice versa, ' zei Ackermans.

Onderwerpen werd gevraagd om afbeeldingen die op het scherm verschenen te classificeren door op knoppen op een responstijdvak te drukken, aldus de auteurs.

Ackerman schreef, "De korte tijd dat de afbeelding werd getoond, verkleinde het verschil tussen hoe CNN's de wereld waarnemen en hoe mensen dat doen."

Het experiment omvatte drie groepen afbeeldingen:huisdieren (katten en honden), groenten (kool en broccoli), en "gevaar" (spinnen en slangen).

Ackerman's comment on the research findings was that "there's overlap between the perceptual manipulation of CNNs and the manipulation of humans. It means that machine learning techniques could potentially be used to subtly alter things like pictures or videos in a way that could change our perception of (and reaction to) them without us ever realizing what was going on."

He added that "we'll have to be careful, and keep in mind that just like those computers, sometimes we're far too easy to fool."

"Adversarial Examples that Fool both Human and Computer Vision" is by Gamaleldin F. Elsayed, Shreya Shankar, Brian Cheung, Nicolas Papernot, Alex Kurakin, Ian Goodfellow, and Jascha Sohl-Dickstein, on arXiv.

© 2018 Tech Xplore

Onderzoekers van SSA bespreken de prestaties van vroegtijdige waarschuwingssystemen voor aardbevingen

Onderzoekers van SSA bespreken de prestaties van vroegtijdige waarschuwingssystemen voor aardbevingen Hoe beïnvloedt klimaatverandering biodiversiteit?

Hoe beïnvloedt klimaatverandering biodiversiteit?  Hoe beleid tegen wildgroei de waterkwaliteit kan schaden

Hoe beleid tegen wildgroei de waterkwaliteit kan schaden Wat is het verschil tussen de korst en de lithosfeer?

Wat is het verschil tussen de korst en de lithosfeer?  NASA ziet tropische cycloon Hola Vanuatu doordrenken, Nieuw-Caledonië

NASA ziet tropische cycloon Hola Vanuatu doordrenken, Nieuw-Caledonië

Hoofdlijnen

- Wereldwijd belang van honingbijen voor natuurlijke habitats vastgelegd in nieuw rapport

- Hoe reproduceren protisten?

- Gymnospermen: definitie, levenscyclus, typen en voorbeelden

- West-Afrikaanse dolfijn staat nu op de lijst van zeldzaamste zoogdieren van Afrika

- Colombia - een megadivers paradijs dat nog ontdekt moet worden

- Energiebesparende LED's stimuleren wereldwijd lichtvervuiling

- Is er een verband tussen dankbaarheid en geluk?

- Welke soort is het meest geschikt voor het leven? Allen hebben een gelijke kans, wetenschappers zeggen:

- Natuurbeschermingsgroep zegt dat Japan helpt bij illegale ivoorhandel (update)

- Nieuw AI-model probeert patiëntgegevens te synthetiseren zoals artsen dat doen

- AMD voert zijn Ryzen-game op met 45W-chips

- Nieuwe robot voor schedelbasischirurgie verlicht de werklast van chirurgen

- Boeing-aandelen zakken in doordat de winst van 737 wordt gewogen

- Kwartaalwinst Toyota stijgt door stijgende verkopen, kostenbesparingen

Sneeuwvalfrequentie neemt af in Noordwest, studie vondsten

Sneeuwvalfrequentie neemt af in Noordwest, studie vondsten Oplossing voor Sigma op een TI83

Oplossing voor Sigma op een TI83 Afbeelding:Zweden in vlammen

Afbeelding:Zweden in vlammen Astronomen spotten een verre en eenzame neutronenster

Astronomen spotten een verre en eenzame neutronenster "What Are Oxidants?

"What Are Oxidants? Voel je je zout over klimaatverandering? Laten we het hebben over ontzilting

Voel je je zout over klimaatverandering? Laten we het hebben over ontzilting Grote moleculen uit voedingsvezels kunnen de darmomgeving veranderen door fysieke krachten

Grote moleculen uit voedingsvezels kunnen de darmomgeving veranderen door fysieke krachten De microstructuur van gestabiliseerde olie-in-water-emulsies uitpakken met behulp van neutronenverstrooiingstechnieken

De microstructuur van gestabiliseerde olie-in-water-emulsies uitpakken met behulp van neutronenverstrooiingstechnieken

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com