Wetenschap

Hey Siri:hoeveel weegt deze melkwegcluster?

Krediet:Pixabay/CC0 publiek domein

Het is bijna een eeuw geleden dat astronoom Fritz Zwicky voor het eerst de massa berekende van de Coma Cluster, een dichte verzameling van bijna 1000 sterrenstelsels in het nabije heelal. Maar het schatten van de massa van iets dat zo groot en compact is, om nog maar te zwijgen van 320 miljoen lichtjaar verwijderd, heeft zijn problemen - toen en nu. Zwicky's eerste metingen, en de vele die sindsdien zijn gedaan, worden geplaagd door foutenbronnen die de massa hoger of lager bepalen.

Nu heeft een team onder leiding van fysici van Carnegie Mellon University, met behulp van tools van machine learning, een diepgaande leermethode ontwikkeld die de massa van de Coma Cluster nauwkeurig schat en de bronnen van fouten effectief vermindert.

"Mensen maken al vele, vele jaren massale schattingen van de Coma Cluster. Maar door aan te tonen dat onze methoden voor machinaal leren consistent zijn met deze eerdere massale schattingen, bouwen we vertrouwen op in deze nieuwe, zeer krachtige methoden die populair zijn in het veld van kosmologie op dit moment", zegt Matthew Ho, een vijfdejaars afgestudeerde student in het McWilliams Center for Cosmology van het Department of Physics en een lid van Carnegie Mellon's NSF AI Planning Institute for Physics of the Future.

Methoden voor machinaal leren worden met succes op verschillende gebieden gebruikt om patronen in complexe gegevens te vinden, maar ze hebben pas in het afgelopen decennium voet aan de grond gekregen in kosmologisch onderzoek. Voor sommige onderzoekers in het veld brengen deze methoden een grote zorg met zich mee:aangezien het moeilijk is om de innerlijke werking van een complex machine-learningmodel te begrijpen, kunnen ze worden vertrouwd om te doen waarvoor ze zijn ontworpen? Ho en zijn collega's probeerden deze reserveringen aan te pakken met hun laatste onderzoek, gepubliceerd in Nature Astronomy .

Om de massa van de Coma Cluster te berekenen, gebruikten Zwicky en anderen een dynamische massameting, waarbij ze de beweging of snelheid van objecten die in en rond de cluster cirkelen bestudeerden en vervolgens hun begrip van de zwaartekracht gebruikten om de massa van de cluster af te leiden. Maar deze meting is onderhevig aan een verscheidenheid aan fouten. Clusters van sterrenstelsels bestaan als knooppunten in een enorm web van materie verspreid over het heelal, en ze botsen en versmelten voortdurend met elkaar, wat het snelheidsprofiel van de samenstellende sterrenstelsels vervormt. En omdat astronomen de cluster van een grote afstand observeren, zijn er een heleboel andere dingen daartussenin die eruit kunnen zien en zich kunnen gedragen alsof ze deel uitmaken van de cluster van sterrenstelsels, wat de massameting kan vertekenen. Recent onderzoek heeft vooruitgang geboekt bij het kwantificeren en verantwoorden van het effect van deze fouten, maar volgens Ho bieden op machine learning gebaseerde methoden een innovatieve, gegevensgestuurde aanpak.

"Onze diepgaande leermethode leert van echte gegevens wat nuttige metingen zijn en wat niet", zei Ho, eraan toevoegend dat hun methode fouten uit in elkaar overlopende sterrenstelsels elimineert (selectie-effecten) en rekening houdt met verschillende vormen van sterrenstelsels (fysieke effecten). "Het gebruik van deze gegevensgestuurde methoden maakt onze voorspellingen beter en geautomatiseerd."

"Een van de grootste tekortkomingen van standaard machine learning-benaderingen is dat ze meestal resultaten opleveren zonder enige onzekerheden", voegt universitair hoofddocent natuurkunde Hy Trac, Ho's adviseur, toe. "Onze methode omvat robuuste Bayesiaanse statistieken, waarmee we de onzekerheid in onze resultaten kunnen kwantificeren."

Ho en zijn collega's ontwikkelden hun nieuwe methode door een bekend hulpmiddel voor machine learning aan te passen, een convolutioneel neuraal netwerk genaamd, een soort dieplerend algoritme dat wordt gebruikt bij beeldherkenning. De onderzoekers trainden hun model door het gegevens van kosmologische simulaties van het universum te geven. Het model leerde het door te kijken naar de waarneembare kenmerken van duizenden clusters van sterrenstelsels, waarvan de massa al bekend is. Na een grondige analyse van de verwerking van de simulatiegegevens door het model, paste Ho het toe op een echt systeem - de Coma Cluster - waarvan de ware massa niet bekend is. De methode van Ho berekende een massaschatting die consistent is met de meeste massaschattingen die sinds de jaren tachtig zijn gemaakt. Dit is de eerste keer dat deze specifieke machine learning-methodologie is toegepast op een observatiesysteem.

"Om de betrouwbaarheid van machine learning-modellen te bouwen, is het belangrijk om de voorspellingen van het model op goed bestudeerde systemen, zoals Coma, te valideren," zei Ho. "We voeren momenteel een meer rigoureuze, uitgebreide controle van onze methode uit. De veelbelovende resultaten zijn een sterke stap in de richting van het toepassen van onze methode op nieuwe, niet-bestudeerde gegevens."

Modellen zoals deze zullen van cruciaal belang zijn voor de toekomst, vooral wanneer grootschalige spectroscopische onderzoeken, zoals het Dark Energy Spectroscopic Instrument, het Vera C. Rubin Observatory en Euclid, de enorme hoeveelheden gegevens die ze van de lucht verzamelen beginnen vrij te geven .

"Binnenkort hebben we een datastroom op petabyteschaal", legt Ho uit. "Dat is enorm. Het is onmogelijk voor mensen om dat met de hand te ontleden. Terwijl we werken aan het bouwen van modellen die robuuste schatters kunnen zijn van zaken als massa en tegelijkertijd bronnen van fouten verminderen, is een ander belangrijk aspect dat ze rekenkundig efficiënt moeten zijn als we we gaan deze enorme gegevensstroom uit deze nieuwe enquêtes verwerken. En dat is precies wat we proberen aan te pakken:machine learning gebruiken om onze analyses te verbeteren en sneller te maken." + Verder verkennen

De grootste suite van kosmische simulaties voor AI-training, gratis te downloaden, die nu al ontdekkingen stimuleert

Kristallisatie opgehelderd, onderzoekers rapporteren

Kristallisatie opgehelderd, onderzoekers rapporteren Welke rol spelen vitaminen in enzymactiviteit?

Welke rol spelen vitaminen in enzymactiviteit?  Haarverf is giftig - kunnen natuurlijke alternatieven worden gemaakt om te werken?

Haarverf is giftig - kunnen natuurlijke alternatieven worden gemaakt om te werken? On-chip pompen zorgen voor snelle sortering van grote cellen

On-chip pompen zorgen voor snelle sortering van grote cellen Nieuw copolymeerbindmiddel om de levensduur van lithium-ionbatterijen te verlengen

Nieuw copolymeerbindmiddel om de levensduur van lithium-ionbatterijen te verlengen

Hoofdlijnen

- Dierenartsen voeren de eerste bekende hersenoperatie uit om hydrocephalus bij pelsrobben te behandelen

- Sequentiebepaling van het genoom van stevia-planten voor het eerst onthuld

- Forest Service weegt wijzigingen in bescherming voor saliehoen af

- Als uw nieuwjaarsresolutie is om fit te worden, uw hond kan uw perfecte trainingspartner zijn

- Investeren in natuurbehoud loont, studie vondsten

- Wat zijn de niveaus van organisatie in de biologie?

- Wat is het Malthusiaanse uitgangspunt?

- Niet zo koude eend? Man blijft zoeken naar uitgestorven vogel

- Dengue Achilleshiel inzicht biedt hoop op betere vaccins

- Kerstbezorging bij ruimtestation, met dank aan Japan

- Een leven met insecten:Millimeter hoge bergen op neutronensterren

- Gelaagdheid, niet vloeibaar:astronomen verklaren de waterige reflecties van Mars

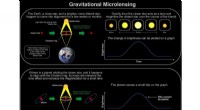

- Vergrootglas van de natuur onthult onverwachte exoplaneten met tussenliggende massa

- Als er vorig leven op Mars bestond, het evolueerde samen met de omgeving van Mars

Gecontroleerde faagtherapie kan zich richten op medicijnresistente bacteriën en tegelijkertijd mogelijke onbedoelde gevolgen omzeilen

Gecontroleerde faagtherapie kan zich richten op medicijnresistente bacteriën en tegelijkertijd mogelijke onbedoelde gevolgen omzeilen Ontdekking dat grootte belangrijk is in cel-tot-cel communicatie, zou nieuwe methoden voor ziektediagnose en -behandeling kunnen ontsluiten

Ontdekking dat grootte belangrijk is in cel-tot-cel communicatie, zou nieuwe methoden voor ziektediagnose en -behandeling kunnen ontsluiten Een snelle en gemakkelijke manier om instabiliteiten in fusie-apparaten te stoppen

Een snelle en gemakkelijke manier om instabiliteiten in fusie-apparaten te stoppen AI voor code stimuleert samenwerking, open wetenschappelijke ontdekking

AI voor code stimuleert samenwerking, open wetenschappelijke ontdekking Gigantische Hawaii-telescoop om zich te concentreren op grote onbekenden van het universum

Gigantische Hawaii-telescoop om zich te concentreren op grote onbekenden van het universum In India, het verwisselen van gewassen kan water besparen en de voeding verbeteren

In India, het verwisselen van gewassen kan water besparen en de voeding verbeteren Religieus links gemobiliseerd in solidariteit voor Womens March on Chicago, studie vondsten

Religieus links gemobiliseerd in solidariteit voor Womens March on Chicago, studie vondsten NASA-missies bieden nieuwe inzichten in oceaanwerelden in ons zonnestelsel

NASA-missies bieden nieuwe inzichten in oceaanwerelden in ons zonnestelsel

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com