Wetenschap

Wetenschappers gebruiken kunstmatige intelligentie om zwaartekrachtsgolven te detecteren

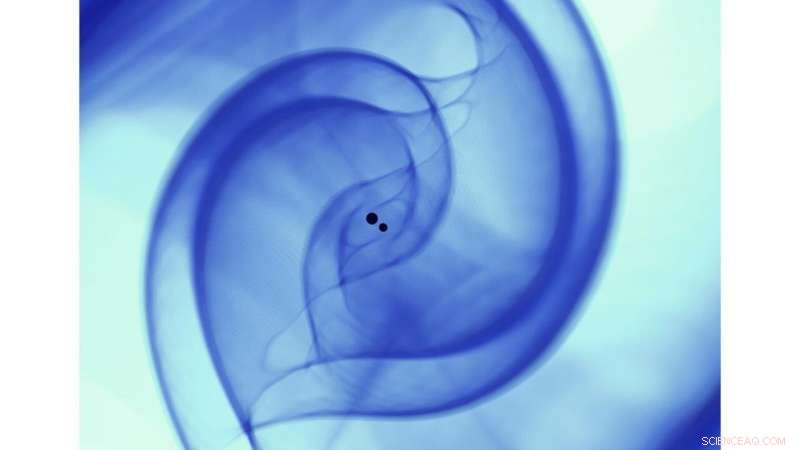

Wetenschappelijke visualisatie van een numerieke relativiteitssimulatie die de botsing van twee zwarte gaten beschrijft in overeenstemming met de binaire fusie van zwarte gaten GW170814. De simulatie is gedaan op de Theta-supercomputer met behulp van de open source, numerieke relativiteit, community-software Einstein Toolkit (https://einsteintoolkit.org/). Krediet:Argonne Leadership Computing Facility, Visualisatie en data-analysegroep [Janet Knowles, Joseph Insley, Victor Mateevitsi, Silvio Rizzi].)

Toen in 2015 voor het eerst zwaartekrachtsgolven werden gedetecteerd door de geavanceerde Laser Interferometer Gravitational-Wave Observatory (LIGO), ze stuurden een rimpeling door de wetenschappelijke gemeenschap, terwijl ze een andere theorie van Einstein bevestigden en de geboorte van zwaartekrachtsgolfastronomie markeerden. Vijf jaar later, talrijke bronnen van zwaartekrachtgolven zijn ontdekt, inclusief de eerste waarneming van twee botsende neutronensterren in zwaartekracht- en elektromagnetische golven.

Terwijl LIGO en zijn internationale partners doorgaan met het verbeteren van de gevoeligheid van hun detectoren voor zwaartekrachtsgolven, ze zullen in staat zijn om een groter volume van het universum te onderzoeken, waardoor de detectie van zwaartekrachtsgolfbronnen een dagelijkse gebeurtenis wordt. Deze ontdekkingszondvloed zal het tijdperk van precisieastronomie lanceren dat rekening houdt met extrasolaire boodschapperfenomenen, inclusief elektromagnetische straling, zwaartekracht golven, neutrino's en kosmische straling. Het realiseren van dit doel, echter, vereist een radicale heroverweging van bestaande methoden die worden gebruikt om zwaartekrachtgolven te zoeken en te vinden.

Onlangs, computationeel wetenschapper en leider voor translationele kunstmatige intelligentie (AI) Eliu Huerta van het Argonne National Laboratory van het Amerikaanse Department of Energy (DOE), in samenwerking met medewerkers van Argonne, de Universiteit van Chicago, de Universiteit van Illinois in Urbana-Champaign, NVIDIA en IBM, heeft een nieuw AI-raamwerk op productieschaal ontwikkeld dat versnelde, schaalbare en reproduceerbare detectie van zwaartekrachtsgolven.

Dit nieuwe raamwerk geeft aan dat AI-modellen net zo gevoelig kunnen zijn als traditionele algoritmen voor het matchen van sjablonen, maar orden van grootte sneller. Verder, deze AI-algoritmen zouden alleen een goedkope grafische verwerkingseenheid (GPU) nodig hebben, zoals die gevonden worden in videospelsystemen, om geavanceerde LIGO-gegevens sneller dan realtime te verwerken.

Het AI-ensemble dat voor dit onderzoek werd gebruikt, verwerkte een hele maand – augustus 2017 – aan geavanceerde LIGO-gegevens in minder dan zeven minuten, het distribueren van de dataset over 64 NVIDIA V100 GPU's. Het AI-ensemble dat door het team voor deze analyse werd gebruikt, identificeerde alle vier binaire fusies van zwarte gaten die eerder in die dataset waren geïdentificeerd. en rapporteerde geen misclassificaties.

"Als computerwetenschapper wat ik zo boeiend vind aan dit project, " zei Ian Foster, directeur van de divisie Data Science and Learning (DSL) van Argonne, "is dat het laat zien hoe, met het juiste gereedschap, AI-methoden kunnen op natuurlijke wijze worden geïntegreerd in de workflows van wetenschappers, waardoor ze hun werk sneller en beter kunnen doen, waardoor niet vervangen, menselijke intelligentie."

Het inzetten van ongelijksoortige middelen, dit interdisciplinaire en multi-institutionele team van medewerkers heeft een paper gepubliceerd in Natuurastronomie met een gegevensgestuurde aanpak die de collectieve supercomputerbronnen van het team combineert om reproduceerbare, versneld, AI-gestuurde detectie van zwaartekrachtgolven.

"In dit onderzoek, we hebben de gecombineerde kracht van AI en supercomputing gebruikt om tijdige en relevante big-data-experimenten op te lossen. We maken AI-onderzoeken nu volledig reproduceerbaar, niet alleen vaststellen of AI een nieuwe oplossing kan bieden voor grote uitdagingen, ' zei Huerta.

Voortbouwend op het interdisciplinaire karakter van dit project, het team kijkt uit naar nieuwe toepassingen van dit datagestuurde raamwerk dat verder gaat dan big data-uitdagingen in de natuurkunde.

"Dit werk benadrukt de significante waarde van data-infrastructuur voor de wetenschappelijke gemeenschap, " zei Ben Blaiszik, een onderzoekswetenschapper aan Argonne en de Universiteit van Chicago. "De langetermijninvesteringen die DOE heeft gedaan, de Nationale Wetenschapsstichting (NSF), de National Institutes of Standards and Technology en anderen hebben een reeks bouwstenen gecreëerd. Het is voor ons mogelijk om deze bouwstenen op nieuwe en opwindende manieren samen te brengen om deze analyse te schalen en om deze mogelijkheden in de toekomst aan anderen te leveren."

Huerta en zijn onderzoeksteam ontwikkelden hun nieuwe raamwerk met de steun van de NSF, Argonne's Laboratory Directed Research and Development (LDRD) programma en DOE's Innovative and Novel Computational Impact on Theory and Experiment (INCITE) programma.

"Deze NSF-investeringen bevatten originele, innovatieve ideeën die een belangrijke belofte inhouden voor het transformeren van de manier waarop wetenschappelijke gegevens die in snelle stromen binnenkomen, worden verwerkt. De geplande activiteiten brengen versnelde en heterogene computertechnologie naar veel wetenschappelijke praktijkgemeenschappen, " zei Manish Parashar, directeur van het Office of Advanced Cyberinfrastructure bij NSF.

Vragen dwarrelen over Portugal brandt weg des doods

Vragen dwarrelen over Portugal brandt weg des doods Verkeersvervuiling neemt af tijdens lockdown, maar andere risico's voor de luchtkwaliteit nemen toe, onderzoekers onthullen

Verkeersvervuiling neemt af tijdens lockdown, maar andere risico's voor de luchtkwaliteit nemen toe, onderzoekers onthullen Portugese privébrandweerlieden waken over vluchtige bossen

Portugese privébrandweerlieden waken over vluchtige bossen Canada gaat CO2-belasting opleggen aan provincies die klimaatactie tegengaan

Canada gaat CO2-belasting opleggen aan provincies die klimaatactie tegengaan Onmogelijk onderzoek levert 400 jaar El Nino-record op, onthullende verrassende veranderingen

Onmogelijk onderzoek levert 400 jaar El Nino-record op, onthullende verrassende veranderingen

Hoofdlijnen

- Onderzoek naar maïsgenetica onthult het mechanisme achter het stil worden van eigenschappen

- Een verticale laminaire luchtstromingskap reinigen

- Wat eerst kwam,

- Hoe kan een mutatie in DNA invloed hebben op eiwitsynthese?

- Je kunt echt op je naam lijken,

- Huilende olifanten en giechelende ratten - dieren hebben gevoelens, te

- Trucs voor het onthouden van dierenfylum

- Een DNA-model maken met behulp van pijpreinigers

- Onderzoek suggereert dat gorilla's spontaan voedselreinigingsgedrag kunnen ontwikkelen

- Uniforme modellen van chorusgolffrequentie getjilp

- Asteroïdebotsingen leiden tot trapsgewijze vorming van subfamilies, studie concludeert

- Mars zou genoeg moleculaire zuurstof kunnen hebben om leven te ondersteunen, en wetenschappers ontdekten waar ze het konden vinden

- Waar ruimtemissies worden geboren

- Stellaire pulsaties verspreiden het belangrijkste ingrediënt voor het leven

Grafeen en DNA:Wondermateriaal kan de sleutel zijn tot vasten, goedkope genetische sequencing

Grafeen en DNA:Wondermateriaal kan de sleutel zijn tot vasten, goedkope genetische sequencing Snapchat is er voor jou met een nieuwe functie voor geestelijke gezondheid

Snapchat is er voor jou met een nieuwe functie voor geestelijke gezondheid DropSynth, een eenpotsbenadering van gensynthese

DropSynth, een eenpotsbenadering van gensynthese National Geographic erkent eerdere racistische berichtgeving

National Geographic erkent eerdere racistische berichtgeving NASA vindt tropische cycloon Joaninha die een oogje in het zeil houdt

NASA vindt tropische cycloon Joaninha die een oogje in het zeil houdt Anti-hulpretoriek heeft impact, maar alleen onder fans van populistische politici

Anti-hulpretoriek heeft impact, maar alleen onder fans van populistische politici Hoe te weten wanneer een titratie voltooid is

Hoe te weten wanneer een titratie voltooid is Wiskundige logica begrijpen

Wiskundige logica begrijpen

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway | French |

-

Wetenschap © https://nl.scienceaq.com