Wetenschap

Er is een nieuwe methode ontwikkeld voor het oplossen van een reeks globale optimalisatieproblemen

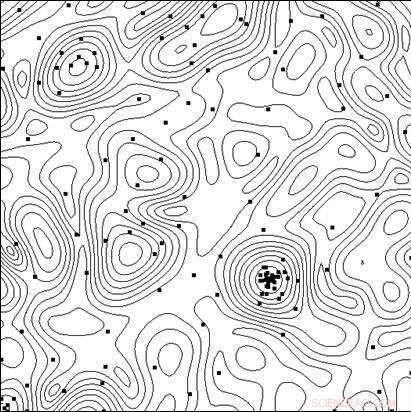

Lijnen van het objectieve functieniveau en de punten van de tests die door het algoritme zijn uitgevoerd tijdens het proces van het vinden van het minimum. Krediet:Lobachevsky University

Om zeer effectieve technische systemen en technologische processen te creëren, naast het gebruik van nieuwe principes, nieuwe materialen, nieuwe fysieke effecten en andere oplossingen die de algehele structuur van het object dat wordt gecreëerd bepalen, onderzoekers moeten de beste combinatie van de parameters van het object kiezen (geometrische afmetingen, elektrische kenmerken, enzovoort.), aangezien eventuele wijzigingen in de parameters met een vaste algemene objectstructuur een aanzienlijke invloed kunnen hebben op de effectiviteitsindicatoren.

Bij computerondersteund ontwerp het testen van opties kan worden uitgevoerd door het wiskundige model ervan te analyseren voor verschillende parameterwaarden. Naarmate de modellen steeds complexer worden, de behoefte ontstaat aan een gerichte keuze van opties in de zoektocht naar de optimale (meest effectieve) oplossing.

Een team van wetenschappers van de Lobachevsky State University van Nizhny Novgorod (UNN) onder leiding van professor Roman Strongin heeft de gerichte keuzes bestudeerd bij het zoeken naar de optimale oplossing. Het omvat een analyse van een deelverzameling van de mogelijke opties met als doel duidelijk kansloze gevallen uit te sluiten en de zoektocht te concentreren op de deelverzameling die de beste optie bevat.

"Als wiskundige modellen van de processen die in een object plaatsvinden ingewikkelder worden, de efficiëntiekenmerken zullen niet de eigenschap van monotoniciteit bezitten, daarom zijn lokale zoekmethoden onvoldoende om de beste optie te evalueren, " zegt professor Roman Strongin.

De globale zoekprocedures die bij dergelijke problemen worden gebruikt (ook wel multi-extremale optimalisatieproblemen genoemd) zorgen ervoor dat de zoekopdracht gericht is door rekening te houden met de beperkte aard van de verandering in de kenmerken van het object wanneer de veranderingen in zijn parameters beperkt zijn. De resulterende wiskundige formulering kan de vorm aannemen van de Lipschitz-voorwaarde, de uniforme Hölder-conditie, enzovoort.

Multi-extremale optimalisatieproblemen bieden een beperkt aantal analytische onderzoeksmogelijkheden, en ze worden rekenkundig duur bij het zoeken naar numerieke oplossingen, aangezien de rekenkosten exponentieel groeien met de toenemende omvang van het probleem.

Volgens Konstantin Barkalov, Universitair hoofddocent van het UNN Department of Software and Supercomputer Technologies, het gebruik van moderne parallelle computersystemen breidt de reikwijdte van wereldwijde optimalisatiemethoden uit. Echter, tegelijkertijd, het vormt de uitdaging om het zoekproces effectief te parallelliseren.

"Daarom moeten de belangrijkste inspanningen op dit gebied worden geconcentreerd op het ontwikkelen van efficiënte parallelle methoden voor het numeriek oplossen van multi-extremale optimalisatieproblemen en het creëren van geschikte software voor moderne computersystemen op basis van dergelijke methoden, ' zegt Barkalov.

Gebruikelijk, de methoden van globale optimalisatie (zowel sequentieel als parallel) zijn bedoeld om een enkel optimalisatieprobleem op te lossen. Om een reeks q-problemen op te lossen, de problemen in de reeks worden sequentieel opgelost, de een na de ander. Daarom, de optimale schatting in het i-de probleem in de reeks blijft ongedefinieerd totdat alle voorgaande problemen van de reeks (met de indices 1, 2, . . . , l ? 1) zijn volledig opgelost. In het geval van beperkte rekenkracht, de optima schattingen in de problemen i + 1, . . . , q wordt niet verkregen als de rekenbronnen zijn uitgeput bij het oplossen van het i-de probleem.

Situaties waarin een reeks q-problemen moet worden opgelost, zijn niet uitzonderlijk. Bijvoorbeeld, een reeks scalaire problemen doet zich voor bij het zoeken naar een Pareto-set voor het oplossen van optimalisatieproblemen met meerdere doelstellingen. In dit geval, de oplossing van een enkelvoudig scalair probleem komt overeen met een van de Pareto-optimale punten van een probleem met meerdere doelstellingen. Een reeks optimalisatieproblemen doet zich ook voor bij het gebruik van dimensiereductiemethoden om multidimensionale optimalisatieproblemen op te lossen. Eindelijk, een reeks testproblemen kan ook worden verkregen met behulp van een bepaalde testprobleemgenerator.

Wetenschappers geloven dat bij het oplossen van een reeks problemen, het is noodzakelijk om in één keer een eerste schatting te hebben van oplossingen voor alle problemen, zodat het op elk moment mogelijk is om de opportuniteit van het voortzetten van de zoektocht te evalueren. In dit geval, het is wenselijk om de optimale schattingen voor alle problemen met dezelfde nauwkeurigheid te hebben.

Veel onafhankelijke processen uitvoeren in een parallel computersysteem, elk van de processen die één probleem uit een reeks oplossen, heeft een aantal nadelen. Eerst, een onbalans in de werkbelasting tussen de processors zal optreden. Als het oplossen van het i -de probleem aanzienlijk minder iteraties van de methode vereist dan het oplossen van het j -de probleem, de processor die belast is met het behandelen van het i -de probleem zou inactief blijven na het voltooien van de taak. Tweede, de schattingen van de optima zullen met verschillende precisie worden verkregen in verschillende problemen. Eenvoudigere problemen worden met hogere precisie opgelost, terwijl de precisie lager zal zijn voor complexere problemen.

Het doel van het onderzoek aan de Lobachevsky Universiteit was om een nieuwe methode te ontwikkelen voor het oplossen van een reeks globale optimalisatieproblemen die zou zorgen voor:(i) een uniforme belasting van alle gebruikte cores/processors; (ii) een uniforme convergentie naar de oplossingen van alle problemen in de reeks.

In het theoretische deel van hun paper, UNN-wetenschappers bewezen ook de stelling over uniforme convergentie van het nieuwe algoritme. Het experimentele deel van het werk bestond uit het oplossen van een reeks van honderden testproblemen van verschillende afmetingen, en de resultaten hebben de aanwezigheid van uniforme convergentie overtuigend aangetoond.

Ook UNN-wetenschappers beschouwen rekenintensieve wereldwijde optimalisatieproblemen, voor het oplossen waarvan de supercomputersystemen met exaflops prestaties kunnen worden vereist. Om dergelijke computationele complexiteit te overwinnen, de onderzoekers stellen gegeneraliseerde parallelle rekenschema's voor, waarbij talrijke efficiënte parallelle algoritmen van globale optimalisatie betrokken kunnen zijn. De voorgestelde schema's omvatten methoden voor decompositie op meerdere niveaus van parallelle berekeningen om de rekenefficiëntie te garanderen van supercomputersystemen met multiprocessors met gedeeld en gedistribueerd geheugen die duizenden processors gebruiken om wereldwijde optimalisatie-uitdagingen aan te gaan.

Technologie onthult voorheen niet-detecteerbare eiwitsignaleringsactiviteit bij diabetes, kanker

Technologie onthult voorheen niet-detecteerbare eiwitsignaleringsactiviteit bij diabetes, kanker Galvaniseren Plastic

Galvaniseren Plastic Hoe een Mercury (Hg) -model uit schuimballen te maken

Hoe een Mercury (Hg) -model uit schuimballen te maken  Polymeermembranen kunnen baat hebben bij een duik

Polymeermembranen kunnen baat hebben bij een duik Enzym bleek de vorming van collageendragers te beheersen en de collageenafscheiding te remmen

Enzym bleek de vorming van collageendragers te beheersen en de collageenafscheiding te remmen

Softwaretool kan laten zien wanneer de afvalwaterzuivering van een stad faalt

Softwaretool kan laten zien wanneer de afvalwaterzuivering van een stad faalt NASA kijkt naar regen in het Midwesten en smeltende sneeuw die hebben bijgedragen aan overstromingen

NASA kijkt naar regen in het Midwesten en smeltende sneeuw die hebben bijgedragen aan overstromingen Griekenland racet om het elektriciteitsnet te herstellen nu de koudegolf afneemt

Griekenland racet om het elektriciteitsnet te herstellen nu de koudegolf afneemt Is een ecosysteem groter of kleiner dan een bioom?

Is een ecosysteem groter of kleiner dan een bioom?  Platentektoniek kan de Cambrische explosie hebben veroorzaakt, studie toont

Platentektoniek kan de Cambrische explosie hebben veroorzaakt, studie toont

Hoofdlijnen

- Rollen van celorganellen in mitose

- Wat zijn de kenmerken die alle bacteriën gemeen hebben?

- Intron: definitie, functie en belang bij RNA-splitsing

- Wat is een tetrad in de microbiologie?

- Angiogenese versus vasculogenese

- De adelaars scouten:het bewijs dat het beschermen van nesten de voortplanting bevordert

- 'S Werelds oudste bevroren sperma werkt prima

- Kleine wespenlichamen betekent kleine hersengebieden van wespen, studie toont

- Wat is het laatste nieuws over de darmflora? Concordia-studenten microbiologie publiceren hun bevindingen

- 10 dingen die je niet wist over Einstein

- Wetenschappers vinden meest vogelachtige dinosaurus ooit gevonden

- Archeologen ontdekken vroegste bewijs voor slijtage van paardachtigen in het oude Nabije Oosten

- Zijn sommige culturen minder vertrouwend dan andere?

- Zeevruchten hielpen prehistorische mensen om uit Afrika te migreren, studie onthult

Online studenten nemen meer deel aan colleges dan fysieke deelnemers

Online studenten nemen meer deel aan colleges dan fysieke deelnemers Onderzoekers proberen de evolutie na te bootsen om de beste vorm voor vluchten te ontdekken

Onderzoekers proberen de evolutie na te bootsen om de beste vorm voor vluchten te ontdekken Gebruik in het echte leven van de stelling van Pythagoras

Gebruik in het echte leven van de stelling van Pythagoras  De machtige Banyan-boom kan eeuwenlang lopen en leven

De machtige Banyan-boom kan eeuwenlang lopen en leven  Hoe het verschil tussen een monarch en een onderkoning te onderscheiden Butterfly

Hoe het verschil tussen een monarch en een onderkoning te onderscheiden Butterfly Wat zijn de verschillende soorten kreeften?

Wat zijn de verschillende soorten kreeften?  Subatomair deeltje veranderd in antideeltje en terug

Subatomair deeltje veranderd in antideeltje en terug Een Science Fair Project op tandbederf

Een Science Fair Project op tandbederf

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com