Wetenschap

Machine learning verbetert de lichtbundelprestaties bij de geavanceerde lichtbron

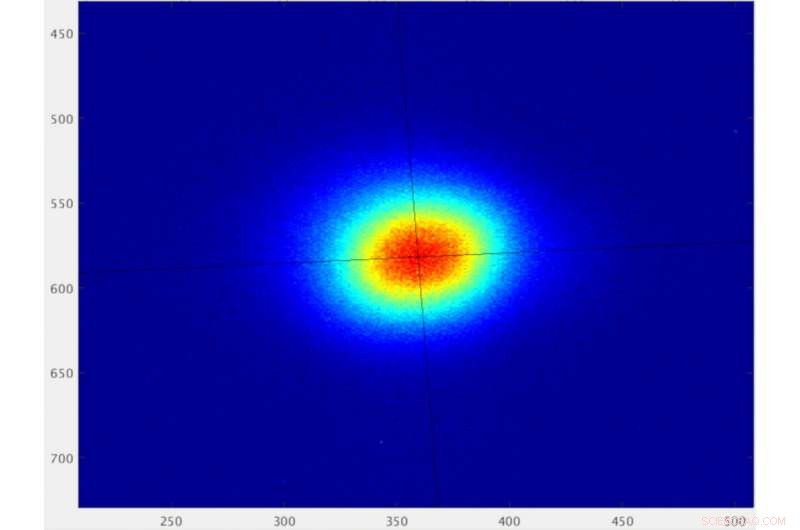

Het profiel van een elektronenbundel bij Berkeley Lab's Advanced Light Source synchrotron, weergegeven als pixels gemeten door een Charged Coupled Device (CCD)-sensor. Wanneer gestabiliseerd door een machine learning-algoritme, de balk heeft een horizontale afmeting van 49 micron wortelgemiddelde in het kwadraat en een verticale afmeting van 48 micron wortelgemiddelde in het kwadraat. Veeleisende experimenten vereisen dat de corresponderende lichtbundelgrootte stabiel is op tijdschalen variërend van minder dan seconden tot uren om betrouwbare gegevens te garanderen. Krediet:Lawrence Berkeley National Laboratory

Synchrotron-lichtbronnen zijn krachtige faciliteiten die licht produceren in verschillende "kleuren, " of golflengten - van infrarood tot röntgenstralen - door elektronen te versnellen om licht uit te zenden in gecontroleerde bundels.

Synchrotrons zoals de geavanceerde lichtbron van het Lawrence Berkeley National Laboratory (Berkeley Lab) van het Department of Energy stellen wetenschappers in staat om met dit licht op verschillende manieren monsters te onderzoeken, op gebieden variërend van materiaalkunde, biologie, en scheikunde tot natuurkunde en milieuwetenschappen.

Onderzoekers hebben manieren gevonden om deze machines te upgraden om intensere, gefocust, en consistente lichtstralen die nieuwe, en meer complexe en gedetailleerde studies over een breed scala aan steekproeftypes.

Maar sommige eigenschappen van de lichtbundel vertonen nog steeds fluctuaties in de prestaties die voor bepaalde experimenten een uitdaging vormen.

Een decennia oud probleem aanpakken

Veel van deze synchrotronfaciliteiten leveren verschillende soorten licht voor tientallen gelijktijdige experimenten. En kleine aanpassingen om de lichtbundeleigenschappen bij deze individuele bundellijnen te verbeteren, kunnen worden teruggevoerd op de algehele lichtbundelprestaties in de hele faciliteit. Synchrotron-ontwerpers en operators worstelen al tientallen jaren met verschillende benaderingen om de meest hardnekkige van deze fluctuaties te compenseren.

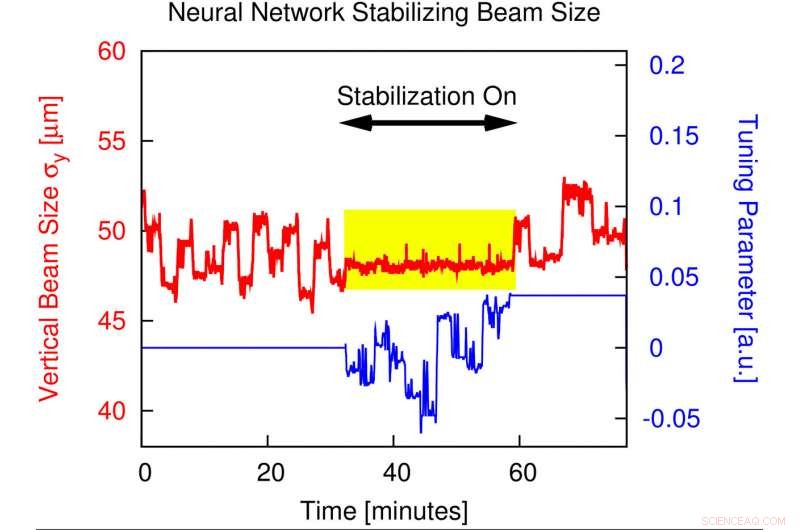

En nu, een groot team van onderzoekers van Berkeley Lab en UC Berkeley heeft met succes aangetoond hoe hulpmiddelen voor machinaal leren de stabiliteit van de lichtbundels voor experimenten kunnen verbeteren via aanpassingen die deze fluctuaties grotendeels opheffen - waardoor ze van een niveau van een paar procent lager worden tot 0,4 procent, met submicron (minder dan 1 miljoenste van een meter) precisie.

De tools worden gedetailleerd beschreven in een studie die op 6 november in het tijdschrift is gepubliceerd Fysieke beoordelingsbrieven .

Machine learning is een vorm van kunstmatige intelligentie waarbij computersystemen een reeks gegevens analyseren om voorspellende programma's te bouwen die complexe problemen oplossen. De machine learning-algoritmen die bij de ALS worden gebruikt, worden een vorm van 'neuraal netwerk' genoemd omdat ze zijn ontworpen om patronen in de gegevens te herkennen op een manier die enigszins lijkt op menselijke hersenfuncties.

In dit onderzoek, onderzoekers voedden elektronenbundelgegevens van de ALS, waaronder de posities van de magnetische apparaten die worden gebruikt om licht uit de elektronenstraal te produceren, in het neurale netwerk. Het neurale netwerk herkende patronen in deze gegevens en identificeerde hoe verschillende apparaatparameters de breedte van de elektronenstraal beïnvloedden. Het machine learning-algoritme adviseerde ook aanpassingen aan de magneten om de elektronenstraal te optimaliseren.

Omdat de grootte van de elektronenstraal de resulterende lichtstraal weerspiegelt die door de magneten wordt geproduceerd, het algoritme optimaliseerde ook de lichtstraal die wordt gebruikt om materiaaleigenschappen bij de ALS te bestuderen.

Oplossing kan wereldwijde impact hebben

De succesvolle demonstratie op de ALS laat zien hoe de techniek ook algemeen toegepast zou kunnen worden op andere lichtbronnen, en zal vooral gunstig zijn voor gespecialiseerde studies die mogelijk worden gemaakt door een upgrade van het ALS dat bekend staat als het ALS-U-project.

"Dat is het mooie hiervan, " zei Hiroshi Nishimura, een aan Berkeley Lab gelieerde onderneming die vorig jaar met pensioen ging en zich bezighield met vroege discussies en verkenningen van een machine-learning-oplossing voor het al lang bestaande probleem van de stabiliteit van de lichtstraal. "Wat het gaspedaal ook is, en wat de conventionele oplossing ook is, deze oplossing kan daar bovenop komen."

Steve Kevan, ALS-directeur, zei, "Dit is een zeer belangrijke vooruitgang voor de ALS en ALS-U. Sinds enkele jaren hebben we problemen met artefacten in de beelden van onze röntgenmicroscopen. Deze studie presenteert een nieuwe feed-forward-benadering op basis van machine learning, en het heeft het probleem grotendeels opgelost."

Het ALS-U-project zal de smalle focus van lichtbundels vergroten van een niveau van ongeveer 100 micron tot minder dan 10 micron en ook een grotere vraag creëren naar consistente, betrouwbare lichtbundeleigenschappen.

De machine learning-techniek bouwt voort op conventionele oplossingen die in de loop van de decennia zijn verbeterd sinds de start van ALS in 1993, en die afhankelijk zijn van constante aanpassingen aan magneten langs de ALS-ring die in realtime compenseren voor aanpassingen aan individuele bundellijnen.

Nishimura, die deel uitmaakten van het team dat de ALS meer dan 25 jaar geleden online bracht, zei dat hij ongeveer vier of vijf jaar geleden de mogelijke toepassing van machine-learningtools voor acceleratortoepassingen begon te bestuderen. Zijn gesprekken strekten zich uit tot experts op het gebied van informatica en versnellers bij Berkeley Lab en bij UC Berkeley, en het concept begon ongeveer twee jaar geleden te geleren.

Deze grafiek laat zien hoe de stabiliteit van de verticale bundelgrootte aanzienlijk verbetert wanneer een neuraal netwerk wordt geïmplementeerd tijdens geavanceerde lichtbronbewerkingen. Wanneer de zogenaamde "feed-forward"-correctie wordt geïmplementeerd, de fluctuaties in de verticale bundelgrootte worden gestabiliseerd tot op het sub-procentniveau (zie geel gemarkeerde sectie) van niveaus die anders oplopen tot enkele procenten. Krediet:Lawrence Berkeley National Laboratory

Succesvol testen tijdens ALS-operaties

Onderzoekers hebben het algoritme eerder dit jaar met succes getest op twee verschillende locaties rond de ALS-ring. Ze waarschuwden ALS-gebruikers die experimenten uitvoerden over het testen van het nieuwe algoritme, en vroeg hen om feedback te geven over onverwachte prestatieproblemen.

"We hebben van april tot juni van dit jaar consistente tests gehad met gebruikersactiviteiten, " zei C. Nathan Melton, een postdoctoraal onderzoeker bij de ALS die in 2018 toetrad tot het machine learning-team en nauw samenwerkte met Shuai Liu, een voormalige UC Berkeley-afgestudeerde student die aanzienlijk heeft bijgedragen aan de inspanning en co-auteur is van de studie.

Simon Leemann, plaatsvervangend voor Accelerator Operations and Development bij de ALS en de hoofdonderzoeker in de machine-learning-inspanning, zei, "We hadden geen negatieve feedback op de tests. Een van de meetbundellijnen die het team gebruikte, is een diagnostische bundellijn die constant de prestaties van de versneller meet, en een andere was een bundellijn waar experimenten actief werden uitgevoerd." Alex Hexemer, een senior wetenschapper bij de ALS en programmaleider voor informatica, diende als co-lead bij de ontwikkeling van de nieuwe tool.

De bundellijn met de actieve experimenten, Stralingslijn 5.3.2.2, maakt gebruik van een techniek die bekend staat als scanning-transmissie-röntgenmicroscopie of STXM, en wetenschappers daar rapporteerden verbeterde lichtstraalprestaties in experimenten.

Het machine-learningteam merkte op dat de verbeterde lichtbundelprestaties ook zeer geschikt zijn voor geavanceerde röntgentechnieken zoals ptychografie, die de structuur van monsters kan oplossen tot op het niveau van nanometers (miljardsten van een meter); en röntgenfotoncorrelatiespectroscopie, of XPCS, wat handig is voor het bestuderen van snelle veranderingen in sterk geconcentreerde materialen die geen uniforme structuur hebben.

Andere experimenten die een betrouwbare, een sterk gerichte lichtstraal van constante intensiteit waar deze in wisselwerking staat met het monster, kan ook profiteren van de verbetering van machine learning, merkte Leemann op.

"De eisen van experimenten worden strenger, met kleinere scans op monsters, " zei hij. "We moeten nieuwe manieren vinden om deze onvolkomenheden te corrigeren."

Hij merkte op dat het kernprobleem waar de lichtbrongemeenschap mee worstelt - en dat de machine-learningtools aanpakken - de fluctuerende verticale elektronenbundelgrootte bij het bronpunt van de bundellijn is.

Het bronpunt is het punt waar de elektronenbundel bij de lichtbron het licht uitzendt dat naar het experiment van een specifieke bundellijn reist. Hoewel de breedte van de elektronenbundel op dit punt van nature stabiel is, de hoogte (of verticale brongrootte) kan fluctueren.

De 'black box' van kunstmatige intelligentie openen

"Dit is een heel mooi voorbeeld van teamwetenschap, "Leeman zei, opmerkend dat de inspanning enige aanvankelijke scepsis over de levensvatbaarheid van machine learning voor het verbeteren van de prestaties van de versneller overwon, en opende de "zwarte doos" van hoe dergelijke tools echte voordelen kunnen opleveren.

"Dit is geen tool die traditioneel deel uitmaakt van de acceleratorgemeenschap. We zijn erin geslaagd mensen uit twee verschillende gemeenschappen samen te brengen om een heel moeilijk probleem op te lossen." Ongeveer 15 Berkeley Lab-onderzoekers namen deel aan de inspanning.

"Machine learning vereist fundamenteel twee dingen:het probleem moet reproduceerbaar zijn, en je hebt enorme hoeveelheden data nodig, "Zei Leemann. "We realiseerden ons dat we al onze gegevens konden gebruiken en dat een algoritme patronen kon herkennen."

De gegevens toonden de kleine blips in de prestaties van de elektronenstraal toen er aanpassingen werden gedaan aan individuele bundellijnen, en het algoritme vond een manier om de elektronenstraal zo af te stemmen dat deze impact beter teniet werd gedaan dan conventionele methoden.

"Het probleem bestaat uit ongeveer 35 parameters - veel te complex voor ons om zelf uit te zoeken, Leemann zei. "Wat het neurale netwerk deed toen het eenmaal was getraind - het gaf ons een voorspelling voor wat er zou gebeuren met de brongrootte in de machine als het helemaal niets zou doen om het te corrigeren.

"Er is een extra parameter in dit model die beschrijft hoe de veranderingen die we aanbrengen in een bepaald type magneet die brongrootte beïnvloeden. Dus alles wat we dan hoeven te doen is de parameter kiezen die - volgens deze voorspelling van het neurale netwerk - resulteert in de straalgrootte die we willen maken en toepassen op de machine, ', voegt Leemann toe.

Het algoritme-gestuurde systeem kan nu correcties maken met een snelheid van maximaal 10 keer per seconde, hoewel drie keer per seconde voldoende lijkt om de prestaties in dit stadium te verbeteren, aldus Leemann.

De zoektocht naar nieuwe toepassingen voor machine learning

Het machine-learningteam ontving in augustus 2018 twee jaar financiering van het Amerikaanse ministerie van Energie om deze en andere machine-learningprojecten voort te zetten in samenwerking met de Stanford Synchrotron Radiation Lightsource bij SLAC National Accelerator Laboratory. "We hebben plannen om dit te blijven ontwikkelen en we hebben ook een aantal nieuwe ideeën voor machine learning die we willen uitproberen, ' zei Leemann.

Nishimura zei dat de modewoorden "kunstmatige intelligentie" al vele jaren in en uit de onderzoeksgemeenschap lijken te zijn gelopen, Hoewel, "Deze keer lijkt het eindelijk iets echts te zijn."

Doorbraak in de organische chemie:asymmetrische syntheses van nuttige, unieke chirale verbindingen

Doorbraak in de organische chemie:asymmetrische syntheses van nuttige, unieke chirale verbindingen Aluminiumrecyclingtechnologie gestimuleerd door kristallisatieonderzoek

Aluminiumrecyclingtechnologie gestimuleerd door kristallisatieonderzoek Ga de piste op met biobased ski's en snowboards

Ga de piste op met biobased ski's en snowboards Hoe alcoholthermometers werken

Hoe alcoholthermometers werken  Een wegwerpbare levende laser geprint op chip voor drugsscreening

Een wegwerpbare levende laser geprint op chip voor drugsscreening

Mosselen en kokkels, schildwachten van de milieutoestand van de Nicaraguaanse kusten

Mosselen en kokkels, schildwachten van de milieutoestand van de Nicaraguaanse kusten Natuurlijke oorzaken zijn de belangrijkste aanjager van verandering in de overstromingspatronen van de Athabasca Delta, uit onderzoek blijkt

Natuurlijke oorzaken zijn de belangrijkste aanjager van verandering in de overstromingspatronen van de Athabasca Delta, uit onderzoek blijkt Een wereldwijde verschuiving van noord naar zuid in windenergie tegen het einde van de eeuw

Een wereldwijde verschuiving van noord naar zuid in windenergie tegen het einde van de eeuw De plastic mythe en de onbegrepen driehoek

De plastic mythe en de onbegrepen driehoek Welk habitattype leven garnalen?

Welk habitattype leven garnalen?

Hoofdlijnen

- Nidovirussen brengen overtollig genen tot expressie en coderen voor meer eiwitten dan eerder werd aangenomen, studie vondsten

- Levenscyclus van Sordaria Fimicola

- Hoe werkt het spierstelsel met de bloedsomloop?

- Poema's die in de buurt van menselijke ontwikkeling leven, verbruiken meer energie

- Onderzoeker koppelt zalmseks aan geologische verandering

- Het opzetten van een genoombrede kaart van bacteriële genen die cruciaal zijn voor de kolonisatie van planten door nuttige microben

- Zich in het volle zicht verbergen - Ontdekking roept vragen op over de schaal van de over het hoofd geziene biodiversiteit

- Onderzoekers ontdekken hoe planten op moleculair niveau reageren op veranderingen in licht

- Vissers in Istanbul houden traditie in stand ondanks voorraadalarm

NASA ziet 14e vorm van tropische depressie in de oostelijke Stille Oceaan

NASA ziet 14e vorm van tropische depressie in de oostelijke Stille Oceaan Europa lekte water de ruimte in,

Europa lekte water de ruimte in,  Jacht op donkere materie wordt verkleind door nieuw onderzoek

Jacht op donkere materie wordt verkleind door nieuw onderzoek In plasmaspiegels turen

In plasmaspiegels turen Hoeveel planeten in ons universum kunnen leven ondersteunen?

Hoeveel planeten in ons universum kunnen leven ondersteunen?  Wetenschappers verkrijgen een hexagonale modificatie van silicium

Wetenschappers verkrijgen een hexagonale modificatie van silicium NASA IMERG onthult regenval van tropische cycloon Berguitta

NASA IMERG onthult regenval van tropische cycloon Berguitta Coronavirus-vrijwilligers:meer tevredenheid dankzij online platforms

Coronavirus-vrijwilligers:meer tevredenheid dankzij online platforms

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com