Wetenschap

AI-systeem maakt beeldgeneratormodellen zoals DALL-E 2 creatiever

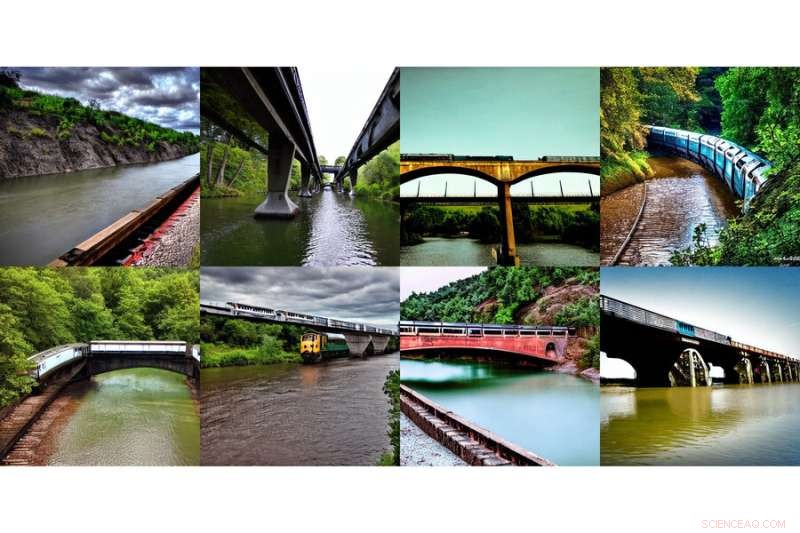

Deze reeks gegenereerde afbeeldingen, die "een trein op een brug" en "een rivier onder de brug" laten zien, is gegenereerd met behulp van een nieuwe methode die is ontwikkeld door MIT-onderzoekers. Credit:Massachusetts Institute of Technology

Het internet had een collectief feelgood-moment met de introductie van DALL-E, een op kunstmatige intelligentie gebaseerde beeldgenerator geïnspireerd door kunstenaar Salvador Dali en de sympathieke robot WALL-E die natuurlijke taal gebruikt om elk mysterieus en mooi beeld te produceren dat je hartje begeert . Het zien van uitgetypte inputs zoals "glimlachende gopher die een ijshoorntje vasthoudt" komt onmiddellijk tot leven en resoneert duidelijk met de wereld.

Het is geen kleine taak om die lachende gopher en attributen op je scherm te laten verschijnen. DALL-E 2 gebruikt iets dat een diffusiemodel wordt genoemd, waarbij het probeert de hele tekst in één beschrijving te coderen om een afbeelding te genereren. Maar zodra de tekst veel meer details bevat, is het moeilijk voor een enkele beschrijving om alles vast te leggen. Bovendien, hoewel ze zeer flexibel zijn, hebben ze soms moeite om de samenstelling van bepaalde concepten te begrijpen, zoals het verwarren van de attributen of relaties tussen verschillende objecten.

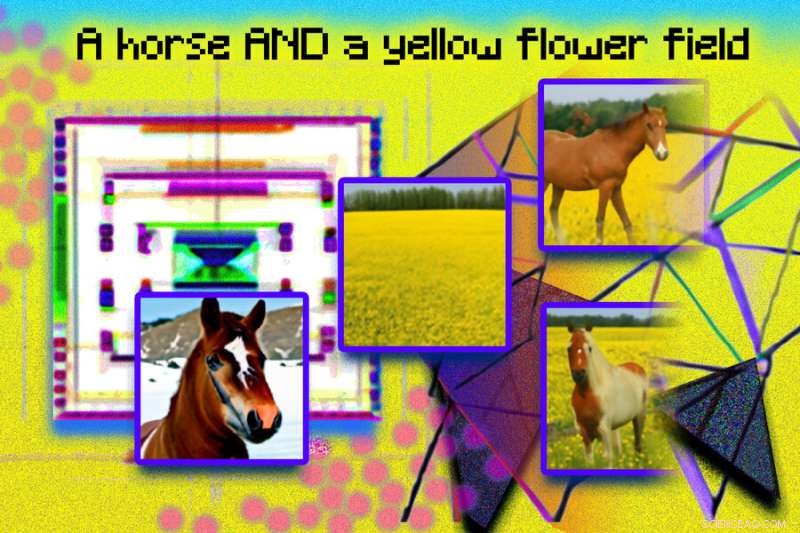

Om complexere afbeeldingen met een beter begrip te genereren, hebben wetenschappers van MIT's Computer Science and Artificial Intelligence Laboratory (CSAIL) het typische model vanuit een andere hoek gestructureerd:ze voegden een reeks modellen samen, waar ze allemaal samenwerken om gewenste afbeeldingen te genereren die meerdere verschillende aspecten vastleggen zoals gevraagd door de invoertekst of labels. Om een afbeelding te maken met twee componenten, bijvoorbeeld beschreven door twee beschrijvingszinnen, zou elk model een bepaalde component van de afbeelding aanpakken.

Deze reeks gegenereerde afbeeldingen, met "een rivier die naar de bergen leidt" en "rode bomen aan de zijkant", is gegenereerd met behulp van een nieuwe methode die is ontwikkeld door MIT-onderzoekers. Krediet:Massachusetts Institute of Technology

De schijnbaar magische modellen achter het genereren van afbeeldingen werken door een reeks iteratieve verfijningsstappen voor te stellen om tot het gewenste beeld te komen. Het begint met een "slecht" beeld en verfijnt het dan geleidelijk totdat het de geselecteerde afbeelding wordt. Door meerdere modellen samen te stellen, verfijnen ze samen het uiterlijk bij elke stap, zodat het resultaat een afbeelding is die alle attributen van elk model vertoont. Door meerdere modellen te laten samenwerken, kun je veel creatievere combinaties krijgen in de gegenereerde afbeeldingen.

Neem bijvoorbeeld een rode vrachtwagen en een groen huis. Het model zal de concepten rode vrachtwagen en groen huis verwarren wanneer deze zinnen erg ingewikkeld worden. Een typische generator zoals DALL-E 2 kan een groene vrachtwagen en een rood huis maken, dus het zal deze kleuren omwisselen. De aanpak van het team kan dit soort binding van attributen met objecten aan, en vooral wanneer er meerdere sets van dingen zijn, kan het elk object nauwkeuriger verwerken.

"Het model kan objectposities en relationele beschrijvingen effectief modelleren, wat een uitdaging is voor bestaande modellen voor het genereren van afbeeldingen. Plaats bijvoorbeeld een object en een kubus in een bepaalde positie en een bol in een andere. DALL-E 2 is goed in het genereren van natuurlijke afbeeldingen, maar heeft soms moeite met het begrijpen van objectrelaties", zegt MIT CSAIL Ph.D. student en co-hoofdauteur Shuang Li:"Naast kunst en creativiteit, kunnen we ons model misschien gebruiken om les te geven. Als je een kind wilt vertellen om een kubus op een bol te plaatsen, en als we dit in taal zeggen, misschien moeilijk te begrijpen voor hen. Maar ons model kan de afbeelding genereren en ze tonen."

Onderzoekers waren in staat om verrassende, surrealistische beelden te creëren met de tekst 'een hond' en 'de lucht'. Aan de linkerkant verschijnen een hond en wolken afzonderlijk, met het label "hond" en "lucht" eronder, en aan de rechterkant verschijnen twee afbeeldingen van wolkachtige honden met het label "hond EN lucht", eronder. Krediet:Massachusetts Institute of Technology

Dali trots maken

Composable Diffusion, het model van het team, gebruikt diffusiemodellen naast compositorische operators om tekstbeschrijvingen te combineren zonder verdere training. De aanpak van het team legt tekstdetails nauwkeuriger vast dan het originele diffusiemodel, dat de woorden rechtstreeks codeert als een enkele lange zin. Bijvoorbeeld, gegeven "een roze lucht" EN "een blauwe berg aan de horizon" EN "kersenbloesems voor de berg", was het model van het team in staat om dat beeld precies te produceren, terwijl het originele diffusiemodel de lucht blauw maakte en alles voor de bergen roze.

"Het feit dat ons model composable is, betekent dat je verschillende delen van het model één voor één kunt leren. Je kunt eerst een object op een ander leren, dan een object rechts van een ander leren, en dan iets links leren. van een ander", zegt co-lead auteur en MIT CSAIL Ph.D. student Yilun Du. "Omdat we deze samen kunnen samenstellen, kun je je voorstellen dat ons systeem ons in staat stelt stapsgewijs taal, relaties of kennis te leren, wat volgens ons een behoorlijk interessante richting is voor toekomstig werk."

Deze foto-illustratie is gemaakt met behulp van gegenereerde afbeeldingen van een MIT-systeem met de naam Composable Diffusion en gerangschikt in Photoshop. Zinnen als "diffusiemodel" en "netwerk" werden gebruikt om de roze stippen en geometrische, hoekige afbeeldingen te genereren. De uitdrukking "een paard EN een geel bloemenveld" staat bovenaan de afbeelding. Gegenereerde afbeeldingen van een paard en een geel veld verschijnen aan de linkerkant en de gecombineerde afbeeldingen van een paard in een geel bloemenveld verschijnen aan de rechterkant. Krediet:Massachusetts Institute of Technology

Hoewel het bedreven was in het genereren van complexe, fotorealistische afbeeldingen, stond het nog steeds voor uitdagingen omdat het model was getraind op een veel kleinere dataset dan die zoals DALL-E 2, dus er waren enkele objecten die het gewoon niet kon vastleggen.

Nu Composable Diffusion kan werken bovenop generatieve modellen, zoals DALL-E 2, willen de wetenschappers continu leren onderzoeken als een mogelijke volgende stap. Aangezien er meestal meer wordt toegevoegd aan objectrelaties, willen ze zien of diffusiemodellen kunnen beginnen met 'leren' zonder eerder geleerde kennis te vergeten - naar een plek waar het model afbeeldingen kan produceren met zowel de eerdere als nieuwe kennis.

"Dit onderzoek stelt een nieuwe methode voor voor het samenstellen van concepten bij het genereren van tekst naar afbeelding, niet door ze samen te voegen tot een prompt, maar eerder door scores met betrekking tot elk concept te berekenen en ze samen te stellen met behulp van conjunctie- en ontkenningsoperatoren", zegt Mark Chen, co-creator van DALL-E 2 en onderzoekswetenschapper bij OpenAI. "Dit is een leuk idee dat gebruikmaakt van de op energie gebaseerde interpretatie van diffusiemodellen, zodat oude ideeën over compositie met behulp van op energie gebaseerde modellen kunnen worden toegepast. De aanpak kan ook gebruik maken van classificatievrije begeleiding, en het is verrassend om zie dat het beter presteert dan de GLIDE-basislijn op verschillende compositiebenchmarks en kwalitatief zeer verschillende soorten beeldgeneraties kan produceren."

"Mensen kunnen op talloze manieren scènes met verschillende elementen samenstellen, maar deze taak is een uitdaging voor computers", zegt Bryan Russel, onderzoekswetenschapper bij Adobe Systems. "Dit werk stelt een elegante formulering voor die expliciet een reeks diffusiemodellen samenstelt om een afbeelding te genereren op basis van een complexe natuurlijke taalprompt." + Verder verkennen

Een revolutie teweegbrengen in het genereren van afbeeldingen via AI:tekst omzetten in afbeeldingen

Dit verhaal is opnieuw gepubliceerd met dank aan MIT News (web.mit.edu/newsoffice/), een populaire site met nieuws over MIT-onderzoek, innovatie en onderwijs.

Onderzoek naar poreuze koolstofvezels een stap dichter bij gebruik in de auto-industrie

Onderzoek naar poreuze koolstofvezels een stap dichter bij gebruik in de auto-industrie Coronavirus test vanuit een koffer

Coronavirus test vanuit een koffer Moleculaire motor:vier rotatietoestanden

Moleculaire motor:vier rotatietoestanden Bestuderen van argongas gevangen in een tweedimensionale reeks kleine kooien

Bestuderen van argongas gevangen in een tweedimensionale reeks kleine kooien Meerlagige fabricage op wafelschaal van micro-elektronica op basis van zijdefibroïne

Meerlagige fabricage op wafelschaal van micro-elektronica op basis van zijdefibroïne

Hoe een poging om het gebruik van fossiele brandstoffen te verminderen tot een ander milieuprobleem leidde:lichtvervuiling

Hoe een poging om het gebruik van fossiele brandstoffen te verminderen tot een ander milieuprobleem leidde:lichtvervuiling Superworm levenscyclus

Superworm levenscyclus  Seismisch apparaat gemaakt voor buitenaards onderzoek kan helpen de klimaatverandering op aarde aan te pakken

Seismisch apparaat gemaakt voor buitenaards onderzoek kan helpen de klimaatverandering op aarde aan te pakken Estuariene steden beschermen tegen stijgende zeespiegel

Estuariene steden beschermen tegen stijgende zeespiegel Ongebruikelijke gletsjerstroom zou de allereerste blik op ijsstroomvorming kunnen zijn

Ongebruikelijke gletsjerstroom zou de allereerste blik op ijsstroomvorming kunnen zijn

Hoofdlijnen

- Verschillen in mannelijke en vrouwelijke chromosomen

- Waarom DNA de meest gunstige molecule is voor genetisch materiaal en hoe RNA zich hiermee verhoudt

- Brandende chili houdt olifanten op afstand, nieuwe studie vondsten

- Onderzoekers vinden mechanisme waarmee plantenwortels zuurstofarme grond vermijden

- Plant Cell Model Ideeën voor kinderen

- Honden likken hun mond om te communiceren met boze mensen

- Wat is het Forer-effect?

- Hoe werkt hennep?

- Fun Biology Presentatie Onderwerpen

- Facebook-zaak over gegevensoverdracht VS gaat naar Europese hoogste rechtbank

- Toekomstige bosbranden:sterkere gebouwen kunnen vertraging oplopen, maar niet stoppen, vernietiging alleen

- Aanwezigheid van gemene robot die de menselijke concentratie verbetert

- Qualcomm schikt sterk verlaagde antitrustboete in Taiwan

- Bombardier om 5 te snijden, 000 banen in herstructurering

Legerwetenschappers geven nieuwe draai aan kwantumonderzoek

Legerwetenschappers geven nieuwe draai aan kwantumonderzoek Welke invloed heeft COVID-19 op de wereldwijde economische orde?

Welke invloed heeft COVID-19 op de wereldwijde economische orde? Ondanks de sociale ontwikkeling, genderattitudes brengen wereldwijd een andere koers in kaart

Ondanks de sociale ontwikkeling, genderattitudes brengen wereldwijd een andere koers in kaart Natuurkundigen melden een manier om donkere materie te horen

Natuurkundigen melden een manier om donkere materie te horen Het belang van het broeikaseffect

Het belang van het broeikaseffect  De hoogte van een driehoek vinden

De hoogte van een driehoek vinden Geduld Bulgaren droogt op door watercrisis

Geduld Bulgaren droogt op door watercrisis Typen elektroden die worden gebruikt bij het lassen

Typen elektroden die worden gebruikt bij het lassen

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com