Wetenschap

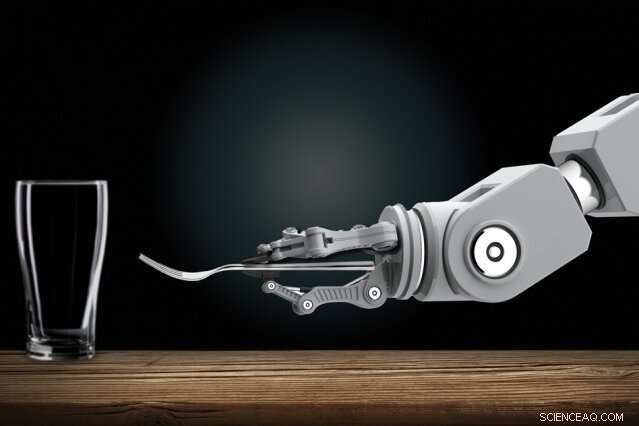

Door mensen te observeren, robots leren complexe taken uit te voeren, zoals het dekken van een tafel

Robotici ontwikkelen geautomatiseerde robots die nieuwe taken alleen kunnen leren door mensen te observeren. Thuis, je zou op een dag een huisrobot kunnen laten zien hoe hij routineklusjes moet doen. Krediet:Christine Daniloff, MIT

Het trainen van interactieve robots kan op een dag een gemakkelijke taak zijn voor iedereen, zelfs degenen zonder programmeerkennis. Robotici ontwikkelen geautomatiseerde robots die nieuwe taken alleen kunnen leren door mensen te observeren. Thuis, je zou op een dag een huisrobot kunnen laten zien hoe hij routineklusjes moet doen. In de werkplaats, je zou robots kunnen opleiden als nieuwe medewerkers, laten zien hoe ze veel taken moeten uitvoeren.

Vooruitgang boeken met die visie, MIT-onderzoekers hebben een systeem ontworpen waarmee dit soort robots gecompliceerde taken kunnen leren die hen anders zouden belemmeren met te veel verwarrende regels. Een van die taken is het dekken van een eettafel onder bepaalde voorwaarden.

In de kern, het "Planning with Uncertain Specifications" (PUnS) -systeem van de onderzoekers geeft robots het menselijke planningsvermogen om tegelijkertijd veel dubbelzinnige - en mogelijk tegenstrijdige - vereisten af te wegen om een einddoel te bereiken. Daarbij, het systeem kiest altijd de meest waarschijnlijke actie om te ondernemen, gebaseerd op een "geloof" over een aantal waarschijnlijke specificaties voor de taak die het zou moeten uitvoeren.

In hun werk, stelden de onderzoekers een dataset samen met informatie over hoe acht objecten - een mok, glas, lepel, vork, mes, diner bord, klein bord, en kom - kan in verschillende configuraties op een tafel worden geplaatst. Een robotarm observeerde voor het eerst willekeurig geselecteerde menselijke demonstraties van het dekken van de tafel met de objecten. Vervolgens, de onderzoekers gaven de arm de opdracht om automatisch een tafel in een specifieke configuratie te plaatsen, in real-world experimenten en in simulatie, op basis van wat het had gezien.

Slagen, de robot moest veel mogelijke plaatsingsopdrachten afwegen, zelfs wanneer items met opzet zijn verwijderd, gestapeld, of verborgen. Normaal gesproken, dat alles zou robots te veel in verwarring brengen. Maar de robot van de onderzoekers maakte geen fouten bij verschillende experimenten in de echte wereld, en slechts een handvol fouten in tienduizenden gesimuleerde testruns.

"De visie is om programmeren in handen te geven van domeinexperts, die robots op intuïtieve manieren kan programmeren, in plaats van orders aan een technicus te beschrijven om aan hun code toe te voegen, " zegt eerste auteur Ankit Shah, een afgestudeerde student in de afdeling Lucht- en ruimtevaart (AeroAstro) en de Interactive Robotics Group, die benadrukt dat hun werk slechts één stap is in het vervullen van die visie. "Op die manier, robots hoeven geen voorgeprogrammeerde taken meer uit te voeren. Fabrieksarbeiders kunnen een robot leren om meerdere complexe montagetaken uit te voeren. Huishoudelijke robots kunnen leren kasten te stapelen, Vul de vaatwasser, of de tafel dekken bij mensen thuis."

Deelnemen aan Shah op het papier zijn AeroAstro en Interactive Robotics Group afgestudeerde student Shen Li en Interactive Robotics Group leider Julie Shah, een universitair hoofddocent in AeroAstro en het Computer Science and Artificial Intelligence Laboratory.

Bots hedging weddenschappen

Robots zijn fijne planners in taken met duidelijke "specificaties, " die helpen bij het beschrijven van de taak die de robot moet vervullen, gezien zijn acties, omgeving, en einddoel. Een tafel leren dekken door demonstraties te observeren, staat vol met onzekere specificaties. Items moeten op bepaalde plaatsen worden geplaatst, afhankelijk van het menu en waar de gasten zitten, en in bepaalde bestellingen, afhankelijk van de onmiddellijke beschikbaarheid van een item of sociale conventies. De huidige benaderingen van planning zijn niet in staat om te gaan met dergelijke onzekere specificaties.

Een populaire benadering van planning is "reinforcement learning, " een trial-and-error machine learning-techniek die hen beloont en bestraft voor acties terwijl ze werken om een taak te voltooien. Maar voor taken met onzekere specificaties, het is moeilijk om duidelijke beloningen en straffen te definiëren. Kortom, robots leren nooit helemaal goed van kwaad.

Het systeem van de onderzoekers, genaamd PUnS (voor planning met onzekere specificaties), stelt een robot in staat om een "geloof" te hebben over een reeks mogelijke specificaties. Het geloof zelf kan dan worden gebruikt om beloningen en straffen uit te delen. "De robot dekt in wezen zijn weddenschappen af in termen van wat bedoeld is in een taak, en onderneemt acties die zijn overtuiging bevredigen, in plaats van dat wij het een duidelijke specificatie geven, ' zegt Ankit Sjah.

Het systeem is gebouwd op "lineaire temporale logica" (LTL), een expressieve taal die robotisch redeneren over huidige en toekomstige resultaten mogelijk maakt. De onderzoekers definieerden sjablonen in LTL die verschillende op tijd gebaseerde omstandigheden modelleren, zoals wat er nu moet gebeuren, moet uiteindelijk gebeuren, en moet gebeuren totdat er iets anders gebeurt. De observaties van de robot van 30 menselijke demonstraties voor het dekken van de tafel leverden een kansverdeling op over 25 verschillende LTL-formules. Elke formule codeerde een iets andere voorkeur of specificatie voor het instellen van de tafel. Die kansverdeling wordt zijn geloof.

"Elke formule codeert iets anders, maar wanneer de robot verschillende combinaties van alle sjablonen overweegt, en probeert alles samen te bevredigen, uiteindelijk doet het uiteindelijk het juiste, ' zegt Ankit Sjah.

Volgende criteria

De onderzoekers ontwikkelden ook verschillende criteria die de robot begeleiden om aan het volledige geloof over die kandidaat-formules te voldoen. Een, bijvoorbeeld, voldoet aan de meest waarschijnlijke formule, die al het andere weggooit, behalve de sjabloon met de grootste waarschijnlijkheid. Anderen voldoen aan het grootste aantal unieke formules, zonder rekening te houden met hun algehele waarschijnlijkheid, of ze voldoen aan verschillende formules die de hoogste totale waarschijnlijkheid vertegenwoordigen. Een andere minimaliseert eenvoudig de fout, dus het systeem negeert formules met een hoge faalkans.

Ontwerpers kunnen een van de vier criteria kiezen om vooraf in te stellen voordat ze gaan trainen en testen. Elk heeft zijn eigen afweging tussen flexibiliteit en risicoaversie. De keuze van de criteria hangt volledig af van de taak. In veiligheidskritieke situaties, bijvoorbeeld, een ontwerper kan ervoor kiezen om de kans op falen te beperken. Maar waar de gevolgen van falen niet zo ernstig zijn, ontwerpers kunnen ervoor kiezen om robots meer flexibiliteit te geven om verschillende benaderingen uit te proberen.

Met de criteria die er zijn, the researchers developed an algorithm to convert the robot's belief—the probability distribution pointing to the desired formula—into an equivalent reinforcement learning problem. This model will ping the robot with a reward or penalty for an action it takes, based on the specification it's decided to follow.

In simulations asking the robot to set the table in different configurations, it only made six mistakes out of 20, 000 tries. In real-world demonstrations, it showed behavior similar to how a human would perform the task. If an item wasn't initially visible, bijvoorbeeld, the robot would finish setting the rest of the table without the item. Vervolgens, when the fork was revealed, it would set the fork in the proper place. "That's where flexibility is very important, " Shah says. "Otherwise it would get stuck when it expects to place a fork and not finish the rest of table setup."

Volgende, the researchers hope to modify the system to help robots change their behavior based on verbal instructions, corrections, or a user's assessment of the robot's performance. "Say a person demonstrates to a robot how to set a table at only one spot. The person may say, 'do the same thing for all other spots, ' or, 'place the knife before the fork here instead, '" Shah says. "We want to develop methods for the system to naturally adapt to handle those verbal commands, without needing additional demonstrations."

Dit verhaal is opnieuw gepubliceerd met dank aan MIT News (web.mit.edu/newsoffice/), een populaire site met nieuws over MIT-onderzoek, innovatie en onderwijs.

Voordelen van het gebruik van een pH-meter

Voordelen van het gebruik van een pH-meter  Wat zijn de grondstoffen van plastic flessen?

Wat zijn de grondstoffen van plastic flessen?  Hoe smelt- en kookpunten te berekenen met behulp van Molality

Hoe smelt- en kookpunten te berekenen met behulp van Molality  Elektronendeficiëntie van fluorforen beïnvloedt de herkenningsprestaties van nabij-infrarood fluorescerende sondes

Elektronendeficiëntie van fluorforen beïnvloedt de herkenningsprestaties van nabij-infrarood fluorescerende sondes Microfluidics helpt ingenieurs om virale infectie in realtime te bekijken

Microfluidics helpt ingenieurs om virale infectie in realtime te bekijken

Michigan winters, zoals generaties ze hebben gekend, komt misschien een einde

Michigan winters, zoals generaties ze hebben gekend, komt misschien een einde Amazonebranden versnellen het smelten van de Andes-gletsjer

Amazonebranden versnellen het smelten van de Andes-gletsjer Nieuwe dieptekaart van de Noordelijke IJszee

Nieuwe dieptekaart van de Noordelijke IJszee De uitstoot van China overtreft nu alle ontwikkelde werelden samen

De uitstoot van China overtreft nu alle ontwikkelde werelden samen Dodelijke instorting van de dam in Brazilië roept angst op voor milieuproblemen

Dodelijke instorting van de dam in Brazilië roept angst op voor milieuproblemen

Hoofdlijnen

- Hersenonderzoek onthult hoe insecten de weg naar huis vinden

- Welke soorten cellen delen door mitose en cytokinese?

- Beperkingen Enzymen die worden gebruikt in DNA-vingerafdrukken

- Kan eten mensen gelukkig maken?

- De controverse over de menselijke hersenen die nieuwe cellen maken

- Sneeuwuilaantallen veel lager dan ooit gedacht

- Leven gelukkige mensen langer?

- Vier hoofdgroepen organische verbindingen waaruit levende organismen bestaan

- Community (ecologie): definitie, structuur, theorie en voorbeelden

SAfricas Naspers gaat internetactiva in Europa vermelden

SAfricas Naspers gaat internetactiva in Europa vermelden Video:Petrichor, de geur van regen

Video:Petrichor, de geur van regen Griekenland geconfronteerd met ecologische ramp door woedende bosbranden

Griekenland geconfronteerd met ecologische ramp door woedende bosbranden NASA-lasercommunicatie om Orion snellere verbindingen te bieden

NASA-lasercommunicatie om Orion snellere verbindingen te bieden Broadcom-aandeelhouders keuren plan om terug te keren naar de VS goed

Broadcom-aandeelhouders keuren plan om terug te keren naar de VS goed Hoe luchtwarmtebeelden een revolutie teweegbrengen in de archeologie

Hoe luchtwarmtebeelden een revolutie teweegbrengen in de archeologie Quasi-periodieke onderdompeling gedetecteerd in een ultralichtgevende röntgenbron

Quasi-periodieke onderdompeling gedetecteerd in een ultralichtgevende röntgenbron Richard Bransons vlucht wekt nieuw optimisme op in New Mexico

Richard Bransons vlucht wekt nieuw optimisme op in New Mexico

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | German | Dutch | Danish | Swedish | Norway |

-

Wetenschap © https://nl.scienceaq.com