Wetenschap

Autonome voertuigen kunnen voor de gek gehouden worden om niet-bestaande obstakels te zien

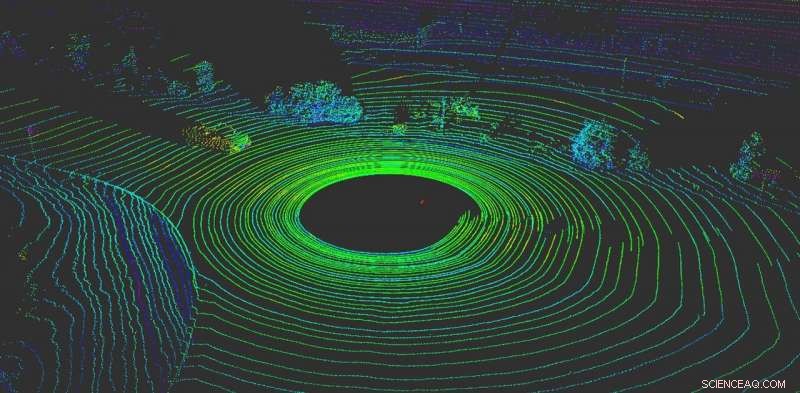

LiDAR helpt een autonoom voertuig 'visualiseren' wat er omheen is. Credit:Yulong Can met gegevens van Baidu Apollo, CC BY-ND

Niets is belangrijker voor een autonoom voertuig dan te voelen wat er omheen gebeurt. Net als menselijke chauffeurs, autonome voertuigen hebben het vermogen nodig om onmiddellijke beslissingen te nemen.

Vandaag, de meeste autonome voertuigen vertrouwen op meerdere sensoren om de wereld waar te nemen. De meeste systemen gebruiken een combinatie van camera's, radarsensoren en LiDAR-sensoren (lichtdetectie en -bereik). Aan boord, computers fuseren deze gegevens om een uitgebreid beeld te krijgen van wat er rondom de auto gebeurt. Zonder deze gegevens, autonome voertuigen zouden geen hoop hebben om veilig door de wereld te navigeren. Auto's die meerdere sensorsystemen gebruiken, werken zowel beter als veiliger - elk systeem kan de andere controleren - maar geen enkel systeem is immuun voor aanvallen.

Helaas, deze systemen zijn niet onfeilbaar. Op camera's gebaseerde waarnemingssystemen kunnen eenvoudig worden misleid door stickers op verkeersborden te plakken om hun betekenis volledig te veranderen.

Ons werk, van de RobustNet Research Group aan de Universiteit van Michigan, heeft aangetoond dat het op LiDAR gebaseerde waarnemingssysteem kan bestaan uit, te. Door de LiDAR-sensorsignalen strategisch te vervalsen, de aanval is in staat om het op LiDAR gebaseerde waarnemingssysteem van het voertuig voor de gek te houden door een niet-bestaand obstakel te "zien". Als dit gebeurt, een voertuig kan een ongeval veroorzaken door het verkeer te blokkeren of abrupt te remmen.

Spoofing van LiDAR-signalen

Op LiDAR gebaseerde waarnemingssystemen hebben twee componenten:de sensor en het machine learning-model dat de gegevens van de sensor verwerkt. Een LiDAR-sensor berekent de afstand tussen zichzelf en zijn omgeving door een lichtsignaal uit te zenden en te meten hoe lang het duurt voordat dat signaal van een object weerkaatst en terugkeert naar de sensor. Deze duur van dit heen en weer wordt ook wel de 'vluchttijd' genoemd.

Een LiDAR-unit zendt tienduizenden lichtsignalen per seconde uit. Vervolgens gebruikt het machine learning-model de geretourneerde pulsen om een beeld te schetsen van de wereld rond het voertuig. Het is vergelijkbaar met hoe een vleermuis echolocatie gebruikt om te weten waar obstakels zich 's nachts bevinden.

Het probleem is dat deze pulsen kunnen worden vervalst. Om de sensor voor de gek te houden, een aanvaller kan zijn of haar eigen lichtsignaal op de sensor schijnen. Dat is alles wat je nodig hebt om de sensor door elkaar te halen.

Echter, het is moeilijker om de LiDAR-sensor te vervalsen om een "voertuig" te "zien" dat er niet is. Slagen, de aanvaller moet de signalen die op de LiDAR van het slachtoffer zijn geschoten nauwkeurig timen. Dit moet gebeuren op nanoseconde niveau, omdat de signalen met de snelheid van het licht reizen. Kleine verschillen zullen opvallen wanneer de LiDAR de afstand berekent aan de hand van de gemeten vliegtijd.

Als een aanvaller de LiDAR-sensor voor de gek houdt, het moet dan ook het machine learning-model voor de gek houden. Uit het werk in het onderzoekslaboratorium van OpenAI blijkt dat modellen voor machine learning kwetsbaar zijn voor speciaal vervaardigde signalen of inputs, wat bekend staat als voorbeelden van tegenstanders. Bijvoorbeeld, speciaal gegenereerde stickers op verkeersborden kunnen cameragebaseerde waarneming voor de gek houden.

We ontdekten dat een aanvaller een vergelijkbare techniek zou kunnen gebruiken om verstoringen te creëren die tegen LiDAR werken. Ze zouden geen zichtbare sticker zijn, maar vervalste signalen die speciaal zijn gemaakt om het machine learning-model voor de gek te houden door te denken dat er obstakels zijn, terwijl die er in feite niet zijn. De LiDAR-sensor stuurt de nepsignalen van de hacker naar het machine learning-model, die ze als een obstakel zal herkennen.

Het vijandige voorbeeld - het nepobject - zou kunnen worden gemaakt om te voldoen aan de verwachtingen van het machine learning-model. Bijvoorbeeld, de aanvaller kan het signaal geven van een vrachtwagen die niet rijdt. Vervolgens, om de aanval uit te voeren, ze kunnen het op een kruispunt plaatsen of op een voertuig plaatsen dat voor een autonoom voertuig rijdt.

Twee mogelijke aanvallen

Om de ontworpen aanval te demonstreren, we kozen voor een autonoom rijsysteem dat door veel autofabrikanten wordt gebruikt:Baidu Apollo. Dit product heeft meer dan 100 partners en heeft een massaproductieovereenkomst bereikt met meerdere fabrikanten, waaronder Volvo en Ford.

Door gebruik te maken van sensorgegevens uit de echte wereld die zijn verzameld door het Baidu Apollo-team, we hebben twee verschillende aanvallen gedemonstreerd. In de eerste, een "noodremaanval, " we hebben laten zien hoe een aanvaller een bewegend voertuig plotseling kan stoppen door het te laten denken dat er een obstakel op zijn pad verscheen. In de tweede, een "AV-bevriezingsaanval, "We gebruikten een vervalst obstakel om een voertuig dat voor een rood stoplicht was gestopt voor de gek te houden om gestopt te blijven nadat het licht groen werd.

Door gebruik te maken van de kwetsbaarheden van waarnemingssystemen voor autonoom rijden, we hopen een alarm te activeren voor teams die autonome technologieën bouwen. Onderzoek naar nieuwe soorten beveiligingsproblemen in de autonome rijsystemen is nog maar net begonnen, en we hopen meer mogelijke problemen aan het licht te brengen voordat ze op straat kunnen worden uitgebuit door slechte actoren.

Dit artikel is opnieuw gepubliceerd vanuit The Conversation onder een Creative Commons-licentie. Lees het originele artikel.

Lego-achtige chemische bouwstenen die zichzelf assembleren tot katalysator voor waterstofbrandstofcellen

Lego-achtige chemische bouwstenen die zichzelf assembleren tot katalysator voor waterstofbrandstofcellen Nieuwe methode gebruikt fluorescentie om ziekteverwekkende vormen van eiwitten te identificeren

Nieuwe methode gebruikt fluorescentie om ziekteverwekkende vormen van eiwitten te identificeren Chemici synthetiseren een nieuwe katalysator voor olie- en gasverwerking

Chemici synthetiseren een nieuwe katalysator voor olie- en gasverwerking Onderzoekers gebruiken machine learning-techniek om nieuwe overgangsmetaalverbindingen snel te evalueren

Onderzoekers gebruiken machine learning-techniek om nieuwe overgangsmetaalverbindingen snel te evalueren Chemische agentia met vertrouwen detecteren

Chemische agentia met vertrouwen detecteren

Wanhopige Grieken vluchten als branden het eiland Evia verwoesten

Wanhopige Grieken vluchten als branden het eiland Evia verwoesten Hier is wat Youd echt ziet als je de Noordpool bezoekt

Hier is wat Youd echt ziet als je de Noordpool bezoekt Computerprogramma ontworpen om de economische impact van bosbranden te berekenen

Computerprogramma ontworpen om de economische impact van bosbranden te berekenen Studie:Opwarmende toekomst betekent meer vuur, minder bomen in hotspot voor westerse biodiversiteit

Studie:Opwarmende toekomst betekent meer vuur, minder bomen in hotspot voor westerse biodiversiteit Provincie Indonesië roept noodtoestand uit vanwege risico op bosbrand

Provincie Indonesië roept noodtoestand uit vanwege risico op bosbrand

Hoofdlijnen

- Er is een gemakkelijke manier om mitose en meiose te begrijpen

- Hinderlaag in een petrischaal

- Wat hebben alle levende organismen gemeen?

- Infectieziekten:CTRL + ALT + Delete

- Hoe maak je een Bacterial Flowchart

- Hoe een utility-functie af te leiden

- De voordelen en nadelen van het Bacillus-expressiesysteem

- Paarden kunnen onze lichaamstaal lezen, zelfs als ze ons niet kennen

- Hoe de bacteriegroei in petrischalen te meten

- Goldman Sachs CEO zegt geen gendervooroordelen in Apple Card

- Nieuwe records in perovskiet-silicium tandemzonnecellen door verbeterd lichtbeheer

- Eerste vlucht Boeings 777X gepland voor donderdag:bronnen

- Aantal passagiers Europese luchthaven bereikt 2,34 miljard:ACI

- Siemens-baas hekelt EU over spoorfusie Alstom

Luchtmacht, SpaceX-moeder over torenhoge raketkosten

Luchtmacht, SpaceX-moeder over torenhoge raketkosten Delen van een dierencel voor kinderen

Delen van een dierencel voor kinderen Amerikaanse FAA:Boeing moet nieuwe kwestie op 737 MAX aanpakken

Amerikaanse FAA:Boeing moet nieuwe kwestie op 737 MAX aanpakken Hoe maak je een beter waterfilter? Keer het binnenstebuiten

Hoe maak je een beter waterfilter? Keer het binnenstebuiten AI-tool onthult automatisch hoe je apps schrijft die minder batterij verbruiken

AI-tool onthult automatisch hoe je apps schrijft die minder batterij verbruiken Boornitride-nanofilms zullen antibiotica vervangen voor bescherming tegen bacteriële en schimmelinfecties

Boornitride-nanofilms zullen antibiotica vervangen voor bescherming tegen bacteriële en schimmelinfecties Hoe bouw je een onderwatertunnel?

Hoe bouw je een onderwatertunnel?  Hoe beïnvloeden zuren en basen groene planten?

Hoe beïnvloeden zuren en basen groene planten?

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Swedish | German | Dutch | Danish | Norway | Portuguese |

-

Wetenschap © https://nl.scienceaq.com