Wetenschap

Deze dataset voor objectherkenning heeft 's werelds beste computervisiemodellen overrompeld

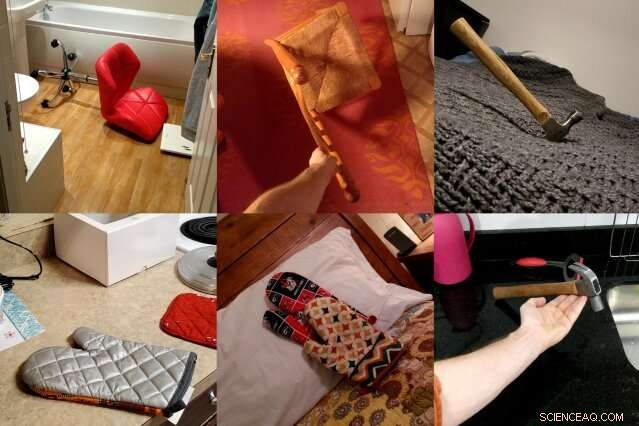

ObjectNet, een dataset van foto's gemaakt door MIT- en IBM-onderzoekers, toont objecten vanuit vreemde hoeken, in meerdere richtingen, en tegen verschillende achtergronden om de complexiteit van 3D-objecten beter weer te geven. De onderzoekers hopen dat de dataset zal leiden tot nieuwe computervisietechnieken die in het echte leven beter presteren. Krediet:Massachusetts Institute of Technology

Computervisiemodellen hebben geleerd om objecten op foto's zo nauwkeurig te identificeren dat sommige op sommige datasets beter kunnen presteren dan mensen. Maar als diezelfde objectdetectoren in de echte wereld worden losgelaten, hun prestaties nemen merkbaar af, het creëren van betrouwbaarheidsproblemen voor zelfrijdende auto's en andere veiligheidskritieke systemen die machinevisie gebruiken.

In een poging om deze prestatiekloof te dichten, een team van MIT- en IBM-onderzoekers ging op zoek naar een heel ander soort objectherkenningsdataset. Het heet ObjectNet, een toneelstuk op ImageNet, de crowdsourced-database met foto's die verantwoordelijk is voor het lanceren van een groot deel van de moderne hausse in kunstmatige intelligentie.

In tegenstelling tot ImageNet, met foto's van Flickr en andere sociale-mediasites, ObjectNet bevat foto's die zijn gemaakt door betaalde freelancers. Objecten worden op hun kant gekanteld weergegeven, onder vreemde hoeken geschoten, en weergegeven in met rommel bezaaide kamers. Toen toonaangevende objectdetectiemodellen werden getest op ObjectNet, hun nauwkeurigheidspercentages daalden van 97 procent op ImageNet tot slechts 50-55 procent.

"We hebben deze dataset gemaakt om mensen te vertellen dat het probleem van objectherkenning een moeilijk probleem blijft, " zegt Boris Katz, een onderzoekswetenschapper bij MIT's Computer Science and Artificial Intelligence Laboratory (CSAIL) en Centre for Brains, Geesten en machines (CBMM). "We hebben betere, slimmere algoritmen." Katz en zijn collega's zullen ObjectNet en hun resultaten presenteren op de Conference on Neural Information Processing Systems (NeurIPS).

Diep leren, de techniek die een groot deel van de recente vooruitgang in AI aanstuurt, gebruikt lagen kunstmatige "neuronen" om patronen te vinden in enorme hoeveelheden ruwe data. Het leert uitkiezen, zeggen, de stoel op een foto na training op honderden tot duizenden voorbeelden. Maar zelfs datasets met miljoenen afbeeldingen kunnen niet elk object in al zijn mogelijke oriëntaties en instellingen weergeven. problemen creëren wanneer de modellen deze objecten in het echte leven tegenkomen.

ObjectNet verschilt op een andere belangrijke manier van conventionele afbeeldingsdatasets:het bevat geen trainingsafbeeldingen. De meeste datasets zijn onderverdeeld in data voor het trainen van de modellen en het testen van hun prestaties. Maar de trainingsset vertoont vaak subtiele overeenkomsten met de testset, in feite geven de modellen een voorproefje bij de test.

Op het eerste gezicht, ImageNet, met 14 miljoen afbeeldingen, lijkt enorm. Maar wanneer zijn trainingsset wordt uitgesloten, het is qua grootte vergelijkbaar met ObjectNet, op 50, 000 foto's.

"Als we willen weten hoe goed algoritmen zullen presteren in de echte wereld, we zouden ze moeten testen op beelden die onbevooroordeeld zijn en die ze nog nooit eerder hebben gezien, " zegt co-auteur Andrei Barbu, een onderzoeker bij CSAIL en CBMM.

Een dataset die probeert de complexiteit van objecten uit de echte wereld vast te leggen

Weinig mensen zouden eraan denken om de foto's van ObjectNet met hun vrienden te delen, en dat is het punt. De onderzoekers huurden freelancers van Amazon Mechanical Turk in om foto's te maken van honderden willekeurig geposeerde huishoudelijke voorwerpen. Werknemers kregen foto-opdrachten op een app, met geanimeerde instructies die hen vertellen hoe ze het toegewezen object moeten oriënteren, vanuit welke hoek je moet fotograferen, en of het object in de keuken moet worden geplaatst, badkamer, slaapkamer, of woonkamer.

Ze wilden drie veelvoorkomende vooroordelen elimineren:objecten die frontaal worden getoond, in iconische posities, en in sterk gecorreleerde omgevingen, bijvoorbeeld borden gestapeld in de keuken.

Het duurde drie jaar om de dataset te bedenken en een app te ontwerpen die het gegevensverzamelingsproces zou standaardiseren. "Ontdekken hoe gegevens te verzamelen op een manier die verschillende vooroordelen controleert, was ongelooflijk lastig, " zegt co-auteur David Mayo, een afgestudeerde student aan het MIT's Department of Electrical Engineering and Computer Science. "We moesten ook experimenten uitvoeren om ervoor te zorgen dat onze instructies duidelijk waren en dat de arbeiders precies wisten wat er van hen werd gevraagd."

Het vergde nog een jaar om de feitelijke gegevens te verzamelen, en op het einde, de helft van alle ingezonden foto's van freelancers moest worden weggegooid omdat ze niet aan de specificaties van de onderzoekers voldeden. In een poging behulpzaam te zijn, sommige arbeiders voegden labels toe aan hun objecten, zette ze op een witte achtergrond, of anderszins probeerden de esthetiek te verbeteren van de foto's die ze moesten maken.

Veel van de foto's zijn buiten de Verenigde Staten genomen, en daarom, sommige objecten kunnen er onbekend uitzien. Rijpe sinaasappels zijn groen, bananen zijn er in verschillende maten, en kleding verschijnt in verschillende vormen en texturen.

Object Net vs. ImageNet:hoe toonaangevende modellen voor objectherkenning zich verhouden

Toen de onderzoekers state-of-the-art computer vision-modellen testten op ObjectNet, ze vonden een prestatiedaling van 40-45 procentpunten van ImageNet. De resultaten laten zien dat objectdetectoren nog steeds moeite hebben om te begrijpen dat objecten driedimensionaal zijn en kunnen worden geroteerd en verplaatst naar nieuwe contexten. zeggen de onderzoekers. "Deze begrippen zijn niet ingebouwd in de architectuur van moderne objectdetectoren, " zegt co-auteur van de studie Dan Gutfreund, een onderzoeker bij IBM.

Om aan te tonen dat ObjectNet moeilijk is juist vanwege de manier waarop objecten worden bekeken en gepositioneerd, de onderzoekers lieten de modellen trainen op de helft van de ObjectNet-gegevens voordat ze op de resterende helft werden getest. Training en testen op dezelfde dataset verbeteren doorgaans de prestaties, maar hier verbeterden de modellen slechts licht, wat suggereert dat objectdetectoren nog niet volledig begrijpen hoe objecten in de echte wereld bestaan.

Computervisiemodellen zijn sinds 2012 geleidelijk verbeterd toen een objectdetector genaamd AlexNet de concurrentie verpletterde tijdens de jaarlijkse ImageNet-wedstrijd. Naarmate de datasets groter zijn geworden, de prestaties zijn ook verbeterd.

Maar het ontwerpen van grotere versies van ObjectNet, met zijn toegevoegde kijkhoeken en oriëntaties, leidt niet noodzakelijk tot betere resultaten, waarschuwen de onderzoekers. Het doel van ObjectNet is om onderzoekers te motiveren om met de volgende golf van revolutionaire technieken te komen, net als bij de eerste lancering van de ImageNet-uitdaging.

"Mensen voeden deze detectoren enorme hoeveelheden data, maar er zijn afnemende opbrengsten, " zegt Katz. "Je kunt een object niet vanuit elke hoek en in elke context bekijken. We hopen dat deze nieuwe dataset zal resulteren in een robuuste computervisie zonder verrassende storingen in de echte wereld."

Dit verhaal is opnieuw gepubliceerd met dank aan MIT News (web.mit.edu/newsoffice/), een populaire site met nieuws over MIT-onderzoek, innovatie en onderwijs.

Het fenomeen van polymorfisme in de atomaire structuur van het methylprednisolonaceponaat

Het fenomeen van polymorfisme in de atomaire structuur van het methylprednisolonaceponaat Supersmering op microschaal zou de weg kunnen effenen voor toekomstige verbeterde elektromechanische apparaten

Supersmering op microschaal zou de weg kunnen effenen voor toekomstige verbeterde elektromechanische apparaten Hoe kaliumchloride bereiden

Hoe kaliumchloride bereiden  NRL pigmentpakket voor schepen vertraagt verkleuring, verlaagt de belasting van de zonnetemperatuur

NRL pigmentpakket voor schepen vertraagt verkleuring, verlaagt de belasting van de zonnetemperatuur Volledig inkjet-geprinte op vanadiumdioxide gebaseerde radiofrequentieschakelaars voor flexibele herconfigureerbare componenten

Volledig inkjet-geprinte op vanadiumdioxide gebaseerde radiofrequentieschakelaars voor flexibele herconfigureerbare componenten

Vijfjarige periode eindigend in 2019 wordt de heetste ooit

Vijfjarige periode eindigend in 2019 wordt de heetste ooit Van de diepe mantel van de aarde, wetenschappers vinden een nieuwe manier waarop vulkanen ontstaan

Van de diepe mantel van de aarde, wetenschappers vinden een nieuwe manier waarop vulkanen ontstaan Nieuwe studie toont voordelen van ondergewaardeerde kwelder aan

Nieuwe studie toont voordelen van ondergewaardeerde kwelder aan Black Saturday-bosbranden:hebben we een gebrekkig systeem gerepareerd?

Black Saturday-bosbranden:hebben we een gebrekkig systeem gerepareerd? Wetenschappers onthullen nieuwe aanwijzingen over hoe de aarde aan zuurstof kwam

Wetenschappers onthullen nieuwe aanwijzingen over hoe de aarde aan zuurstof kwam

Hoofdlijnen

- Profase: wat gebeurt er in dit stadium van mitose en meiose?

- Wat gebeurt er nadat u een wortel in zout water hebt gestopt?

- Relatie tussen celstructuur en functie

- Nieuwe intermoleculaire oppervlaktekracht onthult actomyosine-aandrijfmechanisme

- Geheugenhack:doe wat aerobics vier uur na de les

- Hoeveel calorieën verbrand ik als ik lach?

- Een gemakkelijke manier om het skelet te onthouden

- Neanderthaler DNA veranderde de manier waarop moderne mensen eruitzien

- Your Body On: A Horror Movie

- Pew-studie:kunstmatige intelligentie zal ons tegen 2030 grotendeels beter maken, maar de angst blijft

- Duits prijsplatform klaagt Google aan wegens zoekresultaten

- Apple biedt 2,5 miljard dollar om de huisvestingscrisis in Californië aan te pakken

- Wat is er allemaal zo moeilijk aan 5G?

- Rusland beboet Twitter, Facebook voor het bewaren van gegevens in het buitenland

Holle atomen:de gevolgen van een onderschat effect

Holle atomen:de gevolgen van een onderschat effect Waterstofionen gebruiken om magnetisme op moleculaire schaal te manipuleren

Waterstofionen gebruiken om magnetisme op moleculaire schaal te manipuleren Martian CSI onthult hoe asteroïde-inslagen stromend water creëerden onder de rode planeet

Martian CSI onthult hoe asteroïde-inslagen stromend water creëerden onder de rode planeet Video:Hoe zal klimaatverandering de opvang beïnvloeden?

Video:Hoe zal klimaatverandering de opvang beïnvloeden? Wat zijn de tijden voor kolibries in Kansas?

Wat zijn de tijden voor kolibries in Kansas?  Eerste beeldvorming van vrije nanodeeltjes in laboratoriumexperiment met behulp van een laserbron met hoge intensiteit

Eerste beeldvorming van vrije nanodeeltjes in laboratoriumexperiment met behulp van een laserbron met hoge intensiteit Transparantie toevoegen aan grafeenpapier verbetert de capaciteit van de supercondensator

Transparantie toevoegen aan grafeenpapier verbetert de capaciteit van de supercondensator Volgende stap naar een zwaartekrachtsgolfobservatorium in de ruimte

Volgende stap naar een zwaartekrachtsgolfobservatorium in de ruimte

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com