Wetenschap

Slimme machines beschermen tegen slimme aanvallen

Het bord is gewijzigd om de betekenis te veranderen in systemen die afhankelijk zijn van computervisie van "Stop" in "Wegwerkzaamheden vooruit". Krediet:David Kelly Crow

Het vermogen van machines om te leren door gegevens te verwerken die afkomstig zijn van sensoren, ligt ten grondslag aan geautomatiseerde voertuigen, medische hulpmiddelen en tal van andere opkomende technologieën. Maar dat leervermogen maakt systemen op onverwachte manieren kwetsbaar voor hackers, onderzoekers van Princeton University hebben gevonden.

In een reeks recente publicaties, een onderzoeksteam heeft onderzocht hoe vijandige tactieken die worden toegepast op kunstmatige intelligentie (AI) kunnen, bijvoorbeeld, een systeem voor verkeersefficiëntie misleiden om een patstelling te veroorzaken of een gezondheidsgerelateerde AI-toepassing manipuleren om de persoonlijke medische geschiedenis van patiënten te onthullen. Als voorbeeld van zo'n aanval, het team veranderde de perceptie van een rijdende robot van een verkeersbord van een snelheidslimiet in een "Stop"-bord, waardoor het voertuig gevaarlijk kan remmen bij snelheden op de snelweg; in andere voorbeelden, ze veranderden stopborden om te worden gezien als een verscheidenheid aan andere verkeersinstructies.

"Als machine learning de software van de toekomst is, we zijn op een heel basaal startpunt om het te beveiligen, " zei Prateek Mittal, de hoofdonderzoeker en een universitair hoofddocent bij de afdeling Elektrotechniek van Princeton. "Om ervoor te zorgen dat machine learning-technologieën hun volledige potentieel bereiken, we moeten begrijpen hoe machine learning werkt in aanwezigheid van tegenstanders. Daar hebben we een grote uitdaging.

Net zoals software vatbaar is voor hacking en infectie door computervirussen, of de gebruikers die het doelwit zijn van oplichters via phishing en andere beveiligingsinbreuken, AI-aangedreven applicaties hebben hun eigen kwetsbaarheden. Toch is de inzet van adequate waarborgen achtergebleven. Tot dusver, de meeste ontwikkeling van machine learning heeft plaatsgevonden in goedaardige, gesloten omgevingen - een radicaal andere setting dan in de echte wereld.

Mittal is een pionier in het begrijpen van een opkomende kwetsbaarheid die bekend staat als adversarial machine learning. In essentie, dit type aanval zorgt ervoor dat AI-systemen onbedoelde, mogelijk gevaarlijke resultaten door het leerproces te corrumperen. In hun recente reeks artikelen, De groep van Mittal beschreef en demonstreerde drie brede soorten vijandige machine learning-aanvallen.

De gegevens goed vergiftigen

De eerste aanval houdt in dat een kwaadwillende agent valse informatie invoegt in de gegevensstroom die een AI-systeem gebruikt om te leren - een aanpak die bekend staat als datavergiftiging. Een veelvoorkomend voorbeeld is een groot aantal telefoons van gebruikers die rapporteren over verkeersomstandigheden. Dergelijke crowdsourced-gegevens kunnen worden gebruikt om een AI-systeem te trainen om modellen te ontwikkelen voor een betere collectieve routering van autonome auto's, het verminderen van congestie en verspilde brandstof.

"Een tegenstander kan eenvoudig valse gegevens injecteren in de communicatie tussen de telefoon en entiteiten zoals Apple en Google, en nu kunnen hun modellen mogelijk worden aangetast, "zei Mittal. "Alles wat je leert van corrupte gegevens zal verdacht zijn."

Mittal's groep toonde onlangs een soort van next-level-up van deze simpele datavergiftiging, een aanpak die ze 'modelvergiftiging' noemen. bij AI, een "model" kan een reeks ideeën zijn die een machine heeft gevormd, op basis van zijn analyse van gegevens, over hoe een deel van de wereld werkt. Vanwege privacyoverwegingen, de mobiele telefoon van een persoon kan zijn eigen gelokaliseerde model genereren, waardoor de gegevens van de persoon vertrouwelijk kunnen worden behandeld. De geanonimiseerde modellen worden vervolgens gedeeld en samengevoegd met modellen van andere gebruikers. "Meer en meer, bedrijven evolueren naar gedistribueerd leren waarbij gebruikers hun gegevens niet rechtstreeks delen, maar train in plaats daarvan lokale modellen met hun gegevens, " zei Arjun Nitin Bhagoji, een doctoraat student in het laboratorium van Mittal.

Maar tegenstanders kunnen een duim op de weegschaal leggen. Een persoon of bedrijf met interesse in de uitkomst zou de servers van een bedrijf kunnen misleiden om de updates van hun model te wegen op de modellen van andere gebruikers. "Het doel van de tegenstander is ervoor te zorgen dat de gegevens van zijn keuze worden geclassificeerd in de klasse die hij wenst, en niet de echte klasse, ' zei Bhagoji.

In juni, Bhagoji presenteerde een paper over dit onderwerp op de 2019 International Conference on Machine Learning (ICML) in Long Beach, Californië, in samenwerking met twee onderzoekers van IBM Research. De paper onderzocht een testmodel dat vertrouwt op beeldherkenning om te classificeren of mensen op foto's sandalen of sneakers dragen. Hoewel een geïnduceerde verkeerde classificatie van die aard onschuldig klinkt, het is het soort oneerlijke uitvluchten die een gewetenloos bedrijf zou kunnen plegen om zijn product te promoten boven dat van een rivaal.

"De soorten tegenstanders waarmee we rekening moeten houden in adversarieel AI-onderzoek variëren van individuele hackers die mensen of bedrijven proberen af te persen voor geld, aan bedrijven die zakelijke voordelen proberen te behalen, aan tegenstanders op nationaal niveau die op zoek zijn naar strategische voordelen, " zei Mittal, die ook verbonden is aan Princeton's Centre for Information Technology Policy.

Machine learning tegen zichzelf gebruiken

Een tweede brede dreiging wordt een ontwijkingsaanval genoemd. Het gaat ervan uit dat een machine learning-model met succes is getraind op echte gegevens en een hoge nauwkeurigheid heeft bereikt bij wat zijn taak ook is. Een tegenstander kan dat succes op zijn kop zetten, Hoewel, door de invoer te manipuleren die het systeem ontvangt zodra het zijn kennis begint toe te passen op beslissingen in de echte wereld.

Bijvoorbeeld, de AI voor zelfrijdende auto's is getraind om snelheidslimieten en stopborden te herkennen, terwijl we borden voor fastfoodrestaurants negeren, benzine station, enzovoort. De groep van Mittal heeft een maas in de wet onderzocht waardoor tekens verkeerd kunnen worden geclassificeerd als ze zijn gemarkeerd op een manier die een mens misschien niet opmerkt. De onderzoekers maakten nep-restaurantborden met een extra kleur die lijkt op graffiti of paintballvlekken. De veranderingen zorgden ervoor dat de AI van de auto de borden in het restaurant aanzag voor stopborden.

"We hebben kleine aanpassingen toegevoegd die dit herkenningssysteem voor verkeersborden voor de gek kunnen houden, " zei Mittal. Een paper over de resultaten werd gepresenteerd tijdens de 1st Deep Learning and Security Workshop (DLS), gehouden in mei 2018 in San Francisco door het Institute of Electrical and Electronics Engineers (IEEE).

Hoewel klein en alleen voor demonstratiedoeleinden, de bewegwijzering onthult opnieuw een manier waarop machine learning kan worden gekaapt voor snode doeleinden.

Privacy niet respecteren

De derde brede dreiging zijn privacyaanvallen, die tot doel hebben gevoelige gegevens af te leiden die in het leerproces worden gebruikt. In de huidige, voortdurend met internet verbonden samenleving, er lopen er genoeg rond. Tegenstanders kunnen proberen mee te liften op machine learning-modellen terwijl ze gegevens opzuigen, toegang krijgen tot beveiligde informatie zoals creditcardnummers, medische dossiers en fysieke locaties van gebruikers.

Een voorbeeld van dit misdrijf, studeerde aan Princeton, is de 'lidmaatschapsafleidingsaanval'. Het werkt door te meten of een bepaald gegevenspunt binnen de machine learning-trainingsset van een doel valt. Bijvoorbeeld, mocht een tegenstander de gegevens van een gebruiker tegenkomen terwijl hij de trainingsset van een gezondheidsgerelateerde AI-toepassing doorzoekt, die informatie zou sterk suggereren dat de gebruiker ooit een patiënt in het ziekenhuis was. Door de punten op een aantal van dergelijke punten met elkaar te verbinden, kunnen identificerende details over een gebruiker en hun leven worden onthuld.

Het beschermen van de privacy is mogelijk, maar op dit moment gaat het om een veiligheidsafweging - verdedigingen die de AI-modellen beschermen tegen manipulatie via ontwijkingsaanvallen, kunnen ze kwetsbaarder maken voor lidmaatschapsinferentieaanvallen. Dat is een belangrijke conclusie uit een nieuw document dat is geaccepteerd voor de 26e ACM-conferentie over computer- en communicatiebeveiliging (CCS), die in november 2019 in Londen wordt gehouden, onder leiding van Mittal's afgestudeerde student Liwei Song. De verdedigingstactieken die worden gebruikt om te beschermen tegen ontwijkingsaanvallen zijn sterk afhankelijk van gevoelige gegevens in de trainingsset, waardoor die gegevens kwetsbaarder zijn voor privacyaanvallen.

Het is het klassieke debat over veiligheid versus privacy, deze keer met een machine learning-twist. Lied benadrukt, net als Mittal, dat onderzoekers de twee domeinen als onlosmakelijk met elkaar verbonden zullen moeten gaan behandelen, in plaats van zich op het ene te concentreren zonder rekening te houden met de impact ervan op het andere.

"In onze krant door de toegenomen privacylekkage te laten zien die wordt geïntroduceerd door verdedigingen tegen ontduikingsaanvallen, we hebben benadrukt hoe belangrijk het is om samen na te denken over veiligheid en privacy, " zei Lied,

Het is nog vroeg voor machine learning en adversariële AI - misschien vroeg genoeg om de dreigingen die onvermijdelijk werkelijkheid worden, niet de overhand te hebben.

"We gaan een nieuw tijdperk in waarin machine learning steeds meer ingebed zal worden in bijna alles wat we doen, "zei Mittal. "Het is absoluut noodzakelijk dat we bedreigingen erkennen en tegenmaatregelen tegen hen ontwikkelen."

De degradatiestatus van moderne polymere museumartefacten kan worden geclassificeerd op basis van hun geur

De degradatiestatus van moderne polymere museumartefacten kan worden geclassificeerd op basis van hun geur Hoe het percentage ionisatie te berekenen

Hoe het percentage ionisatie te berekenen Wat is Nadph in Photosynthesis?

Wat is Nadph in Photosynthesis?  Wetenschappers observeren voor het eerst katalysator tijdens Fischer-Tropsch-synthese

Wetenschappers observeren voor het eerst katalysator tijdens Fischer-Tropsch-synthese Lichaamsbeweging is goed voor je huid:een eiwit bootst sommige anti-aging effecten bij muizen na

Lichaamsbeweging is goed voor je huid:een eiwit bootst sommige anti-aging effecten bij muizen na

Onderaardse brand:Indonesië worstelt om ondergrondse branden te blussen

Onderaardse brand:Indonesië worstelt om ondergrondse branden te blussen Waarom wordt China geconfronteerd met recordoverstromingen?

Waarom wordt China geconfronteerd met recordoverstromingen? Nieuw juni-record voor ontbossing Braziliaanse Amazone

Nieuw juni-record voor ontbossing Braziliaanse Amazone Kan zeegras de verzuring van de oceaan helpen bestrijden?

Kan zeegras de verzuring van de oceaan helpen bestrijden? NASA vangt vorming van tropische cycloon Kenneth in de buurt van Aldabra

NASA vangt vorming van tropische cycloon Kenneth in de buurt van Aldabra

Hoofdlijnen

- De reden voor het kleuren van een monster op de microscoop

- Waarom lijken oude stellen op elkaar?

- Hoe beïnvloedt de temperatuur het metabolisme?

- Kwallen hebben superkrachten - en andere redenen waarom ze hun slechte reputatie niet verdienen

- Hoe verschilt gisting van cellulaire ademhaling?

- Onverwachte vondst lost 40 jaar oud cytoskeletmysterie op

- Hoe krijgen mensen zuurstof in hun lichaam?

- Triest afscheid als de in Maleisië geboren panda naar China gaat

- Een aap en een virus:een miljoen jaar samen

- Het onderzoeken van de perceptie van mensen van geometrische kenmerken, persoonlijkheden en emoties in video's met virtuele mensen

- Hoe een AI die is opgeleid om wetenschappelijke artikelen te lezen, toekomstige ontdekkingen kan voorspellen

- Uber zet beursgang in gang, probeert kansen te ontbranden

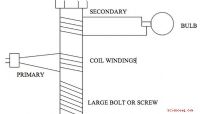

- Zelfgemaakte elektrische transformatoren

- Slimme machinecomponenten waarschuwen gebruikers voor schade en slijtage

Onderzoekers ontdekken vulkanische warmtebron onder grote Antarctische gletsjer

Onderzoekers ontdekken vulkanische warmtebron onder grote Antarctische gletsjer Alle gevechten die worden gevoerd tegen infrastructuur voor fossiele brandstoffen volgen één enkele strategie

Alle gevechten die worden gevoerd tegen infrastructuur voor fossiele brandstoffen volgen één enkele strategie Wetenschappers demonstreren biomagnificatie van nanomaterialen in eenvoudige voedselketen

Wetenschappers demonstreren biomagnificatie van nanomaterialen in eenvoudige voedselketen Eerste satelliet die globale winden meet, klaar voor lancering

Eerste satelliet die globale winden meet, klaar voor lancering Gevoelige nieuwe test detecteert antilichamen tegen SARS-CoV-2 in slechts 10 minuten

Gevoelige nieuwe test detecteert antilichamen tegen SARS-CoV-2 in slechts 10 minuten Natuurkundigen suggereren omkeerbare aanpassing van de emissiekleur van nanodeeltjes

Natuurkundigen suggereren omkeerbare aanpassing van de emissiekleur van nanodeeltjes Verschil tussen mannelijke en vrouwelijke zalm

Verschil tussen mannelijke en vrouwelijke zalm Een op DNA gebaseerde nanogel voor gerichte chemotherapie

Een op DNA gebaseerde nanogel voor gerichte chemotherapie

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com